KI und Machine Learning in Databricks

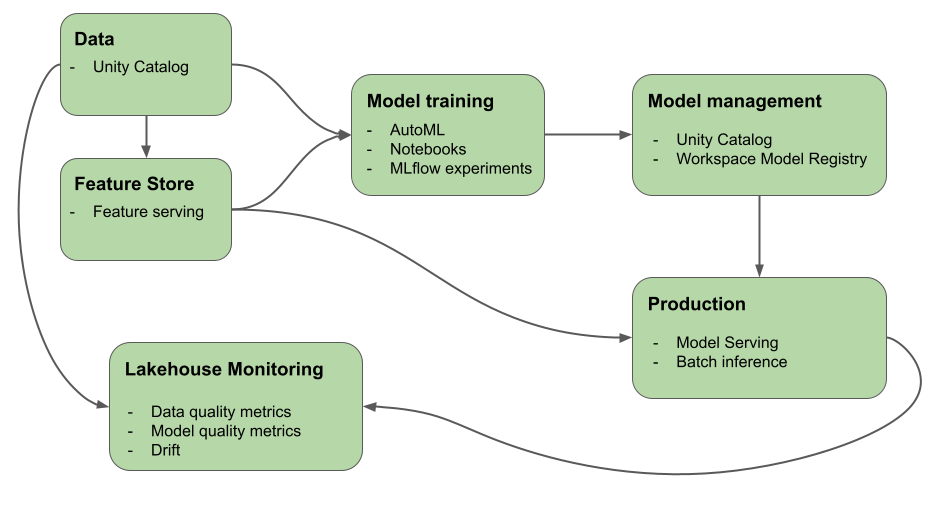

In diesem Artikel werden die Tools beschrieben, die Mosaic AI (ehemals Databricks Machine Learning) bereitstellt, um Sie beim Erstellen von KI- und ML-Systemen zu unterstützen. Das Diagramm zeigt, wie verschiedene Produkte auf der Databricks-Plattform Sie bei der Implementierung Ihrer End-to-End-Workflows für die Entwicklung und Bereitstellung von KI- und ML-Systemen unterstützen.

Generative KI auf Databricks.

Mosaic AI vereint den KI-Lebenszyklus von der Datensammlung und -vorbereitung bis hin zur Modellentwicklung und LLMOps zur Bereitstellung und Überwachung. Die folgenden Features sind speziell optimiert, um die Entwicklung von generativen KI-Anwendungen zu erleichtern:

- Unity Catalog für Governance, Ermittlung, Versionsverwaltung und Zugriffssteuerung für Daten, Features, Modelle und Funktionen.

- MLflow für die Nachverfolgung der Modellentwicklung.

- Mosaic AI Model Serving für die Bereitstellung von LLMs. Sie können ein Modell konfigurieren, das endpunktspezifisch für den Zugriff auf generative KI-Modelle dient:

- Modernste offene LLMs mit Basismodell-APIs.

- Drittanbietermodelle, die außerhalb von Databricks gehostet werden. Weitere Informationen finden Sie unter Externe Modelle in Mosaic AI Model Serving.

- Die Mosaic AI-Vektorsuche stellt eine abfragefähige Vektordatenbank bereit, in der eingebettete Vektoren gespeichert und die so konfiguriert werden kann, dass sie automatisch mit Ihrer Wissensdatenbank synchronisiert wird.

- Lakehouse Monitoring für die Datenüberwachung und Nachverfolgung von Modellvorhersagequalität und -drift mithilfe automatischer Nutzlastprotokollierung mit Rückschlusstabellen

- KI Playground zum Testen von generativen KI-Modellen aus Ihrem Databricks-Arbeitsbereich. Sie können Einstellungen wie Systemeingabeaufforderungen und Rückschlussparameter anfordern, vergleichen und anpassen.

- Foundation Model Fine-Tuning (jetzt Teil des Mosaik AI Model Training) zum Anpassen eines Foundation-Modells mithilfe Ihrer eigenen Daten, um seine Leistung für Ihre spezifische Anwendung zu optimieren.

- Mosaic AI Agent Framework zum Erstellen und Bereitstellen von Produktionsqualitätsagenten wie Retrieval Augmented Generation (RAG)-Anwendungen.

- Mosaic AI Agent Evaluation für die Bewertung der Qualität, Kosten und Latenz von generativen KI-Anwendungen, einschließlich RAG-Anwendungen und Ketten.

Was ist generative KI?

Generative KI ist eine Art künstlicher Intelligenz, die sich auf die Fähigkeit von Computern konzentriert, Modelle zum Erstellen von Inhalten wie Bildern, Text, Code und synthetischen Daten zu verwenden.

Generative KI-Anwendungen basieren auf generativen KI-Modellen: großen Sprachmodellen (LLMs) und Foundation-Modellen.

- LLMs sind Deep Learning-Modelle, die massive Datasets nutzen und trainieren, um in Sprachverarbeitungsaufgaben zu excelieren. Sie erstellen neue Textkombinationen, die natürliche Sprache basierend auf ihren Schulungsdaten nachahmen.

- Generative KI-Modelle oder Foundation-Modelle sind große ML-Modelle, die mit der Absicht geschult wurden, dass sie für spezifischere Sprachverständnis- und Generationsaufgaben optimiert werden sollen. Diese Modelle werden verwendet, um Muster innerhalb der Eingabedaten zu erkennen.

Nachdem diese Modelle ihre Lernprozesse abgeschlossen haben, generieren sie statistisch wahrscheinliche Ausgaben, wenn sie dazu aufgefordert werden, und sie können eingesetzt werden, um verschiedene Aufgaben auszuführen, darunter:

- Die Bildgenerierung basiert auf vorhandenen Oder mithilfe der Formatvorlage eines Bilds, um ein neues Bild zu ändern oder zu erstellen.

- Sprachaufgaben wie Transkription, Übersetzung, Frage-/Antwortgenerierung und Interpretation der Absicht oder Bedeutung von Text.

Wichtig

Während viele LLMs oder andere generative KI-Modelle Sicherheitsvorkehrungen haben, können sie weiterhin schädliche oder ungenaue Informationen generieren.

Generative KI hat die folgenden Entwurfsmuster:

- Prompt Engineering: Erstellen spezieller Prompts zur Steuerung des LLM-Verhaltens

- Retrieval Augmented Generation (RAG): Kombinieren eines LLM mit externem Wissensabruf

- Optimierung: Anpassen eines vortrainierten LLM an bestimmte Datasets von Domänen

- Vorabtraining: Trainieren eines LLM von Grund auf

Machine Learning in Databricks

Mit Mosaic AI kann eine einzige Plattform für jeden Schritt des ML-Prozesses für die Entwicklung und Bereitstellung verwendet werden – von Rohdaten bis hin zu Rückschlusstabellen, die alle Anforderungen und Antworten für ein bereitgestelltes Modell speichern. Data Scientists, Data Engineers, ML Engineers und DevOps können ihre Aufgaben mit den gleichen Tools und einer Single Source of Truth für die Daten erledigen.

Mosaik AI vereint die Datenebene und die ML-Plattform. Alle Datenressourcen und Artefakte, z. B. Modelle und Funktionen, sind in einem einzigen Katalog auffindbar und kontrolliert. Das Verwenden einer einzigen Plattform für Daten und Modelle ermöglicht es, die Herkunft von den Rohdaten bis zum Produktionsmodell nachzuverfolgen. Die integrierte Daten- und Modellüberwachung speichert Qualitätsmetriken in Tabellen, die auch auf der Plattform gespeichert sind, wodurch die Grundursache von Problemen mit der Modellleistung leichter identifiziert werden kann. Weitere Informationen dazu, wie Databricks den vollständigen ML-Lebenszyklus und MLOps unterstützt, finden Sie unter MLOps-Workflows in Azure Databricks und MLOps Stacks: Modellentwicklungsprozess als Code.

Einige der wichtigsten Komponenten der Data Intelligence-Plattform sind die folgenden:

| Aufgaben | Komponente |

|---|---|

| Verwalten von Daten, Features, Modellen und Funktionen. Auch Ermittlung, Versionsverwaltung und Datenherkunft | Unity Catalog |

| Nachverfolgen von Änderungen an Daten, Datenqualität und Modellvorhersagequalität | Lakehouse Monitoring, Rückschlusstabellen |

| Featureentwicklung und -verwaltung | Feature Engineering und Featurebereitstellung. |

| Trainieren von Modellen | AutoML-, Databricks-Notizbücher |

| Nachverfolgen der Modellentwicklung | MLflow-Nachverfolgung |

| Bereitstellen von benutzerdefinierten Modellen | Mosaic AI Model Serving |

| Erstellen automatisierter Workflows und produktionsbereiter ETL-Pipelines | Databricks-Aufträge |

| Git-Integration | Databricks-Git-Ordner |

Deep Learning in Databricks

Das Konfigurieren der Infrastruktur für Deep Learning-Anwendungen kann schwierig sein. Databricks Runtime für Machine Learning kümmert sich darum, mit Clustern, die integrierte kompatible Versionen der gängigsten Deep Learning-Bibliotheken wie TensorFlow, PyTorch und Keras aufweisen.

Databricks Runtime ML-Cluster umfassen auch die vorab konfigurierte GPU-Unterstützung mit Treibern und unterstützenden Bibliotheken. Es unterstützt auch Bibliotheken wie Ray zum Parallelisieren der Computeverarbeitung für die Skalierung von ML-Workflows und ML-Anwendungen.

Databricks Runtime ML-Cluster umfassen auch die vorab konfigurierte GPU-Unterstützung mit Treibern und unterstützenden Bibliotheken. Mosaic AI Model Serving ermöglicht die Erstellung skalierbarer GPU-Endpunkte für Deep Learning-Modelle ohne zusätzliche Konfiguration.

Für Machine Learning-Anwendungen wird die Verwendung eines Clusters empfohlen, in dem Databricks Runtime für Machine Learning ausgeführt wird. Siehe Erstellen eines Clusters mithilfe von Databricks Runtime ML.

Informationen zu den ersten Schritten mit Deep Learning in Databricks finden Sie unter:

- Bewährte Methoden für Deep Learning in Azure Databricks

- Deep Learning in Databricks

- Referenzlösungen für Deep Learning

Nächste Schritte

Informationen zu den ersten Schritten finden Sie unter:

Einen empfohlenen MLOps-Workflow für Databricks Mosaic AI finden Sie unter:

Weitere Informationen zu wichtigen Databricks Mosaik AI-Features finden Sie unter: