Schritt 2. Bereitstellen von Proof of Concept zum Sammeln von Stakeholderfeedback

Am Ende dieses Schritts haben Sie die Agent Evaluation Review-App bereitgestellt, mit der Ihre Projektbeteiligten den Proof of Concept testen und Feedback dazu abgeben können. Detaillierte Protokolle zur Nutzung durch die Projektbeteiligten und ihr Feedback werden an Delta-Tabellen in Ihrem Lakehouse übertragen.

Anforderungen

- Führen Sie die Schritte unter Schritt 1. Klonen des Coderepositorys und Erstellen von Compute aus.

- Daten aus Voraussetzung: Ermitteln von Anforderungen ist in Ihrem Lakehouse in einem Unity Catalog-Volume verfügbar.

Den Beispielcode aus diesem Abschnitt finden Sie in diesem GitHub-Repository.

Proof of Concept für RAG-Anwendungen

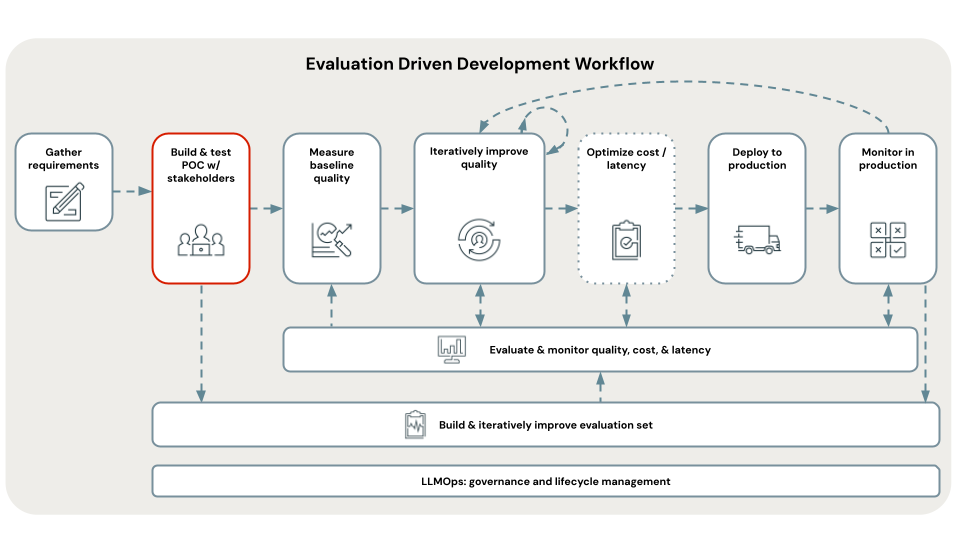

Der erste Schritt bei der auswertungsgesteuerten Entwicklung besteht darin, einen Proof of Concept (POC) zu erstellen. Ein Proof of Concept bietet folgende Vorteile:

- Er bietet eine richtungsweisende Sicht auf die Machbarkeit Ihres Anwendungsfalls mit RAG.

- Er ermöglicht das Sammeln von anfänglichem Feedback von Projektbeteiligten, wodurch Sie wiederum die erste Version Ihres Auswertungssatzes erstellen können.

- Er legt eine Messung von Grundwerten fest, von der aus die Iteration beginnen kann.

Databricks empfiehlt das Erstellen Ihres Proof of Concept mithilfe der einfachsten RAG-Architektur und der von Databricks empfohlenen Standardwerte für jeden Parameter.

Dies wird empfohlen, weil es Hunderte möglicher Kombinationen von Parametern gibt, die Sie innerhalb Ihrer RAG-Anwendung optimieren können. Sie können leicht Wochen mit der Optimierung verbringen. Aber wenn Sie dies tun, bevor Sie Ihre RAG-Anwendung systematisch auswerten können, enden Sie in einer sogenannten verhängnisvollen POC-Schleife. In einer solchen Schleife werden Einstellungen durchlaufen, Sie haben aber keine Möglichkeit, objektiv zu beurteilen, ob eine Verbesserung vorgenommen wurde. Und währenddessen warten die Projektbeteiligten ungeduldig auf die Überprüfung.

Die POC-Vorlagen in diesem Lernprogramm sind mit qualitätsbezogener Iteration konzipiert. Sie werden auf der Grundlage der vom Databricks-Forschungsteam ermittelten Faktoren parametrisiert, deren Optimierung für die Verbesserung der RAG-Qualität wichtig sind. Diese Vorlagen sind nicht „drei Codezeilen, die auf magische Weise eine RAG-Anwendung ergeben“, sondern eine gut strukturierte RAG-Anwendung, die in den folgenden Schritten eines auswertungsgesteuerten Entwicklungsworkflows für eine höhere Qualität optimiert werden kann.

Auf diese Weise können Sie schnell einen Proof of Concept bereitstellen, aber rasch zur Qualitätsiteration wechseln, ohne den Code neu schreiben zu müssen.

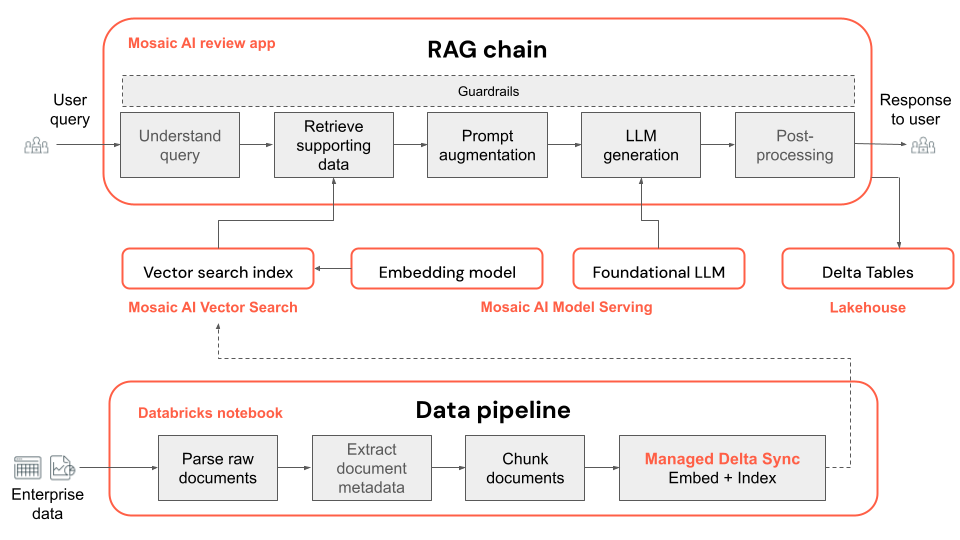

Nachfolgend finden Sie die technische Architektur der Proof of Concept-Anwendung:

Hinweis

Standardmäßig verwendet der Proof of Concept die Open Source-Modelle, die unter Bereitstellung Mosaic AI Foundation-Modell verfügbar sind. Da der Proof of Concept jedoch Mosaic AI-Modellbereitstellung verwendet, die jedes Foundation-Modell unterstützt, ist die Verwendung eines anderen Modells einfach: Konfigurieren Sie dieses Modell einfach in der Modellbereitstellung, und ersetzen Sie dann embedding_endpoint_name und llm_endpoint_name im 00_config-Notebook.

- Unter Foundation Model-APIs mit bereitgestelltem Durchsatz finden Sie weitere Open Source-Modelle, die im Databricks Marketplace verfügbar sind.

- Unterstützte, von Drittanbietern gehostete Modelle wie Azure OpenAI, OpenAI, Cohere, Anthropic und Google Gemini finden Sie im Notebook „Create_OpenAI_External_Model“ oder unter Externe Modelle in der Mosaic KI-Modellbereitstellung.

Schritte zum Bereitstellen eines Proof of Concept zum Sammeln von Feedback

Die folgenden Schritte zeigen, wie sie eine generative Proof of Concept-KI-Anwendung ausführen und bereitstellen. Nach der Bereitstellung erhalten Sie eine URL zur Review-App, die Sie für Projektbeteiligte freigeben können, um Feedback zu sammeln.

Öffnen Sie den Proof of Concept-Codeordner in A_POC_app basierend auf Ihrem Datentyp:

- Verwenden Sie für PDF-Dateien pdf_uc_volume.

- Verwenden Sie für PowerPoint-Dateien pptx_uc_volume.

- Verwenden Sie für DOCX-Dateien docx_uc_volume.

- Verwenden Sie für JSON-Dateien mit Text, Markdown, HTML-Inhalt und Metadaten json_uc_volume.

Wenn Ihre Daten keine der oben genannten Anforderungen erfüllen, können Sie die Analysefunktion (

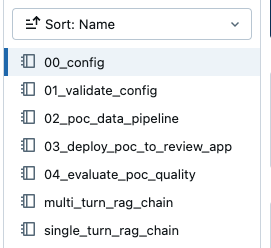

parser_udf) in02_poc_data_pipelinein den oben genannten Proof of Concept-Verzeichnissen anpassen, um mit Ihren Dateitypen zu arbeiten.Im Proof of Concept-Ordner werden die folgenden Notebooks angezeigt:

Hinweis

Diese Notebook-Instanzen beziehen sich auf den von Ihnen ausgewählten Proof of Concept. Wenn beispielsweise ein Verweis auf

00_configangezeigt wird und Siepdf_uc_volumeausgewählt haben, finden Sie das relevante00_config-Notebook unter A_POC_app/pdf_uc_volume/00_config.Überprüfen Sie optional die Standardparameter.

Öffnen Sie das

00_config-Notebook im oben ausgewählten Proof of Concept-Verzeichnis, um die Standardparameter der Proof of Concept-Anwendungen für die Datenpipeline und die RAG-Kette anzuzeigen.Wichtig

Die von Databricks empfohlenen Standardparameter sollen nicht perfekt sein, sind aber ein guter Ausgangspunkt. Die nächsten Schritte dieses Workflows führen Sie durch das Durchlaufen dieser Parameter.

Überprüfen Sie die Konfiguration.

Führen Sie

01_validate_configaus, um zu überprüfen, ob Ihre Konfiguration gültig ist und alle Ressourcen verfügbar sind. Die Dateirag_chain_config.yamlwird in Ihrem Verzeichnis angezeigt, das zum Bereitstellen der Anwendung verwendet wird.Führen Sie die Datenpipeline aus.

Die Proof of Concept-Datenpipeline ist ein Databricks-Notebook, das auf Apache Spark basiert. Öffnen Sie das Notebook

02_poc_data_pipeline, und klicken Sie auf Alle ausführen, um die Pipeline auszuführen. Diese Pipeline führt folgende Schritte aus:- Laden der Rohdokumente vom UC-Volume

- Analysieren der einzelnen Dokumente und Speichern der Ergebnisse in einer Delta-Tabelle

- Aufteilen der einzelnen Dokumente in Blöcke und Speichern der Ergebnisse in einer Delta-Tabelle

- Einbetten der Dokumente und Erstellen eines Vektorindex mithilfe der Mosaic AI-Vektorsuche

Metadaten, etwa Ausgabetabellen und Konfigurationen, zur Datenpipeline werden in MLflow protokolliert:

Sie können die Ausgaben überprüfen, indem Sie Links zur Ausgabe der Delta-Tabellen oder Vektorindizes suchen, die sich am unteren Rand des Notebooks befinden:

Vector index: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>_poc_chunked_docs_gold_index Output tables: Bronze Delta Table w/ raw files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_raw_files_bronze Silver Delta Table w/ parsed files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_parsed_docs_silver Gold Delta Table w/ chunked files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_chunked_docs_goldStellen Sie die Proof of Concept-Kette in der Review-App bereit.

Die Proof of Concept-Standardkette ist eine mithilfe von LangChain erstellte RAG-Kette für mehrteilige Unterhaltungen.

Hinweis

Die Proof of Concept-Kette verwendet auf MLflow-Code basierende Protokollierung. Weitere Informationen zur codebasierten Protokollierung finden Sie unter Protokollieren und Registrieren von KI-Agents.

Öffnen Sie das Notebook

03_deploy_poc_to_review_app.Führen Sie die einzelnen Zellen des Notebooks aus.

Die MLflow-Ablaufverfolgung zeigt, wie die Proof of Concept-Anwendung funktioniert. Passen Sie die Eingabefrage an eine Frage an, die für Ihren Anwendungsfall relevant ist, und führen Sie die Zelle erneut aus, um die Anwendung zu überprüfen.

Ändern Sie die Standardanweisungen, die für Ihren Anwendungsfall relevant sind. Diese werden in der Review-App angezeigt.

instructions_to_reviewer = f"""## Instructions for Testing the {RAG_APP_NAME}'s Initial Proof of Concept (PoC) Your inputs are invaluable for the development team. By providing detailed feedback and corrections, you help us fix issues and improve the overall quality of the application. We rely on your expertise to identify any gaps or areas needing enhancement. 1. **Variety of Questions**: - Please try a wide range of questions that you anticipate the end users of the application will ask. This helps us ensure the application can handle the expected queries effectively. 2. **Feedback on Answers**: - After asking each question, use the feedback widgets provided to review the answer given by the application. - If you think the answer is incorrect or could be improved, please use "Edit Answer" to correct it. Your corrections will enable our team to refine the application's accuracy. 3. **Review of Returned Documents**: - Carefully review each document that the system returns in response to your question. - Use the thumbs up/down feature to indicate whether the document was relevant to the question asked. A thumbs up signifies relevance, while a thumbs down indicates the document was not useful. Thank you for your time and effort in testing {RAG_APP_NAME}. Your contributions are essential to delivering a high-quality product to our end users.""" print(instructions_to_reviewer)Führen Sie die Bereitstellungszelle aus, um einen Link zur Review-App abzurufen.

Review App URL: https://<your-workspace-url>.databricks.com/ml/review/<uc-catalog>.<uc-schema>.<uc-model-name>/<uc-model-version>

Erteilen Sie einzelnen Benutzern Berechtigungen für den Zugriff auf die Review-App.

Sie können Benutzern ohne Databricks Zugriff gewähren, indem Sie die Schritte unter Einrichten von Berechtigungen für die Verwendung der Rezensions-App ausführen.

Testen Sie die Review-App, indem Sie selbst einige Fragen stellen und Feedback abgeben.

Hinweis

MLflow-Ablaufverfolgungen und das Feedback des Benutzers aus der Review-App werden in Delta-Tabellen in dem von Ihnen konfigurierten Katalogschema angezeigt. Es kann bis zu 2 Stunden dauern, bis Protokolle in diesen Delta-Tabellen angezeigt werden.

Freigeben der Review-App für Projektbeteiligte

Sie können jetzt Ihre Proof of Concept-RAG-Anwendung für Ihre Projektbeteiligten freigeben, um ihr Feedback zu erhalten.

Wichtig

Databricks schlägt vor, Ihren Proof of Concept an mindestens drei Projektbeteiligte zu senden und ihnen jeweils 10 bis 20 Fragen zu stellen. Es ist wichtig, dass mehrere Projektbeteiligte Ihren Proof of Concept testen, damit Sie verschiedene Perspektiven in Ihren Auswertungssatz aufnehmen können.

Nächster Schritt

Fahren Sie mit Schritt 3. Zusammenstellen eines Auswertungssatzes aus Stakeholderfeedback fort.

< Vorheriger Schritt: Schritt 1. Klonen von Repositorys und Erstellen von Compute

Weiter: Schritt 3. Zusammenstellen eines Evaluierungssatzes >