Bereitstellen von JAIS mit Azure Machine Learning Studio

In diesem Artikel erfahren Sie, wie Sie Azure Machine Learning Studio zum Bereitstellen des JAIS-Modells als Dienst mit nutzungsbasierter Abrechnung verwenden.

Das JAIS-Modell ist in Azure Machine Learning Studio mit nutzungs- und tokenbasierter Bezahlung als Modell als Dienstleistung (Models-as-a-Service, MaaS) verfügbar.

Sie finden das JAIS-Modell im Modellkatalog, indem Sie nach der JAIS-Sammlung filtern.

Voraussetzungen

Ein Azure-Abonnement mit einer gültigen Zahlungsmethode. Kostenlose Versionen oder Testversionen von Azure-Abonnements funktionieren nicht. Wenn Sie noch kein Azure-Abonnement haben, erstellen Sie zunächst ein kostenpflichtiges Azure-Konto.

Ein Azure Machine Learning-Arbeitsbereich. Falls Sie nicht über diese Komponenten verfügen, führen Sie die Schritte unter Schnellstart: So erstellen Sie Arbeitsbereichsressourcen, die Sie für die ersten Schritte mit Azure Machine Learning benötigen aus, um sie zu erstellen. Das Angebot für die Modellimplementierung als serverlose API für JAIS ist nur mit Arbeitsbereichen verfügbar, die in den folgenden Regionen erstellt wurden:

- East US

- USA (Ost) 2

- USA Nord Mitte

- USA Süd Mitte

- USA (Westen)

- USA, Westen 3

- Schweden, Mitte

Eine Liste der Regionen, die für die einzelnen Modelle verfügbar sind, die Bereitstellungen mit serverlosen API-Endpunkten unterstützen, finden Sie unter Verfügbarkeit von Regionen für Modelle in serverlosen API-Endpunkten.

Die rollenbasierten Zugriffssteuerungen in Azure (Azure RBAC) werden verwendet, um Zugriff auf Vorgänge in Azure KI Studio zuzuweisen. Um die Schritte in diesem Artikel auszuführen, muss Ihrem Benutzerkonto die Azure KI-Entwicklerrolle in der Ressourcengruppe zugewiesen sein. Weitere Informationen zu Berechtigungen finden Sie unter Rollenbasierte Zugriffssteuerung in Azure KI Studio.

JAIS 30b Chat

JAIS 30b Chat ist ein automatisch regressives, bilinguales LLM für Arabisch und Englisch. Die optimierten Versionen verwenden die überwachte Optimierung (Supervised Fine-Tuning, SFT). Das Modell wurde sowohl mit arabischen als auch mit englischen Prompt-Antwort-Paaren optimiert. Die Datasets für die Optimierung enthielten eine breite Palette von Anweisungsdaten aus verschiedenen Themenbereichen. Das Modell umfasst eine Vielzahl gängiger Aufgaben, einschließlich Fragen und Antworten, Codegenerierung und Rückschlüsse aus Textinhalten. Um die Leistung auf Arabisch zu verbessern, hat das Core42-Team ein internes arabisches Dataset entwickelt und einige Open-Source-Anweisungen vom Englischen ins Arabische übersetzt.

Kontextlänge: JAIS 30b Chat unterstützt eine Kontextlänge von 8 K.

Eingabe: Als Modelleingabe ist nur Text zulässig.

Ausgabe: Das Modell generiert ausschließlich Text.

Wichtig

Dieses Feature ist zurzeit als öffentliche Preview verfügbar. Diese Vorschauversion wird ohne Vereinbarung zum Servicelevel bereitgestellt und ist nicht für Produktionsworkloads vorgesehen. Manche Features werden möglicherweise nicht unterstützt oder sind nur eingeschränkt verwendbar.

Weitere Informationen finden Sie unter Zusätzliche Nutzungsbestimmungen für Microsoft Azure-Vorschauen.

Bereitstellen mit nutzungsbasierter Bezahlung

Bestimmte Modelle aus dem Modellkatalog können als Dienst mit nutzungsbasierter Bezahlung bereitgestellt werden. So können Sie sie als API nutzen, ohne sie in Ihrem Abonnement zu hosten, und gleichzeitig die für Unternehmen erforderliche Sicherheit und Compliance gewährleisten. Für diese Bereitstellungsoption ist kein Kontingent aus Ihrem Abonnement erforderlich.

Das bereits erwähnte JAIS 30b Chat-Modell kann als Dienst mit nutzungsbasierter Bezahlung bereitgestellt werden. Es wird von Core42 über den Microsoft Azure Marketplace angeboten. Core42 kann die Nutzungsbedingungen und Preise dieses Modells ändern oder aktualisieren.

Erstellen einer neuen Bereitstellung

So erstellen Sie eine Bereitstellung

Navigieren Sie zu Azure Machine Learning Studio.

Wählen Sie den Arbeitsbereich aus, in dem Sie Ihre Modelle bereitstellen möchten. Um das Modellimplementierungsangebot mit nutzungsbasierter Bezahlung zu verwenden, muss sich Ihr Arbeitsbereich in der Region „USA, Osten 2“ oder „Schweden, Mitte“ befinden.

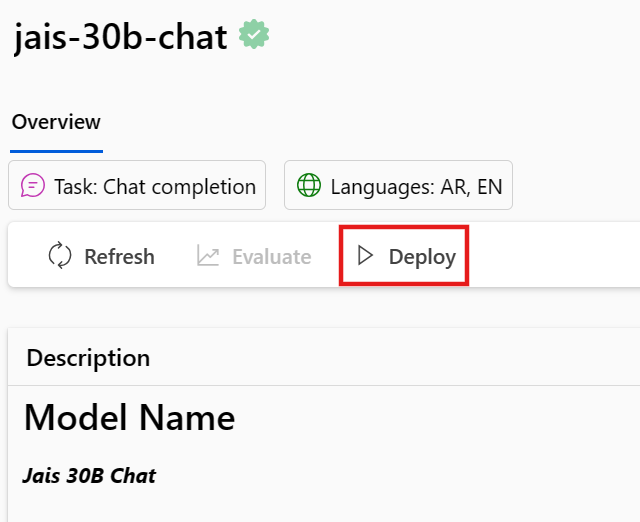

Suchen Sie nach JAIS, und wählen Sie das Jais-30b-Chat-Modell aus dem Modellkatalog aus.

Wählen Sie auf der Übersichtsseite des Modells im Modellkatalog die Option Bereitstellen aus.

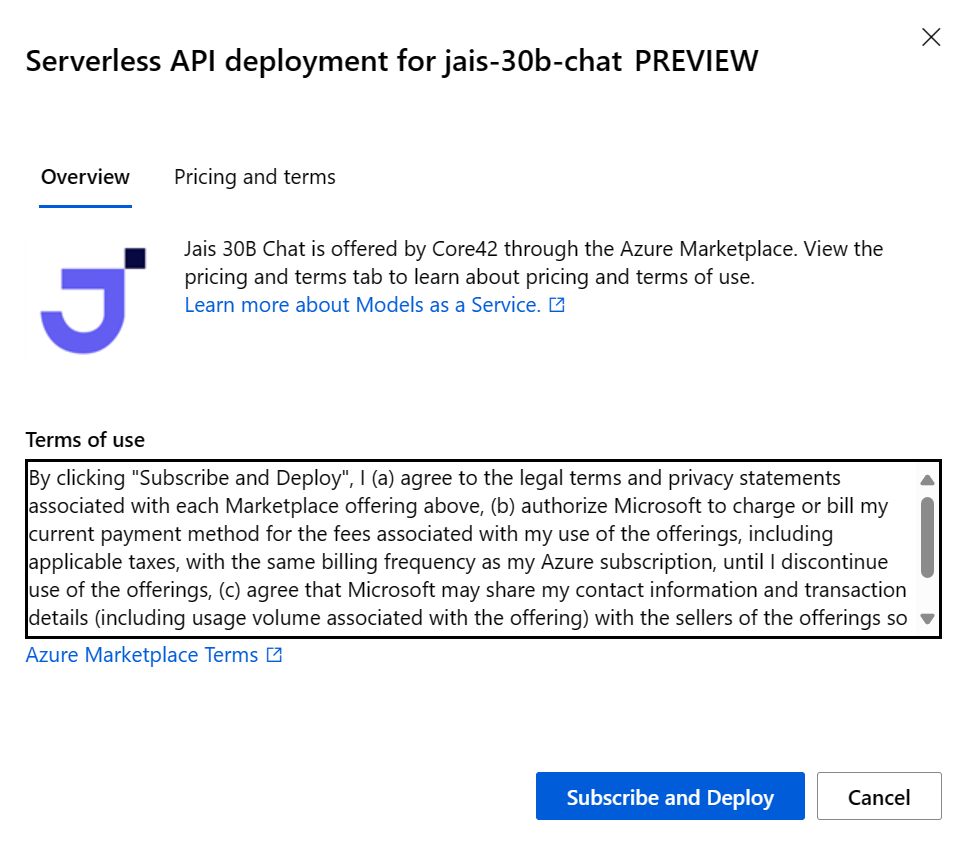

Wählen Sie im Bereitstellungsassistenten den Link zu Azure Marketplace-Nutzungsbedingungen aus, um mehr über die Nutzungsbedingungen zu erfahren.

Sie können auch die Registerkarte Preise und Nutzungsbedingungen auswählen, um mehr über die Preise für das ausgewählte Modell zu erfahren.

Wenn Sie das Modell zum ersten Mal im Arbeitsbereich bereitstellen, müssen Sie Ihren Arbeitsbereich für das jeweilige Angebot des Modells abonnieren. Dieser Schritt erfordert, dass Ihr Konto über die Azure KI-Entwicklerrolle für die Ressourcengruppe verfügt, wie in den Voraussetzungen aufgeführt. Jeder Arbeitsbereich verfügt über ein eigenes Abonnement für das jeweilige Azure Marketplace-Angebot, wodurch Sie die Ausgaben steuern und überwachen können. Wählen Sie Abonnieren und bereitstellen aus. Derzeit können Sie nur eine Bereitstellung für jedes Modell innerhalb eines Arbeitsbereichs haben.

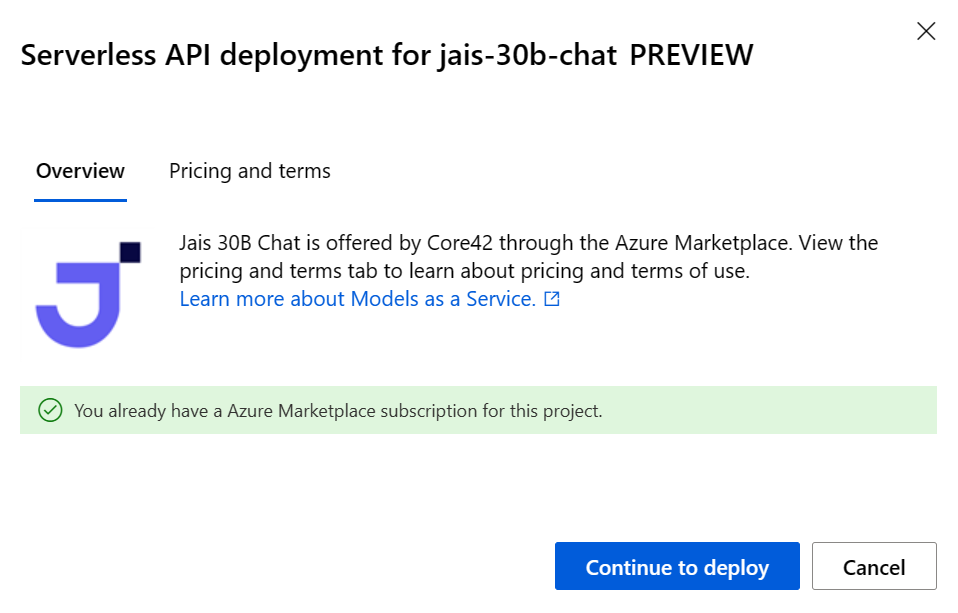

Sobald Sie den Arbeitsbereich für das jeweilige Azure Marketplace-Angebot abonniert haben, müssen nachfolgende Bereitstellungen des gleichen Angebots im gleichen Arbeitsbereich nicht mehr abonniert werden. Wenn dieses Szenario für Sie gilt, wird die Option Weiter zur Bereitstellung zum Auswählen angezeigt.

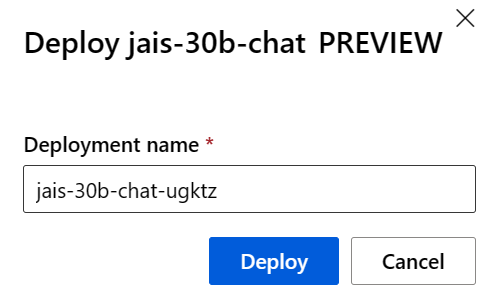

Geben Sie der Bereitstellung einen Namen. Dieser Name wird Teil der Bereitstellungs-API-URL. Diese URL muss in jeder Azure-Region eindeutig sein.

Klicken Sie auf Bereitstellen. Warten Sie, bis die Bereitstellung abgeschlossen ist, und Sie werden zur Seite mit serverlosen Endpunkten umgeleitet.

Wählen Sie den Endpunkt aus, um seine Detailseite zu öffnen.

Wählen Sie die Registerkarte Testen aus, um mit der Interaktion mit dem Modell zu beginnen.

Die Details, die URL und die Zugriffsschlüssel des Endpunkts finden Sie unter Arbeitsbereich>Endpunkte>Serverlose Endpunkte.

Notieren Sie sich die Werte für Ziel-URL und den Geheimen Schlüssel. Weitere Informationen zur Verwendung der APIs finden Sie im Abschnitt Referenz.

Informationen zur Abrechnung für Modelle, die mit nutzungsbasierter Bezahlung bereitgestellt werden, finden Sie im Artikel zu Kosten- und Kontingentüberlegungen zu JAIS-Modellen, die als Dienst bereitgestellt werden.

Verwenden des JAIS 30b Chat-Modells als Dienst

Diese Modelle können mithilfe der Chat-API genutzt werden.

Wählen Sie in Ihrem Arbeitsbereich auf der linken Seite die Registerkarte Endpunkte aus.

Wechseln Sie zur Registerkarte Serverlose Endpunkte.

Wählen Sie Ihre Bereitstellung für JAIS 30b Chat aus.

Sie können die Bereitstellung auf der Registerkarte Testen testen.

Um die APIs zu verwenden, kopieren Sie die Ziel-URL und den Wert in Schlüssel.

Weitere Informationen zur Verwendung der APIs finden Sie im Abschnitt Referenz.

Chat-API-Referenz für JAIS bei Bereitstellung als Dienst

v1/chat/completions

Anfordern

POST /v1/chat/completions HTTP/1.1

Host: <DEPLOYMENT_URI>

Authorization: Bearer <TOKEN>

Content-type: application/json

v1/chat/completions-Anforderungsschema

JAIS 30b Chat akzeptiert die folgenden Parameter für eine v1/chat/completions-Antwort auf einen Rückschlussaufruf:

| Eigenschaft | type | Standard | Beschreibung |

|---|---|---|---|

messages |

array |

None |

Texteingabe für das Modell, dem geantwortet werden soll. |

max_tokens |

integer |

None |

Die maximale Anzahl von Token, die das Modell als Teil der Antwort generiert. Hinweis: Das Festlegen eines niedrigen Werts kann zu unvollständigen Generierungen führen. Wenn nicht festgelegt, werden Token bis zum Ende der Sequenz generiert. |

temperature |

float |

0.3 |

Steuert die Zufälligkeit im Modell. Niedrigere Werte machen das Modell deterministischer, und höhere Werte vergrößern die Zufälligkeit des Modells. |

top_p |

float |

None |

Die kumulierte Wahrscheinlichkeit der Beibehaltung der Vokabulartoken mit der höchsten Wahrscheinlichkeit von Parametern beim Kernsampling ist standardmäßig NULL. |

top_k |

integer |

None |

Die Anzahl der Beibehaltung von Vokabulartoken mit der höchsten Wahrscheinlichkeit bei der Top-k-Filterung ist standardmäßig NULL. |

Eine System- oder eine Benutzernachricht unterstützt die folgenden Eigenschaften:

| Eigenschaft | type | Standard | BESCHREIBUNG |

|---|---|---|---|

role |

enum |

Erforderlich | role=system oder role=user |

content |

string |

Erforderlich | Texteingabe für das Modell, dem geantwortet werden soll. |

Eine Assistentennachricht unterstützt die folgenden Eigenschaften:

| Eigenschaft | type | Standard | BESCHREIBUNG |

|---|---|---|---|

role |

enum |

Erforderlich | role=assistant |

content |

string |

Erforderlich | Die Inhalte der Assistentennachricht. |

v1/chat/completions-Antwortschema

Die Antwortnutzlast ist ein Wörterbuch mit den folgenden Feldern:

| Schlüssel | type | Beschreibung |

|---|---|---|

id |

string |

Eindeutiger Bezeichner für die Vervollständigung |

choices |

array |

Die Liste der Vervollständigungsoptionen, die das Modell für die Eingabenachrichten generiert hat |

created |

integer |

Der Unix-Zeitstempel (in Sekunden) des Zeitpunkts, zu dem die Vervollständigung erstellt wurde |

model |

string |

Die für die Vervollständigung verwendete Modell-ID (model_id) |

object |

string |

chat.completion. |

usage |

object |

Nutzungsstatistiken für die Vervollständigungsanforderung |

Das choices-Objekt ist ein Wörterbuch mit den folgenden Feldern:

| Schlüssel | type | Beschreibung |

|---|---|---|

index |

integer |

Auswahlindex. |

messages oder delta |

string |

Ergebnis des Chatabschlusses im Nachrichtenobjekt. Wenn der Streamingmodus verwendet wird, wird der Deltaschlüssel verwendet. |

finish_reason |

string |

Der Grund, warum das Modell das Generieren von Token beendet hat. |

Das usage-Objekt ist ein Wörterbuch mit den folgenden Feldern:

| Schlüssel | type | Beschreibung |

|---|---|---|

prompt_tokens |

integer |

Anzahl der Token im Prompt. |

completion_tokens |

integer |

Die Anzahl der Token, die in der Vervollständigung generiert werden |

total_tokens |

integer |

Token insgesamt |

Beispiele

Arabisch

Anforderung:

"messages": [

{

"role": "user",

"content": "ما هي الأماكن الشهيرة التي يجب زيارتها في الإمارات؟"

}

]

Antwort:

{

"id": "df23b9f7-e6bd-493f-9437-443c65d428a1",

"choices": [

{

"index": 0,

"finish_reason": "stop",

"message": {

"role": "assistant",

"content": "هناك العديد من الأماكن المذهلة للزيارة في الإمارات! ومن أشهرها برج خليفة في دبي وهو أطول مبنى في العالم ، ومسجد الشيخ زايد الكبير في أبوظبي والذي يعد أحد أجمل المساجد في العالم ، وصحراء ليوا في الظفرة والتي تعد أكبر صحراء رملية في العالم وتجذب الكثير من السياح لتجربة ركوب الجمال والتخييم في الصحراء. كما يمكن للزوار الاستمتاع بالشواطئ الجميلة في دبي وأبوظبي والشارقة ورأس الخيمة، وزيارة متحف اللوفر أبوظبي للتعرف على تاريخ الفن والثقافة العالمية"

}

}

],

"created": 1711734274,

"model": "jais-30b-chat",

"object": "chat.completion",

"usage": {

"prompt_tokens": 23,

"completion_tokens": 744,

"total_tokens": 767

}

}

Deutsch

Anforderung:

"messages": [

{

"role": "user",

"content": "List the emirates of the UAE."

}

]

Antwort:

{

"id": "df23b9f7-e6bd-493f-9437-443c65d428a1",

"choices": [

{

"index": 0,

"finish_reason": "stop",

"message": {

"role": "assistant",

"content": "The seven emirates of the United Arab Emirates are: Abu Dhabi, Dubai, Sharjah, Ajman, Umm Al-Quwain, Fujairah, and Ras Al Khaimah."

}

}

],

"created": 1711734274,

"model": "jais-30b-chat",

"object": "chat.completion",

"usage": {

"prompt_tokens": 23,

"completion_tokens": 60,

"total_tokens": 83

}

}

Modellrückschluss: Beispiele

| Beispieltyp | Beispielnotebook |

|---|---|

| CLI mit CURL- und Python-Webanforderungen | webrequests.ipynb |

| OpenAI SDK (experimentell) | openaisdk.ipynb |

| LiteLLM | litellm.ipynb |

Kosten und Kontingente

Kosten- und Kontingentüberlegungen für als Dienst bereitgestellte Modelle

JAIS 30b Chat wird als Dienst bereitgestellt und von Core42 über den Azure Marketplace angeboten und zur Verwendung in Azure KI Studio integriert. Die Preise für den Azure Marketplace finden Sie, wenn Sie das Modell bereitstellen.

Jedes Mal, wenn ein Projekt ein bestimmtes Angebot aus dem Azure Marketplace abonniert, wird eine neue Ressource erstellt, um die mit der Nutzung verbundenen Kosten nachzuverfolgen. Dieselbe Ressource wird verwendet, um die mit der Inferenz verbundenen Kosten zu verfolgen. Es stehen jedoch mehrere Verbrauchseinheiten zur Verfügung, um jedes Szenario unabhängig zu verfolgen.

Weitere Informationen zum Nachverfolgen von Kosten finden Sie unter Überwachen der Kosten für Modelle, die über den Azure Marketplace angeboten werden.

Das Kontingent wird pro Bereitstellung verwaltet. Jede Bereitstellung hat eine Rate von 200.000 Token pro Minute und 1.000 API-Anforderungen pro Minute. Derzeit wird jedoch eine Bereitstellung pro Modell und Projekt beschränkt. Wenden Sie sich an den Microsoft Azure-Support, wenn die aktuellen Ratenbegrenzungen für Ihre Szenarien nicht ausreichen.

Inhaltsfilterung

Modelle, die als Dienst mit nutzungsbasierter Bezahlung bereitgestellt werden, werden durch Azure KI Inhaltssicherheit geschützt. Mit Azure KI Content Safety (Inhaltssicherheit) durchlaufen sowohl die Eingabeaufforderung als auch die Fertigstellung ein Ensemble von Klassifizierungsmodellen, die darauf abzielen, die Ausgabe von schädlichen Inhalten zu erkennen und zu verhindern. Das System zur Inhaltsfilterung (Vorschau) erkennt bestimmte Kategorien potenziell schädlicher Inhalte sowohl in Eingabeprompts als auch in Ausgabevervollständigungen und ergreift entsprechende Maßnahmen. Weitere Informationen zur Inhaltsfilterung finden Sie hier.