No-Code-Datenstromverarbeitung in Azure Stream Analytics

Mit dem No-Code-Editor können Sie mühelos einen Stream Analytics-Auftrag entwickeln, um Ihre Echtzeitstreamingdaten mithilfe der Drag & Drop-Funktion zu verarbeiten, ohne eine einzige Zeile Code zu schreiben. Die Benutzeroberfläche bietet eine Canvas, auf der Sie eine Verbindung mit Eingabequellen herstellen können, um Ihre Streamingdaten schnell anzuzeigen. Dann können Sie es transformieren, bevor Sie an Ihre Zielinstanzen schreiben.

Mit dem No-Code-Editor können Sie Folgendes ganz einfach durchführen:

- Ändern der Eingabeschemas

- Ausführen von Datenaufbereitungsprozessen wie Joins und Filter

- Behandeln von erweiterten Szenarien wie Zeitfensteraggregationen (rollierende und springende Fenster sowie Sitzungsfenster) für Gruppierungsvorgänge

Nachdem Sie Ihre Stream Analytics-Aufträge erstellt und ausgeführt haben, können Sie Produktionsworkloads problemlos operationalisieren. Verwenden Sie die richtige Auswahl von integrierten Metriken zur Überwachung und Problembehandlung. Stream Analytics-Aufträge werden gemäß dem Preismodell berechnet, wenn sie ausgeführt werden.

Voraussetzungen

Bevor Sie Ihre Stream Analytics-Aufträge mit dem No-Code-Editor entwickeln können, müssen die folgenden Anforderungen erfüllt sein:

- Die Streamingeingabequellen und Zielressourcen für den Stream Analytics-Auftrag müssen öffentlich zugänglich sein und dürfen sich nicht in einem virtuellen Azure-Netzwerk befinden.

- Sie müssen über die erforderlichen Berechtigungen verfügen, um auf die Streamingeingabe- und -ausgaberessourcen zuzugreifen.

- Sie benötigen Berechtigungen zum Erstellen und Ändern von Azure Stream Analytics-Ressourcen.

Hinweis

Der No-Code-Editor ist derzeit in der Region „China“ nicht verfügbar.

Azure Stream Analytics-Auftrag

Ein Stream Analytics-Auftrag basiert auf drei Hauptkomponenten: Streamingeingaben, Transformationen und Ausgaben. Sie können beliebig viele Komponenten verwenden, einschließlich mehrerer Eingaben, paralleler Verzweigungen mit mehreren Transformationen und mehrere Ausgaben. Weitere Informationen finden Sie in der Azure Stream Analytics-Dokumentation.

Hinweis

Die folgenden Funktionen und Ausgabetypen sind bei Verwendung des No-Code-Editors nicht verfügbar:

- Benutzerdefinierte Funktionen

- Abfragebearbeitung auf dem Azure Stream Analytics-Abfrageblatt Sie können die vom No-Code-Editor generierte Abfrage jedoch auf dem Abfrageblatt anzeigen.

- Hinzufügen von Eingaben/Ausgaben auf Azure Stream Analytics-Eingabe-/Ausgabeblättern Sie können jedoch die vom No-Code-Editor generierte Eingabe/Ausgabe auf dem Blatt für Eingaben/Ausgaben anzeigen.

- Die folgenden Ausgabetypen sind nicht verfügbar: Azure-Funktion, ADLS Gen1, PostgreSQL DB, Service Bus-Warteschlange/-Thema, Tabellenspeicher.

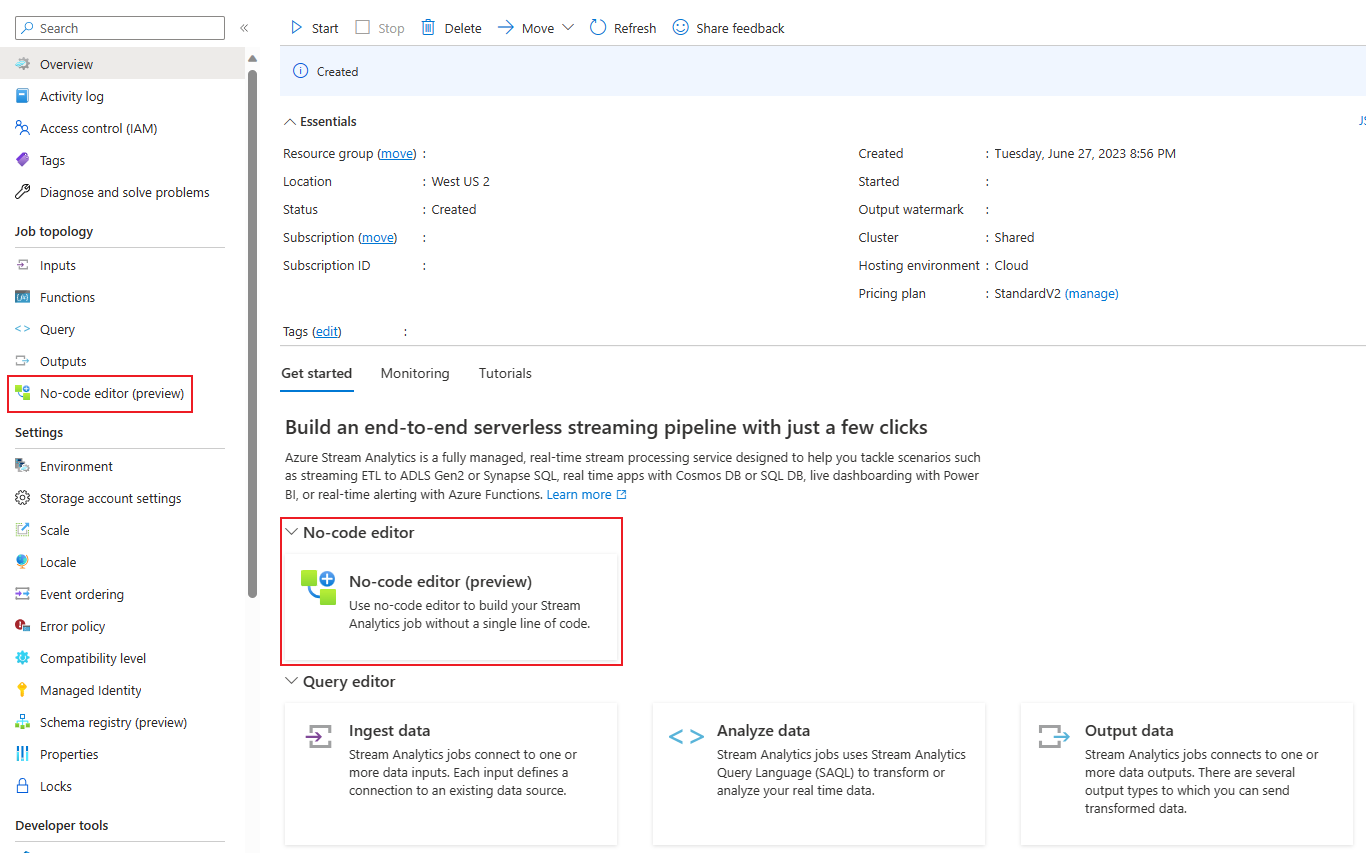

Für den Zugriff auf den No-Code-Editor zum Erstellen Ihres Stream Analytics-Auftrags gibt es zwei Möglichkeiten:

Über das Azure Stream Analytics-Portal (Vorschau): Erstellen Sie einen Stream Analytics-Auftrag, und wählen Sie dann auf der Seite Übersicht den No-Code-Editor auf der Registerkarte Erste Schritte oder im linken Bereich die Option No-Code-Editor aus.

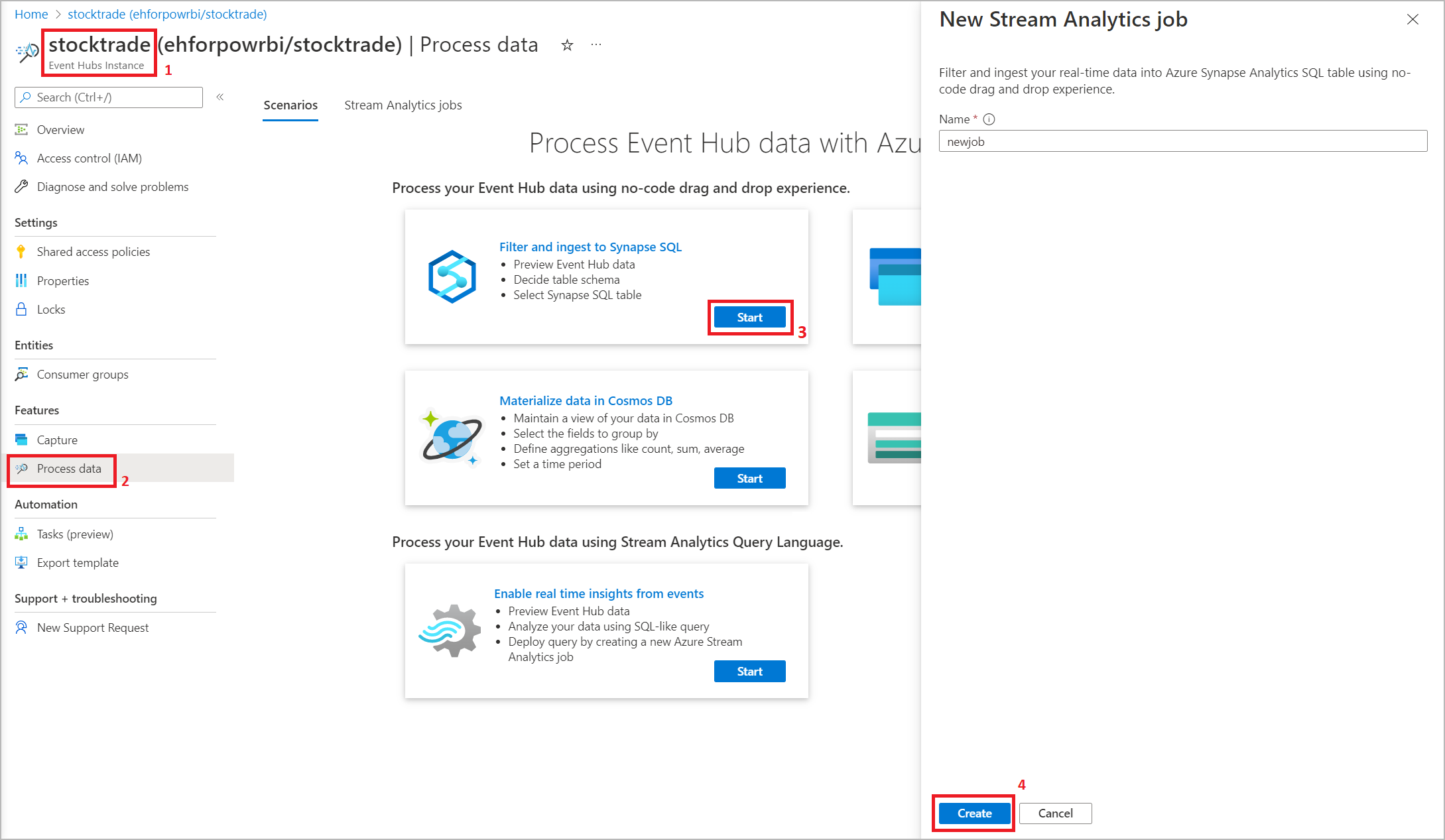

Über das Azure Event Hubs-Portal: Öffnen Sie eine Event Hubs-Instanz. Wählen Sie Daten verarbeiten und dann eine beliebige vordefinierte Vorlage aus.

Die vordefinierten Vorlagen können Sie bei der Entwicklung und Ausführung eines Auftrags für verschiedene Szenarien unterstützen, z. B.:

- Erstellen eines Echtzeitdashboards mit einem Power BI-Dataset, das über den No-Code-Editor von Stream Analytics erstellt wird

- Erfassen von Event Hubs-Daten im Delta Lake-Format (Vorschau)

- Filtern und Erfassen in Azure Synapse SQL

- Erfassen der Event Hubs-Daten im Parquet-Format in Azure Data Lake Storage Gen2

- Materialisieren von Daten in Azure Cosmos DB

- Filtern und Erfassen in Azure Data Lake Storage Gen2

- Anreichern von Daten und Erfassen in Event Hub

- Transformieren und Speichern von Daten in Azure SQL-Datenbank

- Filtern und Erfassen in Azure Data Explorer

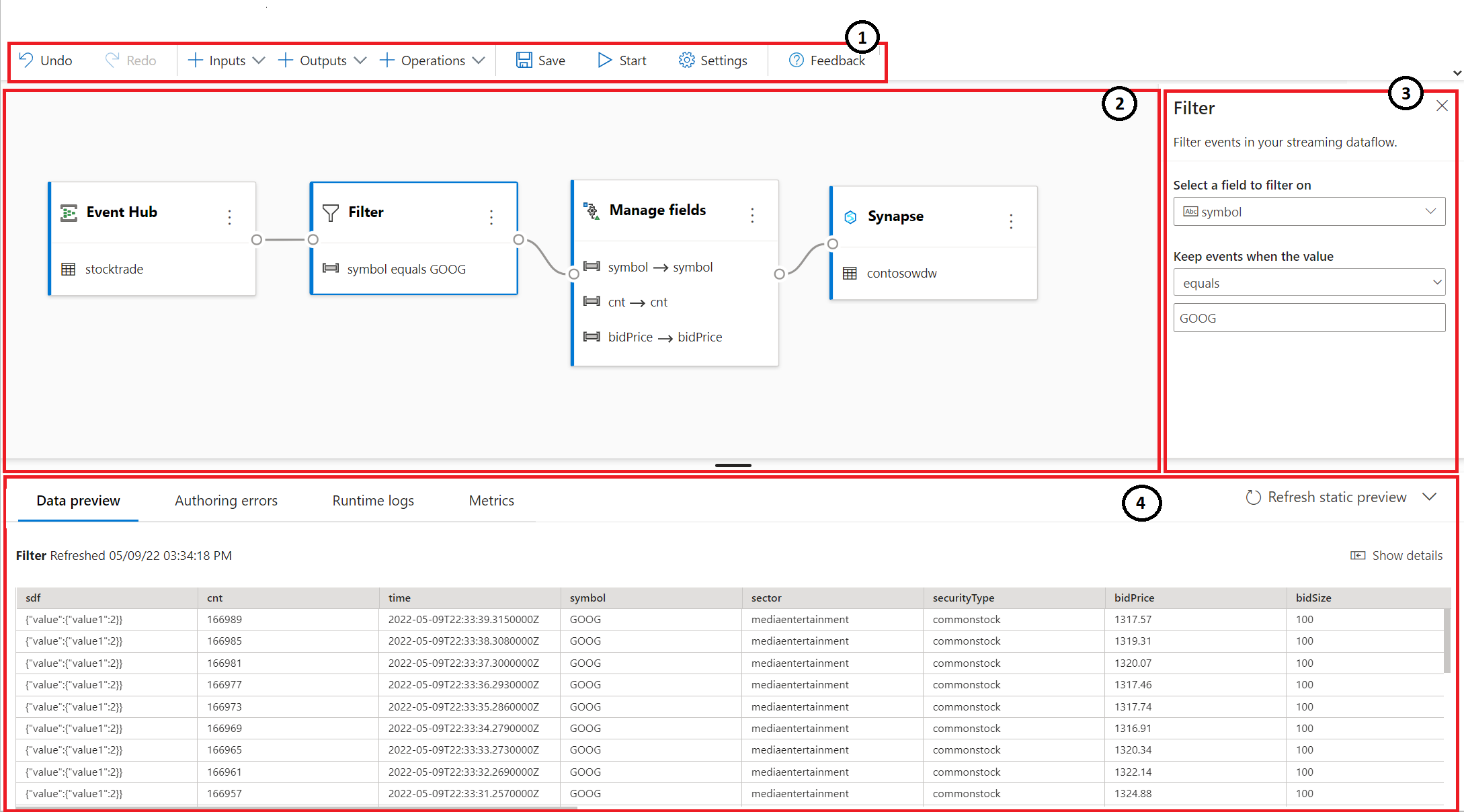

Der folgende Screenshot zeigt einen abgeschlossenen Stream Analytics-Auftrag. Die Abschnitte, die Ihnen beim Erstellen zur Verfügung stehen, sind hervorgehoben.

- Menüband: Die Abschnitte auf dem Menüband entsprechen der Reihenfolge eines klassischen Analyseprozesses: ein Event Hub als Eingabe (auch als Datenquelle bezeichnet), Transformationen (ETL-Streamingvorgänge – Extrahieren, Transformieren und Laden), Ausgaben, eine Schaltfläche zum Speichern und eine Schaltfläche zum Starten des Auftrags.

- Diagrammansicht: Dies ist eine grafische Darstellung, die Ihren Stream Analytics-Auftrag von der Eingabe über die Vorgänge bis hin zu den Ausgaben zeigt.

- Seitenbereich: Je nachdem, welche Komponente Sie in der Diagrammansicht ausgewählt haben, werden Einstellungen zum Ändern der Eingaben, Transformationen oder Ausgaben angezeigt.

- Registerkarten für Datenvorschau, Erstellungsfehler, Runtimeprotokolle und Metriken: In der Datenvorschau werden für jede Kachel die Ergebnisse für den jeweiligen Schritt angezeigt (live für Eingaben und bei Bedarf für Transformationen und Ausgaben). In diesem Abschnitt werden außerdem alle Erstellungsfehler oder Warnungen bei der Entwicklung Ihres Auftrags zusammengefasst. Durch Auswahl der einzelnen Fehler oder Warnungen wird die entsprechende Transformation ausgewählt. Er stellt Ihnen auch die Auftragsmetrik zur Verfügung, damit Sie die Integrität des ausgeführten Auftrags überwachen können.

Streamingdateneingabe

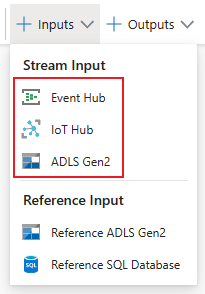

Der No-Code-Editor unterstützt die Eingabe von Streamingdaten von drei Arten von Ressourcen:

- Azure Event Hubs

- Azure IoT Hub

- Azure Data Lake Storage Gen2

Weitere Informationen zu Streamingdateneingaben finden Sie unter Streamen von Daten als Eingabe in Stream Analytics.

Hinweis

Der No-Code-Editor im Azure Event Hubs-Portal hat nur Event Hub als Eingabeoption.

Azure Event Hubs als Streamingeingabe

Bei Azure Event Hubs handelt es sich um eine Big Data-Streamingplattform und einen Ereigniserfassungsdienst. Mit diesem Dienst können Millionen von Ereignissen pro Sekunde empfangen und verarbeitet werden. An einen Event Hub gesendete Daten können transformiert und mit einem beliebigen Echtzeitanalyse-Anbieter oder Batchverarbeitungs-/Speicheradapter gespeichert werden.

Wählen Sie zum Konfigurieren eines Event Hubs als Eingabe für Ihren Auftrag das Symbol Event Hub aus. In der Diagrammansicht wird eine Kachel mit einem Seitenbereich für die Konfiguration und die Verbindung angezeigt.

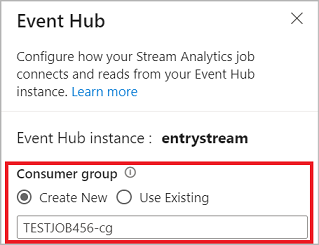

Wenn Sie im No-Code-Editor eine Verbindung mit Ihrem Event Hub herstellen, empfehlen wir Ihnen, eine neue Consumergruppe zu erstellen (dies ist die Standardoption). Auf diese Weise wird verhindert, dass der Event Hub den Grenzwert der gleichzeitigen Leser erreicht. Weitere Informationen zu Consumergruppen und ob Sie eine vorhandene Consumergruppe auswählen oder eine neue erstellen sollten, finden Sie unter Consumergruppen.

Wenn sich Ihr Event Hub im Basic-Tarif befindet, können Sie nur die vorhandene Consumergruppe $Default verwenden. Wenn sich Ihr Event Hub im Standard- oder Premium-Tarif befindet, können Sie eine neue Consumergruppe erstellen.

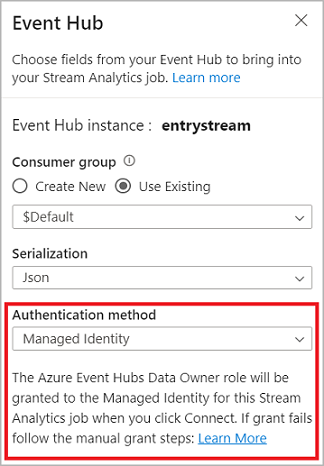

Wenn Sie eine Verbindung mit dem Event Hub herstellen und als Authentifizierungsmodus Verwaltete Identität auswählen, wird der verwalteten Identität für den Stream Analytics-Auftrag die Rolle „Azure Event Hubs-Datenbesitzer“ zugewiesen. Weitere Informationen zu verwalteten Identitäten für einen Event Hub finden Sie unter Verwenden verwalteter Identitäten für den Zugriff auf einen Event Hub über einen Azure Stream Analytics-Auftrag.

Verwaltete Identitäten beseitigen die Einschränkungen von benutzerbasierten Authentifizierungsmethoden. Zu diesen Einschränkungen gehört, dass Sie sich neu authentifizieren müssen, wenn sich das Kennwort ändert oder das Benutzertoken alle 90 Tage abläuft.

Nachdem Sie Ihre Event Hub-Angaben eingerichtet und Verbinden ausgewählt haben, können Sie über + Feld hinzufügen Felder manuell hinzufügen. Voraussetzung ist, dass Sie die Feldnamen kennen. Um stattdessen Felder und Datentypen automatisch basierend auf einem Beispiel der eingehenden Nachrichten zu erkennen, wählen Sie Felder automatisch erkennen aus. Über das Zahnradsymbol können Sie bei Bedarf die Anmeldeinformationen bearbeiten.

Wenn Stream Analytics-Aufträge die Felder erkennen, werden sie in der Liste angezeigt. Außerdem sehen Sie eine Livevorschau der eingehenden Nachrichten in der Tabelle Datenvorschau unter der Diagrammansicht.

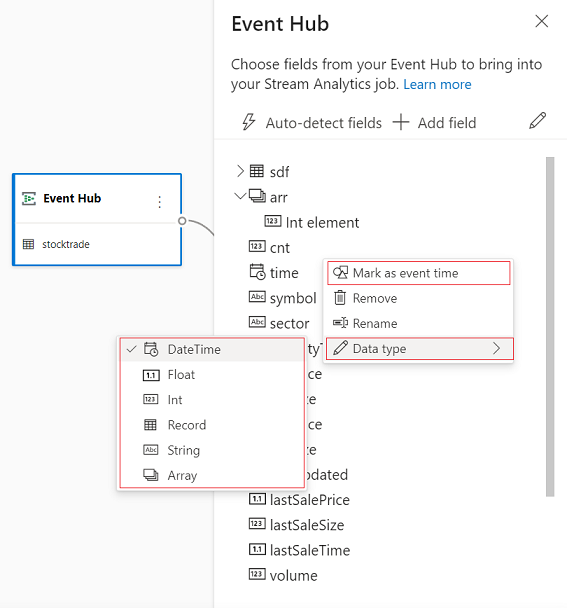

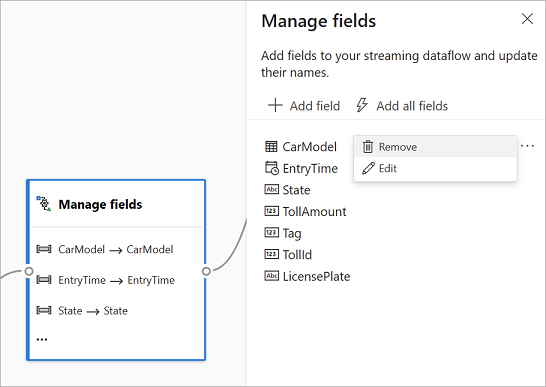

Ändern von Eingabedaten

Sie können die Feldnamen bearbeiten, das Feld entfernen bzw. den Datentyp oder die Ereigniszeit ändern (Markieren als Ereigniszeit: TIMESTAMP BY-Klausel, wenn es sich um ein Feld vom Typ „datetime“ handelt), indem Sie das Symbol mit den drei Punkten neben jedem Feld auswählen. Sie können auch geschachtelte Felder aus den eingehenden Nachrichten erweitern, auswählen und bearbeiten, wie in der folgenden Abbildung dargestellt.

Tipp

Dies gilt auch für die Eingabedaten aus Azure IoT Hub und Azure Data Lake Storage Gen2.

Folgende Datentypen sind verfügbar:

- DateTime: Datums- und Uhrzeitfeld im ISO-Format

- Gleitkomma: Dezimalzahl

- Int: Ganzzahl

- Datensatz: Geschachteltes Objekt mit mehreren Datensätzen

- Zeichenfolge: Text

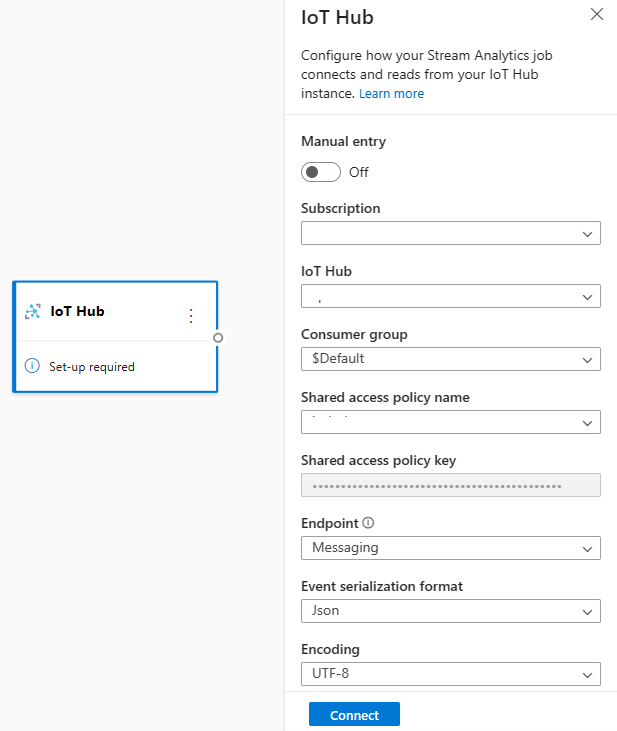

Azure IoT Hub als Streamingeingabe

Azure IoT Hub ist ein verwalteter Dienst, der in der Cloud gehostet wird und als zentraler Nachrichten-Hub für die Kommunikation zwischen einer IoT-Anwendung und deren angeschlossenen Geräten fungiert. An IoT Hub gesendete IoT-Gerätedaten können als Eingabe für einen Stream Analytics-Auftrag verwendet werden.

Hinweis

Die Azure IoT Hub-Eingabe ist im No-Code-Editor im Azure Stream Analytics-Portal verfügbar.

Um einen IoT Hub als Streamingeingabe für Ihren Auftrag hinzuzufügen, wählen Sie IoT Hub unter Eingaben auf dem Menüband aus. Geben Sie dann die erforderlichen Informationen im rechten Bereich ein, um IoT Hub mit Ihrem Auftrag zu verbinden. Weitere Informationen zu den Details der einzelnen Felder finden Sie unter Streamen von Daten vom IoT Hub zum Stream Analytics-Auftrag.

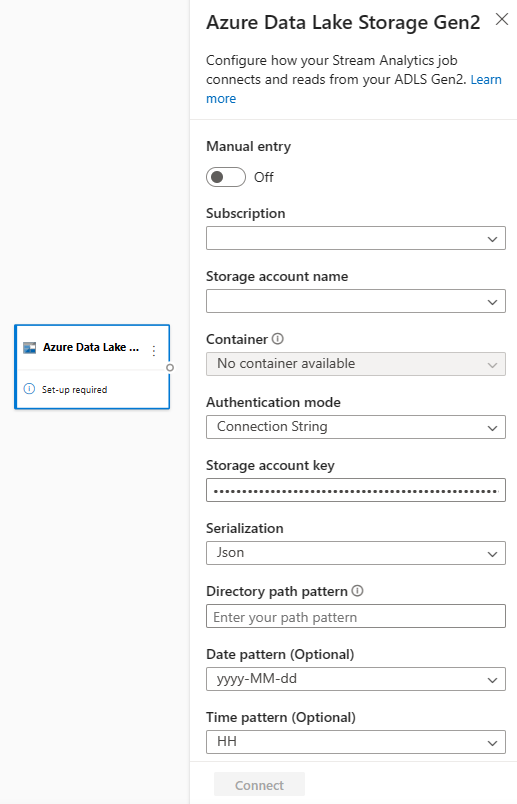

Azure Data Lake Storage Gen2 als Streamingeingabe

Azure Data Lake Storage Gen2 (ADLS Gen2) ist eine cloudbasierte Data Lake-Lösung für Unternehmen. Die Lösung wurde entwickelt, um große Datenmengen in jedem beliebigen Format zu speichern und Big Data-Analyseworkloads zu ermöglichen. Die in ADLS Gen2 gespeicherten Daten können von Stream Analytics als Datenstrom verarbeitet werden. Weitere Informationen zur Art der Eingabe finden Sie unter Streamen von Daten von ADLS Gen2 zum Stream Analytics-Auftrag.

Hinweis

Die Azure Data Lake Storage Gen2-Eingabe ist im No-Code-Editor im Azure Stream Analytics-Portal verfügbar.

Um einen ADLS Gen2 als Streamingeingabe für Ihren Auftrag hinzuzufügen, wählen Sie auf dem Menüband die Option ADLS Gen2 unter Eingaben aus. Geben Sie dann die erforderlichen Informationen im rechten Bereich ein, um ADLS Gen2 mit Ihrem Auftrag zu verbinden. Weitere Informationen zu den Details der einzelnen Felder finden Sie unter Streamen von Daten vom ADLS Gen2 zum Stream Analytics-Auftrag.

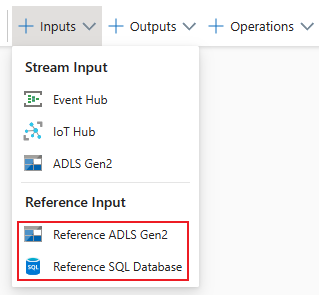

Verweisdateneingaben

Die Verweisdaten sind statisch oder ändern sich im Laufe der Zeit langsam. Sie werden normalerweise verwendet, um eingehende Datenströme anzureichern und Suchen in Ihrem Auftrag durchzuführen. Beispielsweise können Sie Datenstromeingaben mit Verweisdaten verknüpfen – ähnlich wie bei einer SQL-Verknüpfung zum Suchen statischer Werte. Weitere Informationen zu Verweisdateneingaben finden Sie unter Verwenden von Verweisdaten für Suchvorgänge in Stream Analytics.

Der No-Code-Editor unterstützt jetzt zwei Verweisdatenquellen:

- Azure Data Lake Storage Gen2

- Azure SQL-Datenbank

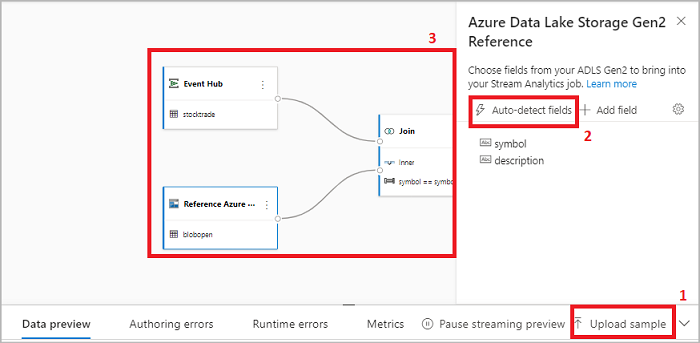

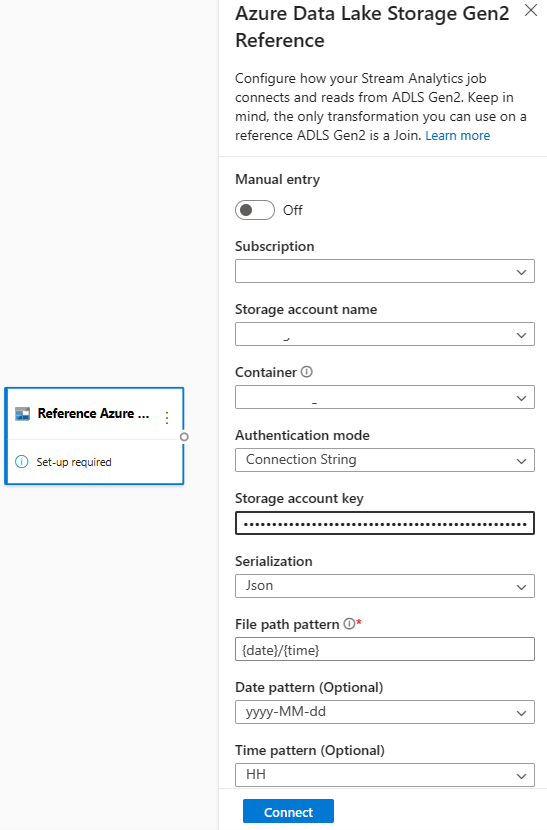

Azure Data Lake Storage Gen2 als Verweisdaten

Verweisdaten werden als Blobsequenz in aufsteigender Reihenfolge nach der im Blobnamen angegebenen Kombination von Datums- bzw. Uhrzeitwert modelliert. Sie können Blobs am Ende der Sequenz nur mithilfe eines Datums- bzw. Uhrzeitwerts hinzufügen, der größer ist als der, den das letzte Blob in der Sequenz angegeben hat. Blobs werden in der Eingabekonfiguration definiert.

Wählen Sie zunächst im Menüband unter dem Abschnitt Eingaben die Option Verweis auf ADLS Gen2 aus. Weitere Informationen zu den einzelnen Feldern finden Sie im Abschnitt über Azure Blob Storage unter Verwenden von Verweisdaten für Suchvorgänge in Stream Analytics.

Dann laden Sie eine JSON-Arraydatei hoch. Die Felder in der Datei werden erkannt. Verwenden Sie diese Verweisdaten, um Transformationen mit Streamingeingabedaten von Event Hubs durchzuführen.

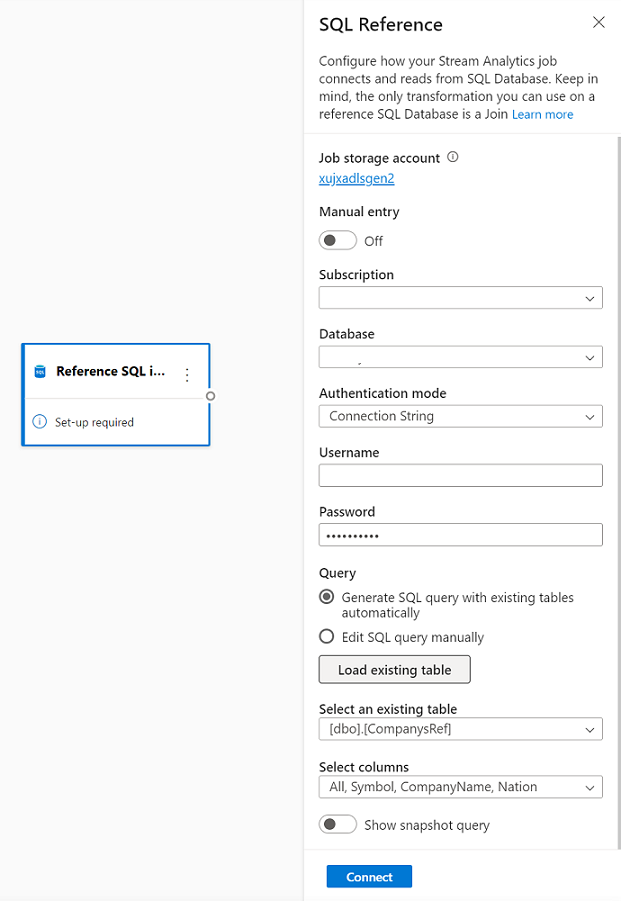

Azure SQL-Datenbank als Verweisdaten

Sie können Azure SQL-Datenbank als Verweisdaten für Ihren Stream Analytics-Auftrag im No-Code-Editor verwenden. Weitere Informationen finden Sie im Abschnitt zu SQL-Datenbank in Verwenden von Verweisdaten für Suchvorgänge in Stream Analytics.

Um SQL-Datenbank als Verweisdateneingabe zu konfigurieren, wählen Sie Verweis auf SQL-Datenbank im Abschnitt Eingaben im Menüband aus. Geben Sie dann die Informationen für die Verbindung mit Ihrer Referenzdatenbank ein, und wählen Sie die Tabelle mit den von Ihnen benötigten Spalten aus. Sie können die Verweisdaten auch aus Ihrer Tabelle abrufen, indem Sie die SQL-Abfrage manuell bearbeiten.

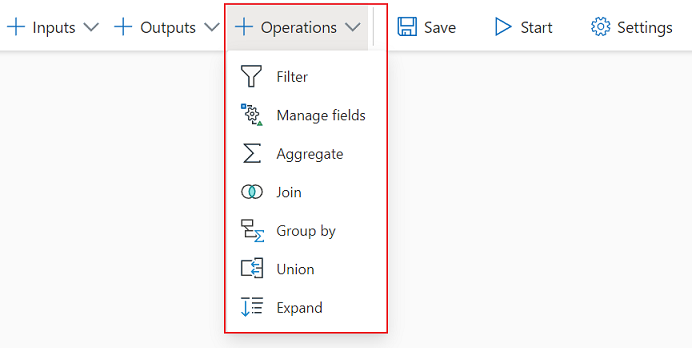

Transformationen

Streamingdatentransformationen unterscheiden sich grundsätzlich von Batchdatentransformationen. Nahezu alle Streamingdaten haben eine Zeitkomponente, die Einfluss auf alle beteiligten Datenaufbereitungsaufgaben hat.

Wählen Sie zum Hinzufügen einer Streamingdatentransformation zu Ihrem Auftrag im Menüband das Transformationssymbol unter dem Abschnitt Vorgänge für die jeweilige Transformation aus. Die entsprechende Kachel wird in der Diagrammansicht abgelegt. Nach Auswahl des Symbols wird der Seitenbereich für die betreffende Transformation angezeigt, sodass Sie sie konfigurieren können.

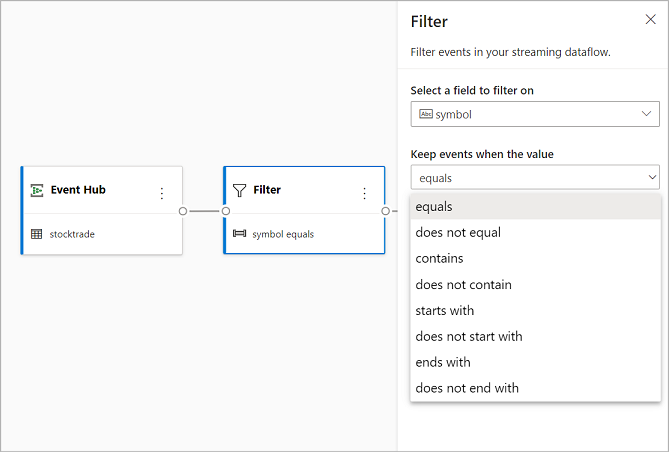

Filtern

Verwenden Sie die Filter-Transformation, um Ereignisse basierend auf dem Wert eines Felds in der Eingabe zu filtern. Abhängig vom Datentyp (Zahl oder Text) werden bei der Transformation die Werte beibehalten, die der ausgewählten Bedingung entsprechen.

Hinweis

In jeder Kachel finden Sie Informationen darüber, was die Transformation noch benötigt. Wenn Sie z. B. eine neue Kachel hinzufügen, wird die Meldung angezeigt, dass die Einrichtung erforderlich ist. Fehlt ein Knotenconnector, wird eine Meldung vom Typ Fehlermeldung oder Warnung angezeigt.

Verwalten von Feldern

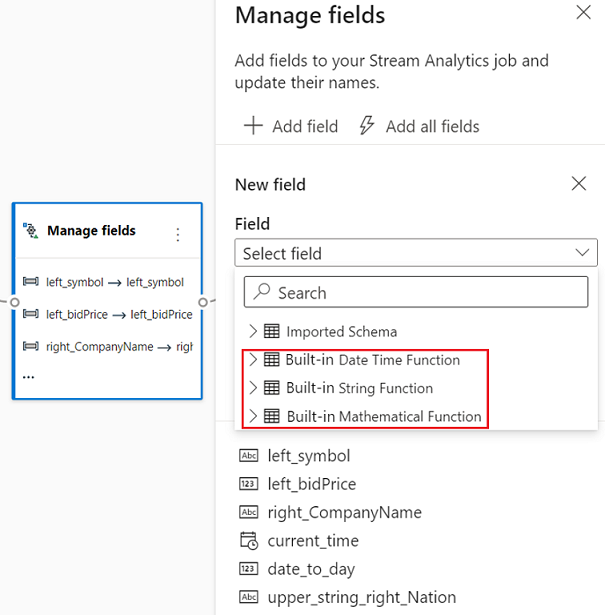

Mit der Transformation Verwalten von Feldern können Sie Felder, die aus einer Eingabe oder einer anderen Transformation stammen, hinzufügen, entfernen oder umbenennen. In den Einstellungen im Seitenbereich haben Sie die Möglichkeit, durch Auswahl von Feld hinzufügen ein neues Feld oder alle Felder zugleich hinzuzufügen.

Sie können auch mit den integrierten Funktionen neue Felder hinzufügen, um die Daten aus dem Upstream zu aggregieren. Die von uns unterstützten integrierten Funktionen sind derzeit einige Funktionen in Zeichenfolgenfunktionen, Datums- und Uhrzeitfunktionen, Mathematische Funktionen. Weitere Informationen zu den Definitionen dieser Funktionen finden Sie unter Integrierte Funktionen (Azure Stream Analytics).

Tipp

Nachdem Sie eine Kachel konfiguriert haben, erhalten Sie in der Diagrammansicht einen Überblick über die Einstellungen auf der Kachel. Beispielsweise können Sie im Bereich Felder verwalten der vorherigen Abbildung sehen, wie die ersten drei Felder verwaltet werden und welche neuen Namen ihnen zugewiesen wurden. Jede Kachel enthält für sie relevante Informationen.

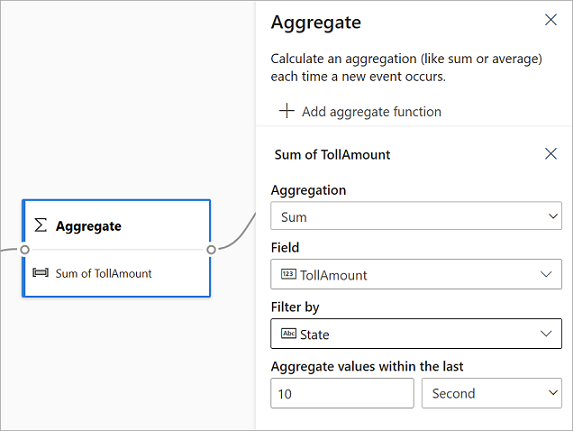

Aggregat

Mithilfe der Aggregattransformation können Sie jedes Mal, wenn in einem Zeitraum ein neues Ereignis eintritt, eine Aggregation (Summe, Minimum, Maximum oder Durchschnitt) berechnen. Mit diesem Vorgang können Sie die Aggregation außerdem basierend auf anderen Dimensionen in Ihren Daten filtern oder segmentieren. Sie können in derselben Transformation eine oder mehrere Aggregationen verwenden.

Wählen Sie das Transformationssymbol aus, um eine Aggregation hinzuzufügen. Verbinden Sie dann eine Eingabe, wählen Sie die Aggregation aus, fügen Sie eventuelle Filter- oder Slicedimensionen hinzu, und wählen Sie den Zeitraum aus, über den die Aggregation berechnet werden soll. In diesem Beispiel berechnen wir die Summe des Mautwerts über die letzten 10 Sekunden nach dem Bundesstaat, in dem sich Fahrzeug befindet.

Um der gleichen Transformation eine weitere Aggregation hinzuzufügen, wählen Sie Aggregatfunktion hinzufügen aus. Beachten Sie, dass der Filter oder das Slice auf alle Aggregationen in der Transformation angewendet wird.

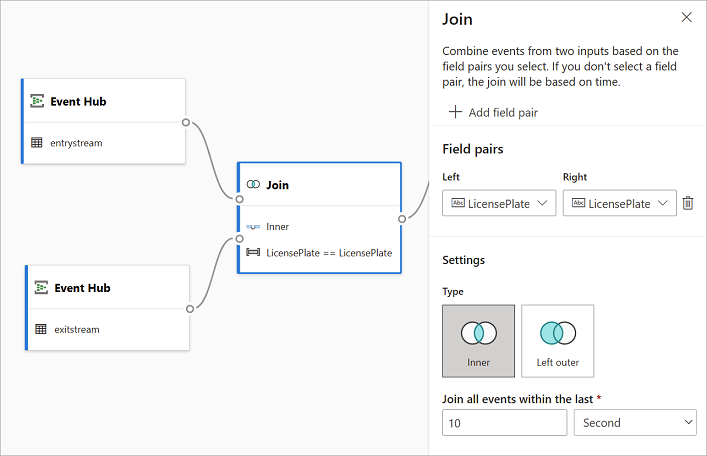

Join

Verwenden Sie die Join-Transformation, um Ereignisse aus zwei Eingaben basierend auf den von Ihnen ausgewählten Feldpaaren zu kombinieren. Wenn Sie kein Feldpaar auswählen, basiert der Join standardmäßig auf der Zeit. Standardmäßig unterscheidet sich diese Transformation von einer Batch-Transformation.

Wie bei regulären Joins haben Sie Optionen für Ihre Verknüpfungslogik:

- Innerer Join: Enthält nur Datensätze aus beiden Tabellen, in denen das Paar übereinstimmt. In diesem Beispiel also die Fälle, in denen das Nummernschild mit beiden Eingaben übereinstimmt.

- Linker äußerer Join: Eingeschlossen sind alle Datensätze aus der linken (ersten) Tabelle und nur die Datensätze aus der zweiten, die dem Feldpaar entsprechen. Wenn keine Übereinstimmung besteht, sind die Felder aus der zweiten Eingabe leer.

Wählen Sie zum Auswählen des Jointyps im Seitenbereich das Symbol für den gewünschten Typ aus.

Wählen Sie abschließend aus, für welchen Zeitraum der Join berechnet werden soll. In diesem Beispiel berücksichtigt der Join die letzten 10 Sekunden. Je länger der Zeitraum ist, desto seltener erfolgt die Ausgabe und desto mehr Verarbeitungsressourcen werden für die Transformation aufgewendet.

Standardmäßig sind alle Felder aus beiden Tabellen enthalten. Die Präfixe links (erster Knoten) und rechts (zweiter Knoten) in der Ausgabe helfen ihnen, die Quelle unterscheiden zu können.

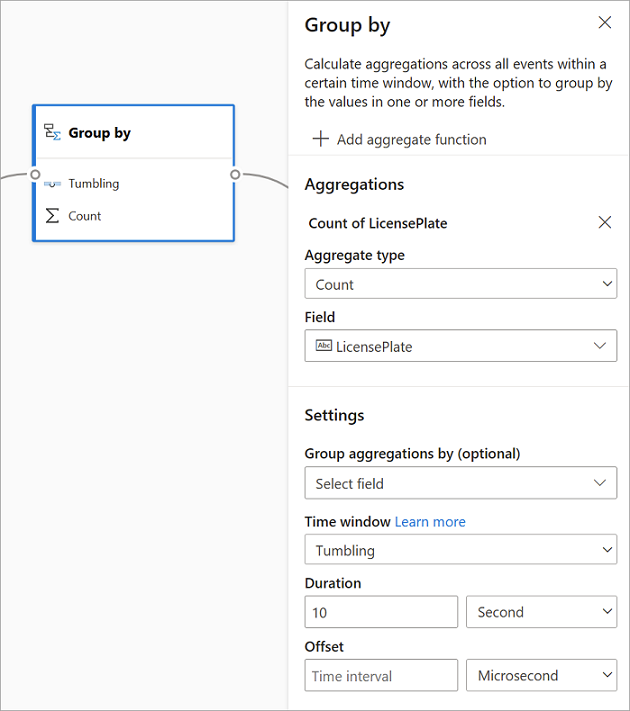

Gruppieren nach

Verwenden Sie die Gruppieren nach-Transformation, um Aggregationen für alle Ereignisse innerhalb eines bestimmten Zeitfensters zu berechnen. Sie können die Ansicht nach den Werten in einem oder mehreren Feldern gruppieren. Dies ähnelt der Transformation Aggregat, bietet jedoch mehr Optionen für Aggregationen. Sie enthält auch komplexere Optionen für Zeitfenster. Ebenfalls ähnlich wie bei Aggregat können Sie pro Transformation mehrere Aggregationen hinzufügen.

Für die Transformation sind folgende Aggregationen verfügbar:

- Average

- Count

- Maximum

- Mindestanforderungen

- Perzentil (kontinuierlich und diskret)

- Standardabweichung

- Sum

- Variance

So konfigurieren Sie die Transformation:

- Wählen Sie Ihre bevorzugte Aggregation aus.

- Wählen Sie das Feld aus, für das Sie die Aggregation durchführen möchten.

- Wählen Sie optional ein Feld unter „Gruppieren nach“ aus, wenn Sie die Aggregatberechnung für eine andere Dimension oder Kategorie erhalten möchten Beispiel: Zustand.

- Wählen Sie Ihre Funktion für die Zeitfenster aus.

Um der gleichen Transformation eine weitere Aggregation hinzuzufügen, wählen Sie Aggregatfunktion hinzufügen aus. Beachten Sie, dass sich das Feld Gruppieren nach und die Zeitfensterfunktion auf alle in der Transformation enthaltenen Aggregationen beziehen.

Ein Zeitstempel für das Ende des Zeitfensters wird zur Referenz als Teil der Transformationsausgabe angezeigt. Weitere Informationen zu den von Stream Analytics-Aufträgen unterstützten Zeitfenstern finden Sie unter Windowingfunktionen (Azure Stream Analytics).

Union

Mithilfe von Union-Transformation können Sie zwei oder mehr Eingaben verbinden, um Ereignisse mit gemeinsamen Feldern (mit dem gleichen Namen und Datentyp) in eine Tabelle einzufügen. Felder, die nicht übereinstimmen, werden verworfen und sind nicht in der Ausgabe enthalten.

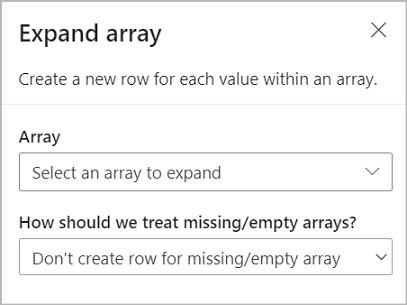

Array erweitern

Verwenden Sie die Transformation Array erweitern, um eine neue Zeile für jeden Wert in einem Array zu erstellen.

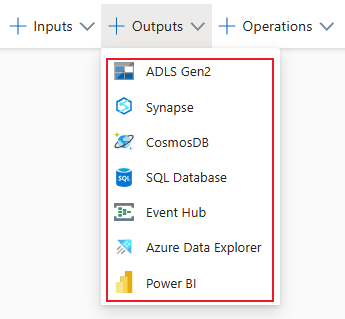

Streamingausgaben

Die No-Code-Drag & Drop-Benutzeroberfläche unterstützt derzeit verschiedene Ausgabesenken zum Speichern Ihrer verarbeiteten Echtzeitdaten.

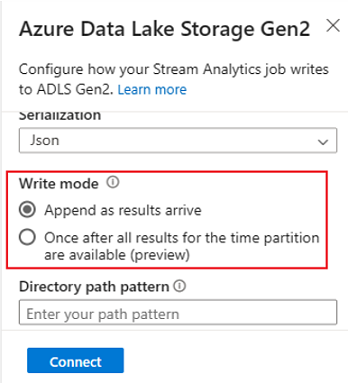

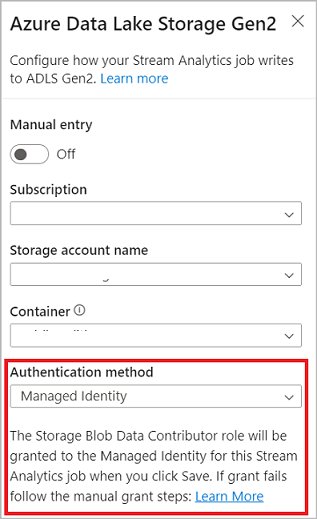

Azure Data Lake Storage Gen2

Mit Data Lake Storage Gen2 wird Azure Storage zur Grundlage für das Erstellen von Enterprise Data Lakes in Azure. Diese SKU ist darauf ausgelegt, mehrere Petabyte an Informationen bereitzustellen und gleichzeitig Hunderte von Gigabyte an Durchsatz zu unterstützen. Sie ermöglicht Ihnen die einfache Verwaltung großer Datenmengen. Azure Blob Storage bietet eine kostengünstige und skalierbare Lösung zum Speichern von großen Mengen unstrukturierter Daten in der Cloud.

Wählen Sie im Menüband im Bereich Ausgaben die Option ADLS Gen2 als Ausgabe für Ihren Stream Analytics-Auftrag aus. Wählen Sie dann den Container aus, in den Sie die Ausgabe des Auftrags senden möchten. Weitere Informationen zur Azure Data Lake Gen2-Ausgabe für einen Stream Analytics-Auftrag finden Sie unter Blob Storage- und Azure Data Lake Gen2-Ausgabe von Azure Stream Analytics.

Wenn Sie eine Verbindung mit Azure Data Lake Storage Gen2 herstellen und als Authentifizierungsmodus Verwaltete Identität auswählen, wird der verwalteten Identität für den Stream Analytics-Auftrag die Rolle „Mitwirkender an Storage-Blobdaten“ zugewiesen. Weitere Informationen über verwaltete Identitäten für Azure Data Lake Storage Gen2 finden Sie unter Verwenden verwalteter Identitäten zum Authentifizieren Ihres Azure Stream Analytics-Auftrags für Azure Blob Storage.

Verwaltete Identitäten beseitigen die Einschränkungen von benutzerbasierten Authentifizierungsmethoden. Zu diesen Einschränkungen gehört, dass Sie sich neu authentifizieren müssen, wenn sich das Kennwort ändert oder das Benutzertoken alle 90 Tage abläuft.

Zustellung vom Typ „Genau einmal“ (Vorschau) wird in ADLS Gen2 als Ausgabe des No-Code-Editors unterstützt. Das Feature kann im Abschnitt Schreibmodus der ADLS Gen2-Konfiguration aktiviert werden. Weitere Informationen zu diesem Feature finden Sie unter Zustellung vom Typ „Genau einmal“ (Public Preview).

Schreiben in eine Delta Lake-Tabelle (Vorschau) wird in ADLS Gen2 als Ausgabe des No-Code-Editors unterstützt. Auf diese Option kann im Abschnitt Serialisierung der ADLS Gen2-Konfiguration zugegriffen werden. Weitere Informationen zu diesem Feature finden Sie unter Azure Stream Analytics: Schreiben in eine Delta Lake-Tabelle.

Azure Synapse Analytics

Azure Stream Analytics-Aufträge können die Ausgabe an eine spezielle SQL-Pooltabelle in Azure Synapse Analytics senden und Durchsatzraten von bis zu 200 MB pro Sekunde verarbeiten. Stream Analytics unterstützt die anspruchsvollsten Echtzeitanalysen und Datenverarbeitungsanforderungen für den langsamsten Pfad für Workloads wie Berichterstellung und Dashboarding.

Wichtig

Die dedizierte SQL-Pooltabelle muss vorhanden sein, bevor Sie sie Ihrem Stream Analytics-Auftrag als Ausgabe hinzufügen können. Das Schema der Tabelle muss den Feldern und deren Typen in der Ausgabe Ihres Auftrags entsprechen.

Wählen Sie im Menüband im Bereich Ausgaben die Option Synapse als Ausgabe für Ihren Stream Analytics-Auftrag aus. Wählen Sie dann die SQL-Pooltabelle aus, in die Sie die Ausgabe des Auftrags senden möchten. Weitere Informationen zur Azure Synapse-Ausgabe für einen Stream Analytics-Auftrag finden Sie unter Azure Synapse Analytics-Ausgabe für Azure Stream Analytics.

Azure Cosmos DB

Azure Cosmos DB ist ein global verteilter Datenbankdienst, der eine unbegrenzte elastische Skalierung rund um den Globus bietet. Außerdem bietet es umfangreiche Abfragen und automatische Indizierung über schemaunabhängige Datenmodelle.

Wählen Sie im Menüband im Bereich Ausgaben die Option CosmosDB als Ausgabe für Ihren Stream Analytics-Auftrag aus. Weitere Informationen zur Azure Cosmos DB-Ausgabe für einen Stream Analytics-Auftrag finden Sie unter Azure Cosmos DB-Ausgabe von Azure Stream Analytics.

Wenn Sie eine Verbindung mit Azure Cosmos DB herstellen und als Authentifizierungsmodus Verwaltete Identität auswählen, wird der verwalteten Identität für den Stream Analytics-Auftrag die Rolle „Mitwirkender“ zugewiesen. Weitere Informationen über verwaltete Identitäten für Azure Cosmos DB finden Sie unter Verwenden von verwalteten Identitäten für den Zugriff auf Azure Cosmos DB aus einem Azure Stream Analytics-Auftrag (Vorschau).

Die Authentifizierungsmethode für verwaltete Identitäten wird auch in der Azure Cosmos DB-Ausgabe im No-Code-Editor unterstützt, was denselben Vorteil hat wie in der obigen ADLS Gen2-Ausgabe.

Azure SQL-Datenbank

Azure SQL-Datenbank ist eine vollständig verwaltete PaaS-Datenbank-Engine (Platform-as-a-Service), mit der Sie eine hochverfügbare und leistungsstarke Datenspeicherebene für die Anwendungen und Lösungen in Azure erstellen können. Mithilfe des No-Code-Editors können Sie Azure Stream Analytics-Aufträge so konfigurieren, dass die verarbeiteten Daten in eine bestehende Tabelle in der SQL-Datenbank geschrieben werden.

Um Azure SQL-Datenbank als Ausgabe zu konfigurieren, wählen Sie SQL-Datenbank unter dem Abschnitt Ausgaben im Menüband aus. Füllen Sie dann die erforderlichen Informationen aus, um Ihre SQL-Datenbank zu verbinden und wählen Sie die Tabelle aus, in die Sie Daten schreiben möchten.

Wichtig

Die Azure SQL-Datenbank-Tabelle muss vorhanden sein, bevor Sie sie Ihrem Stream Analytics-Auftrag als Ausgabe hinzufügen können. Das Schema der Tabelle muss den Feldern und deren Typen in der Ausgabe Ihres Auftrags entsprechen.

Weitere Informationen zur Azure SQL-Datenbank-Ausgabe für einen Stream Analytics-Auftrag finden Sie unter Azure SQL-Datenbank-Ausgabe für Azure Stream Analytics.

Event Hubs

Mit den Echtzeitdaten, die an Azure Stream Analytics (ASA) übermittelt werden, kann der No-Code-Editor die Daten transformieren, anreichern und dann an einen anderen Event Hub ausgeben. Sie können die Event Hub-Ausgabe auswählen, wenn Sie Ihren Azure Stream Analytics-Auftrag konfigurieren.

Um Event Hubs als Ausgabe zu konfigurieren, wählen Sie auf dem Menüband unter dem Abschnitt „Ausgaben“ die Option Event Hub aus. Füllen Sie dann die erforderlichen Informationen aus, um die Verbindung mit Ihrem Event Hub herzustellen, in den Sie Daten schreiben möchten.

Weitere Informationen zur Event Hubs-Ausgabe für einen Stream Analytics-Auftrag finden Sie unter Event Hubs-Ausgabe für Azure Stream Analytics.

Azure-Daten-Explorer

Azure Data Explorer ist eine vollständig verwaltete, leistungsstarke Big Data-Analyseplattform, die das Analysieren großer Datenmengen vereinfacht. Sie können Azure Data Explorer auch mithilfe des No-Code-Editors als Ausgabe für Ihren Azure Stream Analytics-Auftrag verwenden.

Um Azure Data Explorer als Ausgabe zu konfigurieren, wählen Sie Azure Data Explorer unter dem Abschnitt „Ausgaben“ im Menüband aus. Füllen Sie dann die erforderlichen Informationen aus, um Ihre Azure Data Explorer-Datenbank zu verbinden und geben Sie die Tabelle an, in die Sie Daten schreiben möchten.

Wichtig

Die Tabelle muss in der von Ihnen gewählten Datenbank existieren und das Schema der Tabelle muss genau mit den Feldern und deren Typen in der Ausgabe Ihres Auftrags übereinstimmen.

Weitere Informationen zur Azure Data Explorer-Ausgabe für einen Stream Analytics-Auftrag finden Sie unter Azure Data Explorer-Ausgabe von Azure Stream Analytics (Vorschau).

Power BI

Power BI bietet eine umfassende Visualisierungsumgebung für die Ergebnisse Ihrer Datenanalyse. Mit der Power BI-Ausgabe in Stream Analytics werden die verarbeiteten Streamingdaten in das Power BI-Streamingdataset geschrieben und können dann zum Erstellen des Power BI-Dashboards in Quasi-Echtzeit verwendet werden. Weitere Informationen zum Erstellen des Dashboards in Quasi-Echtzeit finden Sie unter Erstellen eines Echtzeitdashboards mit einem Power BI-Dataset, das über den No-Code-Editor von Stream Analytics erstellt wird.

Um Power BI als Ausgabe zu konfigurieren, wählen Sie Power BI unter dem Abschnitt Ausgaben auf dem Menüband aus. Geben Sie dann die erforderlichen Informationen ein, um eine Verbindung mit Ihrem Power BI-Arbeitsbereich herzustellen, und geben Sie die Namen für das Streamingdataset und die Tabelle an, in die Sie die Daten schreiben möchten. Mehr über die Details der einzelnen Felder erfahren Sie unter Power BI-Ausgabe für Azure Stream Analytics.

Datenvorschau, Erstellungsfehler, Runtimeprotokolle und Metriken

Die No-Code-Drag & Drop-Benutzeroberfläche bietet Tools, mit denen Sie Ihre Analysepipeline für Streamingdaten erstellen, Probleme beheben sowie die Leistung der Pipeline bewerten können.

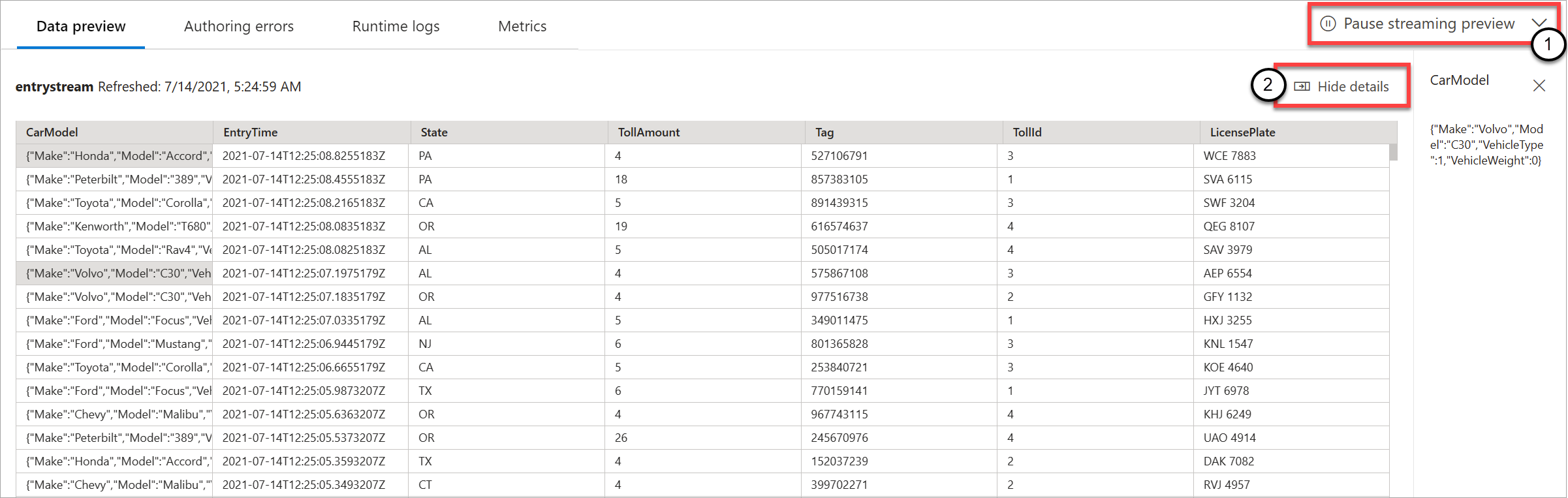

Livedatenvorschau für Eingaben

Wenn Sie eine Verbindung mit einer Eingabequelle wie einem Event Hub herstellen und deren Kachel in der Diagrammansicht (Registerkarte Datenvorschau) auswählen, erhalten Sie eine Livevorschau der eingehenden Daten, sofern alle der folgenden Punkte zutreffen:

- Daten werden per Push übertragen.

- Die Eingabe ist ordnungsgemäß konfiguriert.

- Felder wurden hinzugefügt.

Wie im folgenden Screenshot zu sehen, können Sie die Vorschau (1) anhalten, wenn Sie etwas Bestimmtes anzeigen oder einen Drilldown ausführen möchten. Oder Sie können sie erneut starten, wenn Sie fertig sind.

Sie können auch die Details eines bestimmten Datensatzes, d. h. einer Zelle in der Tabelle, anzeigen, indem Sie ihn auswählen und dann Details anzeigen/ausblenden (2) auswählen. Der Screenshot zeigt die detaillierte Ansicht eines geschachtelten Objekts in einem Datensatz.

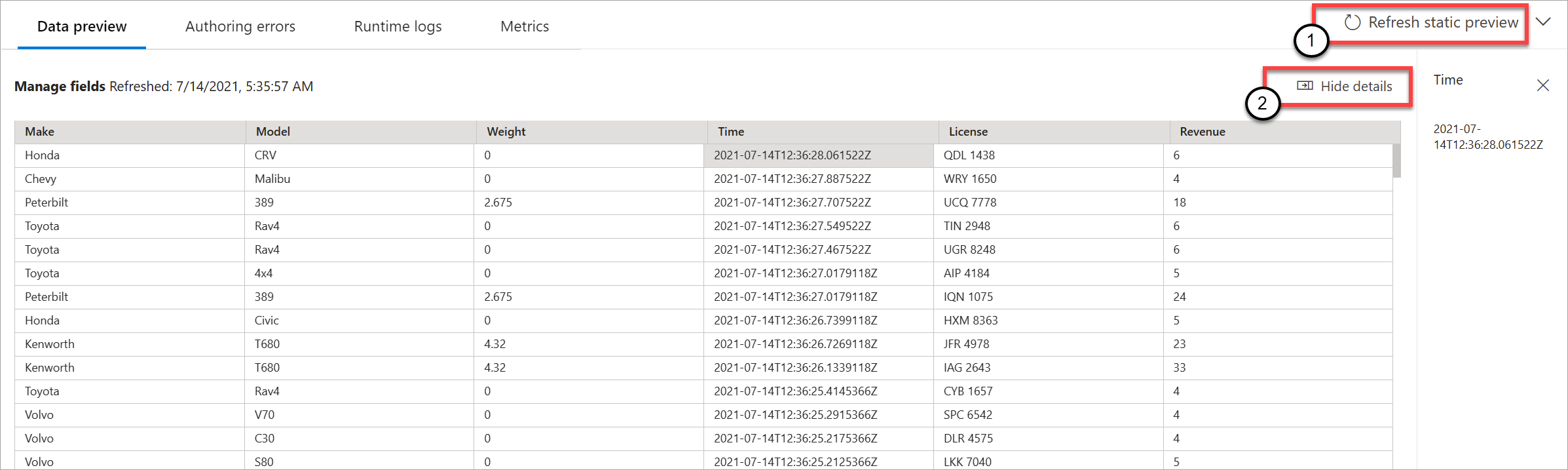

Statische Vorschau für Transformationen und Ausgaben

Nachdem Sie Schritte in der Diagrammansicht hinzugefügt und eingerichtet haben, können Sie deren Verhalten testen, indem Sie die Schaltfläche Statische Vorschau abrufen auswählen.

Anschließend wertet der Stream Analytics-Auftrag alle Transformationen und Ausgaben aus, um sicherzustellen, dass sie korrekt konfiguriert sind. Stream Analytics zeigt die Ergebnisse dann wie in der folgenden Abbildung gezeigt in der statischen Datenvorschau an.

Sie können die Vorschau aktualisieren, indem Sie Statische Vorschau aktualisieren (1) auswählen. Wenn Sie die Vorschau aktualisieren, übernimmt der Stream Analytics-Auftrag neue Daten aus der Eingabe und wertet alle Transformationen aus. Dann sendet sie die Ausgabe erneut mit allen Aktualisierungen, die Sie möglicherweise vorgenommen haben. Die Option Details ein-/ausblenden ist ebenfalls verfügbar (2).

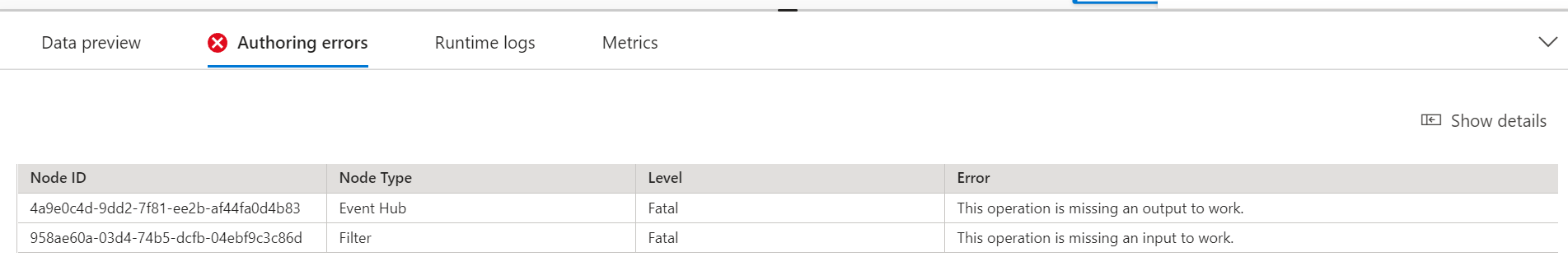

Erstellungsfehler

Wenn Erstellungsfehler oder Warnungen vorliegen, werden diese wie im folgenden Screenshot gezeigt auf der Registerkarte Erstellungsfehler aufgelistet. Die Liste enthält Details zum Fehler bzw. zur Warnung, zum Kartentyp (Eingabe, Transformation oder Ausgabe) und zur Fehlerstufe sowie eine Beschreibung des Fehlers bzw. der Warnung.

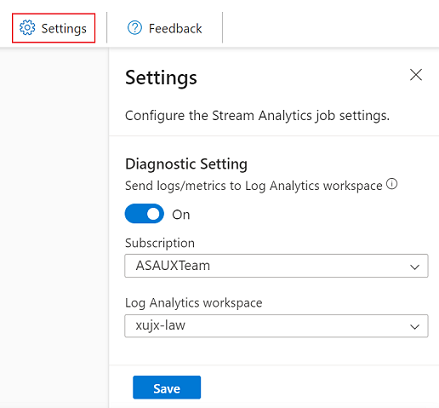

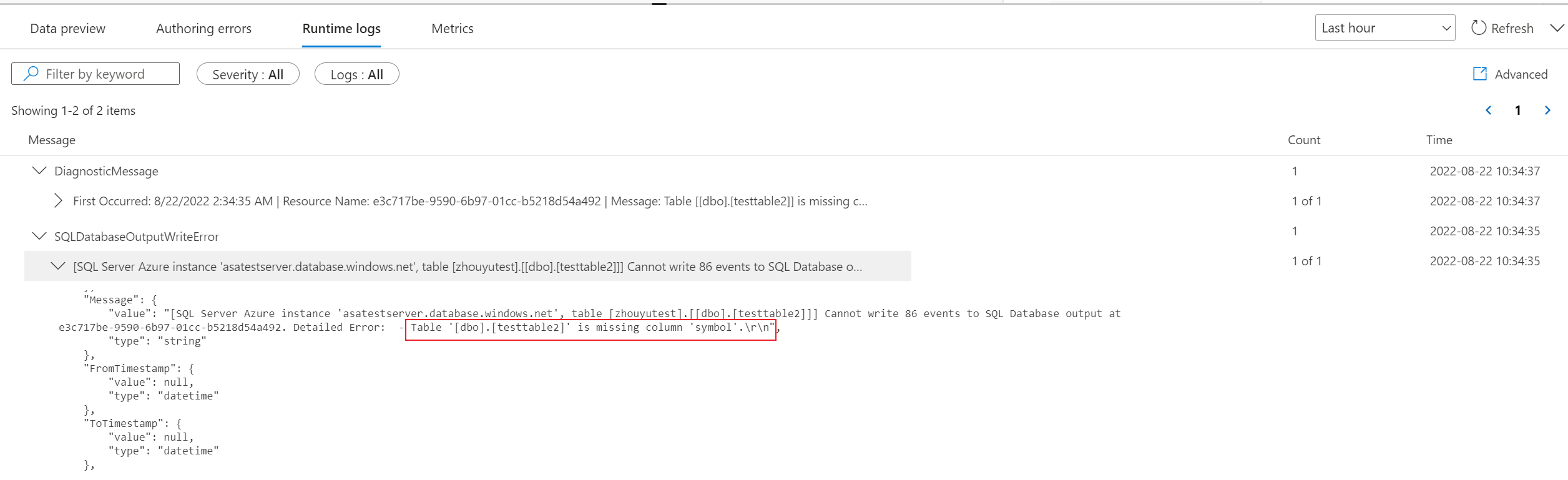

Runtimeprotokolle

Runtimeprotokolle werden auf der Warn-, Fehler- oder Informationsebene angezeigt, wenn ein Auftrag ausgeführt wird. Diese Protokolle sind hilfreich, wenn Sie die Topologie oder Konfiguration Ihres Stream Analytics-Auftrags für die Problembehandlung bearbeiten möchten. Wir empfehlen Ihnen dringend, die Diagnoseprotokolle zu aktivieren und an den Log Analytics-Arbeitsbereich in Einstellungen zu senden, um mehr Erkenntnisse über Ihre ausgeführten Aufträge zum Debuggen zu erhalten.

Im folgenden Screenshotbeispiel hat der Benutzer die SQL-Datenbank-Ausgabe mit einem Tabellenschema konfiguriert, das nicht mit den Feldern der Auftragsausgabe übereinstimmt.

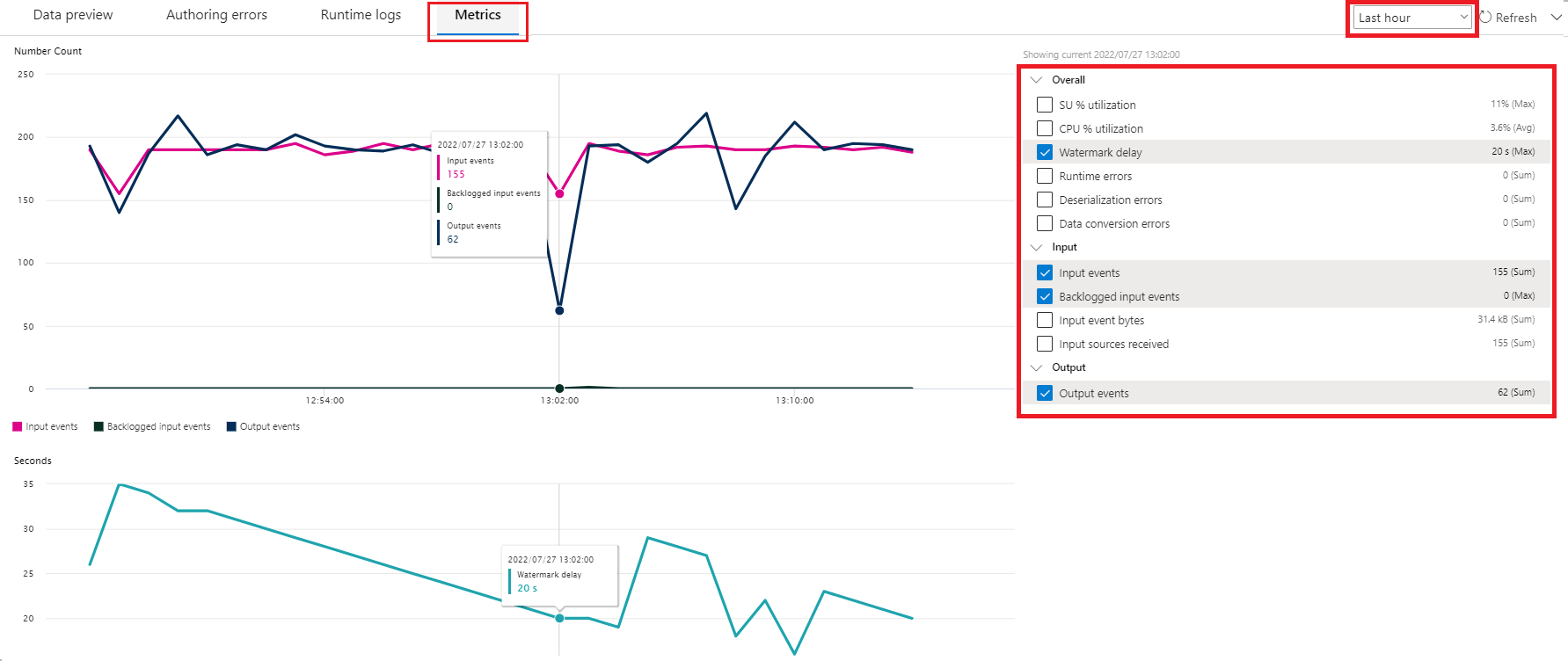

Metriken

Wenn der Auftrag ausgeführt wird, können Sie die Integrität Ihres Auftrags auf der Registerkarte Metriken überwachen. Die vier standardmäßig angezeigten Metriken sind Wasserzeichenverzögerung, Eingabeereignisse, Noch nicht verarbeitete Eingabeereignisse und Ausgabeereignisse. Sie können diese Metriken verwenden, um zu verstehen, ob die Ereignisse in den Auftrag hinein und aus ihm heraus gelangen, ohne dass es einen Eingabebacklog gibt.

Sie können weitere Metriken aus der Liste auswählen. Informationen zu allen Metriken im Detail finden Sie unter Azure Stream Analytics-Auftragsmetriken.

Starten eines Stream Analytics-Auftrags

Sie können den Auftrag jederzeit beim Erstellen speichern. Nachdem Sie die Streamingeingaben, Transformationen und die Streamingausgaben für den Auftrag konfiguriert haben, können Sie den Auftrag starten.

Hinweis

Obwohl sich der No-Code-Editor im Azure Stream Analtyics-Portal noch in der Vorschau befindet, ist der Azure Stream Analytics-Dienst allgemein verfügbar.

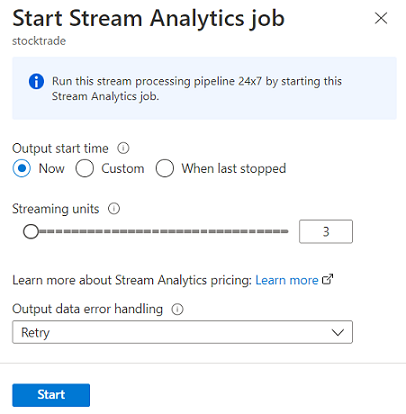

Sie können folgende Optionen konfigurieren:

- Startzeitpunkt der Ausgabe: Wenn Sie einen Auftrag starten, wählen Sie eine Uhrzeit aus, zu der der Auftrag mit dem Erstellen der Ausgabe beginnen soll.

- Jetzt: Diese Option legt den Startzeitpunkt des Ausgabeereignisstreams als Zeitpunkt des Auftragsstarts fest.

- Benutzerdefiniert: Sie können den Startzeitpunkt der Ausgabe auswählen.

- Zeitpunkt der letzten Beendigung: Diese Option ist verfügbar, wenn der Auftrag bereits gestartet wurde, jedoch entweder manuell oder durch einen Fehler beendet wurde. Bei Auswahl dieser Option wird der letzte Ausgabezeitpunkt zum Neustarten des Auftrags verwendet, sodass keine Daten verloren gehen.

- Streamingeinheiten: Streamingeinheiten (Streaming Unit, SU) stellen die Menge an Compute- und Arbeitsspeicherressourcen dar, die dem Auftrag während der Ausführung zugewiesen werden. Wenn Sie nicht sicher sind, wie viele SUs Sie auswählen sollten, empfehlen wir, mit drei zu beginnen und die Anzahl nach Bedarf anzupassen.

- Fehlerbehandlung für Ausgabedaten: Richtlinien für die Fehlerbehandlung für Ausgabedaten gelten nur, wenn das von einem Stream Analytics-Auftrag generierte Ausgabeereignis nicht dem Schema der Zielsenke entspricht. Sie können die Richtlinie durch Auswählen von Wiederholen oder Verwerfen konfigurieren. Weitere Informationen finden Sie unter Azure Stream Analytics-Ausgabefehlerrichtlinie.

- Start: Mit dieser Schaltfläche starten Sie den Stream Analytics-Auftrag.

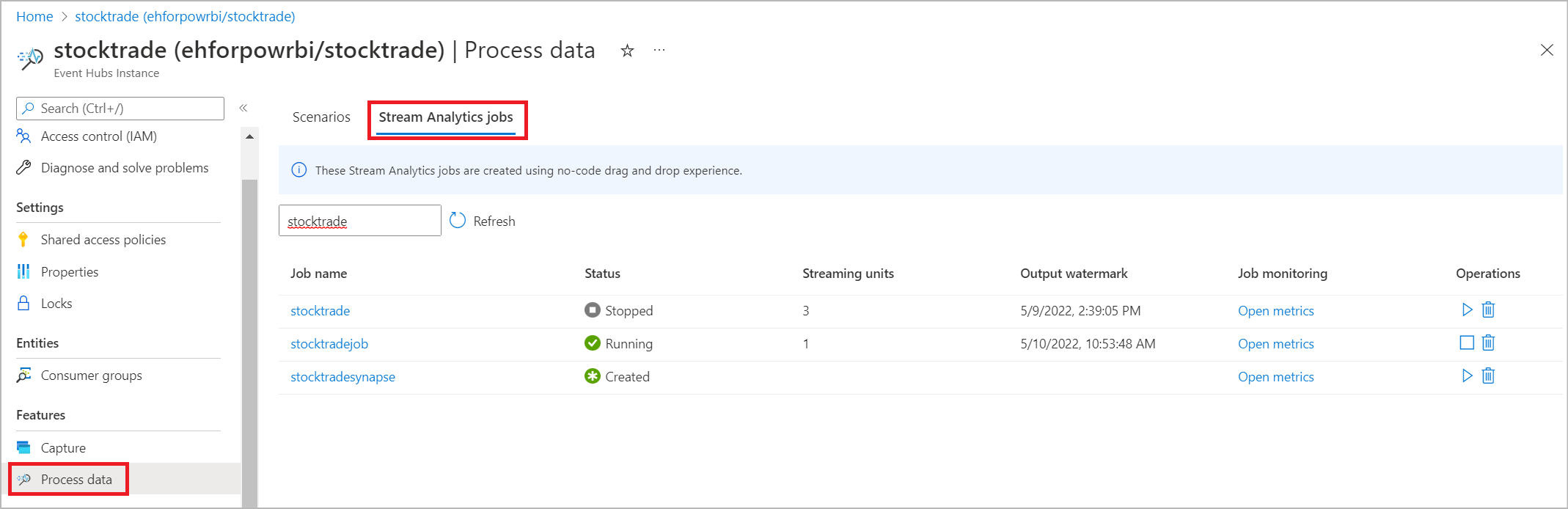

Stream Analytics-Auftragsliste in Azure Event Hubs-Portal

Um eine Liste aller Stream Analytics-Aufträge anzuzeigen, die Sie mithilfe der Drag & Drop-Funktion ohne Code im Azure Event Hubs-Portal erstellt haben, wählen Sie Daten verarbeiten>Stream Analytics-Aufträge aus.

Dies sind die Elemente der Registerkarte Stream Analytics-Aufträge:

- Filtern: Sie können die Liste nach dem Auftragsnamen filtern.

- Aktualisieren: Derzeit wird die Liste nicht automatisch aktualisiert. Verwenden Sie die Schaltfläche Aktualisieren, um die Liste zu aktualisieren und den aktuellen Status anzuzeigen.

- Auftragsname: Der Name in diesem Bereich ist der Name, den Sie im ersten Schritt der Auftragserstellung bereitgestellt haben. Der Name kann nicht bearbeitet werden. Wählen Sie den Auftragsnamen aus, um den Auftrag in der No-Code-Drag & Drop-Benutzeroberfläche zu öffnen, wo Sie ihn beenden, bearbeiten und erneut starten können.

- Status: Dieser Bereich zeigt den Status des Auftrags an. Wählen Sie oben in der Liste die Option Aktualisieren aus, um den aktuellen Status anzuzeigen.

- Streamingeinheiten: In diesem Bereich wird die Anzahl der Streamingeinheiten angezeigt, die Sie beim Starten des Auftrags ausgewählt haben.

- Ausgabewasserzeichen: Dieser Bereich bietet einen Indikator für die Aktualität der Daten, die der Auftrag erzeugt hat. Alle Ereignisse vor dem Zeitstempel sind bereits berechnet.

- Auftragsüberwachung: Wählen Sie Metriken öffnen aus, um die Metriken im Zusammenhang mit dem Stream Analytics-Auftrag anzuzeigen. Weitere Informationen zu den Metriken, die Sie zum Überwachen Ihres Stream Analytics-Auftrags verwenden können, finden Sie unter Azure Stream Analytics-Auftragsmetriken.

- Vorgänge: Sie können den Auftrag starten, beenden oder löschen.

Nächste Schritte

Erfahren Sie, wie Sie den No-Code-Editor mit vordefinierten Vorlagen für gängige Szenarien verwenden: