Hinzufügen der Apache Kafka-Quelle zu einem Eventstream (Vorschau)

In diesem Artikel wird gezeigt, wie Sie apache Kafka-Quelle zu einem Eventstream hinzufügen.

Apache Kafka ist eine verteilte Open-Source-Plattform zum Erstellen skalierbarer Systeme mit Echtzeitdaten. Durch die Integration von Apache Kafka als Quelle in Ihren Eventstream können Sie die Echtzeitereignisse von Apache Kafka nahtlos übertragen und verarbeiten, bevor Sie sie an mehrere Ziele innerhalb von Fabric weiterleiten.

Hinweis

Diese Quelle wird in den folgenden Regionen Ihrer Arbeitsbereichskapazität nicht unterstützt: USA, Westen 3; Schweiz, Westen.

Voraussetzungen

- Erhalten Sie Zugriff auf einen Fabric-Arbeitsbereich mit Mitwirkender-Berechtigungen oder höher.

- Ein Apache Kafka-Cluster wird ausgeführt.

- Ihr Apache Kafka muss öffentlich zugänglich sein und darf sich nicht hinter einer Firewall oder in einem virtuellen Netzwerk befinden.

Hinweis

Die maximale Anzahl der Quellen und Ziele für einen Eventstream beträgt 11.

Apache Kafka als Quelle hinzufügen

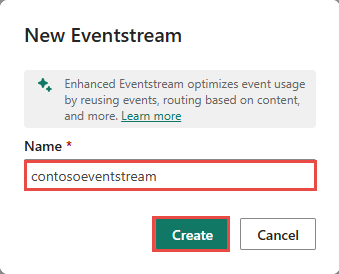

In Fabric Echtzeitintelligenz wählen Sie Eventstream aus, um einen neuen Eventstream zu erstellen.

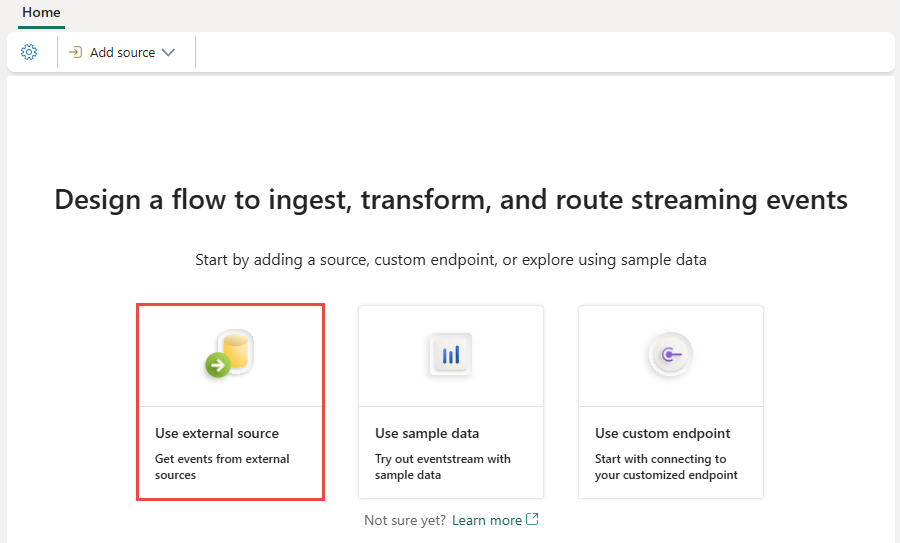

Wählen Sie auf der nächsten Anzeige Externe Quelle hinzufügen aus.

Konfigurieren und Herstellen einer Verbindung mit Apache Kafka

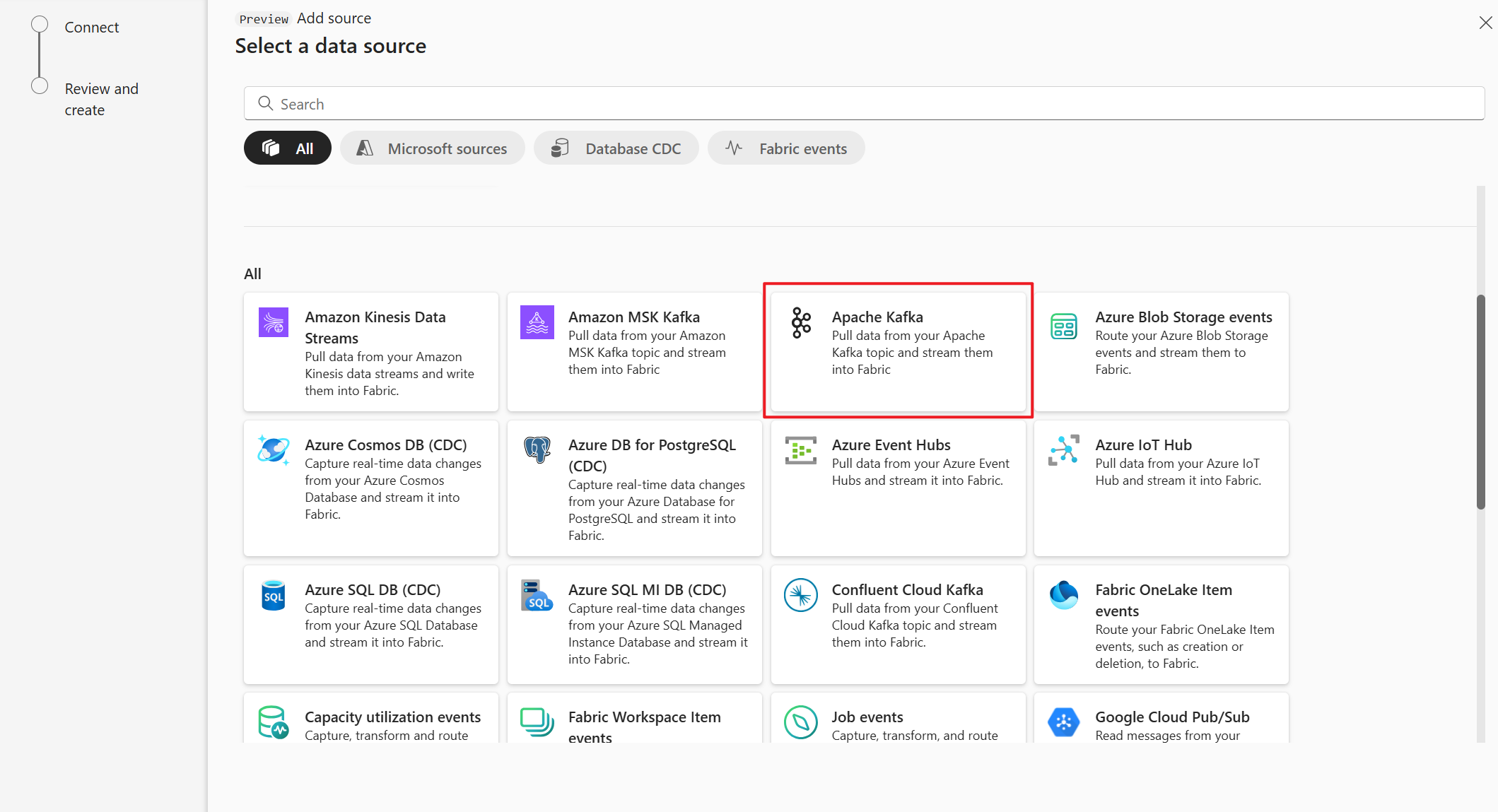

Wählen Sie auf der Seite Datenquelle auswählen die Option Apache Kafkaaus.

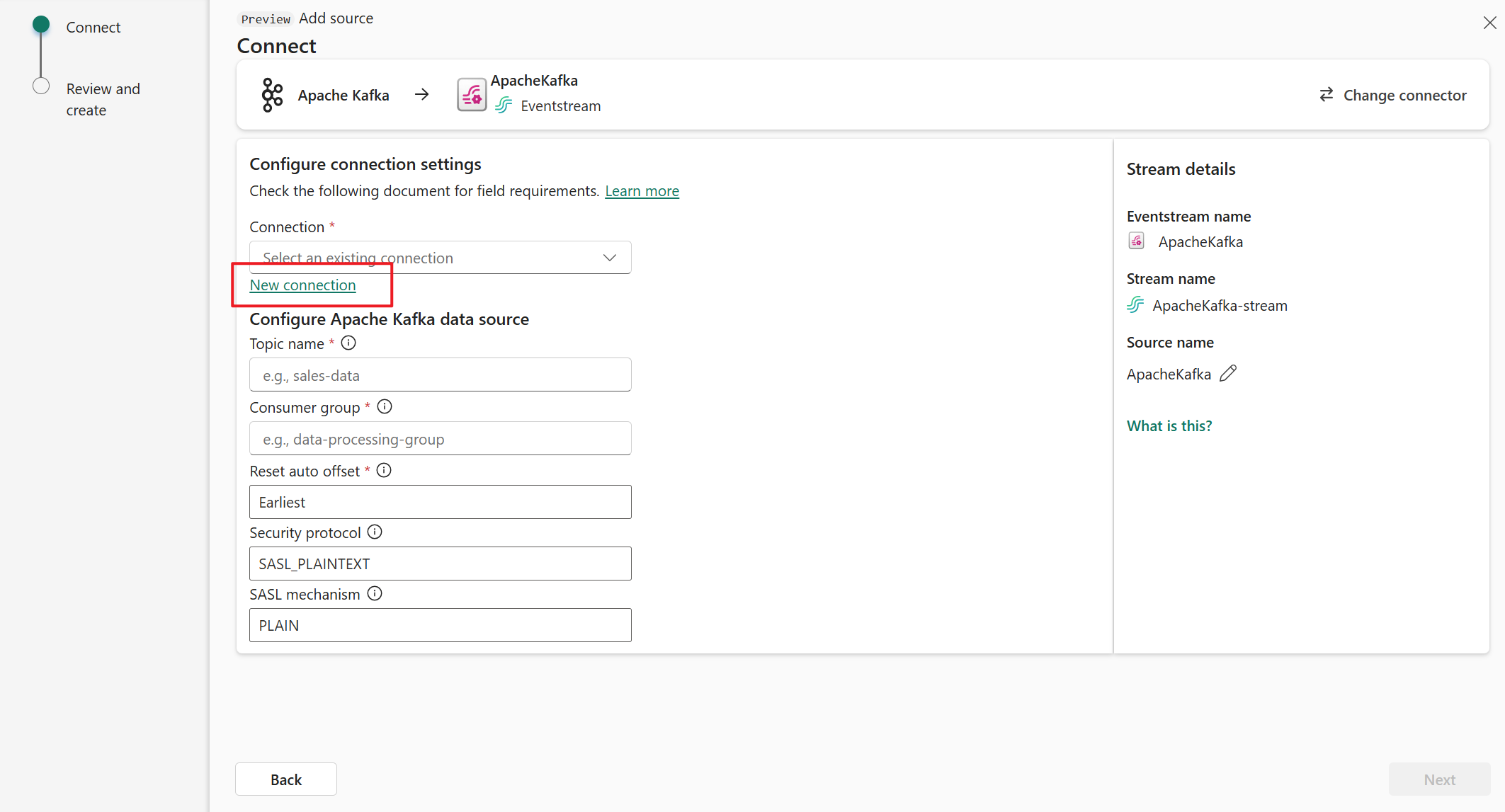

Wählen Sie auf der Seite Verbinden die Option Neue Verbindung aus.

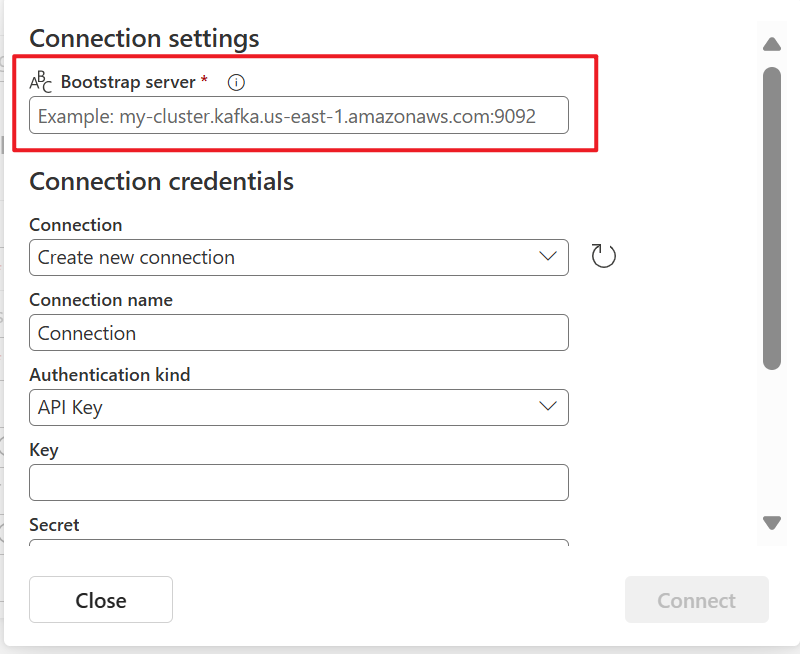

Geben Sie im Abschnitt Verbindungseinstellungen für Bootstrap-ServerIhre Apache Kafka-Serveradresse ein.

Wählen Sie im Abschnitt Verbindungsanmeldeinformationen eine vorhandene Verbindung mit dem Apache Kafka-Cluster aus der Dropdownliste für Verbindung aus. Führen Sie andernfalls die folgenden Schritte aus:

- Geben Sie für Verbindungsname einen Namen für die Verbindung ein.

- Vergewissern Sie sich bei der Authentifizierungsart, dass der API-Schlüssel ausgewählt ist.

- Geben Sie für Schlüssel und geheimen Schlüsselden API-Schlüssel und den Schlüsselschlüsselschlüssel ein.

Wählen Sie Verbinden.

Führen Sie nun auf der Seite Verbinden die folgenden Schritte aus.

Geben Sie für Thema das Thema Kafka ein.

Geben Sie für Verbrauchergruppe die Verbrauchergruppe Ihres Apache Kafka-Clusters ein. Dieses Feld bietet Ihnen eine dedizierte Verbrauchergruppe zum Abrufen von Ereignissen.

Wählen Sie den automatischen Offset zurücksetzen aus, um anzugeben, wo leseversatz gestartet werden soll, wenn kein Commit vorhanden ist.

Für das Sicherheitsprotokollist der Standardwert SASL_PLAINTEXT.

Hinweis

Die Apache Kafka-Quelle unterstützt derzeit nur die unverschlüsselte Datenübertragung (SASL_PLAINTEXT und PLAINTEXT) zwischen Ihrem Apache Kafka-Cluster und Eventstream. Die Unterstützung für die verschlüsselte Datenübertragung über SSL wird in Kürze verfügbar sein.

Der STANDARDMÄßIGe SASL-Mechanismus ist in der Regel PLAIN, sofern nicht anders konfiguriert. Sie können den SCRAM-SHA-256 - oder SCRAM-SHA-512-Mechanismus auswählen, der Ihren Sicherheitsanforderungen entspricht.

Wählen Sie Weiter aus. Überprüfen Sie auf der Anzeige Überprüfen und Erstellen die Zusammenfassung, und wählen Sie dann Hinzufügen aus.

Anzeigen des aktualisierten Eventstreams

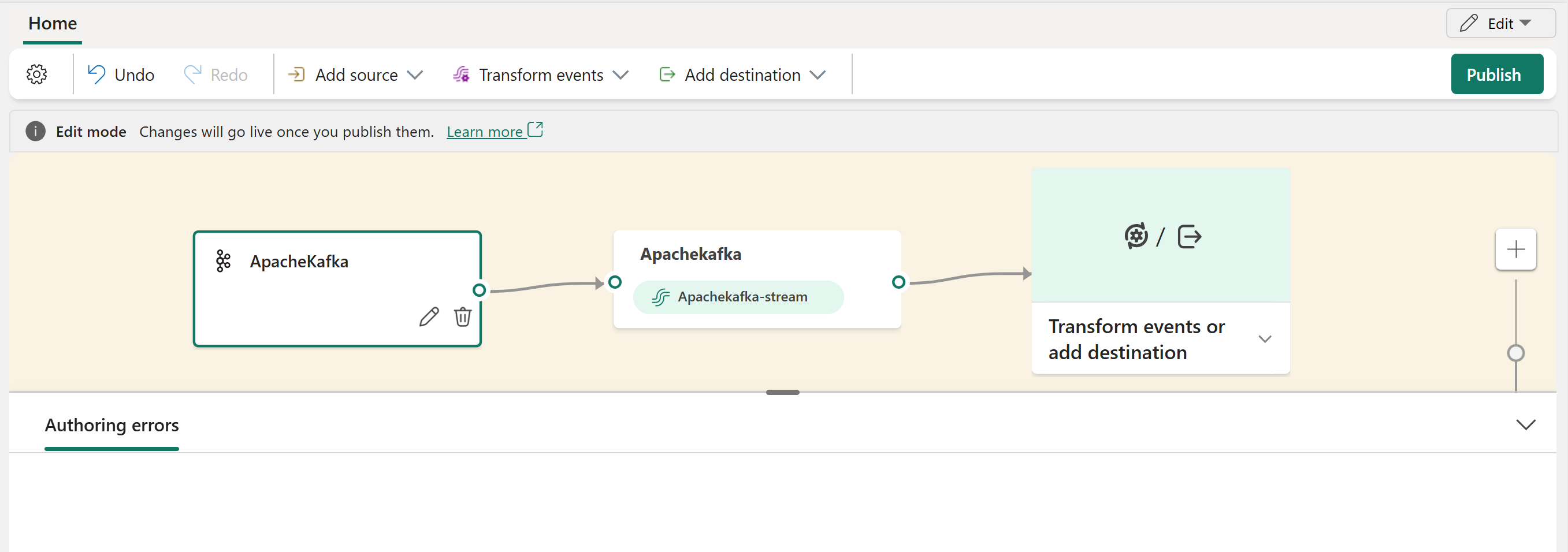

Sie können die Apache Kafka-Quelle sehen, die Ihrem Eventstream im Bearbeitungsmodushinzugefügt wurde.

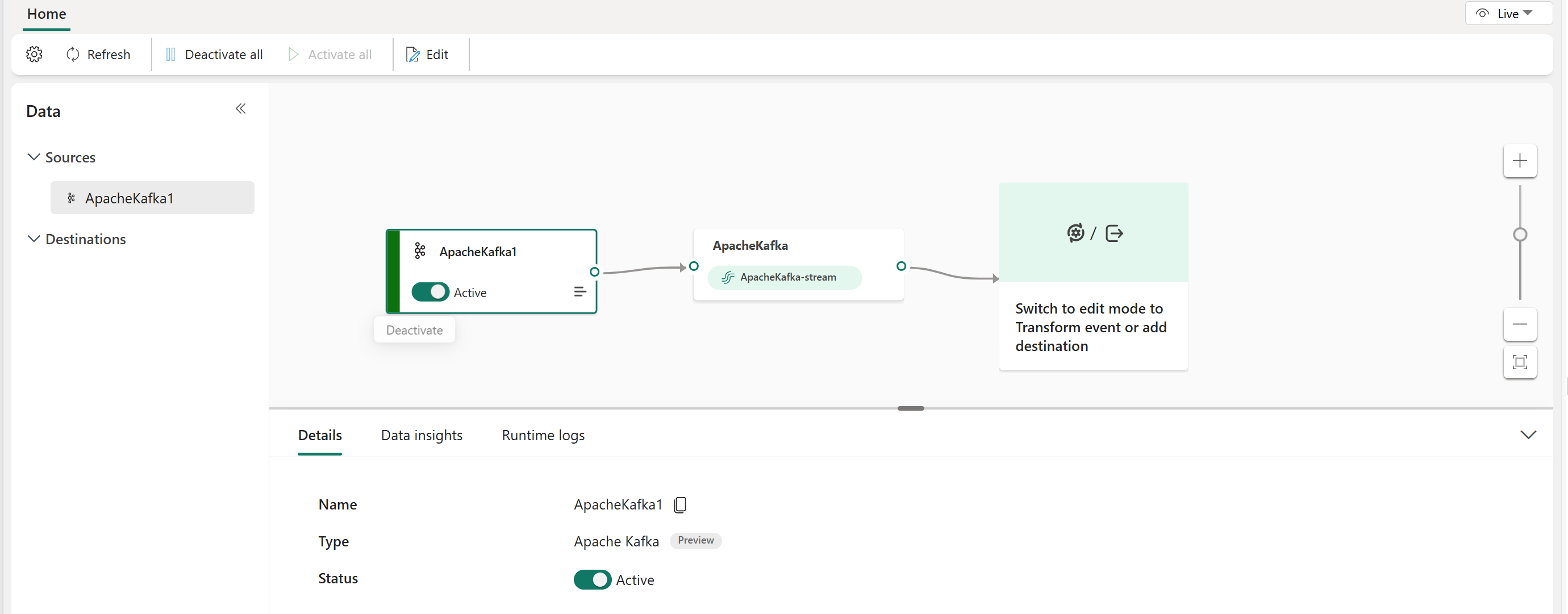

Nachdem Sie diese Schritte ausgeführt haben, ist die Apache Kafka-Quelle für die Visualisierung in der Liveansichtverfügbar.

Zugehöriger Inhalt

Andere Connectors: