Bereitstellen und Verwalten von lokalen Azure-Instanzen in VMM

Dieser Artikel enthält Informationen zum Einrichten einer lokalen Azure-Instanz in System Center Virtual Machine Manager (VMM). Sie können eine lokale Azure-Instanz implementieren, indem sie von Bare-Metal-Servern bereitgestellt wird oder indem Sie vorhandene Hosts hinzufügen. Erfahren Sie mehr über das neue Azure Local.

VMM 2022- unterstützt Azure Local, Version 22H2 (unterstützt von VMM 2022 UR1).

VMM 2019 UR3 (Update Rollup 3) unterstützt Azure Stack HCI Version 20H2. Das aktuelle Produkt ist Azure Local, Version 23H2.

Wichtig

Azure Local instances that are managed by Virtual Machine Manager must not join the preview channel yet. System Center (einschließlich Virtual Machine Manager, Operations Manager und andere Komponenten) unterstützt derzeit keine lokalen Azure-Vorschauversionen. Die neuesten Updates finden Sie im System Center-Blog.

Vor der Installation

Stellen Sie sicher, dass Sie VMM 2019 UR3 oder höher verwenden.

Was wird unterstützt?

Hinzufügung, Erstellung und Verwaltung von lokalen Azure-Instanzen. Siehe detaillierte Schritte, um Azure Local-Instanzen zu erstellen und zu verwalten.

Möglichkeit zum Bereitstellen und Implementieren von VMs auf den Azure Local-Instanzen und zum Ausführen von VM-Lebenszyklusvorgängen. VMs können mithilfe von VHD(x)-Dateien, Vorlagen oder von einer vorhandenen VM bereitgestellt werden. Weitere Informationen

Einrichten des VLAN-basierten Netzwerks auf lokalen Azure-Instanzen.

Bereitstellung und Verwaltung von SDN-Netzwerkcontrollern auf lokalen Azure-Instanzen.

Verwalten von Speicherpool-Einstellungen, Erstellen von virtuellen Datenträgern, Erstellen von freigegebenen Cluster-Volumes (CSVs) und Anwenden von QoS-Einstellungen.

Das Verschieben von VMs zwischen Windows Server und lokalen Azure-Instanzen erfolgt durch Netzwerkmigration und das Migrieren einer offline (heruntergefahrenen) VM. In diesem Szenario exportiert und importiert der VMM hinter den Kulissen, auch wenn es sich um einen einzigen Vorgang handelt.

Die PowerShell-Cmdlets, die zum Verwalten von Windows Server-Clustern verwendet werden, können auch zum Verwalten von lokalen Azure-Instanzen verwendet werden.

Stellen Sie sicher, dass Sie VMM 2022 UR1 oder höher ausführen.

Was wird unterstützt?

Hinzufügung, Erstellung und Verwaltung von lokalen Azure-Instanzen. Detaillierte Schritte zum Erstellen und Verwalten von lokalen Azure-Instanzen anzeigen.

Möglichkeit zur Bereitstellung und zum Einsatz von VMs auf den lokalen Azure-Instanzen und zur Durchführung von VM-Lebenszyklusvorgängen. VMs können mithilfe von VHD(x)-Dateien, Vorlagen oder von einer vorhandenen VM bereitgestellt werden. Weitere Informationen

Einrichten des VLAN-basierten Netzwerks auf lokalen Azure-Instanzen.

Bereitstellung und Verwaltung von SDN-Netzwerkcontrollern auf lokalen Azure-Instanzen.

Verwalten von Speicherpool-Einstellungen, Erstellen von virtuellen Datenträgern, Erstellen von freigegebenen Cluster-Volumes (CSVs) und Anwenden von QoS-Einstellungen.

Das Verschieben von VMs zwischen Windows Server und lokalen Azure-Instanzen funktioniert über die Netzwerkmigration und das Migrieren einer offline geschalteten (heruntergefahrenen) VM. In diesem Szenario exportiert und importiert der VMM hinter den Kulissen, auch wenn es sich um einen einzigen Vorgang handelt.

Die PowerShell-Cmdlets, die zum Verwalten von Windows Server-Clustern verwendet werden, können auch zum Verwalten von lokalen Azure-Instanzen verwendet werden.

Registrieren und Aufheben der Registrierung lokaler Azure-Instanzen

Mit VMM 2022 führen wir VMM PowerShell-Cmdlets zum Registrieren und Aufheben der Registrierung lokaler Azure-Instanzen ein.

Verwenden Sie die folgenden Cmdlets, um eine lokale Azure-Instanz zu registrieren:

Register-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Mit dem folgenden Befehl können Sie die Registrierung eines Clusters aufheben:

Unregister-SCAzStackHCI -VMHostCluster <HostCluster> -SubscriptionID <string>

Detaillierte Informationen zu den unterstützten Parametern finden Sie unter Register-SCAzStackHCI und Unregister-SCAzStackHCI.

Was wird nicht unterstützt?

Die Verwaltung von Azure Local gestreckten Clustern wird in VMM derzeit nicht unterstützt.

Azure-Localmaschinen sind als Virtualisierungshosts vorgesehen, auf denen Sie alle Ihre Workloads in virtuellen Maschinen betreiben. Mit den lokalen Azure-Nutzungsbedingungen können Sie nur das betreiben, was für das Hosten virtueller Maschinen erforderlich ist. Lokale Azure-Instanzen sollten nicht für andere Zwecke wie WSUS-Server, WDS-Server oder Bibliotheksserver verwendet werden. Weitere Informationen finden Sie unter Anwendungsfälle für Azure Local, Wann Azure Localverwendet werden soll, und Rollen, die Sie ausführen können, ohnezu virtualisieren.

Die Livemigration zwischen einer beliebigen Version von Windows Server und azure Local instances wird nicht unterstützt.

Hinweis

Die Livemigration zwischen lokalen Azure-Instanzen funktioniert ebenso wie zwischen Windows Server-Clustern.

- Der einzige für Azure Local verfügbare Speichertyp ist "Storage Spaces Direct (S2D)". Das Erstellen oder Verwalten von Nicht-S2D-Clustern mit lokalen Azure-Computern wird nicht unterstützt. Wenn Sie einen anderen Speichertyp, z. B. SANs, verwenden müssen, verwenden Sie Windows Server als Virtualisierungshost.

Hinweis

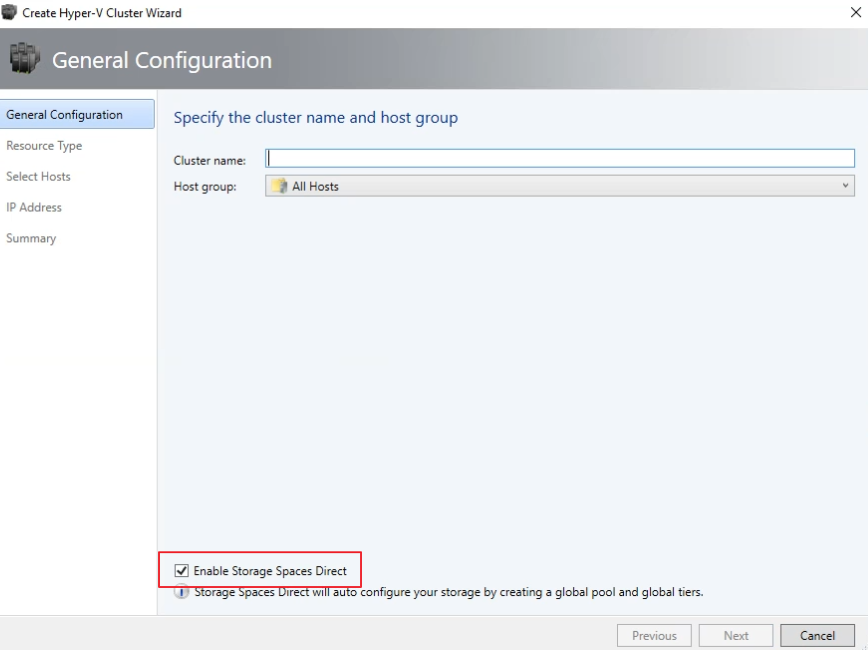

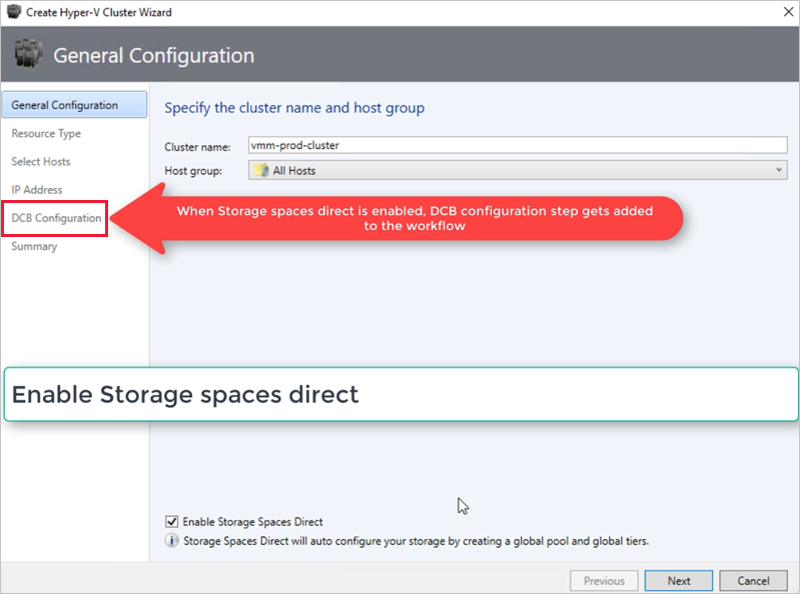

Sie müssen S2D beim Erstellen einer lokalen Azure-Instanz aktivieren. Um S2D zu aktivieren, gehen Sie im Assistenten zum Erstellen von Clustern zu Allgemeine Konfiguration. Wählen Sie unter Bestimmen von Clusternamen und Hostgruppe die Option Direkte Speicherplätze aktivieren, wie unten dargestellt:

Nachdem Sie einen Cluster mit S2D aktiviert haben, geht der VMM wie folgt vor:

- Die Funktion „Failover Clustering“ ist aktiviert.

- Speicherreplikat und Datendeduplizierung werden aktiviert.

- Der Cluster wird optional validiert und erstellt.

- S2D ist aktiviert, und es wird in VMM ein Speicherarrayobjekt mit dem Namen erstellt, den Sie im Assistenten angegeben haben.

Wenn Sie VMM zum Erstellen eines hyperkonvergenten Clusters verwenden, werden der Pool und die Speicherebenen automatisch durch Ausführen von Enable-ClusterStorageSpacesDirect -Autoconfig $True erstellt.

Nachdem diese Voraussetzungen erfüllt sind, stellen Sie einen Cluster bereit und richten Speicherressourcen darauf ein. Sie können dann VMs auf dem Cluster bereitstellen.

Führen Sie folgende Schritte aus:

Schritt 1: Bereitstellen des Clusters

Sie können einen Cluster mit Hyper-V-Hosts und Bare-Metal-Geräten bereitstellen:

Bereitstellen eines Clusters aus Hyper-V-Hosts

Wenn Sie die lokalen Azure-Server zum VMM-Fabric hinzufügen müssen, führen Sie die Schritteaus. Wenn sie sich bereits im VMM-Fabric befinden, fahren Sie mit dem nächsten Schritt fort.

Hinweis

- Wenn Sie den Cluster einrichten, wählen Sie die Option Direkte Speicherplätze aktivieren auf der Seite Allgemeine Konfiguration des Assistenten Hyper-V Cluster erstellen.

- Wählen Sie unter Ressourcentyp die Option Vorhandene Server mit einem Windows Server-Betriebssystem und wählen Sie die Hyper-V-Hosts aus, die dem Cluster hinzugefügt werden sollen.

- Alle ausgewählten Hosts müssen Azure Local installiert haben.

- Da S2D aktiviert ist, muss der Cluster validiert werden.

Bereitstellen eines Clusters aus Bare-Metal-Geräten

Hinweis

Normalerweise erfordert der S2D-Knoten RDMA‑, QoS‑ und SET-Einstellungen. Um diese Einstellungen für einen Knoten mit Bare-Metal-Computern zu konfigurieren, können Sie die Post-Deployment-Skriptfunktion in PCP verwenden. Hier ist das Beispiel für ein PCP-Skript nach der Bereitstellung. Sie können dieses Skript auch verwenden, um RDMA, QoS und SET zu konfigurieren, während Sie einen neuen Knoten zu einer bestehenden S2D-Bereitstellung von Bare-Metal-Computern hinzufügen.

- Lesen Sie die Voraussetzungen für die Bereitstellung von Bare-Metal-Clustern.

Hinweis

- Die generalisierte VHD oder VHDX in der VMM-Bibliothek sollte Azure Stack HCI mit den neuesten Updates ausführen. Die Werte der Betriebssystem - und Virtualisierungsplattform für die Festplatte sollten festgelegt werden.

- Für die Bare-Metal-Bereitstellung müssen Sie dem VMM-Fabric einen PXE-Server (Pre-Boot Execution Environment) hinzufügen. Der PXE-Server wird über Windows-Bereitstellungsdienste bereitgestellt. VMM verwendet sein eigenes WinPE-Image, und Sie müssen sicherstellen, dass es auf dem neuesten Stand ist. Wählen Sie dazu Fabric>Infrastruktur>Update WinPE image und stellen Sie sicher, dass der Auftrag beendet wird.

- Befolgen Sie die Anweisungen zum Bereitstellen eines Clusters von Bare-Metal-Computern.

Schritt 2: Einrichten des Netzwerks für den Cluster

Nachdem der Cluster im VMM-Fabric bereitgestellt und verwaltet wurde, müssen Sie ein Netzwerk für Clusterknoten einrichten.

- Beginnen Sie mit Erstellen eines logischen Netzwerkes, um Ihr physisches Verwaltungsnetzwerk zu spiegeln.

- Sie müssen einen logischen Switch mit aktiviertem Switch Embedded Teaming (SET) einrichten, damit der Switch die Virtualisierung wahrnimmt. Dieser Switch ist mit dem logischen Verwaltungsnetzwerk verbunden und verfügt über alle virtuellen Hostadapter, die erforderlich sind, um den Zugang zum Verwaltungsnetzwerk bereitzustellen oder das Speichernetzwerk zu konfigurieren. S2D stützt sich auf ein Netzwerk zur Kommunikation zwischen Hosts. RDMA-fähige Adapter werden empfohlen.

- Erstellen von VM-Netzwerken.

Schritt 3: Konfigurieren von DCB-Einstellungen in der lokalen Azure-Instanz

Hinweis

Die Konfiguration der DCB-Einstellungen ist ein optionaler Schritt, um eine hohe Leistung während des Workflows zur Erstellung von S2D-Clustern zu erreichen. Fahren Sie mit Schritt 4 fort, wenn Sie die DCB-Einstellungen nicht konfigurieren möchten.

Empfehlungen

Wenn Sie vNICs bereitgestellt haben, empfehlen wir Ihnen, für eine optimale Leistung alle Ihre vNICs den entsprechenden pNICs zuzuordnen. Affinitäten zwischen vNIC und pNIC werden vom Betriebssystem zufällig festgelegt, und es kann Szenarien geben, in denen mehrere vNICs demselben pNIC zugeordnet sind. Um solche Szenarien zu vermeiden, empfehlen wir Ihnen, die Affinität zwischen vNIC und pNIC manuell festzulegen, indem Sie die hier aufgeführten Schritte ausführen.

Wenn Sie ein Netzwerkadapterportprofil erstellen, empfehlen wir, IEEE-Priorität zu erlauben. Weitere Informationen

Sie können die IEEE-Priorität auch mit den folgenden PowerShell-Befehlen festlegen:

Set-VMNetworkAdapterVlan -VMNetworkAdapterName 'SMB2' -VlanId '101' -Access -ManagementOS Set-VMNetworkAdapter -ManagementOS -Name 'SMB2' -IeeePriorityTag on

Nutzen Sie die folgenden Schritte, um die DCB-Einstellungen zu konfigurieren:

Erstellen Sie einen neuen Hyper-V-Cluster, wählen Sie Aktivieren Sie Direkte Speicherplätze. Die Option DCB-Konfiguration wird dem Workflow zur Erstellung von Hyper-V-Clustern hinzugefügt.

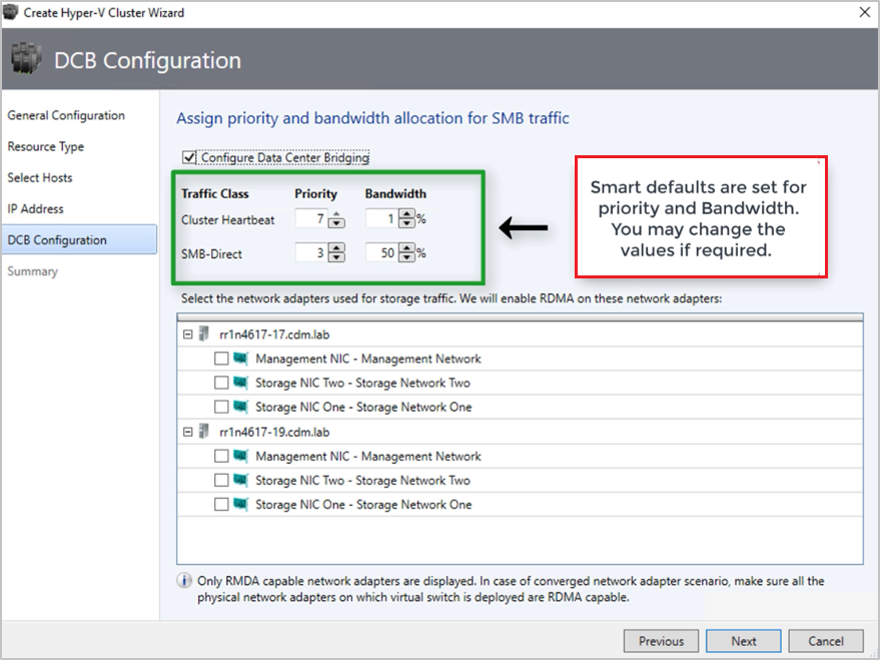

Wählen Sie in der DCB-Konfiguration Folgendes aus: Data Center Bridging konfigurieren aus.

Stellen Sie Prioritäts‑ und Bandbreiten-Werte für SMB-Direct- und Cluster-Taktdatenverkehr bereit.

Hinweis

Standardwerte werden für Priorität und Bandbreite zugewiesen. Passen Sie diese Werte an die Umgebungsanforderungen Ihrer Organisation an.

Standardwerte:

| Datenverkehrsklasse | Priorität | Bandbreite (%) |

|---|---|---|

| Clustertakt | 7 | 1 |

| SMB-Direct | 3 | 50 |

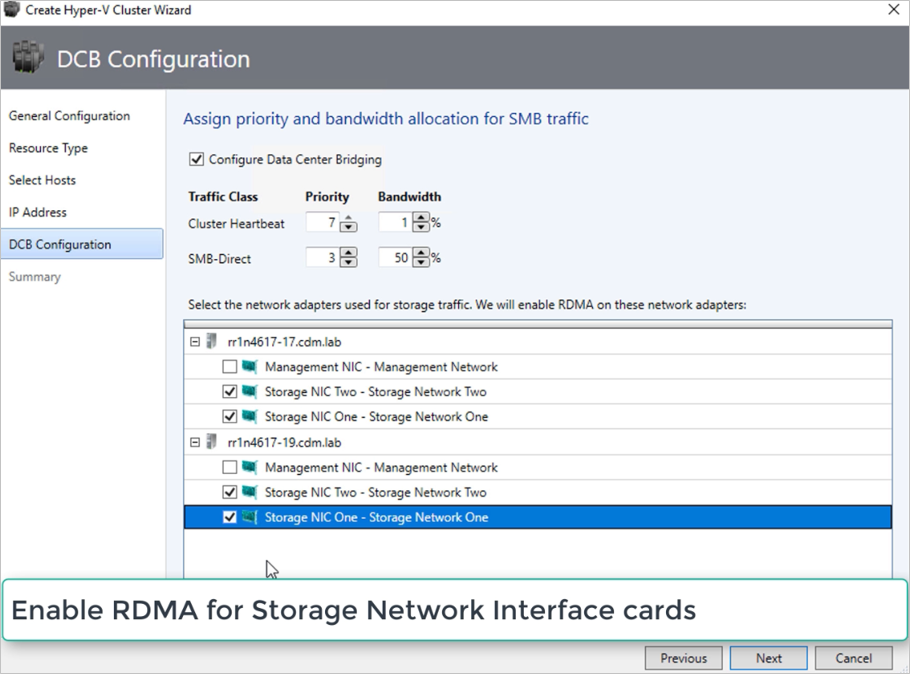

Wählen Sie die Netzwerkadapter aus, die für den Speicherdatenverkehr verwendet werden. RDMA ist auf diesen Netzwerkadaptern aktiviert.

Hinweis

Wählen Sie in einem konvergenten NIC-Szenario die Speicher-vNICs aus. Die zugrunde liegenden pNICs müssen RDMA-fähig sein, damit vNICs angezeigt und zur Auswahl verfügbar sind.

Überprüfen Sie die Zusammenfassung, und wählen Sie Fertig stellen aus.

Es wird eine lokale Azure-Instanz erstellt, und die DCB-Parameter werden auf allen S2D-Knoten konfiguriert.

Hinweis

- DCB-Einstellungen können auf den vorhandenen Hyper-V S2D-Clustern konfiguriert werden, indem Sie die Seite Cluster-Eigenschaften besuchen und zur Seite DCB-Konfiguration navigieren.

- Jede Out-of-Band-Änderung der DCB-Einstellungen auf einem der Knoten führt dazu, dass der S2D-Cluster im VMM nicht konform ist. Auf der Seite DCB-Konfiguration der Eigenschaften des Clusters wird eine Option Remediate bereitgestellt, mit der Sie die im VMM konfigurierten DCB-Einstellungen auf den Cluster-Knoten erzwingen können.

Schritt 4: Registrieren einer lokalen Azure-Instanz mit Azure

Nach dem Erstellen einer lokalen Azure-Instanz muss sie innerhalb von 30 Tagen nach der Installation gemäß den Nutzungsbedingungen des Azure Online-Diensts bei Azure registriert werden. Wenn Sie System Center 2022 verwenden, verwenden Sie Register-SCAzStackHCI Cmdlet in VMM, um die lokale Azure-Instanz bei Azure zu registrieren. Führen Sie alternativ diesen Schritten aus, um die lokale Azure-Instanz bei Azure zu registrieren.

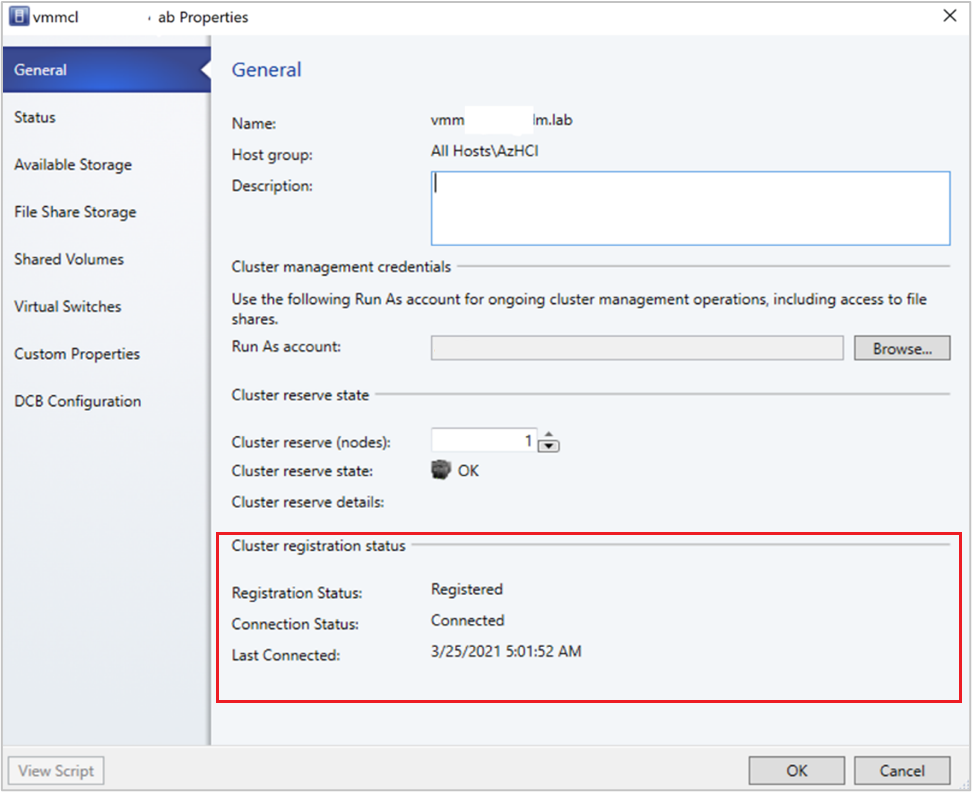

Der Registrierungsstatus wird nach einer erfolgreichen Aktualisierung des Clusters im VMM angezeigt.

Schritt 5: Anzeigen des Registrierungsstatus von Azure Stack HCI-Instanzen

In der VMM-Konsole können Sie den Registrierungsstatus und das Datum der letzten Verbindung von Azure Stack HCI-Clustern anzeigen.

Wählen Sie Fabric, klicken Sie mit der rechten Maustaste auf den Azure Stack HCI-Cluster, und wählen Sie Eigenschaften.

Alternativ dazu können Sie

Get-SCVMHostausführen und die Eigenschaften des zurückgegebenen Objekts beachten, um den Registrierungsstatus zu überprüfen.

Schritt 6: Verwalten des Pools und Erstellen von CSVs

Sie können nun die Einstellungen des Speicherpools ändern und virtuelle Datenträger und CSVs erstellen.

Klicken Sie auf Fabric>Speicher>Arrays.

Klicken Sie mit der rechten Maustaste auf den Cluster >Pool verwalten, und wählen Sie den standardmäßig erstellten Speicherpool aus. Sie können den Standardnamen ändern und eine Klassifizierung hinzufügen.

Klicken Sie zum Erstellen eines CSV mit der rechten Maustaste auf den Cluster und dann auf >Eigenschaften>Freigegebene Volumes.

Geben Sie im Assistenten zum Erstellen von Volumes>Speichertyp den Volume-Namen an und wählen Sie den Speicherpool aus.

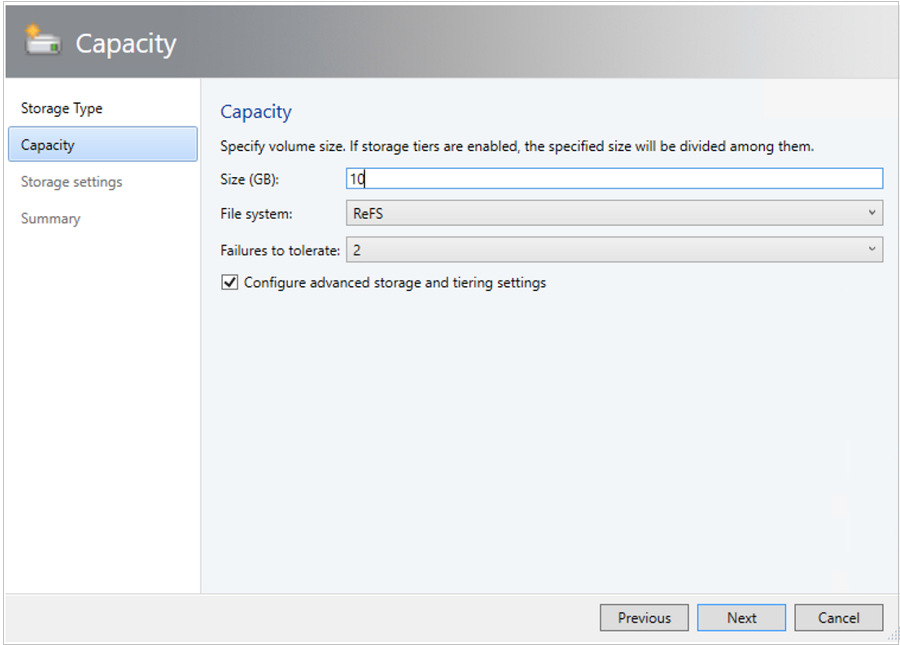

Unter Kapazität können Sie die Einstellungen für Volume-Größe, Dateisystem und Resilienz (Tolerierte Anzahl von Fehlern) festlegen. Wählen Sie Erweiterte Speicher- und Ebenenoptionen konfigurieren aus, um diese Optionen einzurichten.

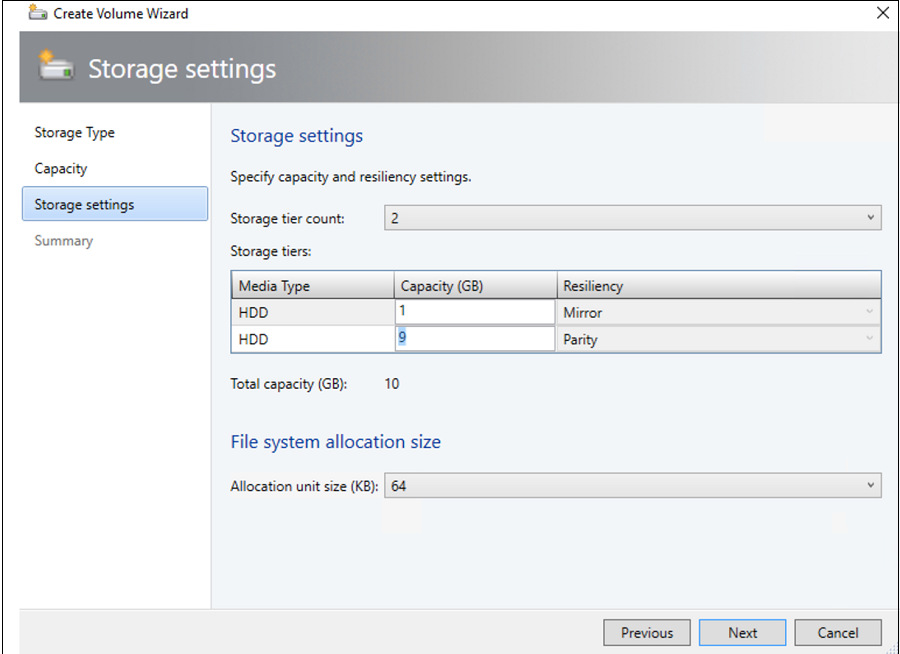

In den Speichereinstellungen können Sie die Speicherebene teilen, Kapazität und Resilienz angeben.

Überprüfen Sie unter Zusammenfassung die Einstellungen und beenden Sie den Assistenten. Beim Erstellen des Volumes wird automatisch ein virtueller Datenträger erstellt.

Schritt 7: Bereitstellung von VMs auf dem Cluster

In einer hyperkonvergenten Topologie können VMs direkt auf dem Cluster bereitgestellt werden. Ihre virtuellen Festplatten werden auf den Volumes platziert, die Sie mit S2D erstellt haben. Sie erstellen und stellen diese VMs bereit genauso wie jede andere VM.

Wichtig

Wenn die lokale Azure-Instanz nicht bei Azure registriert ist oder seit mehr als 30 Tagen nach der Registrierung nicht mit Azure verbunden ist, wird die Erstellung virtueller Hochverfügbarkeitscomputer (HAVM) auf dem Cluster blockiert. Siehe Schritt 4 und 5 für die Cluster-Registrierung.

Schritt 8: Migrieren von VMs von Windows Server zur lokalen Azure-Instanz

Verwenden Sie die Netzwerkmigrationsfunktion in VMM, um Workloads von Hyper-V (Windows Server 2019 und höher) zu Azure Stack HCI zu migrieren.

Hinweis

Die Livemigration zwischen Windows Server und Azure Local wird nicht unterstützt. Die Netzwerkmigration von Azure Local zu Windows Server wird nicht unterstützt.

- Deaktivieren Sie vorübergehend die Livemigration auf dem Ziel-Host von Azure Local.

- Wählen Sie VMs und Dienste>für alle Hosts aus, und wählen Sie dann den Hyper-V-Quellhost aus, von dem Sie migrieren möchten.

- Wählen Sie die VM aus, die Sie migrieren möchten. Die VM muss sich in einem ausgeschalteten Zustand befinden.

- Wählen Sie "Virtueller Computer migrieren" aus.

- Überprüfen Und wählen Sie in Hostden lokalen Azure-Zielhost aus.

- Wählen Sie "Weiter" aus, um die Netzwerkmigration zu initiieren. VMM führt Importe und Exporte am Back-End durch.

- Um zu überprüfen, ob die virtuelle Maschine erfolgreich migriert wurde, überprüfen Sie die Liste der VMs auf dem Zielhost. Schalten Sie die VM ein und aktivieren Sie die Livemigration auf dem lokalen Host in Azure erneut.

Schritt 9: Migrieren von VMware-Workloads zur lokalen Azure-Instanz mithilfe von SCVMM

VMM bietet eine einfache, assistentengestützte Erfahrung für die V2V-Konvertierung (Virtual to Virtual). Mit dem Konvertierungstool können Sie Workloads in großem Umfang von einer VMware-Infrastruktur auf eine Hyper-V-Infrastruktur migrieren. Eine Liste der unterstützten VMware-Server finden Sie unter Systemanforderungen.

Voraussetzungen und Einschränkungen für die Konvertierung finden Sie unter Konvertieren einer VMware-VM nach Hyper-V in der VMM-Fabric.

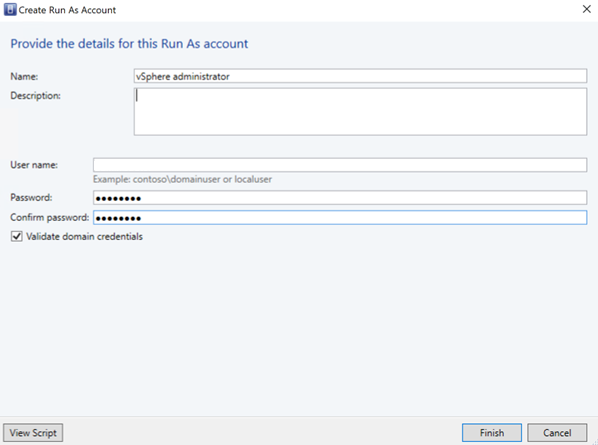

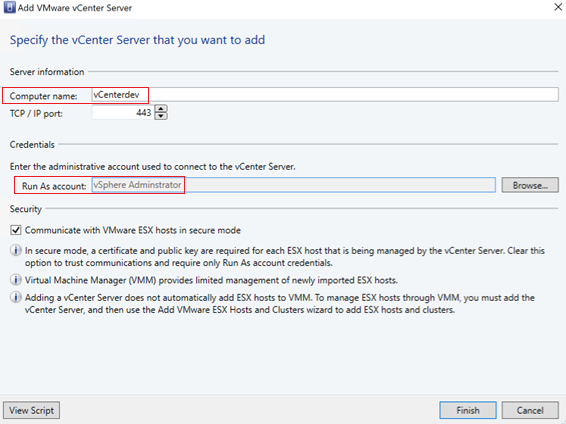

Erstellen Sie ein Runs as-Konto für die Rolle vCenter Server Administrierende im VMM. Diese Administratoranmeldeinformationen werden für die Verwaltung von vCenter-Server und ESXi-Hosts verwendet.

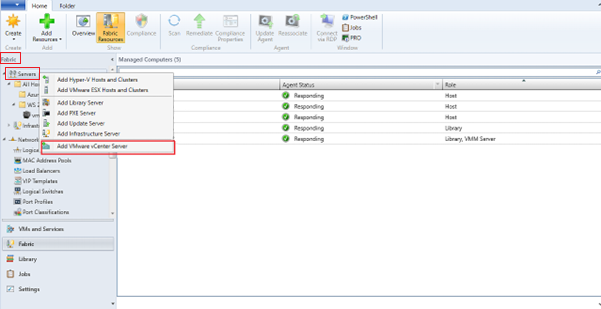

Wählen Sie in der VMM-Konsole unter Fabric die Option Server>VMware vCenter Server hinzufügen.

Gehen Sie auf der Seite VMware vCenter Server hinzufügen wie folgt vor:

Computername: Geben Sie den Namen des vCenter-Servers an.

Ausführendes Konto: Das für den vSphere-Administrierenden erstellte ausführende Konto auswählen.

Wählen Sie Fertig stellen aus.

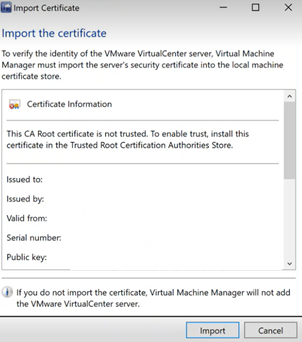

Wählen Sie auf der Seite Zertifikat importieren die Option Importieren.

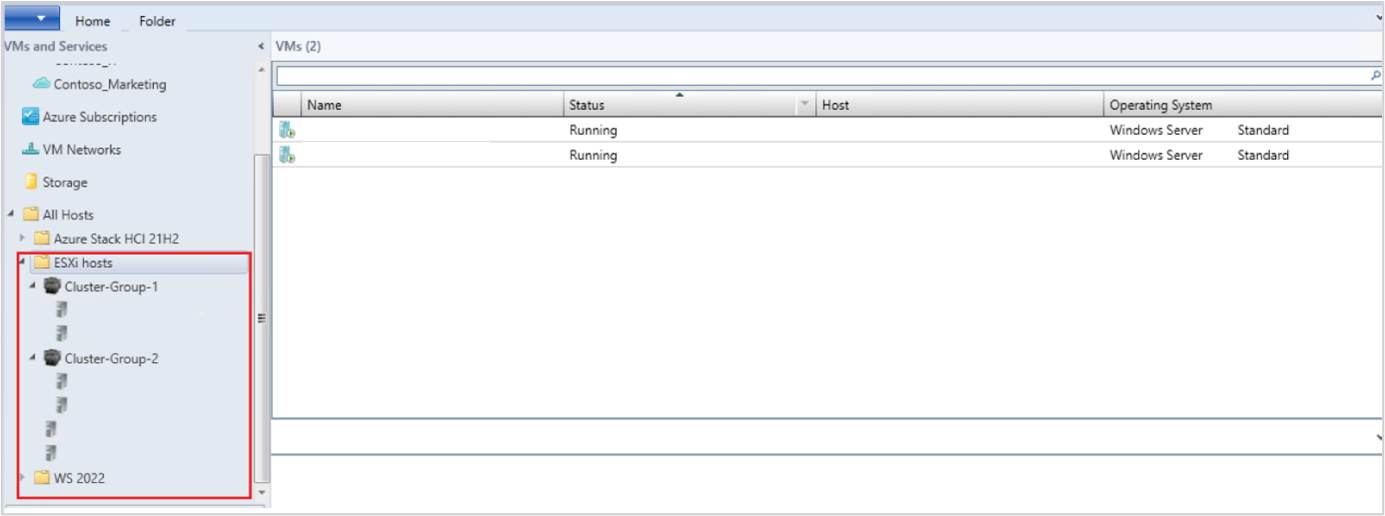

Nach dem erfolgreichen Hinzufügen des vCenter-Servers werden alle ESXi-Hosts unter dem vCenter zum VMM migriert.

Hosts hinzufügen

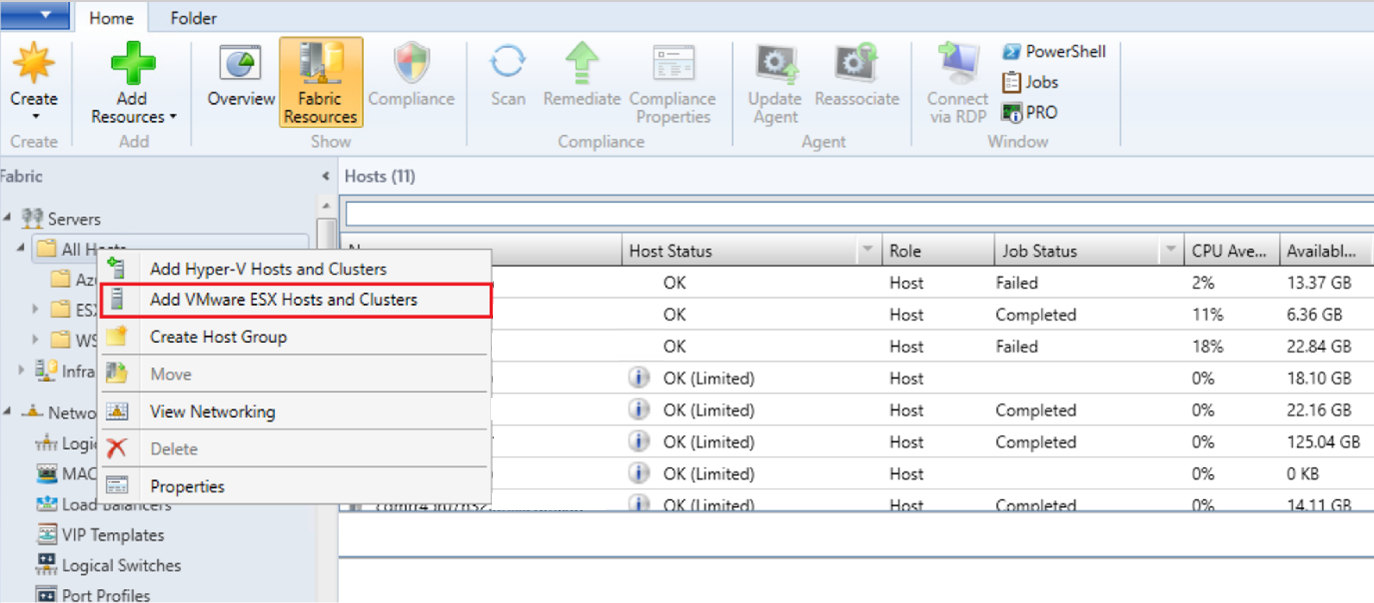

- Wählen Sie in der VMM-Konsole unter Fabric die Option Server>VMware ESX Hosts und Cluster hinzufügen.

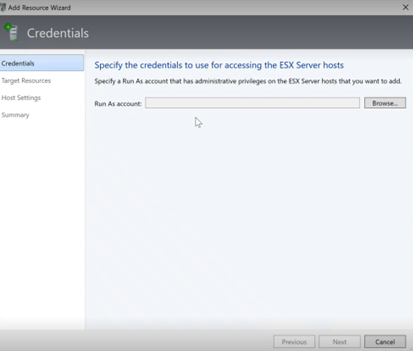

- Im Assistenten zum Hinzufügen von Ressourcen,

Wählen Sie unter Anmeldeinformationen das „Ausführen als“-Konto, das für den Port verwendet wird, und wählen Sie Weiter.

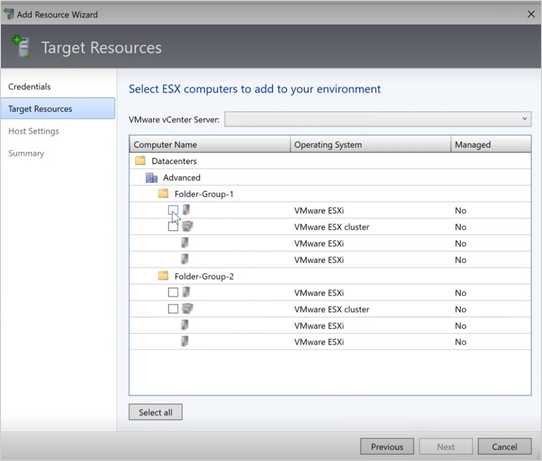

Wählen Sie unter Zielressourcen alle ESX-Cluster aus, die dem VMM hinzugefügt werden müssen, und wählen Sie Weiter.

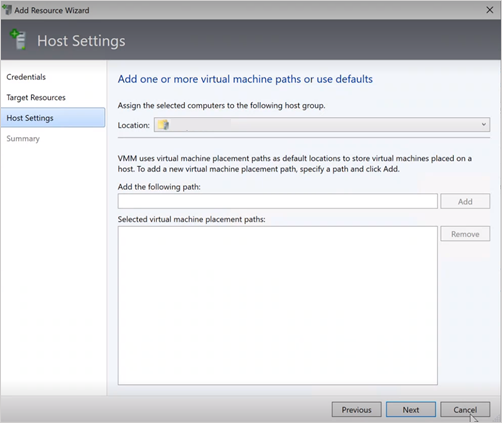

Wählen Sie unter Host-Einstellungen den Standort, an dem Sie die VMs hinzufügen möchten, und wählen Sie Weiter.

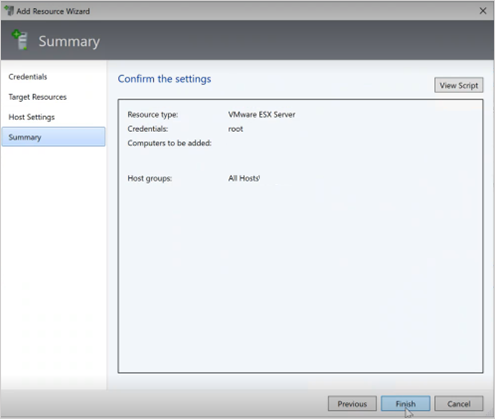

Überprüfen Sie unter Zusammenfassung die Einstellungen und wählen Sie Beenden. Zusammen mit den Hosts werden auch die zugehörigen VMs hinzugefügt.

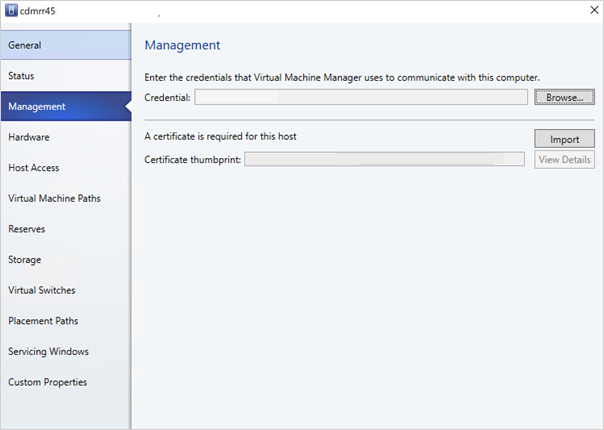

Überprüfen Sie den Status des ESXi-Hosts

Wenn der ESXi-Hoststatus als OK (Limitiert) angezeigt wird, klicken Sie mit der rechten Maustaste auf Eigenschaften>Verwaltung, wählen Sie „Ausführen als“-Konto, das für den Port verwendet wird, und importieren Sie die Zertifikate für den Host.

Wiederholen Sie den gleichen Vorgang für alle ESXi-Hosts.

Nachdem Sie die ESXi-Cluster hinzugefügt haben, werden alle virtuellen Computer, die auf den ESXi-Clustern ausgeführt werden, automatisch in VMM ermittelt.

VMs anzeigen

Gehen Sie zu VMs und Dienste, um die virtuellen Computer anzuzeigen. Sie können die primären Lebenszyklusvorgänge dieser virtuellen Computer auch vom VMM aus verwalten.

Klicken Sie mit der rechten Maustaste auf die zu migrierende VM und wählen Sie Ausschalten (Online-Migrationen werden nicht unterstützt) und deinstallieren Sie die VMware-Tools vom Gastbetriebssystem.

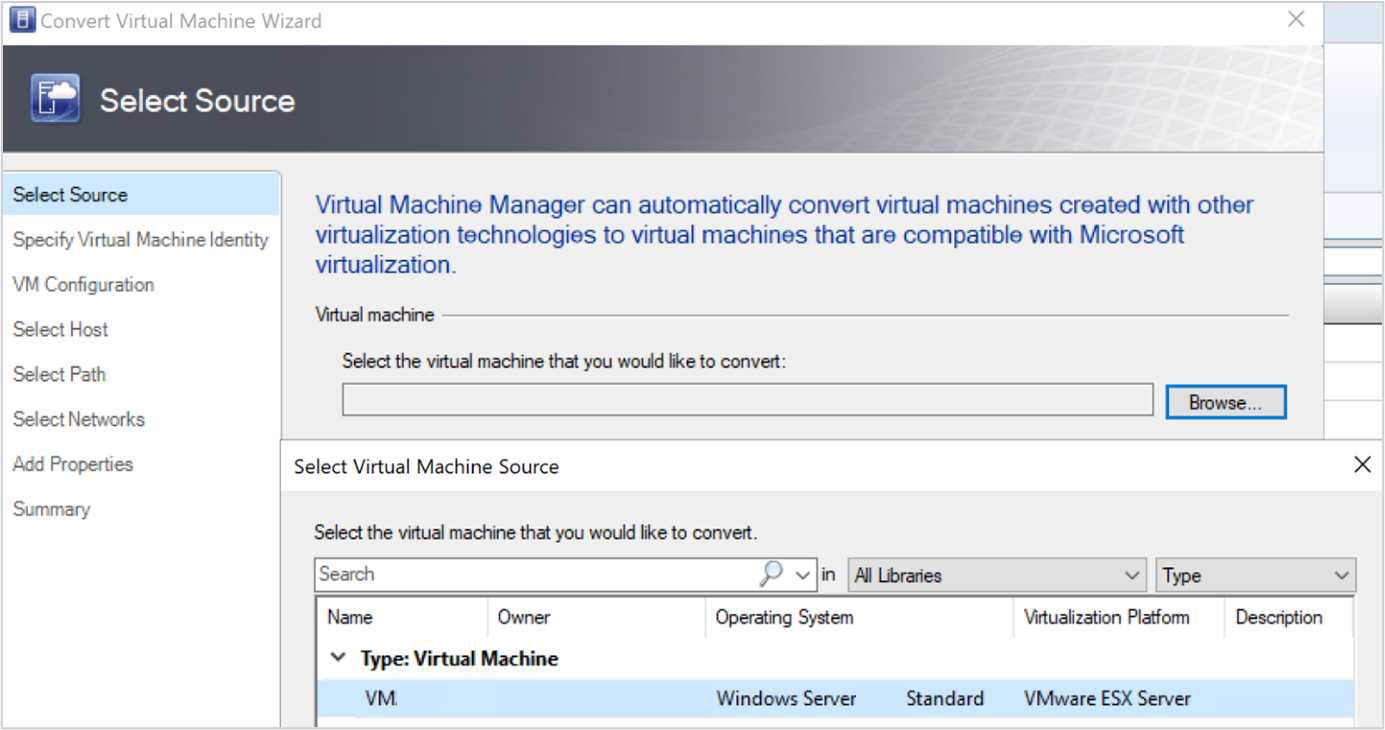

Wählen Sie Home>Erstellen virtueller Computer>Konvertieren virtueller Computer.

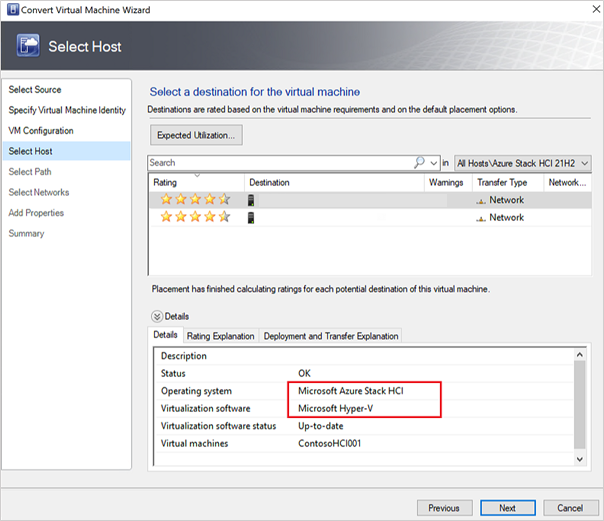

Im Assistenten zum Konvertieren virtueller Computer,

- Wählen Sie unter Auswählen der Quelle die VM, die auf dem ESXi-Server läuft, und wählen Sie Weiter.

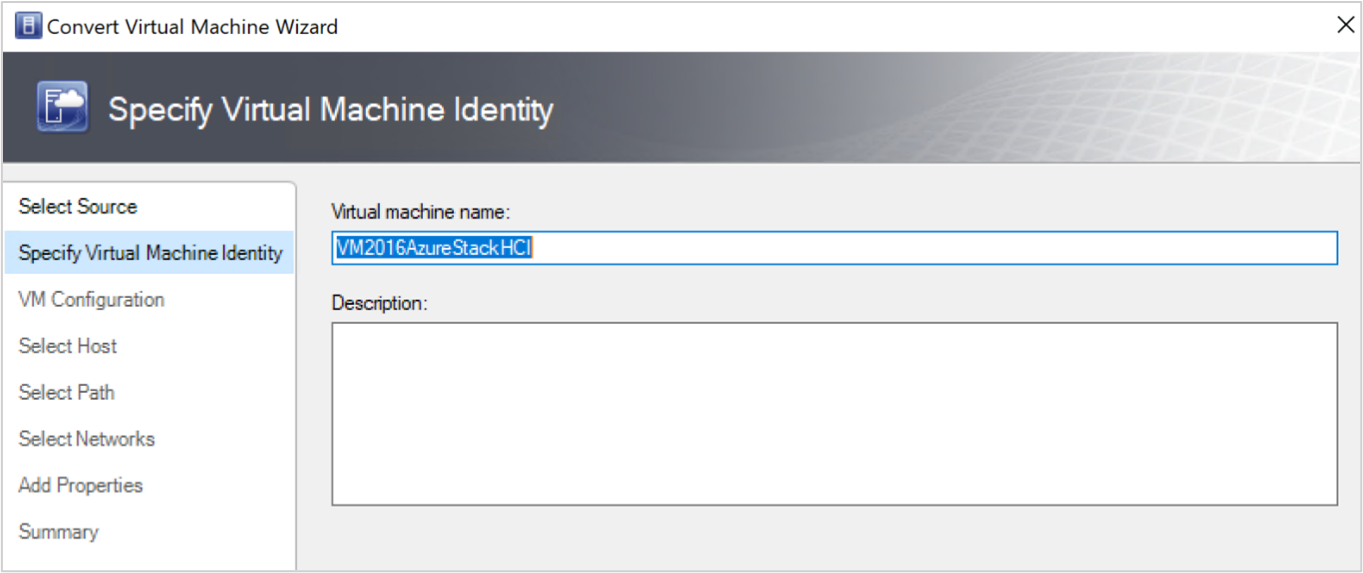

- Geben Sie unter Spezifizieren der Identität des virtuellen Computers den neuen Namen für das virtuelle Gerät ein, wenn Sie dies wünschen, und wählen Sie Weiter.

- Wählen Sie unter Auswählen der Quelle die VM, die auf dem ESXi-Server läuft, und wählen Sie Weiter.

Wählen Sie unter Host-den Zielcomputer "Azure Local" aus, und geben Sie den Speicherort auf dem Host für VM-Speicherdateien an, und wählen Sie Weiteraus.

Wählen Sie ein virtuelles Netzwerk für das virtuelle Gerät und wählen Sie Erstellen, um die Migration abzuschließen.

Der virtuelle Computer, der auf dem ESXi-Cluster ausgeführt wird, wird erfolgreich zur lokalen Azure-Instanz migriert. Zur Automatisierung verwenden Sie PowerShell-Befehle für die Konvertierung.