Grundlegendes zu LLMs

Ein großes Sprachmodell (LLM) ist eine Art von KI, die natürlichsprachliche Texte verarbeiten und produzieren kann. Es lernt aus einer riesigen Menge von Daten, die aus Quellen wie Büchern, Artikeln, Webseiten und Bildern gesammelt werden, um Muster und Regeln von Sprache zu erkennen.

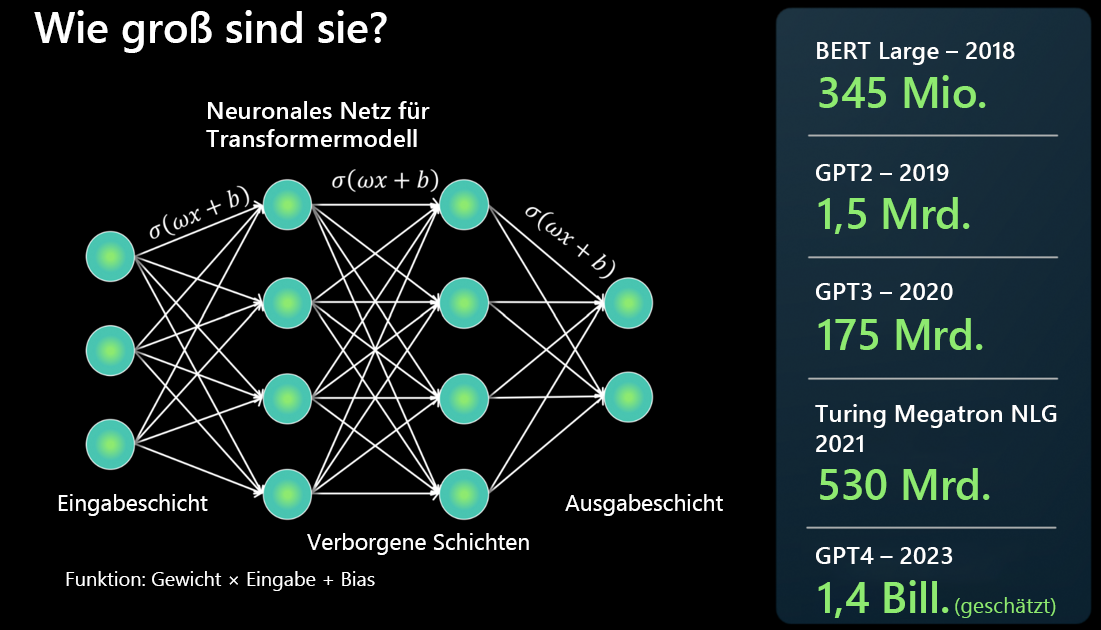

Wie groß sind LLMs?

Ein LLM wird mit Hilfe einer neuronalen Netzwerkarchitektur erstellt. Es verarbeitet eine Eingabe, hat mehrere verborgene Schichten, die verschiedene Aspekte der Sprache aufschlüsseln, und erzeugt in der Ausgabeschicht ein Ergebnis.

Es wird oft berichtet, dass das neueste Basismodell größer ist als das letzte, aber was bedeutet das? Kurz gesagt, je mehr Parameter ein Modell hat, desto mehr Daten kann es verarbeiten, daraus lernen und generieren.

Für jede Verbindung zwischen zwei Neuronen in der Architektur des neuronalen Netzwerks gibt es eine Funktion: Gewichtung * Eingabe + Trend (weight * input + bias). Dieses Netzwerk erzeugt numerische Werte, die bestimmen, wie das Modell Sprache verarbeitet.

LLMs sind in der Tat groß, und sie wachsen schnell. Einige Modelle konnten im Jahr 2018 Millionen von Parametern berechnen. Aber heute kann GPT-4 Billionen von Parametern berechnen.

Wie passen die Basismodelle in die LLMs?

Ein Basismodell ist eine bestimmte Instanz oder Version eines LLM. Zum Beispiel GPT-3, GPT-4 oder Codex.

Basismodelle werden auf einem großen Textkorpus trainiert und optimiert, oder auf Code, wenn es sich um eine Codex-Modellinstanz handelt.

Ein Basismodell nimmt Trainingsdaten in allen möglichen Formaten auf und verwendet eine Transformatorarchitektur, um ein allgemeines Modell zu erstellen. Anpassungen und Spezialisierungen können erstellt werden, um bestimmte Aufgaben über Aufforderungen oder Optimierungen zu erledigen.

Wie unterscheidet sich ein LLM von der eher traditionellen linguistischen Datenverarbeitung (NLP)?

Es gibt ein paar Dinge, die traditionelle NLPs von LLMs unterscheiden.

| Traditionelle NLP | Große Sprachmodelle |

|---|---|

| Es wird ein Modell pro Funktion benötigt. | Ein einziges Modell wird für viele natürlichsprachliche Anwendungsfälle verwendet. |

| Bietet eine Reihe von gelabelten Daten zum Trainieren des ML-Modells. | Verwendet viele Terabytes an nicht gelabelten Daten im Basismodell. |

| Beschreibt in natürlicher Sprache, was das Modell tun soll. | Ist für bestimmte Anwendungsfälle hochgradig optimiert. |

Was macht ein LLM nicht?

So wichtig es ist zu verstehen, was ein LLM kann, so wichtig ist es auch zu verstehen, was er nicht kann, damit Sie das richtige Tool für die zu erledigende Aufgabe wählen.

Sprache verstehen: Ein LLM ist eine Prognosemaschine, die auf der Grundlage von bereits vorhandenem Text Muster zusammenstellt, um mehr Text zu produzieren. Es versteht weder Sprache noch Mathematik.

Fakten verstehen: Ein LLM hat keine separaten Modi für die Informationsbeschaffung und das kreative Schreiben; es sagt einfach das nächste wahrscheinlichste Token voraus.

Umgangsformen, Emotionen oder Ethik verstehen: Ein LLM kann weder Anthropomorphismus zeigen noch Ethik verstehen. Die Ausgabe eines Basismodells ist eine Kombination aus Trainingsdaten und Prompts.