Ausführen von Experimenten mit MLflow

Mit MLflow-Experimenten können wissenschaftliche Fachkräfte für Daten Trainingsausführungen in einer als Experiment bezeichneten Sammlung nachverfolgen. Experimentausführungen sind nützlich für den Vergleich von Änderungen im Zeitverlauf oder für den Vergleich der relativen Leistung von Modellen mit unterschiedlichen Hyperparameterwerten.

Ausführen eines Experiments

Das Erstellen eines Experiments in Azure Databricks erfolgt automatisch, wenn Sie eine Ausführung starten. Es folgt ein Beispiel für das Starten einer Ausführung in MLflow sowie für das Protokollieren von zwei Parametern und einer Metrik:

with mlflow.start_run():

mlflow.log_param("input1", input1)

mlflow.log_param("input2", input2)

# Perform operations here like model training.

mlflow.log_metric("rmse", rmse)

In diesem Fall entspricht der Name des Experiments dem Namen des Notebooks. Sie können eine Variable mit dem Namen MLFLOW_EXPERIMENT_NAME exportieren, um den Namen Ihres Experiments bei Bedarf zu ändern.

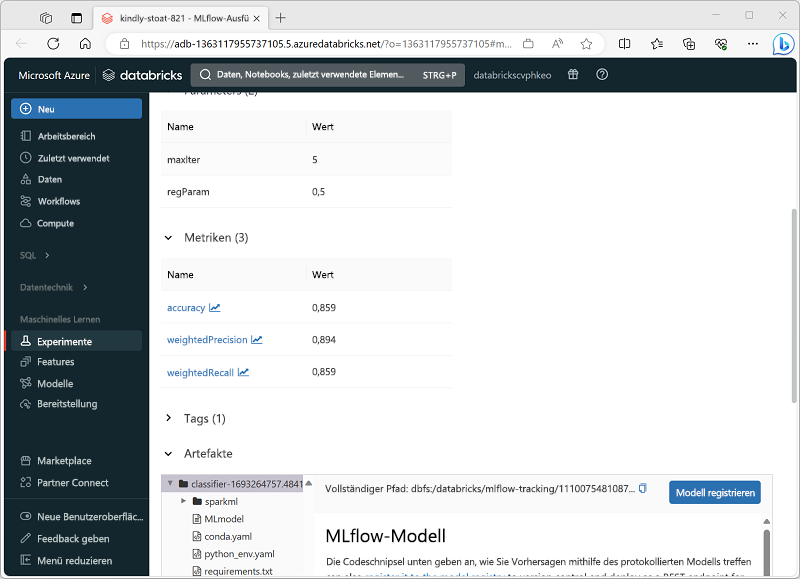

Überprüfen einer Experimentausführung

Im Azure Databricks-Portal können Sie auf der Seite Experimente Details zu jeder Experimentausführung anzeigen, darunter protokollierte Werte für Parameter, Metriken und andere Artefakte.