Erste Schritte mit Vision Studio in Azure

Um den Azure KI Vision-Dienst zu verwenden, müssen Sie zunächst eine Ressource für diesen in Ihrem Azure-Abonnement erstellen. Sie können einen der folgenden Ressourcentypen auswählen:

- Azure KI Vision: Eine bestimmte Ressource für Dienste zum maschinellen Sehen. Verwenden Sie diesen Ressourcentyp, wenn Sie keine anderen Azure KI-Dienste verwenden oder die Auslastung und die Kosten der Ressource „maschinelles Sehen“ separat nachverfolgen möchten.

- Azure KI Services: Eine allgemeine Ressource, die Azure KI Vision zusammen mit vielen anderen Azure KI-Diensten wie Azure KI Language, Azure KI Speech und anderen umfasst. Verwenden Sie diesen Ressourcentyp, wenn Sie mehrere Azure KI Services verwenden und die Verwaltung und Entwicklung vereinfachen möchten.

Sobald Sie eine Ressource erstellt haben, gibt es mehrere Möglichkeiten, die Lese-API von Azure KI Vision zu nutzen:

- Vision Studio

- REST-API

- Software Development Kits (SDKs): Python, C#, JavaScript

Im Folgenden konzentrieren wir uns auf das Vision Studio.

Azure KI Vision Studio

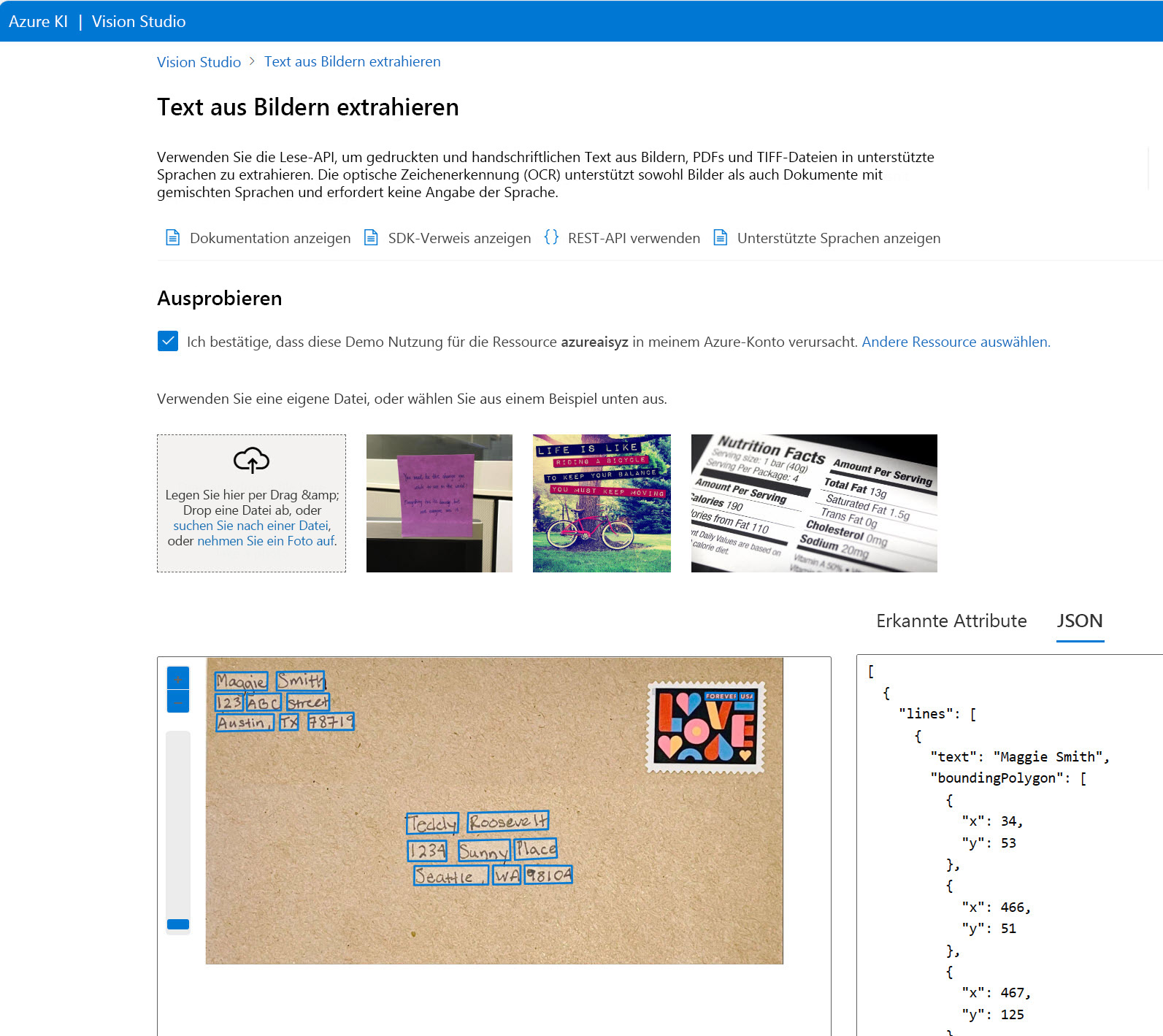

Azure KI Vision Studio ermöglicht Ihnen den Zugriff auf Azure KI Vision APIs über eine grafische Benutzeroberfläche, die keine Programmierung erfordert.

Wenn Sie Vision Studio öffnen, müssen Sie Ihre Standardressource auswählen. Ihre Standardressource in Vision Studio muss eine Azure KI-Dienste-Ressource sein, keine Azure KI Vision-Ressource.

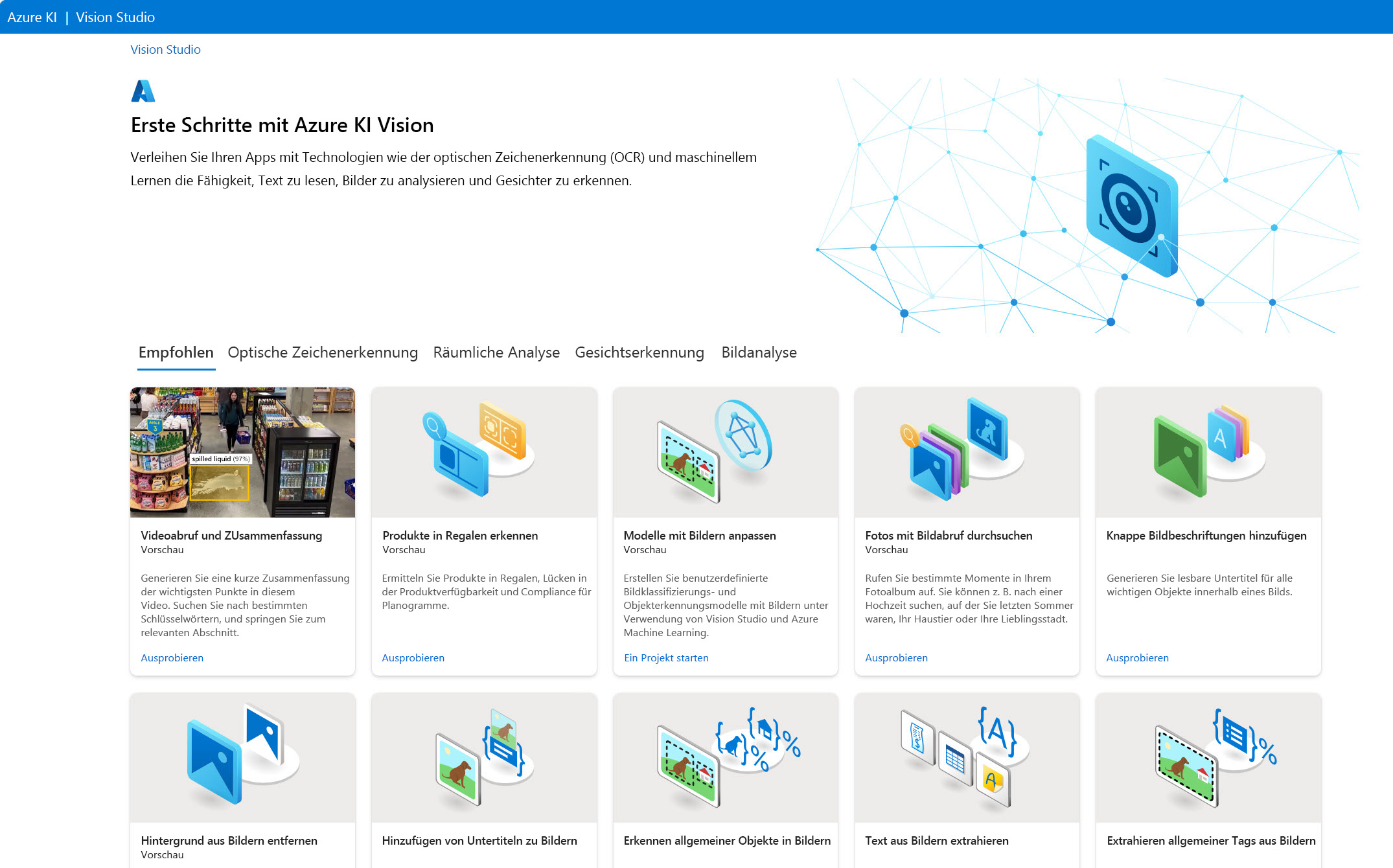

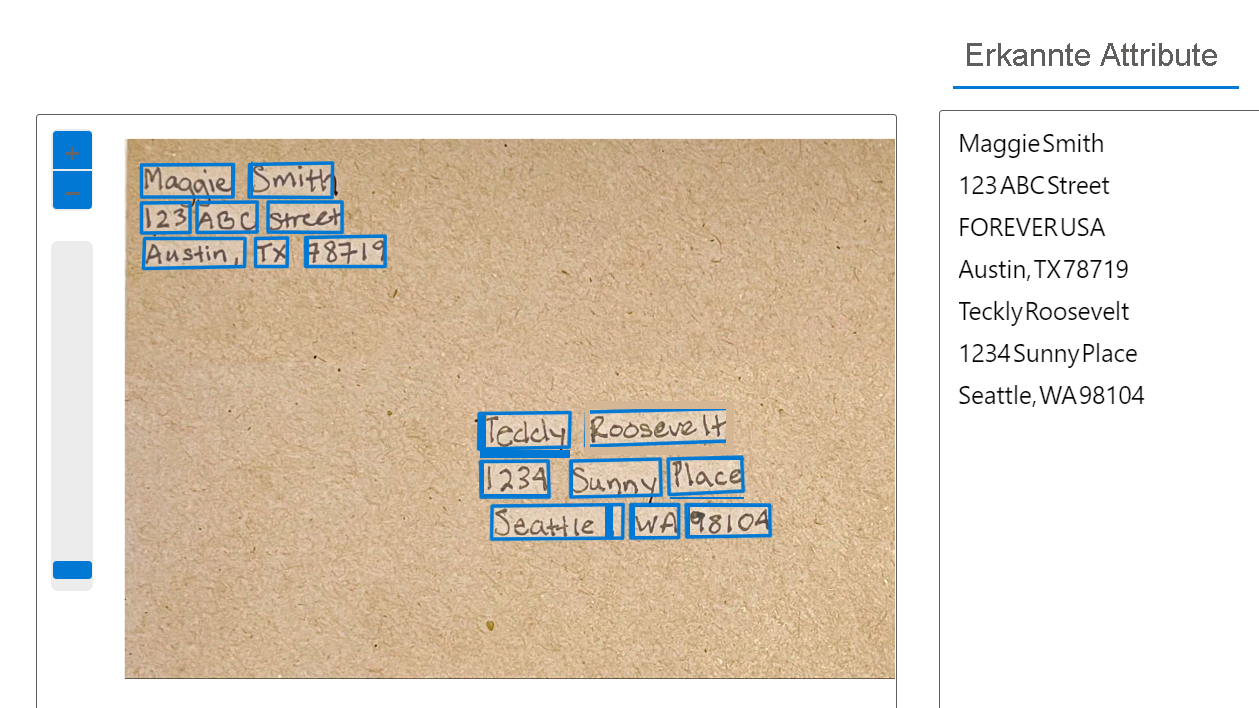

Auf der Vision Studio-Startseite können Sie Optische Zeichenerkennung und die Kachel Text aus Bildern extrahieren auswählen, um die Read OCR-Engine zu testen. Ihre Ressource verursacht Nutzungskosten, wenn sie für die Rückgabe von Ergebnissen verwendet wird. Anhand einer Ihrer eigenen Dateien oder einer Beispieldatei können Sie sehen, wie die Read OCR Engine erkannte Attribute zurückgibt. Diese Attribute entsprechen dem, was der Computer in den Begrenzungsrahmen erkennt.

Im Hintergrund wird das Bild auf Merkmale wie Personen, Text und Objekte analysiert und durch Begrenzungsrahmen markiert. Die erkannten Informationen werden verarbeitet, und die Ergebnisse werden an den Benutzer bzw. die Benutzerin zurückgegeben. Die Rohergebnisse werden in JSON zurückgegeben und enthalten Informationen über die Positionen der Begrenzungsrahmen auf der Seite und den erkannten Text. Denken Sie daran, dass Vision Studio Beispiele für OCR liefern kann, aber um Ihre eigene OCR-Anwendung zu erstellen, müssen Sie mit einem SDK oder einer REST API arbeiten.