Wie funktioniert Azure KI Inhaltssicherheit?

Azure KI Inhaltssicherheit funktioniert mit Text und Bildern und KI-generierten Inhalten.

Die Vision-Funktionen für die Inhaltssicherheit werden durch das Florence Foundation-Modell von Microsoft unterstützt, das mit Milliarden von Textbildpaaren trainiert wurde. Die Textanalyse verwendet Techniken für die Verarbeitung natürlicher Sprachen und ermöglicht ein besseres Verständnis von Nuancen und Kontext. Azure KI Inhaltssicherheit ist mehrsprachig und kann schädliche Inhalte in kurzer und langer Form erkennen. Es ist derzeit in Englisch, Deutsch, Spanisch, Französisch, Portugiesisch, Italienisch und Chinesisch verfügbar.

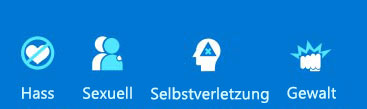

Azure KI Inhaltssicherheit klassifiziert Inhalte in vier Kategorien:

Anhand eines Schweregrads für jede Kategorie wird bestimmt, ob Inhalte blockiert, an einen Moderator gesendet oder automatisch genehmigt werden sollen.

Die Features von Azure KI Inhaltssicherheit umfassen:

Schützen von Textinhalten

Moderater Text scannt Text in vier Kategorien: Gewalt, Hassrede, sexuelle Inhalte und Selbstverletzung. Für jede Kategorie wird ein Schweregrad von 0 bis 6 zurückgegeben. Auf dieser Ebene können Sie priorisieren, was sofortige Aufmerksamkeit durch einen Menschen benötigt und wie dringend. Sie können auch eine Blockliste erstellen, um nach Begriffen zu suchen, die für Ihre Situation spezifisch sind.

Prompt Shields ist eine einheitliche API zum Identifizieren und Blockieren von Jailbreak-Angriffen von Eingaben an LLMs. Sie enthält sowohl Benutzereingaben als auch Dokumente. Diese Angriffe sind Aufforderungen an LLMs, die versuchen, die integrierten Sicherheitsfeatures des Modells zu umgehen. Benutzeraufforderungen werden getestet, um sicherzustellen, dass die Eingabe für das LLM sicher ist. Dokumente werden getestet, um sicherzustellen, dass sie keine unsicheren Anweisungen enthalten, die in den Text eingebettet sind.

Geschützte Materialerkennung überprüft KI-generierten Text auf geschützten Text wie Rezepte, urheberrechtlich geschützte Songtexte oder anderes Originalmaterial.

Die Fundiertheitserkennung schützt vor ungenauen Antworten in KI-generierten Texten von LLMs. Öffentliche LLMs verwenden Daten, die zum Zeitpunkt des Trainings verfügbar sind. Daten können jedoch nach dem ursprünglichen Training des Modells eingeführt werden oder auf privaten Daten basieren. Eine fundierte Antwort ist eine Antwort, bei der die Ausgabe des Modells auf den Quellinformationen basiert. Eine unfundierte Antwort ist eine Antwort, bei der die Ausgabe des Modells von den Quellinformationen abweicht. Die Fundiertheitserkennung enthält eine Erläuterungsoption in der API-Antwort. Dadurch wird ein Feld Erläuterung hinzugefügt, das die Erkennung von Unfundiertheit erläutert. Erläuterung erhöht jedoch die Verarbeitungszeit und die Kosten.

Schützen von Bildinhalten

Moderate Bilder sucht nach unangemessenen Inhalten in vier Kategorien: Gewalt, Selbstverletzung, sexuelle Inhalte und Hass. Es wird ein Schweregrad zurückgegeben: sicher, niedrig oder hoch. Anschließend legen Sie einen Schwellenwert für niedrig, mittel oder hoch fest. Die Kombination aus Schweregrad und Schwellenwert bestimmt, ob das Bild für jede Kategorie zulässig oder blockiert ist.

Moderater multimodaler Inhalt scannt sowohl Bilder als auch Text, einschließlich Text, der aus einem Bild extrahiert wurde, mithilfe der optischen Zeichenerkennung (OCR). Inhalte werden in vier Kategorien analysiert: Gewalt, Hassrede, sexuelle Inhalte und Selbstverletzung.

Benutzerdefinierte Sicherheitslösungen

Mit benutzerdefinierten Kategorien können Sie eigene Kategorien erstellen, indem Sie positive und negative Beispiele bereitstellen und das Modell trainieren. Inhalte können dann entsprechend Ihren eigenen Kategoriedefinitionen gescannt werden.

Die Meldung des Sicherheitssystems hilft Ihnen, effektive Aufforderungen zu schreiben, um das Verhalten eines KI-Systems zu leiten.

Begrenzungen

Azure KI Inhaltssicherheit verwendet KI-Algorithmen und erkennt daher unangemessene Sprache möglicherweise nicht immer. Und manchmal kann es akzeptable Sprache blockieren, da es auf Algorithmen und maschinellem Lernen basiert, um problematische Sprache zu erkennen.

Azure KI Inhaltssicherheit sollte vor der Bereitstellung auf realen Daten getestet und ausgewertet werden. Nach der Bereitstellung sollten Sie das System weiterhin überwachen, um zu sehen, wie akkurat es funktioniert.

Auswerten der Genauigkeit

Wenn Sie auswerten, wie akkurat Azure KI Inhaltssicherheit für Ihre Situation ist, vergleichen Sie die Leistung anhand von vier Kriterien:

- True Positive – korrekte Identifizierung schädlicher Inhalte.

- False Positive – falsche Identifizierung schädlicher Inhalte.

- True Negative – korrekte Identifizierung harmloser Inhalte.

- False Negative – schädliche Inhalte werden nicht identifiziert.

Azure KI Inhaltssicherheit eignet sich optimal, um menschliche Moderatoren zu unterstützen, die Fälle einer falschen Identifizierung beheben können. Wenn Personen Inhalte zu einer Website hinzufügen, gehen sie davon aus, dass Beiträge nicht ohne Grund entfernt werden. Die Kommunikation mit Benutzern darüber, warum Inhalte entfernt oder als unangemessen gekennzeichnet werden, hilft jedem zu verstehen, was zulässig ist und was nicht.