Übersetzen von gesprochener Sprache in Text

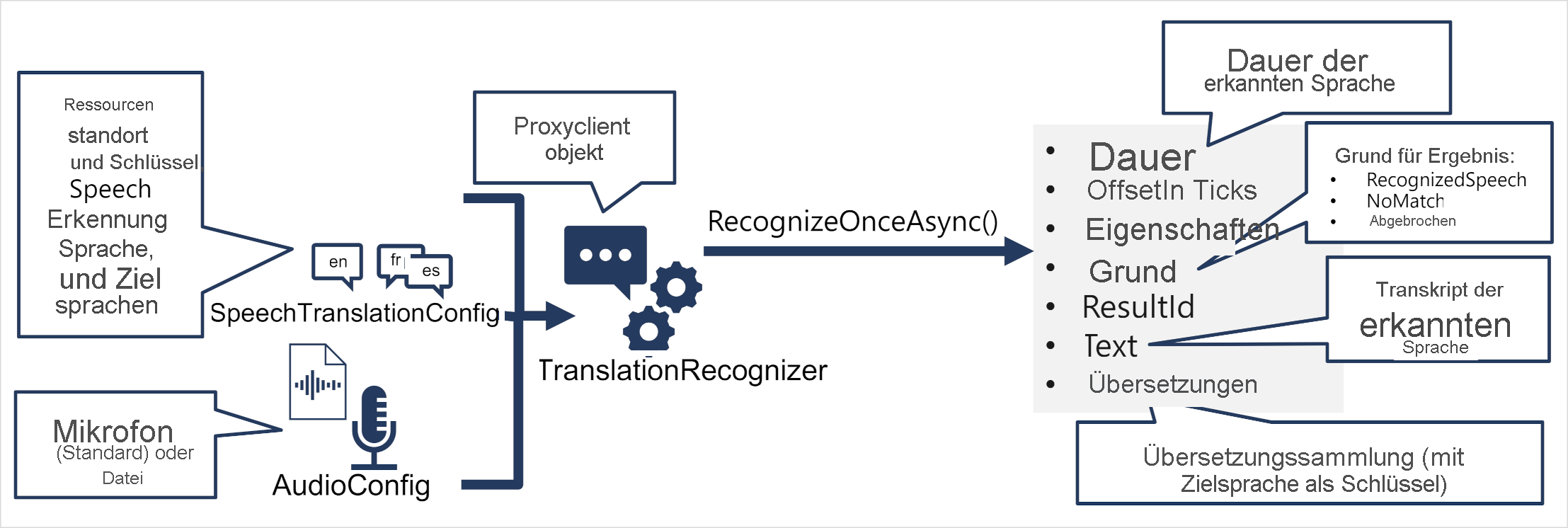

Das Muster für die Sprachübersetzung mit dem Azure KI Speech SDK ist ähnlich wie bei der Spracherkennung, mit dem Zusatz von Informationen zur Quell- und Zielsprache für die Übersetzung:

Verwenden Sie ein SpeechTranslationConfig-Objekt, um die Informationen zu kapseln, die zum Herstellen einer Verbindung mit Ihrer Azure KI Speech-Ressource erforderlich sind. Insbesondere ihren Standort und Schlüssel.

Das SpeechTranslationConfig-Objekt dient auch dazu, die Spracherkennungssprache (die Sprache, in der die Eingabe gesprochen wird) und die Zielsprachen, in die sie übersetzt werden soll, anzugeben.

Verwenden Sie optional ein AudioConfig-Objekt, um die Eingabequelle für die zu transkribierenden Audioinformationen zu definieren. Standardmäßig ist dies das Standardsystemmikrofon, aber Sie können auch eine Audiodatei angeben.

Verwenden Sie SpeechTranslationConfig und AudioConfig, um ein TranslationRecognizer-Objekt zu erstellen. Dieses Objekt ist ein Proxyclient für die Übersetzungs-API von Azure KI Speech.

Verwenden Sie die Methoden des TranslationRecognizer-Objekts, um die zugrunde liegenden API-Funktionen aufzurufen. Beispielsweise verwendet die RecognizeOnceAsync()-Methode Azure KI Speech, um eine einzelne gesprochene Äußerung asynchron zu übersetzen.

Verarbeiten Sie die Antwort von Azure KI Speech. Im Fall der RecognizeOnceAsync()-Methode ist das Ergebnis ein SpeechRecognitionResult-Objekt, das die folgenden Eigenschaften enthält:

- Duration

- OffsetInTicks

- Eigenschaften

- `Reason`

- ResultId

- Text

- Translations

Wenn der Vorgang erfolgreich war, weist die Reason-Eigenschaft den aufgezählten Wert RecognizedSpeech auf, und die Text-Eigenschaft enthält die Transkription in der Originalsprache. Sie können auch auf eine Translations-Eigenschaft zugreifen, die ein Wörterbuch der Übersetzungen enthält (mit dem zweistelligen ISO-Sprachcode als Schlüssel, z. B. „en“ für Englisch).