Adición de Apache Kafka como origen en el centro en tiempo real (versión preliminar)

En este artículo se describe cómo agregar Apache Kafka como origen de eventos en el centro en tiempo real de Fabric.

Requisitos previos

- Acceso a un área de trabajo en el modo de licencia de capacidad de Fabric (o) el modo de licencia de prueba con los permisos Colaborador o superior.

- Un clúster de Apache Kafka en ejecución.

- Apache Kafka debe ser accesible públicamente y no estar detrás de un firewall o protegido en una red virtual.

Página Orígenes de datos

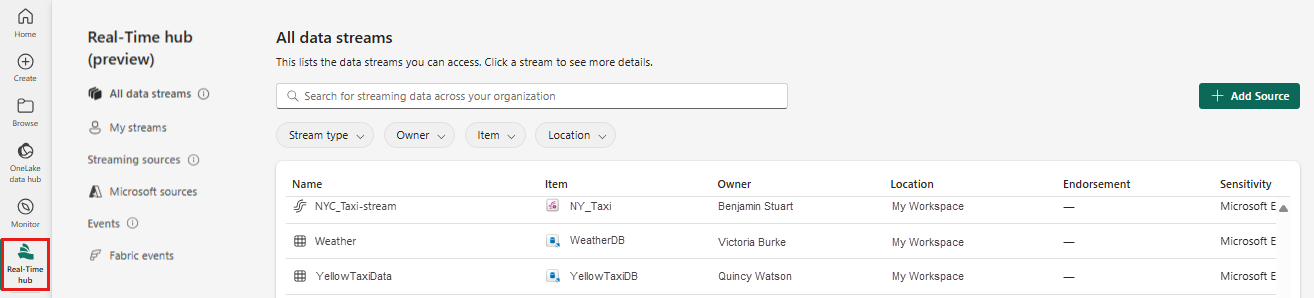

Inicie sesión en Microsoft Fabric.

Selecciona Tiempo real en la barra de navegación de la izquierda.

En la página Centro en tiempo real, selecciona + Orígenes de datos en Conectar a en el menú de navegación izquierdo. También puedes acceder a la página Orígenes de datos desde las páginas Todos los flujos de datos o Mis flujos de datos seleccionando el botón + Conectar origen de datos de la esquina superior derecha.

Adición de Apache Kafka como origen

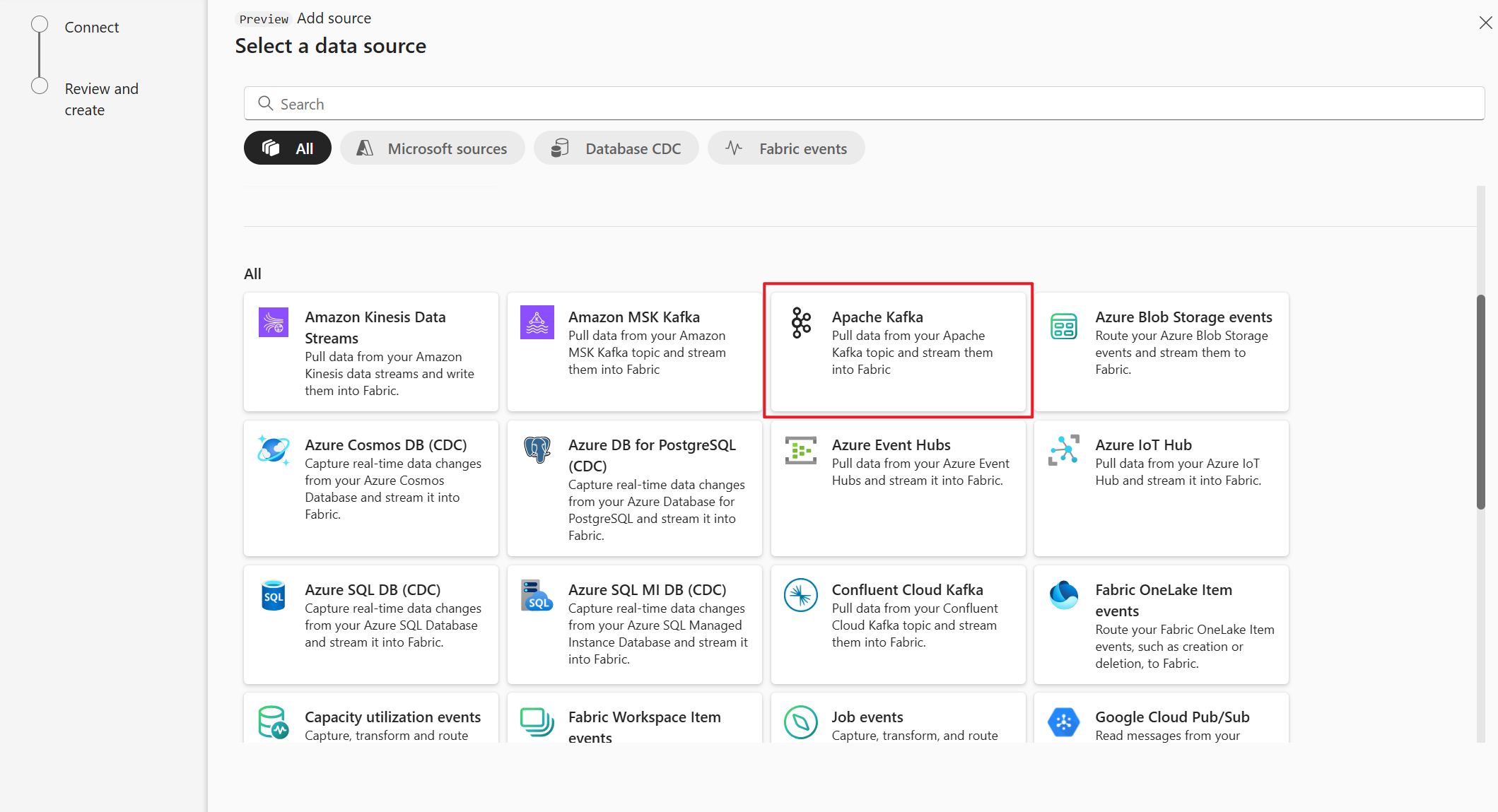

En la página Seleccionar un origen de datos, seleccione Apache Kafka.

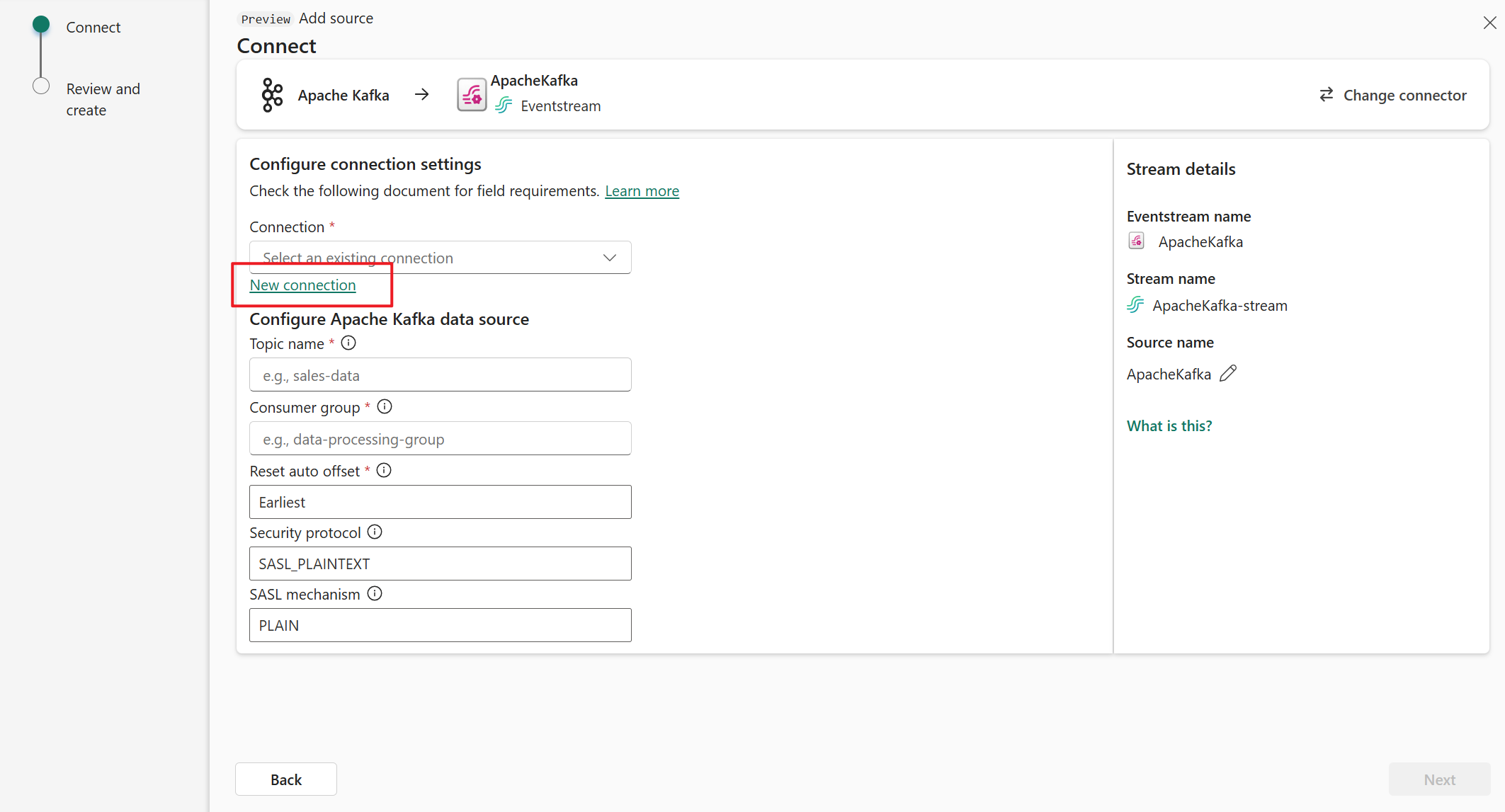

En la página Conectar, seleccione Nueva conexión.

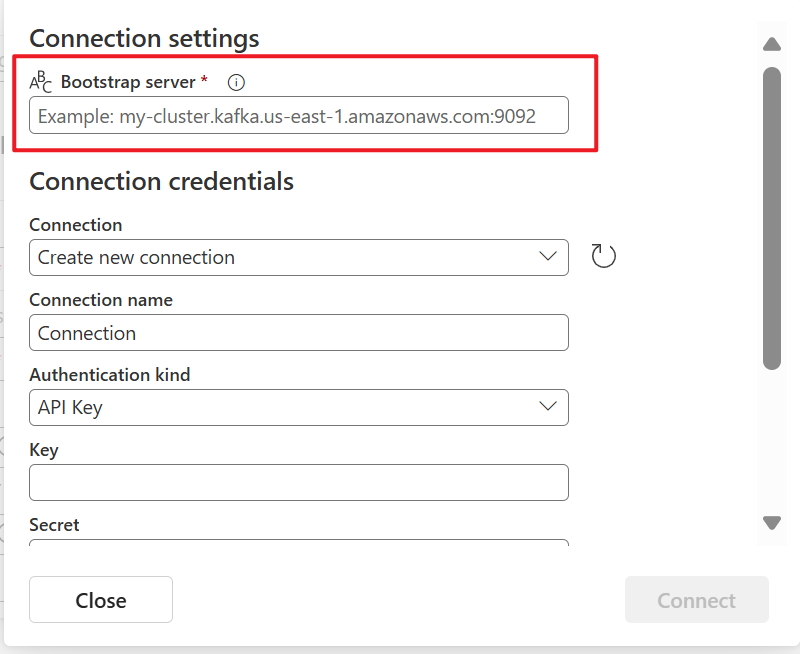

En la sección Configuración de conexión, en Arranque de servidor, escriba la dirección del servidor de Apache Kafka.

En la sección Credenciales de conexión, si tiene una conexión existente al clúster de Apache Kafka, selecciónela en la lista desplegable de Conexión. De lo contrario, siga estos pasos:

- Para Nombre de conexión, introduzca un nombre para la conexión.

- En Tipo de autenticación, confirme que está seleccionada la clave de API.

- En Clave y Secreto, escriba la clave de API y el secreto de clave.

Seleccione Conectar.

Ahora, en la página Conectar, sigue estos pasos.

En Tema, escriba el tema de Kafka.

En Grupo de consumidores, escriba el grupo de consumidores del clúster de Apache Kafka. Este campo proporciona un grupo de consumidores dedicado para obtener eventos.

Seleccione Restablecer desplazamiento automático para especificar dónde empezar a leer desplazamientos si no hay ninguna confirmación.

En Protocolo de seguridad, el valor predeterminado es SASL_PLAINTEXT.

Nota:

Actualmente, el origen de Apache Kafka solo admite la transmisión de datos sin cifrar (SASL_PLAINTEXT y PLAINTEXT) entre el clúster de Apache Kafka y Eventstream. La compatibilidad con la transmisión de datos cifrada a través de SSL estará disponible pronto.

El mecanismo SASL predeterminado suele ser PLAIN, a menos que se configure lo contrario. Puede seleccionar el mecanismo SCRAM-SHA-256 o SCRAM-SHA-512 que se adapte a sus requisitos de seguridad.

Seleccione Siguiente. En la pantalla Revisar y crear, revise el resumen y, a continuación, seleccione Agregar.

Visualización de los detalles del flujo de datos

En la página Revisar y conectar, si selecciona Abrir secuencia de eventos, el asistente abre la secuencia de eventos que creó automáticamente con el origen de Apache Kafka seleccionado. Para cerrar el asistente, seleccione Cerrar en la parte inferior de la página.

En el centro en tiempo real, cambie a la pestaña Flujos de datos del centro en tiempo real. Actualice la página. Debería ver la secuencia de datos creada automáticamente.

Para obtener pasos detallados, consulte Visualización de los detalles de los flujos de datos en el centro en tiempo real de Fabric.

Contenido relacionado

Para obtener información sobre cómo consumir flujos de datos, vea los artículos siguientes: