Inspección de datos de telemetría con Application Insights

Application Insights forma parte de Azure Monitor, que es una solución completa para recopilar, analizar y actuar sobre datos de telemetría de los entornos locales y en la nube. Con Application Insights, puede supervisar el rendimiento de la aplicación, detectar problemas y diagnosticar problemas.

En este ejemplo, aprenderá a exportar datos de telemetría a Application Insights e inspeccionar los datos en el portal de Application Insights.

Exportador

Los exportadores son responsables de enviar datos de telemetría a un destino. Obtenga más información sobre los exportadores aquí. En este ejemplo, se usa el exportador de Azure Monitor para generar datos de telemetría en una instancia de Application Insights.

Requisitos previos

- Una implementación de finalización de chat de Azure OpenAI.

- Una instancia de Application Insights. Siga las instrucciones que se indican aquí para crear un recurso si no tiene uno. Copie el cadena de conexión para su uso posterior.

- El SDK de .Net más reciente para el sistema operativo.

- Una implementación de finalización de chat de Azure OpenAI.

- Una instancia de Application Insights. Siga las instrucciones que se indican aquí para crear un recurso si no tiene uno. Copie el cadena de conexión para su uso posterior.

- Python 3.10, 3.11 o 3.12 instalado en el equipo.

Nota:

La observabilidad semántica del kernel aún no está disponible para Java.

Configurar

Creación de una nueva aplicación de consola

En un terminal, ejecute el siguiente comando para crear una nueva aplicación de consola en C#:

dotnet new console -n TelemetryApplicationInsightsQuickstart

Vaya al directorio del proyecto recién creado una vez completado el comando.

Instalación de los paquetes requeridos

Kernel semántico

dotnet add package Microsoft.SemanticKernelExportador de consola de OpenTelemetry

dotnet add package Azure.Monitor.OpenTelemetry.Exporter

Creación de una aplicación sencilla con kernel semántico

En el directorio del proyecto, abra el Program.cs archivo con su editor favorito. Vamos a crear una aplicación sencilla que use kernel semántico para enviar un mensaje a un modelo de finalización de chat. Reemplace el contenido existente por el código siguiente y rellene los valores necesarios para deploymentName, endpointy apiKey:

using Azure.Monitor.OpenTelemetry.Exporter;

using Microsoft.Extensions.DependencyInjection;

using Microsoft.Extensions.Logging;

using Microsoft.SemanticKernel;

using OpenTelemetry;

using OpenTelemetry.Logs;

using OpenTelemetry.Metrics;

using OpenTelemetry.Resources;

using OpenTelemetry.Trace;

namespace TelemetryApplicationInsightsQuickstart

{

class Program

{

static async Task Main(string[] args)

{

// Telemetry setup code goes here

IKernelBuilder builder = Kernel.CreateBuilder();

// builder.Services.AddSingleton(loggerFactory);

builder.AddAzureOpenAIChatCompletion(

deploymentName: "your-deployment-name",

endpoint: "your-azure-openai-endpoint",

apiKey: "your-azure-openai-api-key"

);

Kernel kernel = builder.Build();

var answer = await kernel.InvokePromptAsync(

"Why is the sky blue in one sentence?"

);

Console.WriteLine(answer);

}

}

}

Adición de telemetría

Si ejecuta la aplicación de consola ahora, debería esperar ver una frase que explique por qué el cielo es azul. Para observar el kernel mediante telemetría, reemplace el // Telemetry setup code goes here comentario por el código siguiente:

// Replace the connection string with your Application Insights connection string

var connectionString = "your-application-insights-connection-string";

var resourceBuilder = ResourceBuilder

.CreateDefault()

.AddService("TelemetryApplicationInsightsQuickstart");

// Enable model diagnostics with sensitive data.

AppContext.SetSwitch("Microsoft.SemanticKernel.Experimental.GenAI.EnableOTelDiagnosticsSensitive", true);

using var traceProvider = Sdk.CreateTracerProviderBuilder()

.SetResourceBuilder(resourceBuilder)

.AddSource("Microsoft.SemanticKernel*")

.AddAzureMonitorTraceExporter(options => options.ConnectionString = connectionString)

.Build();

using var meterProvider = Sdk.CreateMeterProviderBuilder()

.SetResourceBuilder(resourceBuilder)

.AddMeter("Microsoft.SemanticKernel*")

.AddAzureMonitorMetricExporter(options => options.ConnectionString = connectionString)

.Build();

using var loggerFactory = LoggerFactory.Create(builder =>

{

// Add OpenTelemetry as a logging provider

builder.AddOpenTelemetry(options =>

{

options.SetResourceBuilder(resourceBuilder);

options.AddAzureMonitorLogExporter(options => options.ConnectionString = connectionString);

// Format log messages. This is default to false.

options.IncludeFormattedMessage = true;

options.IncludeScopes = true;

});

builder.SetMinimumLevel(LogLevel.Information);

});

Por último, quite la marca de comentario de la línea // builder.Services.AddSingleton(loggerFactory); para agregar el generador del registrador al generador.

Consulte este artículo para obtener más información sobre el código de configuración de telemetría. La única diferencia aquí es que estamos usando AddAzureMonitor[Trace|Metric|Log]Exporter para exportar datos de telemetría a Application Insights.

Creación de un nuevo entorno virtual de Python

python -m venv telemetry-application-insights-quickstart

Active el entorno virtual.

telemetry-application-insights-quickstart\Scripts\activate

Instalación de los paquetes requeridos

pip install semantic-kernel azure-monitor-opentelemetry-exporter

Creación de un script de Python sencillo con kernel semántico

Cree un nuevo script de Python y ábralo con su editor favorito.

New-Item -Path telemetry_application_insights_quickstart.py -ItemType file

Vamos a crear un script de Python sencillo que use kernel semántico para enviar un mensaje a un modelo de finalización de chat. Reemplace el contenido existente por el código siguiente y rellene los valores necesarios para deployment_name, endpointy api_key:

import asyncio

import logging

from azure.monitor.opentelemetry.exporter import (

AzureMonitorLogExporter,

AzureMonitorMetricExporter,

AzureMonitorTraceExporter,

)

from opentelemetry._logs import set_logger_provider

from opentelemetry.metrics import set_meter_provider

from opentelemetry.sdk._logs import LoggerProvider, LoggingHandler

from opentelemetry.sdk._logs.export import BatchLogRecordProcessor

from opentelemetry.sdk.metrics import MeterProvider

from opentelemetry.sdk.metrics.export import PeriodicExportingMetricReader

from opentelemetry.sdk.metrics.view import DropAggregation, View

from opentelemetry.sdk.resources import Resource

from opentelemetry.sdk.trace import TracerProvider

from opentelemetry.sdk.trace.export import BatchSpanProcessor

from opentelemetry.semconv.resource import ResourceAttributes

from opentelemetry.trace import set_tracer_provider

from semantic_kernel import Kernel

from semantic_kernel.connectors.ai.open_ai import AzureChatCompletion

# Telemetry setup code goes here

async def main():

# Create a kernel and add a service

kernel = Kernel()

kernel.add_service(AzureChatCompletion(

api_key="your-azure-openai-api-key",

endpoint="your-azure-openai-endpoint",

deployment_name="your-deployment-name"

))

answer = await kernel.invoke_prompt("Why is the sky blue in one sentence?")

print(answer)

if __name__ == "__main__":

asyncio.run(main())

Adición de telemetría

Variables de entorno

Consulte este artículo para obtener más información sobre cómo configurar las variables de entorno necesarias para permitir que el kernel emita intervalos para los conectores de IA.

Código

Si ejecuta el script ahora, debería esperar ver una frase que explique por qué el cielo es azul. Para observar el kernel mediante telemetría, reemplace el # Telemetry setup code goes here comentario por el código siguiente:

# Replace the connection string with your Application Insights connection string

connection_string = "your-application-insights-connection-string"

# Create a resource to represent the service/sample

resource = Resource.create({ResourceAttributes.SERVICE_NAME: "telemetry-application-insights-quickstart"})

def set_up_logging():

exporter = AzureMonitorLogExporter(connection_string=connection_string)

# Create and set a global logger provider for the application.

logger_provider = LoggerProvider(resource=resource)

# Log processors are initialized with an exporter which is responsible

# for sending the telemetry data to a particular backend.

logger_provider.add_log_record_processor(BatchLogRecordProcessor(exporter))

# Sets the global default logger provider

set_logger_provider(logger_provider)

# Create a logging handler to write logging records, in OTLP format, to the exporter.

handler = LoggingHandler()

# Add filters to the handler to only process records from semantic_kernel.

handler.addFilter(logging.Filter("semantic_kernel"))

# Attach the handler to the root logger. `getLogger()` with no arguments returns the root logger.

# Events from all child loggers will be processed by this handler.

logger = logging.getLogger()

logger.addHandler(handler)

logger.setLevel(logging.INFO)

def set_up_tracing():

exporter = AzureMonitorTraceExporter(connection_string=connection_string)

# Initialize a trace provider for the application. This is a factory for creating tracers.

tracer_provider = TracerProvider(resource=resource)

# Span processors are initialized with an exporter which is responsible

# for sending the telemetry data to a particular backend.

tracer_provider.add_span_processor(BatchSpanProcessor(exporter))

# Sets the global default tracer provider

set_tracer_provider(tracer_provider)

def set_up_metrics():

exporter = AzureMonitorMetricExporter(connection_string=connection_string)

# Initialize a metric provider for the application. This is a factory for creating meters.

meter_provider = MeterProvider(

metric_readers=[PeriodicExportingMetricReader(exporter, export_interval_millis=5000)],

resource=resource,

views=[

# Dropping all instrument names except for those starting with "semantic_kernel"

View(instrument_name="*", aggregation=DropAggregation()),

View(instrument_name="semantic_kernel*"),

],

)

# Sets the global default meter provider

set_meter_provider(meter_provider)

# This must be done before any other telemetry calls

set_up_logging()

set_up_tracing()

set_up_metrics()

Consulte este artículo para obtener más información sobre el código de configuración de telemetría. La única diferencia aquí es que estamos usando AzureMonitor[Trace|Metric|Log]Exporter para exportar datos de telemetría a Application Insights.

Nota:

La observabilidad semántica del kernel aún no está disponible para Java.

Ejecutar

Ejecute la aplicación de consola con el siguiente comando:

dotnet run

Ejecute el script de Python con el siguiente comando:

python telemetry_application_insights_quickstart.py

Nota:

La observabilidad semántica del kernel aún no está disponible para Java.

Inspección de los datos de telemetría

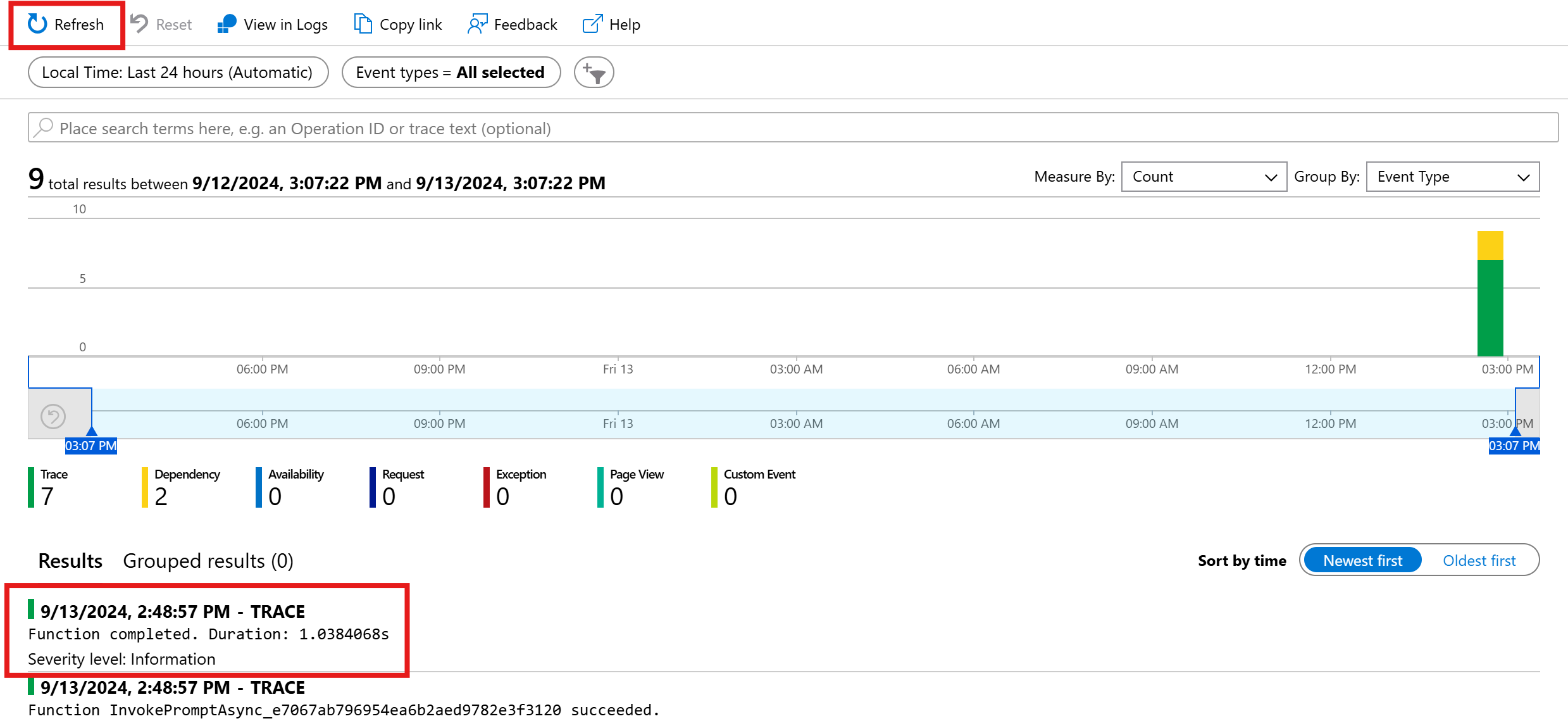

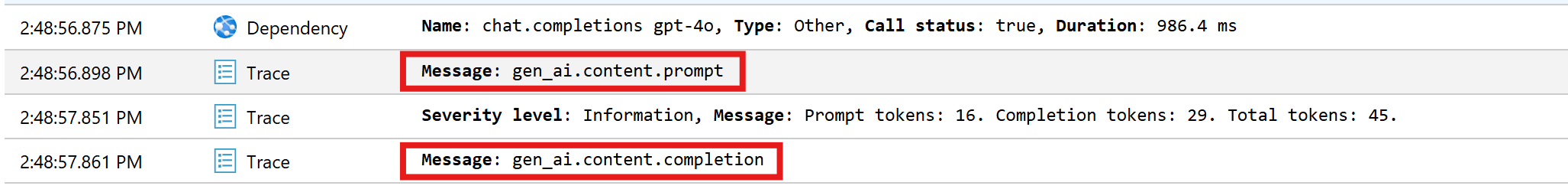

Después de ejecutar la aplicación, vaya al portal de Application Insights para inspeccionar los datos de telemetría. Los datos pueden tardar unos minutos en aparecer en el portal.

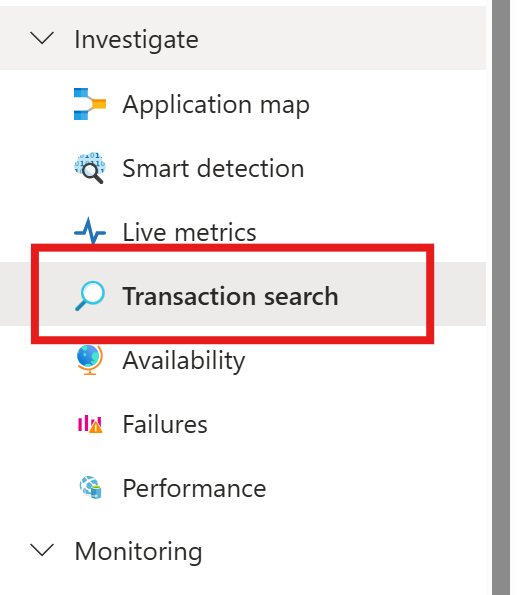

Búsqueda de transacciones

Vaya a la pestaña Búsqueda de transacciones para ver las transacciones que se han registrado.

Presione actualizar para ver las transacciones más recientes. Cuando aparezcan los resultados, haga clic en uno de ellos para ver más detalles.

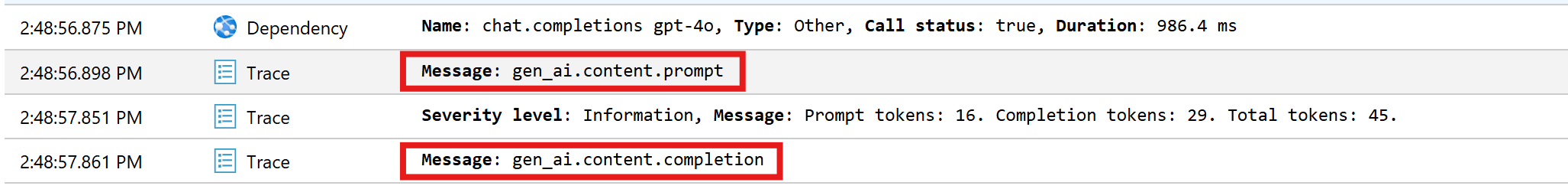

Cambie entre el botón Ver todo y Ver escala de tiempo para ver todos los seguimientos y dependencias de la transacción en distintas vistas.

Importante

Los seguimientos representan entradas de registro tradicionales y eventos de intervalo de OpenTelemetry. No son iguales que los seguimientos distribuidos. Las dependencias representan las llamadas a componentes (internos y externos). Consulte este artículo para obtener más información sobre el modelo de datos en Application Insights.

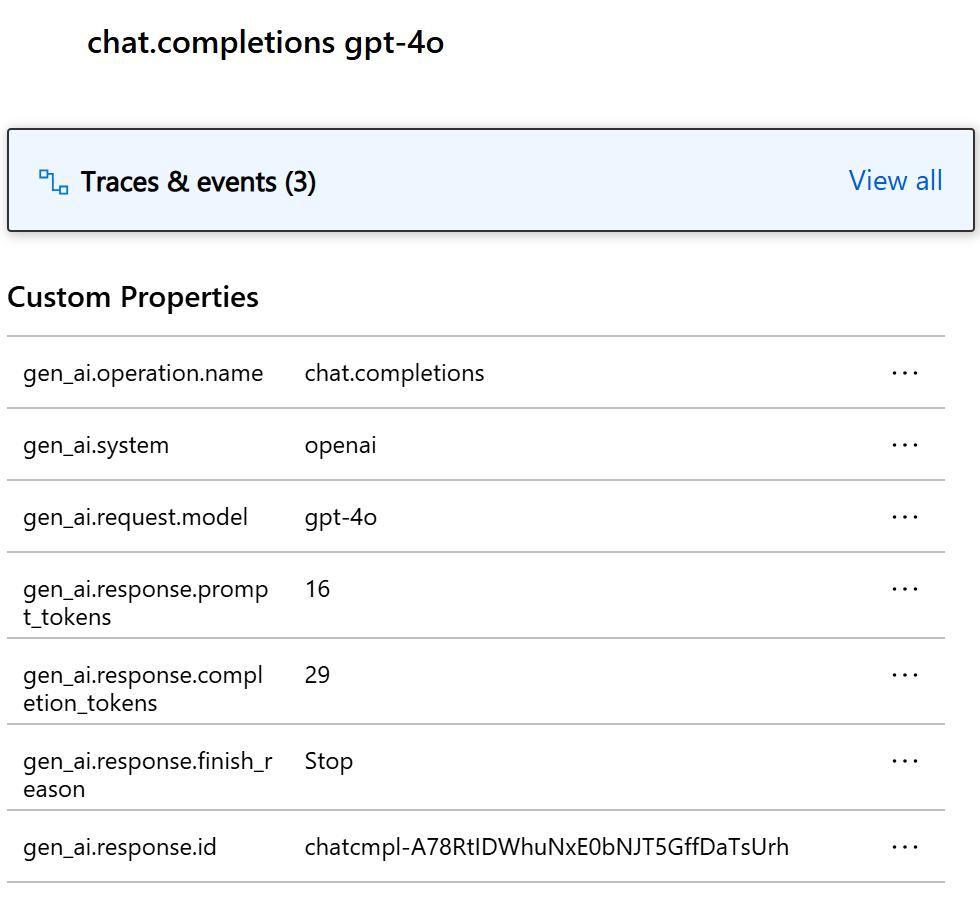

Para este ejemplo concreto, debería ver dos dependencias y varios seguimientos. La primera dependencia representa una función de kernel que se crea a partir del símbolo del sistema. La segunda dependencia representa la llamada al modelo de finalización de chat de Azure OpenAI. Al expandir la chat.completion {your-deployment-name} dependencia, debería ver los detalles de la llamada. Un conjunto de gen_ai atributos se adjunta a la dependencia, que proporciona contexto adicional sobre la llamada.

Si tiene el modificador Microsoft.SemanticKernel.Experimental.GenAI.EnableOTelDiagnosticsSensitive establecido trueen , también verá dos seguimientos que llevan los datos confidenciales del símbolo del sistema y el resultado de la finalización.

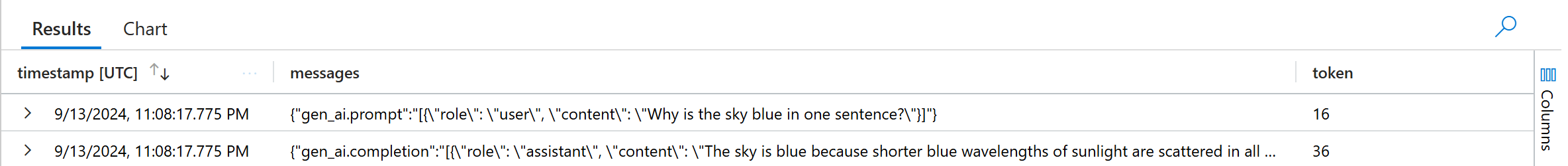

Haga clic en ellos y verá el mensaje y el resultado de finalización en la sección de propiedades personalizadas.

Si tiene la variable SEMANTICKERNEL_EXPERIMENTAL_GENAI_ENABLE_OTEL_DIAGNOSTICS_SENSITIVE de entorno establecida trueen , también verá dos seguimientos que llevan los datos confidenciales del símbolo del sistema y el resultado de la finalización.

Haga clic en ellos y verá el mensaje y el resultado de finalización en la sección de propiedades personalizadas.

Log Analytics

La búsqueda de transacciones no es la única manera de inspeccionar los datos de telemetría. También puede usar Log Analytics para consultar y analizar los datos. Vaya a los registros en Supervisión para iniciarse.

Siga este documento para empezar a explorar la interfaz de Log Analytics.

A continuación se muestran algunas consultas de ejemplo que puede usar para este ejemplo:

// Retrieves the total number of completion and prompt tokens used for the model if you run the application multiple times.

dependencies

| where name startswith "chat"

| project model = customDimensions["gen_ai.request.model"], completion_token = toint(customDimensions["gen_ai.response.completion_tokens"]), prompt_token = toint(customDimensions["gen_ai.response.prompt_tokens"])

| where model == "gpt-4o"

| project completion_token, prompt_token

| summarize total_completion_tokens = sum(completion_token), total_prompt_tokens = sum(prompt_token)

// Retrieves all the prompts and completions and their corresponding token usage.

dependencies

| where name startswith "chat"

| project timestamp, operation_Id, name, completion_token = customDimensions["gen_ai.response.completion_tokens"], prompt_token = customDimensions["gen_ai.response.prompt_tokens"]

| join traces on operation_Id

| where message startswith "gen_ai"

|project timestamp, messages = customDimensions, token=iff(customDimensions contains "gen_ai.prompt", prompt_token, completion_token)

Pasos siguientes

Ahora que ha generado correctamente datos de telemetría en Application Insights, puede explorar más características del kernel semántico que pueden ayudarle a supervisar y diagnosticar la aplicación: