Entrenamiento y puntuación de modelos con Microsoft Fabric

Cuando haya ingerido, explorado y preprocesado los datos, puede usarlos para entrenar un modelo. El entrenamiento de un modelo es un proceso iterativo y le interesa poder realizar el seguimiento del trabajo.

Microsoft Fabric se integra con MLflow para realizar el seguimiento y registrar fácilmente el trabajo, lo que le permite revisarlo en cualquier momento a fin de decidir cuál es el mejor enfoque para entrenar el modelo final. Al realizar el seguimiento del trabajo, los resultados se pueden reproducir fácilmente.

El seguimiento de los trabajos que quiera se puede realizar en forma de experimentos.

Descripción de los experimentos

Siempre que entrene un modelo en un cuaderno del que quiera realizar el seguimiento, puede crear un experimento en Microsoft Fabric.

Un experimento puede constar de varias ejecuciones. Cada ejecución representa una tarea que ha ejecutado en un cuaderno, como entrenar un modelo de Machine Learning.

Por ejemplo, para entrenar un modelo de Machine Learning para la previsión de ventas, puede probar diferentes conjuntos de datos de entrenamiento con el mismo algoritmo. Cada vez que entrena un modelo con un conjunto de datos diferente, se crea una nueva ejecución del experimento. A continuación, puede comparar las ejecuciones del experimento para determinar el modelo de mejor rendimiento.

Inicio de las métricas de seguimiento

Para comparar ejecuciones de experimentos, puede supervisar los parámetros, las métricas y los artefactos de cada ejecución.

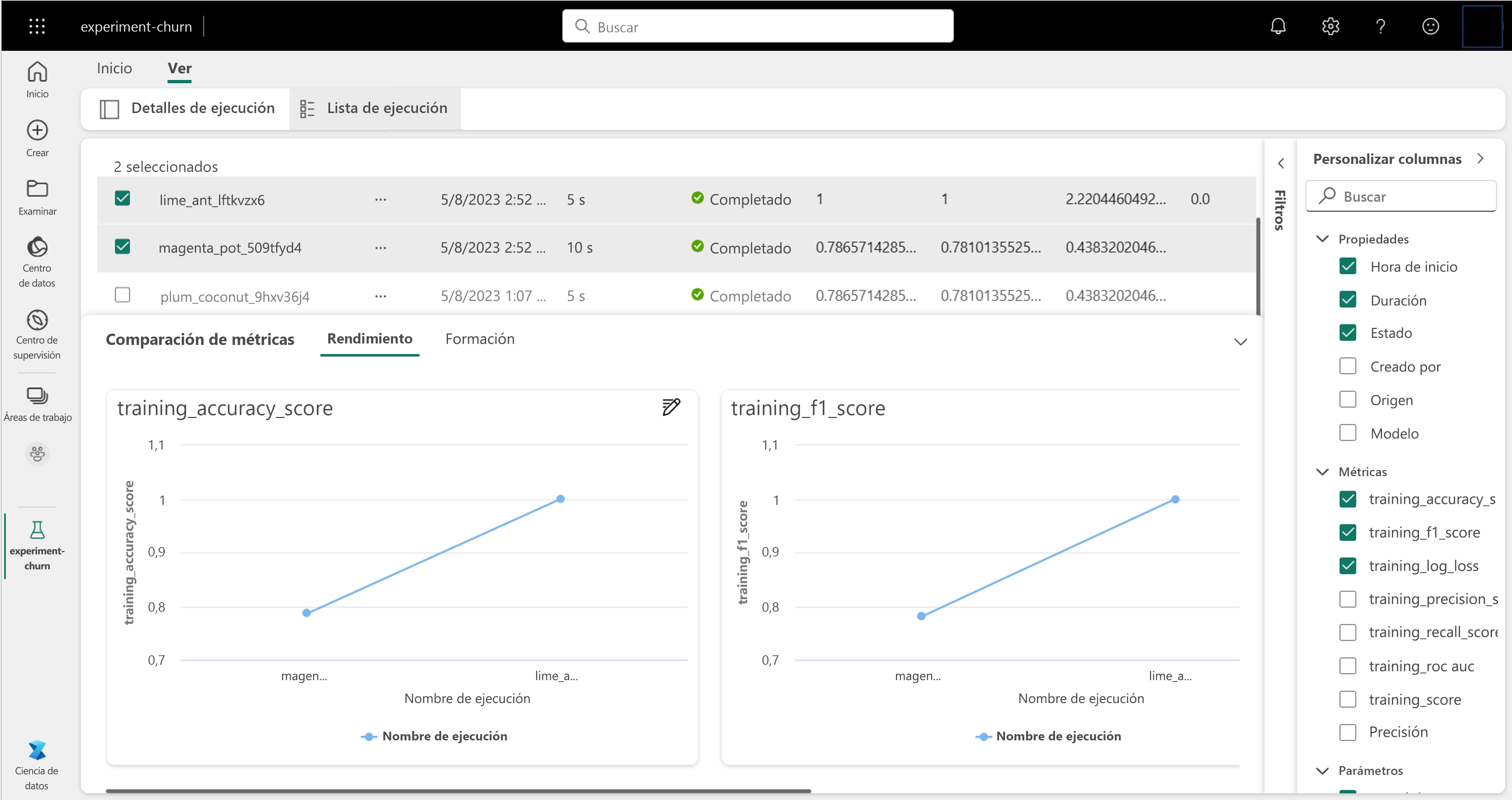

Todos los parámetros, métricas y artefactos que supervise en una ejecución de experimento se muestran en la información general de los experimentos. Puede ver las ejecuciones de experimentos individualmente en la pestaña Detalles de ejecución o comparar entre ejecuciones con la lista de ejecuciones:

Al realizar el seguimiento del trabajo con MLflow, puede comparar las iteraciones de entrenamiento del modelo y decidir qué configuración ha generado el mejor modelo para el caso de uso.

Descripción de modelos

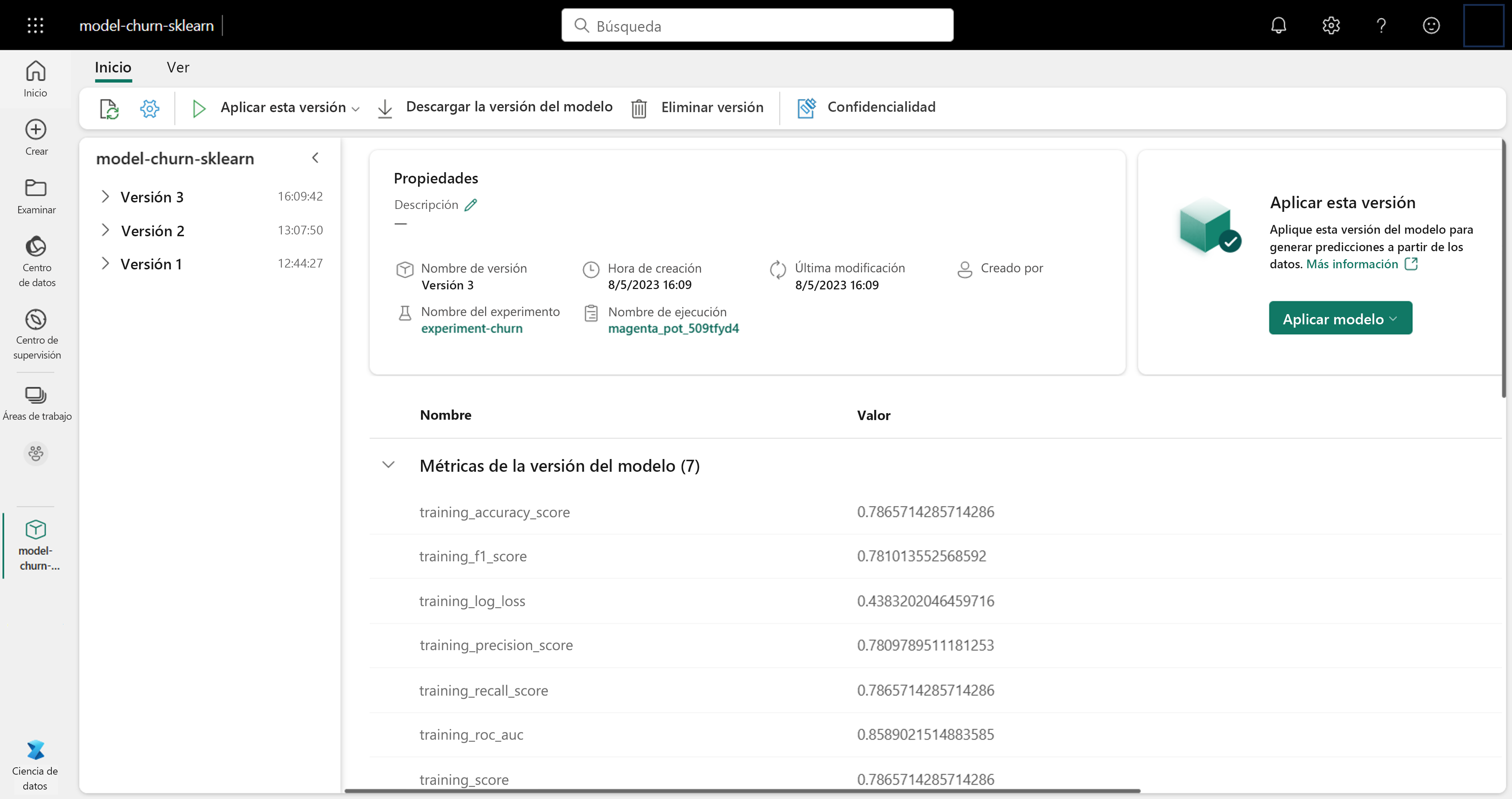

Después de entrenar un modelo, querrá usarlo para puntuar. Con la puntuación, se usa el modelo en nuevos datos para generar predicciones o conclusiones. Al entrenar y realizar el seguimiento de un modelo con MLflow, los artefactos se almacenan dentro de la ejecución del experimento para representar el modelo y sus metadatos. Puede guardar estos artefactos en Microsoft Fabric como un modelo.

Al guardar los artefactos del modelo como un modelo registrado en Microsoft Fabric, puede administrar fácilmente los modelos. Cada vez que entrena un modelo nuevo y lo guarda con el mismo nombre, se agrega una versión nueva al modelo.

Uso de un modelo para generar conclusiones

Para usar un modelo a fin de generar predicciones, puede usar la función PREDICT en Microsoft Fabric. La función PREDICT se ha creado para integrarse fácilmente con los modelos de MLflow y permite usar el modelo para generar predicciones por lotes.

Por ejemplo, cada semana recibe datos de ventas de varias tiendas. En función de los datos históricos, ha entrenado un modelo que puede predecir las ventas de la próxima semana, en función de las ventas de las últimas semanas. Ha realizado el seguimiento del modelo con MLflow y lo ha guardado en Microsoft Fabric. Cada vez que recibe nuevos datos de ventas semanales, usa la función PREDICT para permitir que el modelo genere la previsión para la próxima semana. Los datos de ventas previstos se almacenan como una tabla en un almacén de lago, que se visualiza en un informe de Power BI para que los usuarios empresariales los consuman.