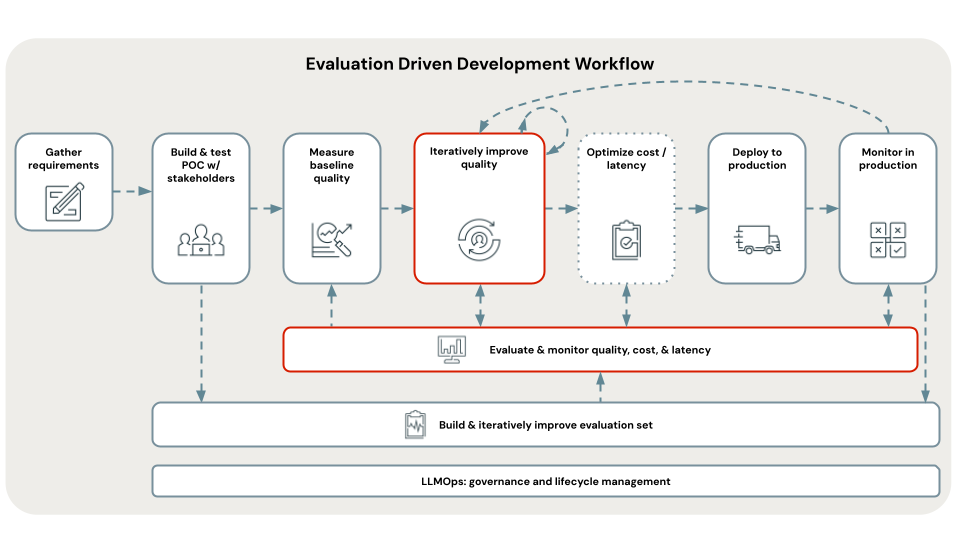

Étape 6. Implémenter et évaluer de manière itérative des correctifs de qualité

Spécifications

- Sur la base de votre analyse de la cause racine, vous avez identifié des correctifs potentiels à implémenter et à évaluer pour la récupération ou la génération.

- Votre application de preuve de concept (POC) (ou une autre chaîne de référence) est enregistrée dans une exécution MLflow avec une évaluation Évaluation de l’agent stockée dans la même exécution.

Consultez le dépôt GitHub pour obtenir l’exemple de code de cette section.

Résultat attendu

Instructions

Pour tous les types, utilisez le notebook B_quality_iteration/02_evaluate_fixes pour évaluer la chaîne résultante par rapport à votre configuration de base de référence et votre POC, et choisissez un « vainqueur ». Ce notebook vous aide à choisir l’expérience gagnante et à la déployer sur l’application de révision ou sur une API REST évolutive prête pour la production.

- Ouvrez le notebook B_quality_iteration/02_evaluate_fixes.

- En fonction du type de correctif que vous implémentez :

- Pour les correctifs de pipeline de données :

- Suivez Étape 6 (pipelines). Implémenter des correctifs de pipeline de données pour créer le nouveau pipeline de données et obtenir le nom de l’exécution MLflow résultante.

- Ajoutez le nom d’exécution à la variable

DATA_PIPELINE_FIXES_RUN_NAMES.

- Pour les correctifs de configuration de chaîne :

- Suivez les instructions de la section

Chain configurationdu notebook 02_evaluate_fixes pour ajouter des correctifs de configuration de chaîne à la variableCHAIN_CONFIG_FIXES.

- Suivez les instructions de la section

- Pour les correctifs de code de chaîne :

- Créez un fichier de code de chaîne modifié et enregistrez-le dans le dossier B_quality_iteration/chain_code_fixes. Vous pouvez également sélectionner l’un des correctifs de code de chaîne fournis à partir de ce dossier.

- Suivez les instructions de la section

Chain codedu notebook 02_evaluate_fixes pour ajouter le fichier de code de chaîne et toute configuration de chaîne supplémentaire requise à la variableCHAIN_CODE_FIXES.

- Pour les correctifs de pipeline de données :

- Voici ce qui se produit lorsque vous exécutez le notebook à partir de la cellule

Run evaluation:- Évaluez chaque correctif.

- Déterminez le correctif offrant les métriques de qualité/coût/latence optimales.

- Déployez le meilleur correctif sur l’application de révision et sur une API REST prête pour la production afin d’obtenir les commentaires de la part des parties prenantes.

Étape suivante

Passez à l’Étape 6 (pipelines). Implémenter des correctifs de pipeline de données.