Paralléliser l’optimisation des hyperparamètres Hyperopt

Remarque

La version open source de Hyperopt n’est plus conservée.

Hyperopt sera supprimé dans la prochaine version principale de DBR ML. Azure Databricks recommande d’utiliser Optuna pour une expérience similaire et d’accéder à des algorithmes d’optimisation des hyperparamètres à jour.

Ce notebook montre comment utiliser Hyperopt pour paralléliser les calculs d’optimisation des hyperparamètres. Il utilise la classe SparkTrials pour distribuer automatiquement les calculs entre les Workers du cluster. Il illustre également le suivi MLflow automatisé des exécutions Hyperopt, ce qui vous permet d’enregistrer les résultats ultérieurement.

Notebook de parallélisation du réglage des hyperparamètres avec suivi automatisé de MLflow

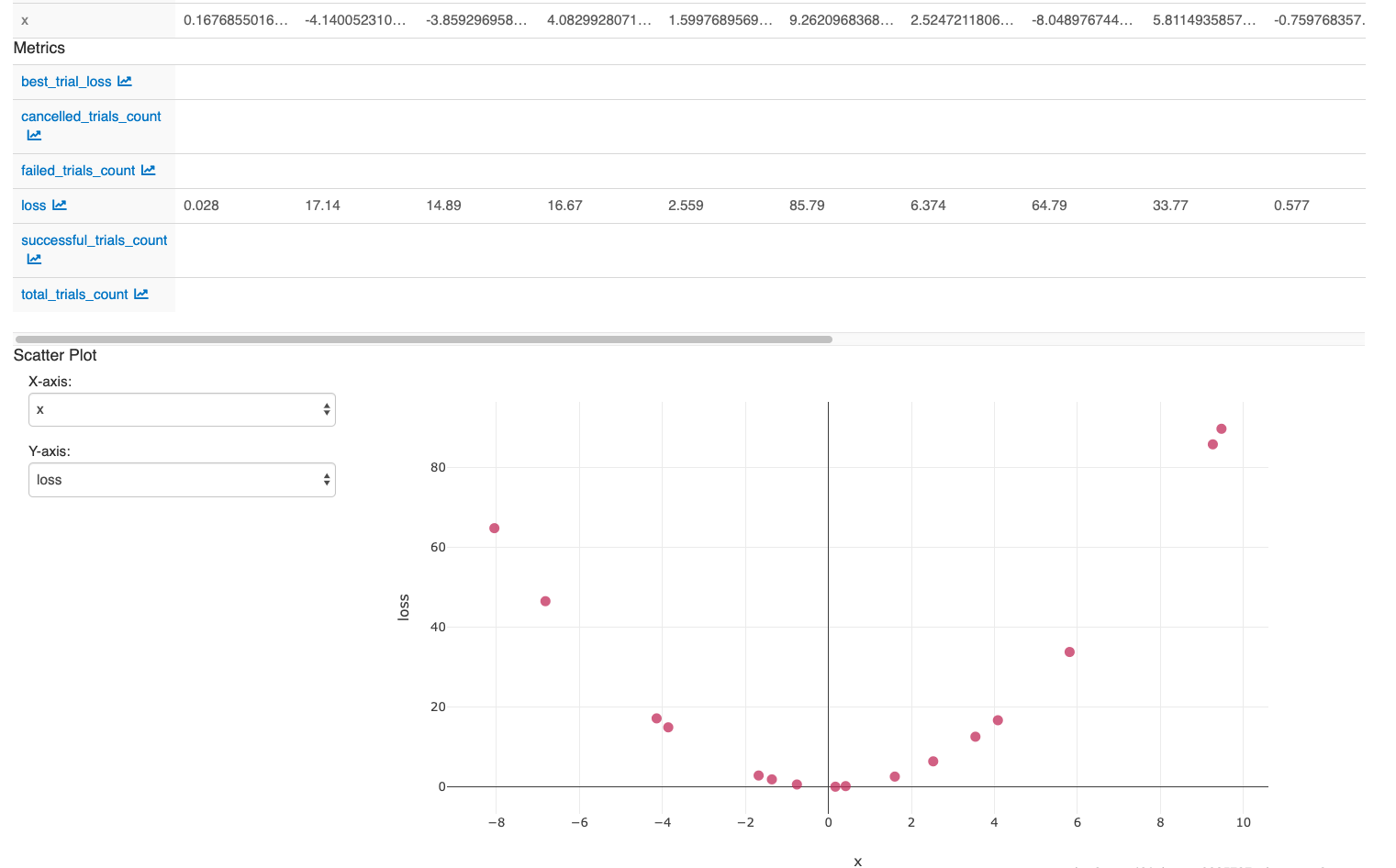

Une fois que vous avez effectué les actions dans la dernière cellule du bloc-notes, votre interface utilisateur MLflow doit afficher :