Qu’est-ce que l’IA responsable ?

S’APPLIQUE À : Extension Azure CLI v2 (actuelle)

Extension Azure CLI v2 (actuelle) Kit de développement logiciel (SDK) Python azure-ai-ml v2 (version actuelle)

Kit de développement logiciel (SDK) Python azure-ai-ml v2 (version actuelle)

L’intelligence artificielle responsable (IA responsable) est une approche du développement, de l’évaluation et du déploiement de systèmes IA de façon sûre, fiable et éthique. Les systèmes IA sont le produit de nombreuses décisions prises par ceux qui les développent et les déploient. De l’objectif système à la façon dont les personnes interagissent avec les systèmes IA, l’IA responsable peut aider à guider de manière proactive ces décisions vers des résultats plus bénéfiques et équitables. Cela signifie maintenir les personnes et leurs objectifs au centre des décisions de conception du système et respecter les valeurs durables telles que l’équité, la fiabilité et la transparence.

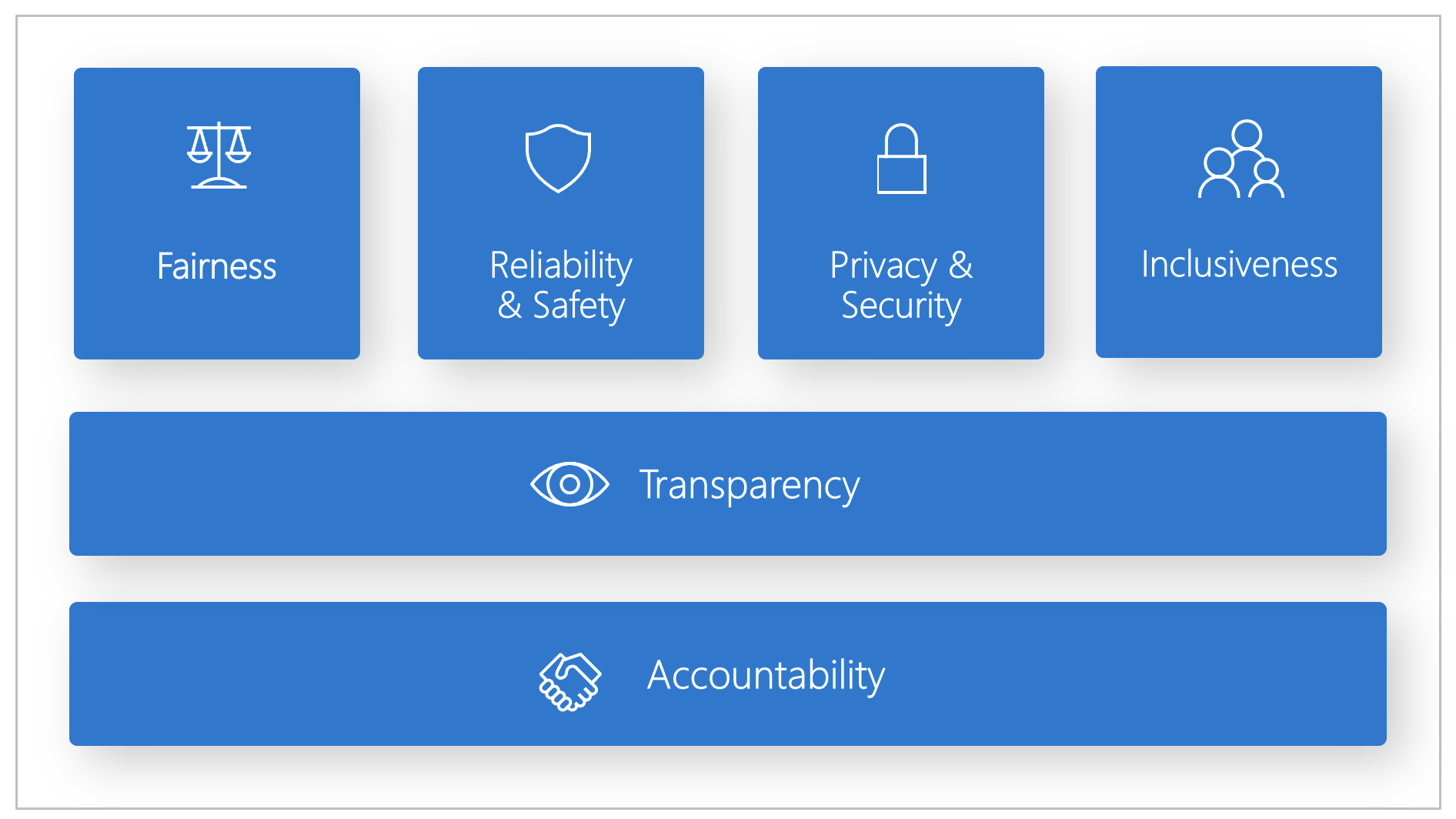

Microsoft a développé un Standard d’IA responsable. Il s’agit d’un cadre permettant de créer des systèmes d’IA selon six principes : équité, fiabilité/sécurité, confidentialité/sécurité, inclusivité, transparence et responsabilité. Pour Microsoft, ces principes sont la pierre angulaire d’une approche responsable et digne de confiance de l’IA, d’autant plus que celle-ci devient plus présente dans les produits et services que les gens utilisent tous les jours.

Cet article montre comment Azure Machine Learning prend en charge les outils permettant aux développeurs et aux scientifiques des données d’implémenter et de mettre en œuvre les six principes.

Équité et inclusivité

Les systèmes d’intelligence artificielle doivent traiter chacun de manière équitable et éviter d’affecter des groupes de personnes à la situation similaire de différentes façons. Par exemple, quand les systèmes d’intelligence artificielle fournissent des conseils sur les soins médicaux, les demandes de prêt ou l’emploi, ils devraient faire les mêmes suggestions à toutes les personnes présentant des symptômes, des situations financières ou des qualifications professionnelles similaires.

Équité et inclusivité dans Azure Machine Learning : le composant d’évaluation de l’équité du tableau de bord d’IA responsable permet aux scientifiques des données et aux développeurs ML d’évaluer l’équité des modèles parmi des groupes sensibles définis en termes de sexe, d’origine ethnique, d’âge et d’autres caractéristiques.

Fiabilité et sécurité

Pour favoriser la confiance, il est essentiel que les systèmes d’IA fonctionnent de manière sécurisée, fiable et cohérente. Ces systèmes doivent être en mesure de fonctionner comme prévu lors de leur conception, de répondre en toute sécurité aux conditions inattendues et de résister aux manipulations dangereuses. Leur comportement ainsi que la diversité des conditions qu’ils peuvent gérer reflètent l’éventail de situations et de circonstances que les développeurs anticipent au cours de la conception et du test.

Fiabilité et sécurité dans Azure Machine Learning : le composant d’analyse des erreurs du tableau de bord de l’IA responsable permet aux scientifiques des données et aux développeurs :

- De comprendre de manière approfondie comment l’échec est distribué pour un modèle

- D’identifier les cohortes (sous-ensembles) de données avec un taux d’erreur supérieur au taux d’erreur de référence global

Ces écarts peuvent se produire quand le système ou le modèle sous-performe pour des groupes démographiques spécifiques ou pour des conditions d’entrée rarement observées dans les données d’entraînement.

Transparence

Quand des systèmes d’IA aident à la prise de décisions qui ont un impact considérable sur nos vies, il est essentiel que les personnes comprennent comment ces décisions ont été prises. Par exemple, une banque peut utiliser un système d’IA pour décider si une personne est solvable. Une société peut utiliser un système d’IA pour déterminer les candidats les plus qualifiés à l’embauche.

L’interprétabilité (ou explication utile du comportement des systèmes d’intelligence artificielle et de leurs composants) est une composante essentielle de la transparence. Pour améliorer l’interprétabilité, il faut que les parties prenantes comprennent comment et pourquoi les systèmes d’IA fonctionnent de la manière dont ils le font. Les parties prenantes peuvent ensuite identifier les problèmes potentiels de performance, d’équité, de pratiques d’exclusion ou de résultats involontaires.

Transparence dans Azure Machine Learning : les composants d’interprétabilité de modèle et de simulation contrefactuelle du tableau de bord d’IA responsable permettent aux scientifiques des données et aux développeurs de générer des descriptions compréhensibles par l’homme des prédictions d’un modèle.

Le composant d’interprétabilité du modèle fournit plusieurs vues du comportement d’un modèle :

- Explications globales. Par exemple, quelles caractéristiques affectent le comportement général d’un modèle d’allocation de prêt ?

- Explications locales. Par exemple, pourquoi la demande de prêt d’un client a été approuvée ou rejetée ?

- Explications de modèle pour une cohorte sélectionnée de points de données. Par exemple, quelles caractéristiques affectent le comportement global d’un modèle d’allocation de prêt pour les demandeurs à faible revenu ?

De plus, le composant de simulation contrefactuelle permet de comprendre et de déboguer un modèle Machine Learning en fonction de la façon dont il réagit aux changements et aux perturbations des caractéristiques.

Azure Machine Learning prend également en charge un tableau de bord d’IA responsable. Il s’agit d’un rapport PDF personnalisable que les développeurs peuvent facilement configurer, générer, télécharger et partager avec leurs partenaires techniques et non techniques pour les informer sur la santé de leurs ensembles de données et de leurs modèles, assurer la conformité et instaurer la confiance. Ce tableau de bord peut également être utilisé dans les examens d’audit pour découvrir les caractéristiques des modèles de Machine Learning.

Confidentialité et sécurité

À mesure que l’intelligence artificielle se répand, la protection de la confidentialité et la sécurisation des informations personnelles et professionnelles représentent des tâches toujours plus complexes et importantes. Avec l’intelligence artificielle, la confidentialité et la sécurité des données nécessitent une attention particulière, car l’accès aux données est essentiel pour que les systèmes d’intelligence artificielle puissent effectuer des prévisions et des décisions sur les personnes qui soient précises et fondées. Les systèmes d’IA doivent respecter les lois relatives à la confidentialité qui :

- Exigent une transparence sur la collecte, l’utilisation et le stockage des données.

- Imposent que les consommateurs disposent de contrôles appropriés pour choisir la façon dont leurs données sont utilisées.

Confidentialité et sécurité dans Azure Machine Learning : Azure Machine Learning permet aux administrateurs et aux développeurs de créer une configuration sécurisée conforme aux stratégies de leurs entreprises. Azure Machine Learning et la plateforme Azure permettent aux utilisateurs d’effectuer les opérations suivantes :

- Limiter l’accès aux ressources et aux opérations par compte d’utilisateur ou par groupe.

- Limiter les communications réseau entrantes et sortantes.

- Chiffrer des données en transit et au repos.

- Analyser les vulnérabilités.

- Appliquer et auditer des stratégies de configuration.

Microsoft a également créé deux packages open source qui peuvent permettre une implémentation plus poussée des principes de confidentialité et de sécurité :

SmartNoise : La confidentialité différentielle est un ensemble de systèmes et pratiques qui permettent de préserver la sécurité et la confidentialité des données des personnes. Dans les solutions de Machine Learning, une confidentialité différentielle peut être requise en lien avec la conformité réglementaire. SmartNoise est un projet open source (co-développé par Microsoft) contenant des composants pour la création de systèmes globaux assortis d’une confidentialité différentielle.

Counterfit : Counterfit est un projet open-source qui comprend un outil en ligne de commande et une couche d’automatisation générique pour permettre aux développeurs de simuler des cyber-attaques contre des systèmes d’IA. Tout le monde peut télécharger l’outil et le déployer par le biais d’Azure Cloud Shell pour une exécution dans un navigateur ou le déployer localement dans un environnement Anaconda Python. Il peut évaluer les modèles IA hébergés dans différents environnements cloud, locaux ou en périphérie. L’outil est agnostique aux modèles IA et prend en charge différents types de données, notamment du texte, des images ou des entrées génériques.

Responsabilité

Les personnes qui conçoivent et déploient des systèmes IA doivent être responsables de leur fonctionnement. Les organisations doivent s’inspirer des standards du secteur pour développer des normes de responsabilité. Ces normes peuvent garantir que les systèmes d’IA n’ont pas le dernier mot sur toute décision ayant une incidence sur la vie de personnes. Elles peuvent également garantir que les humains gardent un contrôle significatif sur les systèmes d’IA autrement très autonomes.

Responsabilité dans Azure Machine Learning : MLOps (Machine Learning Operations) est basé sur des principes et des pratiques DevOps qui accroissent l’efficacité des workflows d’IA. Azure Machine Learning fournit les fonctionnalités MLOps suivantes pour améliorer la responsabilité de vos systèmes IA :

- Inscrire, empaqueter et déployer des modèles à partir de n’importe quel emplacement. Vous pouvez également suivre les métadonnées associées requises pour utiliser le modèle.

- Capturer les données de gouvernance nécessaires pour le cycle de vie Machine Learning de bout en bout. Les informations de traçabilité journalisées peuvent inclure qui publie des modèles, pourquoi des modifications ont été apportées et quand les modèles ont été déployés ou utilisés en production.

- Notifier et alerter sur des événements du cycle de vie Machine Learning. Par exemple, la fin d’une expérience, l’inscription de modèles, le déploiement de modèles et la détection d’une dérive de données.

- Superviser les applications pour déterminer si elles sont affectées par des problèmes opérationnels ou liés au Machine Learning. Comparer les entrées de modèle entre l’apprentissage et l’inférence, explorer les métriques spécifiques du modèle, et fournir une surveillance et des alertes pour votre infrastructure d’apprentissage automatique.

Outre les fonctionnalités MLOps, le tableau de bord d’IA responsable dans Azure Machine Learning crée une responsabilité en autorisant les communications entre parties prenantes. Le tableau de bord crée également une responsabilité en permettant aux développeurs de configurer, télécharger et partager leurs insights d’intégrité de modèle avec leurs parties prenantes techniques et non techniques au sujet de l’intégrité des données et du modèle d’IA. Le partage de ces insights peut aider à générer de la confiance.

La plateforme Machine Learning autorise également la prise de décisions en alimentant les décisions métier par le biais :

- D’insights basés sur des données pour aider les parties prenantes à comprendre les effets causaux du traitement sur un résultat, en utilisant uniquement des données historiques. Par exemple, « Quel serait l’impact d’un médicament sur la pression artérielle d’un patient ? ». Ces insights sont fournis par le biais du composant d’inférence causale du tableau de bord d’IA responsable.

- D’insights basés sur des modèles, afin de répondre aux questions des utilisateurs (telles que « Que puis-je faire pour obtenir un résultat différent de votre IA la prochaine fois ? ») afin qu’ils puissent entreprendre une action. Ces informations sont fournies aux scientifiques des données par le biais du composant de simulation contrefactuelle du tableau de bord d’IA responsable.

Étapes suivantes

- Pour plus d’informations sur la façon d’implémenter l’IA responsable dans Azure Machine Learning, consultez Tableau de bord d’IA responsable.

- Découvrez comment générer le tableau de bord d’IA responsable par le biais de CLIv2 et SDKv2 ou de l’interface utilisateur d’Azure Machine Learning studio.

- Découvrez comment générer une carte de performance d’IA responsable basée sur des insights observées dans votre tableau de bord d’IA responsable.

- Découvrez le standard d’IA responsable pour créer des systèmes d’IA répondant à six principes clés.