Migrer des configurations Spark d’Azure Synapse Analytics vers Fabric

Apache Spark fournit de nombreuses configurations qui peuvent être personnalisées pour améliorer l’expérience dans différents scénarios. Dans Azure Synapse Spark et l’engineering données Fabric, vous avez la possibilité d’incorporer ces configurations ou propriétés pour personnaliser votre expérience. Dans Fabric, vous pouvez ajouter des configurations Spark à un environnement et utiliser des propriétés Spark incluses directement dans vos tâches Spark. Pour déplacer des configurations de pool Spark d’Azure Synapse vers Fabric, utilisez un environnement.

Pour plus d’informations sur la configuration de Spark, consultez les différences entre Azure Synapse Spark et Fabric.

Prérequis

- Si vous n’en avez pas encore, créez un espace de travail Fabric dans votre locataire.

- Si vous n’en avez pas encore, créez un Environnement dans votre espace de travail.

Option 1 : Ajouter des configurations Spark à un environnement personnalisé

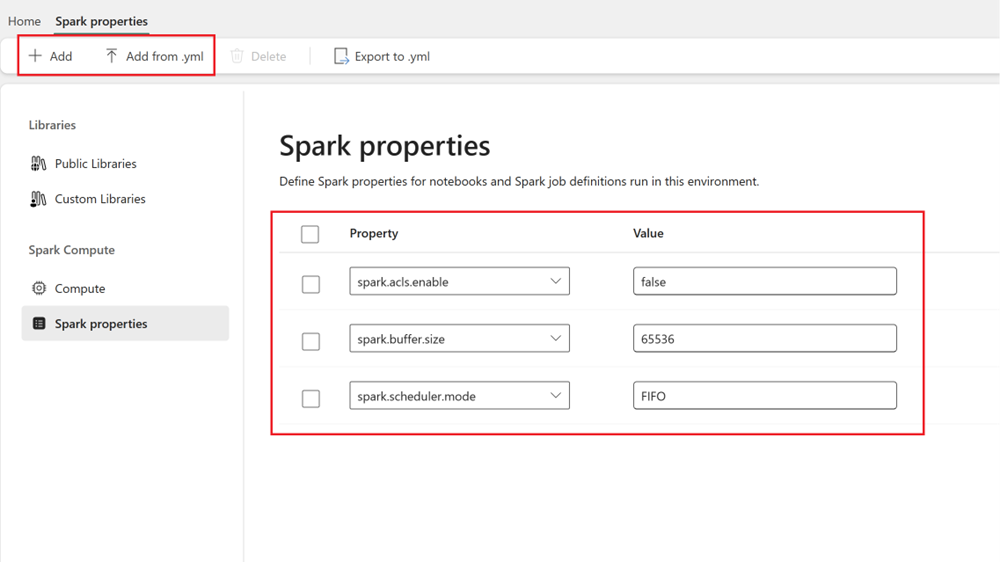

Dans un environnement, vous pouvez définir des propriétés Spark et ces configurations sont appliquées au pool d’environnements sélectionné.

- Ouvrez Synapse Studio : connectez-vous à Azure. Accédez à votre espace de travail Azure Synapse et ouvrez Synapse Studio.

- Repérez les configurations Spark :

- Accédez à la zone Gérer, puis sélectionnez pools Apache Spark.

- Trouvez le pool Apache Spark, sélectionnez Configuration Apache Spark et repérez le nom de configuration Spark pour le pool.

- Obtenir des configurations Spark : vous pouvez obtenir ces propriétés en sélectionnant Afficher les configurations ou en exportant la configuration (format .txt/.conf/.json) à partir de Configurations + bibliothèques>Configurations Apache Spark.

- Une fois que vous avez des configurations Spark, ajoutez des propriétés Spark personnalisées à votre environnement dans Fabric :

- Dans l’environnement, accédez à Calcul Spark>Propriétés Spark.

- Ajoutez des configurations Spark. Vous pouvez ajouter chaque fichier manuellement ou les importer à partir de .yml.

- Cliquez sur Enregistrer et Publier les modifications.

En savoir plus sur l’ajout de configurations Spark à un environnement.