API GPT-4o Realtime per la voce e l'audio (anteprima)

Nota

Questa funzionalità è attualmente in anteprima pubblica. Questa anteprima viene fornita senza un contratto di servizio e non è consigliabile per i carichi di lavoro di produzione. Alcune funzionalità potrebbero non essere supportate o potrebbero presentare funzionalità limitate. Per altre informazioni, vedere le Condizioni supplementari per l'uso delle anteprime di Microsoft Azure.

L'API GPT-4o in tempo reale di Azure OpenAI per il riconoscimento vocale e l'audio fa parte della famiglia di modelli GPT-4o che supporta interazioni conversazionali a bassa latenza, "riconoscimento vocale, riconoscimento vocale". L'API audio realtime GPT-4o è progettata per gestire interazioni conversazionali in tempo reale e a bassa latenza, rendendola ideale per i casi d'uso che coinvolgono interazioni live tra un utente e un modello, ad esempio agenti di supporto clienti, assistenti vocali e traduttori in tempo reale.

La maggior parte degli utenti dell'API Realtime deve distribuire e ricevere audio da un utente finale in tempo reale, incluse le applicazioni che usano WebRTC o un sistema di telefonia. L'API Realtime non è progettata per connettersi direttamente ai dispositivi degli utenti finali e si basa sulle integrazioni client per terminare i flussi audio dell'utente finale.

Modelli supportati

Attualmente solo gpt-4o-realtime-preview versione: 2024-10-01-preview supporta l'audio in tempo reale.

Il gpt-4o-realtime-preview modello è disponibile per le distribuzioni globali nelle aree Stati Uniti orientali 2 e Svezia centrale.

Importante

Il sistema archivia le richieste e i completamenti, come descritto nella sezione "Utilizzo dati e accesso per il monitoraggio degli abusi" delle Condizioni di prodotto specifiche del servizio per il servizio Azure OpenAI, ad eccezione del fatto che l'eccezione limitata non è applicabile. Il monitoraggio degli abusi verrà attivato per l'uso dell'API gpt-4o-realtime-preview anche per i clienti che altrimenti sono approvati per il monitoraggio degli abusi modificati.

Supporto dell'API

Il supporto per l'API Realtime è stato aggiunto per la prima volta nella versione 2024-10-01-previewdell'API .

Nota

Per altre informazioni sull'API e sull'architettura, vedere il repository audio in tempo reale OpenAI GPT-4o di Azure su GitHub.

Distribuire un modello per l'audio in tempo reale

Per distribuire il gpt-4o-realtime-preview modello nel portale di Azure AI Foundry:

- Passare al portale di Azure AI Foundry e assicurarsi di aver eseguito l'accesso con la sottoscrizione di Azure con la risorsa del servizio Azure OpenAI (con o senza distribuzioni di modelli).

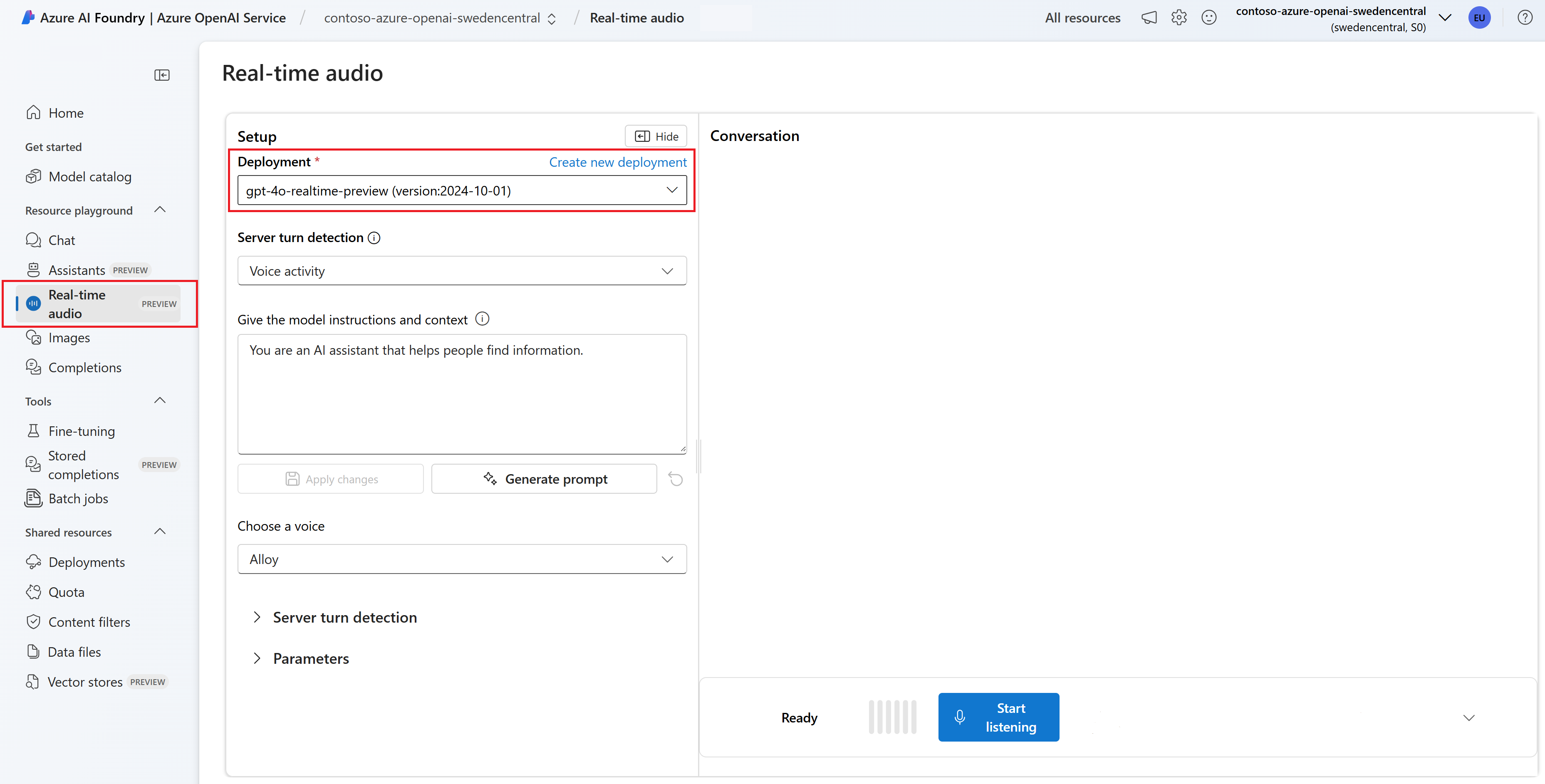

- Selezionare il playground audio in tempo reale in Playgrounds (Playground) nel riquadro sinistro.

- Selezionare Crea nuova distribuzione per aprire la finestra di distribuzione.

- Cercare e selezionare il

gpt-4o-realtime-previewmodello e quindi selezionare Conferma. - Nella distribuzione guidata assicurarsi di selezionare la versione del

2024-10-01modello. - Seguire la procedura guidata per completare la distribuzione del modello.

Ora che è disponibile una distribuzione del gpt-4o-realtime-preview modello, è possibile interagire con esso in tempo reale nel portale di Azure AI Foundry Playground audio in tempo reale o nell'API In tempo reale.

Usare l'audio in tempo reale GPT-4o

Per chattare con il modello distribuito gpt-4o-realtime-preview nel playground audio in tempo reale di Azure AI Foundry, seguire questa procedura:

Passare alla pagina servizio Azure OpenAI nel portale di Azure AI Foundry. Assicurarsi di aver eseguito l'accesso con la sottoscrizione di Azure con la risorsa del servizio Azure OpenAI e il modello distribuito

gpt-4o-realtime-preview.Selezionare il playground audio in tempo reale in Playgrounds (Playground) nel riquadro sinistro.

Selezionare il modello distribuito

gpt-4o-realtime-previewdall'elenco a discesa Distribuzione .Selezionare Abilita microfono per consentire al browser di accedere al microfono. Se è già stata concessa l'autorizzazione, è possibile ignorare questo passaggio.

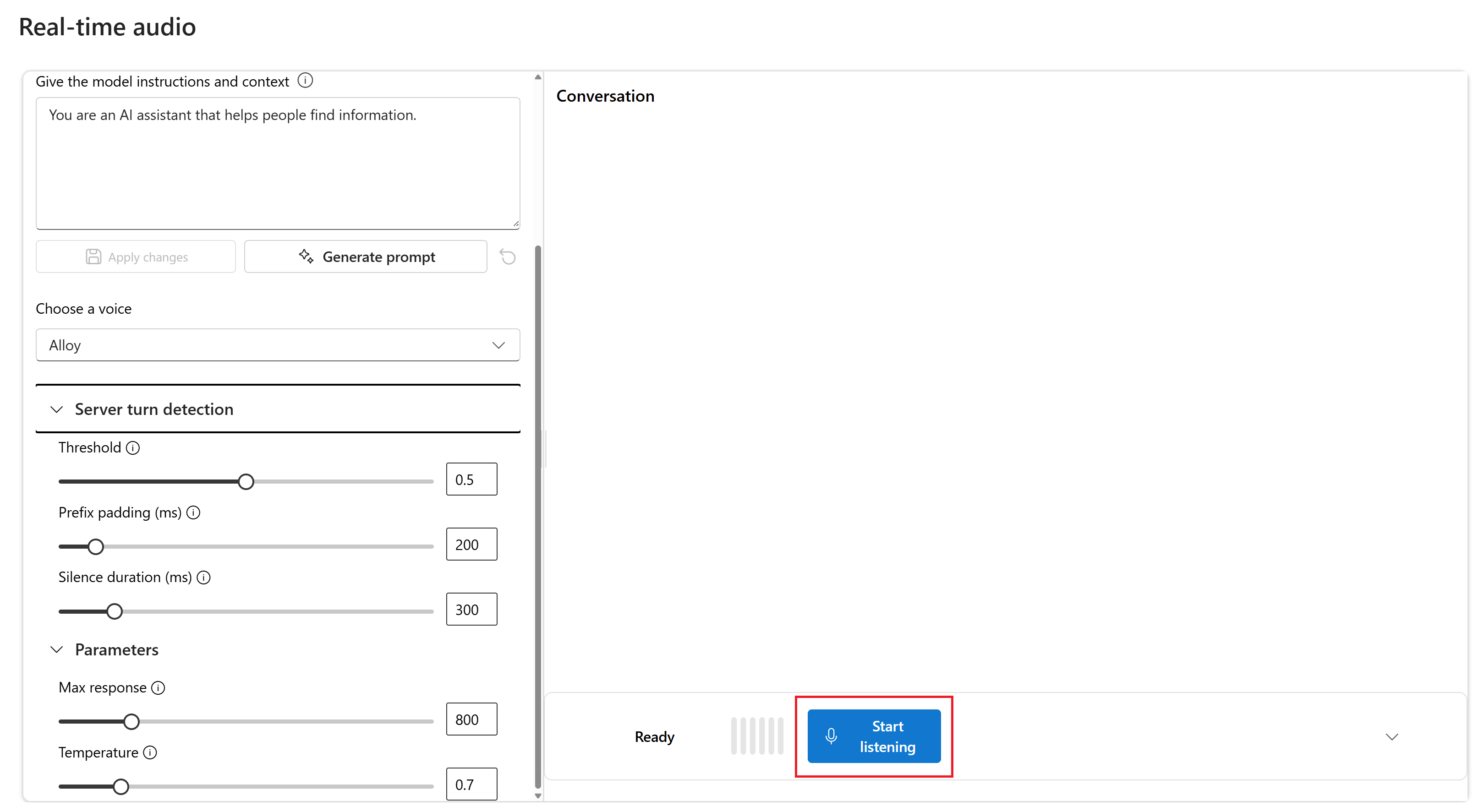

Facoltativamente, è possibile modificare il contenuto nella casella di testo Fornire le istruzioni del modello e il contesto . Fornire al modello le istruzioni sul comportamento e su qualsiasi contesto a cui deve fare riferimento durante la generazione di una risposta. È possibile descrivere la personalità dell'assistente, definire cosa deve e non deve rispondere e come formattare le risposte.

Facoltativamente, modificare le impostazioni, ad esempio soglia, riempimento del prefisso e durata del silenzio.

Selezionare Avvia ascolto per avviare la sessione. Puoi parlare con il microfono per avviare una chat.

Puoi interrompere la chat in qualsiasi momento parlando. È possibile terminare la chat selezionando il pulsante Arresta ascolto .

Prerequisiti

- Una sottoscrizione di Azure: creare un account gratuitamente

- Node.js supporto LTS o ESM.

- Una risorsa OpenAI di Azure creata nelle aree Stati Uniti orientali 2 o Svezia centrale. Vedere Disponibilità a livello di area.

- È quindi necessario distribuire un

gpt-4o-realtime-previewmodello con la risorsa OpenAI di Azure. Per altre informazioni, vedere Creare una risorsa e distribuire un modello con Azure OpenAI.

Prerequisiti di Microsoft Entra ID

Per l'autenticazione senza chiave consigliata con Microsoft Entra ID, è necessario:

- Installare l'interfaccia della riga di comando di Azure usata per l'autenticazione senza chiave con Microsoft Entra ID.

- Assegnare il ruolo

Cognitive Services Userall'account utente. È possibile assegnare ruoli nella portale di Azure in Controllo di accesso (IAM)>Aggiungere un'assegnazione di ruolo.

Distribuire un modello per l'audio in tempo reale

Per distribuire il gpt-4o-realtime-preview modello nel portale di Azure AI Foundry:

- Passare al portale di Azure AI Foundry e assicurarsi di aver eseguito l'accesso con la sottoscrizione di Azure con la risorsa del servizio Azure OpenAI (con o senza distribuzioni di modelli).

- Selezionare il playground audio in tempo reale in Playgrounds (Playground) nel riquadro sinistro.

- Selezionare Crea nuova distribuzione per aprire la finestra di distribuzione.

- Cercare e selezionare il

gpt-4o-realtime-previewmodello e quindi selezionare Conferma. - Nella distribuzione guidata assicurarsi di selezionare la versione del

2024-10-01modello. - Seguire la procedura guidata per completare la distribuzione del modello.

Ora che è disponibile una distribuzione del gpt-4o-realtime-preview modello, è possibile interagire con esso in tempo reale nel portale di Azure AI Foundry Playground audio in tempo reale o nell'API In tempo reale.

Impostazione

Creare una nuova cartella

realtime-audio-quickstartper contenere l'applicazione e aprire Visual Studio Code in tale cartella con il comando seguente:mkdir realtime-audio-quickstart && code realtime-audio-quickstartpackage.jsonCreare con il comando seguente:npm init -yAggiornare in

package.jsonECMAScript con il comando seguente:npm pkg set type=moduleInstallare la libreria client audio in tempo reale per JavaScript con:

npm install https://github.com/Azure-Samples/aoai-realtime-audio-sdk/releases/download/js/v0.5.2/rt-client-0.5.2.tgzPer l'autenticazione senza chiave consigliata con Microsoft Entra ID, installare il

@azure/identitypacchetto con:npm install @azure/identity

Recuperare le informazioni sulle risorse

È necessario recuperare le informazioni seguenti per autenticare l'applicazione con la risorsa OpenAI di Azure:

| Nome variabile | Valore |

|---|---|

AZURE_OPENAI_ENDPOINT |

Questo valore è disponibile nella sezione Chiavi ed endpoint quando si esamina la risorsa dal portale di Azure. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Questo valore corrisponderà al nome personalizzato scelto per la distribuzione quando è stato distribuito un modello. Questo valore è disponibile in Distribuzioni di modelli di gestione>risorse nella portale di Azure. |

OPENAI_API_VERSION |

Altre informazioni sulle versioni api. |

Altre informazioni sull'autenticazione senza chiave e sull'impostazione delle variabili di ambiente.

Attenzione

Per usare l'autenticazione senza chiave consigliata con l'SDK, assicurarsi che la AZURE_OPENAI_API_KEY variabile di ambiente non sia impostata.

Testo in uscita audio

Creare il

text-in-audio-out.jsfile con il codice seguente:import { DefaultAzureCredential } from "@azure/identity"; import { LowLevelRTClient } from "rt-client"; import dotenv from "dotenv"; dotenv.config(); async function text_in_audio_out() { // Set environment variables or edit the corresponding values here. const endpoint = process.env["AZURE_OPENAI_ENDPOINT"] || "yourEndpoint"; const deployment = "gpt-4o-realtime-preview"; if (!endpoint || !deployment) { throw new Error("You didn't set the environment variables."); } const client = new LowLevelRTClient(new URL(endpoint), new DefaultAzureCredential(), { deployment: deployment }); try { await client.send({ type: "response.create", response: { modalities: ["audio", "text"], instructions: "Please assist the user." } }); for await (const message of client.messages()) { switch (message.type) { case "response.done": { break; } case "error": { console.error(message.error); break; } case "response.audio_transcript.delta": { console.log(`Received text delta: ${message.delta}`); break; } case "response.audio.delta": { const buffer = Buffer.from(message.delta, "base64"); console.log(`Received ${buffer.length} bytes of audio data.`); break; } } if (message.type === "response.done" || message.type === "error") { break; } } } finally { client.close(); } } await text_in_audio_out();Accedere ad Azure con il comando seguente:

az loginEseguire il file JavaScript.

node text-in-audio-out.js

Attendere qualche istante per ottenere la risposta.

Output

Lo script ottiene una risposta dal modello e stampa la trascrizione e i dati audio ricevuti.

L'output sarà simile al seguente:

Received text delta: Hello

Received text delta: !

Received text delta: How

Received text delta: can

Received text delta: I

Received 4800 bytes of audio data.

Received 7200 bytes of audio data.

Received text delta: help

Received 12000 bytes of audio data.

Received text delta: you

Received text delta: today

Received text delta: ?

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 24000 bytes of audio data.

Esempio di applicazione Web

L'esempio Web JavaScript su GitHub illustra come usare l'API GPT-4o Realtime per interagire con il modello in tempo reale. Il codice di esempio include una semplice interfaccia Web che acquisisce l'audio dal microfono dell'utente e lo invia al modello per l'elaborazione. Il modello risponde con testo e audio, che il codice di esempio esegue il rendering nell'interfaccia Web.

È possibile eseguire il codice di esempio in locale nel computer seguendo questa procedura. Per le istruzioni più aggiornate, vedere il repository in GitHub .

Se non è installato Node.js, scaricare e installare la versione LTS di Node.js.

Clonare il repository nel computer locale:

git clone https://github.com/Azure-Samples/aoai-realtime-audio-sdk.gitPassare alla cartella nell'editor

javascript/samples/webdi codice preferito.cd ./javascript/samplesEseguire

download-pkg.ps1odownload-pkg.shper scaricare i pacchetti necessari.Passare alla

webcartella dalla./javascript/samplescartella .cd ./webEseguire

npm installper installare le dipendenze dei pacchetti.Eseguire

npm run devper avviare il server Web, spostandosi in qualsiasi richiesta di autorizzazioni del firewall in base alle esigenze.Passare a uno degli URI forniti dall'output della console (ad esempio

http://localhost:5173/) in un browser.Immettere le informazioni seguenti nell'interfaccia Web:

- Endpoint: endpoint della risorsa di una risorsa OpenAI di Azure. Non è necessario aggiungere il

/realtimepercorso. Una struttura di esempio potrebbe esserehttps://my-azure-openai-resource-from-portal.openai.azure.com. - Chiave API: chiave API corrispondente per la risorsa OpenAI di Azure.

- Distribuzione: nome del

gpt-4o-realtime-previewmodello distribuito nella sezione precedente. - Messaggio di sistema: facoltativamente, è possibile fornire un messaggio di sistema come "Si parla sempre come un pirata amichevole".

- Temperatura: facoltativamente, è possibile fornire una temperatura personalizzata.

- Voce: facoltativamente, è possibile selezionare una voce.

- Endpoint: endpoint della risorsa di una risorsa OpenAI di Azure. Non è necessario aggiungere il

Selezionare il pulsante Registra per avviare la sessione. Accettare le autorizzazioni per usare il microfono, se richiesto.

Verrà visualizzato un

<< Session Started >>messaggio nell'output principale. Poi puoi parlare con il microfono per avviare una chat.Puoi interrompere la chat in qualsiasi momento parlando. È possibile terminare la chat selezionando il pulsante Arresta .

Prerequisiti

- Una sottoscrizione di Azure. Crearne una gratuitamente.

- Python 3.8 o versioni successive. È consigliabile usare Python 3.10 o versione successiva; è comunque necessario avere almeno Python 3.8. Se non è installata una versione appropriata di Python, seguire le istruzioni riportate in Esercitazione di Vs Code Python, che descrive il modo più semplice per installare Python nel sistema operativo.

- Una risorsa OpenAI di Azure creata nelle aree Stati Uniti orientali 2 o Svezia centrale. Vedere Disponibilità a livello di area.

- È quindi necessario distribuire un

gpt-4o-realtime-previewmodello con la risorsa OpenAI di Azure. Per altre informazioni, vedere Creare una risorsa e distribuire un modello con Azure OpenAI.

Prerequisiti di Microsoft Entra ID

Per l'autenticazione senza chiave consigliata con Microsoft Entra ID, è necessario:

- Installare l'interfaccia della riga di comando di Azure usata per l'autenticazione senza chiave con Microsoft Entra ID.

- Assegnare il ruolo

Cognitive Services Userall'account utente. È possibile assegnare ruoli nella portale di Azure in Controllo di accesso (IAM)>Aggiungere un'assegnazione di ruolo.

Distribuire un modello per l'audio in tempo reale

Per distribuire il gpt-4o-realtime-preview modello nel portale di Azure AI Foundry:

- Passare al portale di Azure AI Foundry e assicurarsi di aver eseguito l'accesso con la sottoscrizione di Azure con la risorsa del servizio Azure OpenAI (con o senza distribuzioni di modelli).

- Selezionare il playground audio in tempo reale in Playgrounds (Playground) nel riquadro sinistro.

- Selezionare Crea nuova distribuzione per aprire la finestra di distribuzione.

- Cercare e selezionare il

gpt-4o-realtime-previewmodello e quindi selezionare Conferma. - Nella distribuzione guidata assicurarsi di selezionare la versione del

2024-10-01modello. - Seguire la procedura guidata per completare la distribuzione del modello.

Ora che è disponibile una distribuzione del gpt-4o-realtime-preview modello, è possibile interagire con esso in tempo reale nel portale di Azure AI Foundry Playground audio in tempo reale o nell'API In tempo reale.

Impostazione

Creare una nuova cartella

realtime-audio-quickstartper contenere l'applicazione e aprire Visual Studio Code in tale cartella con il comando seguente:mkdir realtime-audio-quickstart && code realtime-audio-quickstartCreare un ambiente virtuale. Se Python 3.10 o versione successiva è già installato, è possibile creare un ambiente virtuale usando i comandi seguenti:

L'attivazione dell'ambiente Python implica che quando si esegue

pythonopipdalla riga di comando, si usa l'interprete Python contenuto nella cartella.venvdell'applicazione. Per uscire dall'ambiente virtuale Python è possibile usare il comandodeactivate. Potrà poi essere riattivato successivamente, quando necessario.Suggerimento

È consigliabile creare e attivare un nuovo ambiente Python da usare per installare i pacchetti necessari per questa esercitazione. Non installare pacchetti nell'installazione globale di Python. È consigliabile usare sempre un ambiente virtuale o conda durante l'installazione di pacchetti Python. In caso contrario, è possibile interrompere l'installazione globale di Python.

Installare la libreria client audio in tempo reale per Python con:

pip install "https://github.com/Azure-Samples/aoai-realtime-audio-sdk/releases/download/py%2Fv0.5.3/rtclient-0.5.3.tar.gz"Per l'autenticazione senza chiave consigliata con Microsoft Entra ID, installare il

azure-identitypacchetto con:pip install azure-identity

Recuperare le informazioni sulle risorse

È necessario recuperare le informazioni seguenti per autenticare l'applicazione con la risorsa OpenAI di Azure:

| Nome variabile | Valore |

|---|---|

AZURE_OPENAI_ENDPOINT |

Questo valore è disponibile nella sezione Chiavi ed endpoint quando si esamina la risorsa dal portale di Azure. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Questo valore corrisponderà al nome personalizzato scelto per la distribuzione quando è stato distribuito un modello. Questo valore è disponibile in Distribuzioni di modelli di gestione>risorse nella portale di Azure. |

OPENAI_API_VERSION |

Altre informazioni sulle versioni api. |

Altre informazioni sull'autenticazione senza chiave e sull'impostazione delle variabili di ambiente.

Testo in uscita audio

Creare il

text-in-audio-out.pyfile con il codice seguente:import base64 import asyncio from azure.identity.aio import DefaultAzureCredential from rtclient import ( ResponseCreateMessage, RTLowLevelClient, ResponseCreateParams ) # Set environment variables or edit the corresponding values here. endpoint = os.environ["AZURE_OPENAI_ENDPOINT"] deployment = "gpt-4o-realtime-preview" async def text_in_audio_out(): async with RTLowLevelClient( url=endpoint, azure_deployment=deployment, token_credential=DefaultAzureCredential(), ) as client: await client.send( ResponseCreateMessage( response=ResponseCreateParams( modalities={"audio", "text"}, instructions="Please assist the user." ) ) ) done = False while not done: message = await client.recv() match message.type: case "response.done": done = True case "error": done = True print(message.error) case "response.audio_transcript.delta": print(f"Received text delta: {message.delta}") case "response.audio.delta": buffer = base64.b64decode(message.delta) print(f"Received {len(buffer)} bytes of audio data.") case _: pass async def main(): await text_in_audio_out() asyncio.run(main())Eseguire il file Python.

python text-in-audio-out.py

Attendere qualche istante per ottenere la risposta.

Output

Lo script ottiene una risposta dal modello e stampa la trascrizione e i dati audio ricevuti.

L'output sarà simile al seguente:

Received text delta: Hello

Received text delta: !

Received text delta: How

Received 4800 bytes of audio data.

Received 7200 bytes of audio data.

Received text delta: can

Received 12000 bytes of audio data.

Received text delta: I

Received text delta: assist

Received text delta: you

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received text delta: today

Received text delta: ?

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 28800 bytes of audio data.

Prerequisiti

- Una sottoscrizione di Azure: creare un account gratuitamente

- Node.js supporto LTS o ESM.

- TypeScript installato a livello globale.

- Una risorsa OpenAI di Azure creata nelle aree Stati Uniti orientali 2 o Svezia centrale. Vedere Disponibilità a livello di area.

- È quindi necessario distribuire un

gpt-4o-realtime-previewmodello con la risorsa OpenAI di Azure. Per altre informazioni, vedere Creare una risorsa e distribuire un modello con Azure OpenAI.

Prerequisiti di Microsoft Entra ID

Per l'autenticazione senza chiave consigliata con Microsoft Entra ID, è necessario:

- Installare l'interfaccia della riga di comando di Azure usata per l'autenticazione senza chiave con Microsoft Entra ID.

- Assegnare il ruolo

Cognitive Services Userall'account utente. È possibile assegnare ruoli nella portale di Azure in Controllo di accesso (IAM)>Aggiungere un'assegnazione di ruolo.

Distribuire un modello per l'audio in tempo reale

Per distribuire il gpt-4o-realtime-preview modello nel portale di Azure AI Foundry:

- Passare al portale di Azure AI Foundry e assicurarsi di aver eseguito l'accesso con la sottoscrizione di Azure con la risorsa del servizio Azure OpenAI (con o senza distribuzioni di modelli).

- Selezionare il playground audio in tempo reale in Playgrounds (Playground) nel riquadro sinistro.

- Selezionare Crea nuova distribuzione per aprire la finestra di distribuzione.

- Cercare e selezionare il

gpt-4o-realtime-previewmodello e quindi selezionare Conferma. - Nella distribuzione guidata assicurarsi di selezionare la versione del

2024-10-01modello. - Seguire la procedura guidata per completare la distribuzione del modello.

Ora che è disponibile una distribuzione del gpt-4o-realtime-preview modello, è possibile interagire con esso in tempo reale nel portale di Azure AI Foundry Playground audio in tempo reale o nell'API In tempo reale.

Impostazione

Creare una nuova cartella

realtime-audio-quickstartper contenere l'applicazione e aprire Visual Studio Code in tale cartella con il comando seguente:mkdir realtime-audio-quickstart && code realtime-audio-quickstartpackage.jsonCreare con il comando seguente:npm init -yAggiornare in

package.jsonECMAScript con il comando seguente:npm pkg set type=moduleInstallare la libreria client audio in tempo reale per JavaScript con:

npm install https://github.com/Azure-Samples/aoai-realtime-audio-sdk/releases/download/js/v0.5.2/rt-client-0.5.2.tgzPer l'autenticazione senza chiave consigliata con Microsoft Entra ID, installare il

@azure/identitypacchetto con:npm install @azure/identity

Recuperare le informazioni sulle risorse

È necessario recuperare le informazioni seguenti per autenticare l'applicazione con la risorsa OpenAI di Azure:

| Nome variabile | Valore |

|---|---|

AZURE_OPENAI_ENDPOINT |

Questo valore è disponibile nella sezione Chiavi ed endpoint quando si esamina la risorsa dal portale di Azure. |

AZURE_OPENAI_DEPLOYMENT_NAME |

Questo valore corrisponderà al nome personalizzato scelto per la distribuzione quando è stato distribuito un modello. Questo valore è disponibile in Distribuzioni di modelli di gestione>risorse nella portale di Azure. |

OPENAI_API_VERSION |

Altre informazioni sulle versioni api. |

Altre informazioni sull'autenticazione senza chiave e sull'impostazione delle variabili di ambiente.

Attenzione

Per usare l'autenticazione senza chiave consigliata con l'SDK, assicurarsi che la AZURE_OPENAI_API_KEY variabile di ambiente non sia impostata.

Testo in uscita audio

Creare il

text-in-audio-out.tsfile con il codice seguente:import { DefaultAzureCredential } from "@azure/identity"; import { LowLevelRTClient } from "rt-client"; import dotenv from "dotenv"; dotenv.config(); async function text_in_audio_out() { // Set environment variables or edit the corresponding values here. const endpoint: string = process.env["AZURE_OPENAI_ENDPOINT"] || "yourEndpoint"; const deployment = "gpt-4o-realtime-preview"; if (!endpoint || !deployment) { throw new Error("You didn't set the environment variables."); } const client = new LowLevelRTClient( new URL(endpoint), new DefaultAzureCredential(), {deployment: deployment} ); try { await client.send({ type: "response.create", response: { modalities: ["audio", "text"], instructions: "Please assist the user." } }); for await (const message of client.messages()) { switch (message.type) { case "response.done": { break; } case "error": { console.error(message.error); break; } case "response.audio_transcript.delta": { console.log(`Received text delta: ${message.delta}`); break; } case "response.audio.delta": { const buffer = Buffer.from(message.delta, "base64"); console.log(`Received ${buffer.length} bytes of audio data.`); break; } } if (message.type === "response.done" || message.type === "error") { break; } } } finally { client.close(); } } await text_in_audio_out();Creare il file per eseguire la

tsconfig.jsontranspile del codice TypeScript e copiare il codice seguente per ECMAScript.{ "compilerOptions": { "module": "NodeNext", "target": "ES2022", // Supports top-level await "moduleResolution": "NodeNext", "skipLibCheck": true, // Avoid type errors from node_modules "strict": true // Enable strict type-checking options }, "include": ["*.ts"] }Transpile da TypeScript a JavaScript.

tscAccedere ad Azure con il comando seguente:

az loginEseguire il codice con il comando seguente:

node text-in-audio-out.js

Attendere qualche istante per ottenere la risposta.

Output

Lo script ottiene una risposta dal modello e stampa la trascrizione e i dati audio ricevuti.

L'output sarà simile al seguente:

Received text delta: Hello

Received text delta: !

Received text delta: How

Received text delta: can

Received text delta: I

Received 4800 bytes of audio data.

Received 7200 bytes of audio data.

Received text delta: help

Received 12000 bytes of audio data.

Received text delta: you

Received text delta: today

Received text delta: ?

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 12000 bytes of audio data.

Received 24000 bytes of audio data.

Contenuto correlato

- Altre informazioni su Come usare l'API Realtime

- Vedere le informazioni di riferimento sulle API realtime

- Altre informazioni sulle quote e i limiti di Azure OpenAI