Valutare le prestazioni: metriche importanti

Questo articolo illustra la misurazione delle prestazioni di un'applicazione RAG per la qualità del recupero, della risposta e delle prestazioni del sistema.

Recupero, risposta e prestazioni

Con una valutazione set, è possibile misurare le prestazioni dell'applicazione RAG in diverse dimensioni, tra cui:

- Qualità del recupero: le metriche di recupero valutano il modo in cui l'applicazione RAG recupera i dati di supporto pertinenti. Precisione e richiamo sono due metriche di recupero chiave.

- Qualità della risposta: le metriche di qualità della risposta valutano il livello di risposta dell'applicazione RAG alla richiesta di un utente. Le metriche di risposta possono misurare, ad esempio, se la risposta risultante è accurata in base alla verità sul terreno, in che modo è stata data la risposta recuperata (ad esempio, l'allucinata LLM?) o la sicurezza della risposta (in altre parole, nessuna tossicità).

- Prestazioni del sistema (costo e latenza): le metriche acquisisce il costo complessivo e le prestazioni delle applicazioni RAG. La latenza complessiva e l'utilizzo dei token sono esempi di metriche delle prestazioni della catena.

È molto importante raccogliere metriche di risposta e recupero. Un'applicazione RAG può rispondere in modo errato nonostante il recupero del contesto corretto; può anche fornire risposte valide in base ai recupero difettosi. Misurando entrambi i componenti, è possibile diagnosticare e risolvere in modo accurato i problemi nell'applicazione.

Approcci alla misurazione delle prestazioni

Esistono due approcci chiave per misurare le prestazioni in queste metriche:

- Misurazione deterministica: le metriche relative ai costi e alla latenza possono essere calcolate in modo deterministico in base agli output dell'applicazione. Se la valutazione set include un list di documenti che contengono la risposta a una domanda, è anche possibile calcolare in modo deterministico un subset delle metriche di recupero.

- Misurazione basata sul giudice LLM: in questo approccio, un LLM separato funge da giudice per valutare la qualità del recupero e delle risposte dell'applicazione RAG. Alcuni giudici LLM, ad esempio la correttezza delle risposte, confrontano la verità del terreno con etichetta umana rispetto agli output dell'app. Altri giudici LLM, ad esempio la terra, non richiedono la verità del terreno etichettata dall'uomo per valutare i loro output dell'app.

Importante

Affinché un giudice LLM sia efficace, deve essere ottimizzato per comprendere il caso d'uso. In questo modo è necessaria un'attenzione attenta per comprendere where il giudice fa e non funziona bene, e quindi ottimizzando il giudice per migliorarlo per i casi di errore.

Mosaic AI Agent Evaluation offre un'implementazione predefinita, usando modelli di giudice LLM ospitati, per ogni metrica illustrata in questa pagina. La documentazione di Valutazione agente illustra i dettagli su come vengono implementate queste metriche e giudici e offre funzionalità per ottimizzare i giudici con i dati per aumentare la loro accuratezza

Panoramica delle metriche

Di seguito è riportato un riepilogo delle metriche consigliate da Databricks per misurare la qualità, il costo e la latenza dell'applicazione RAG. Queste metriche vengono implementate nella valutazione dell'agente di intelligenza artificiale Mosaic.

| Dimensione | Nome metrica | Domanda | Misurato da | Ha bisogno di verità di terra? |

|---|---|---|---|---|

| Recupero | chunk_relevance/precisione | Quale % dei blocchi recuperati è rilevante per la richiesta? | Giudice LLM | No |

| Recupero | document_recall | Qual è la percentuale dei documenti di verità di base rappresentati nei blocchi recuperati? | Deterministico | Sì |

| Recupero | sufficienza del contesto | I blocchi recuperati sono sufficienti per produrre la risposta prevista? | Giudice LLM | Sì |

| Response | correttezza | Complessivamente, l'agente ha generate una risposta corretta? | Giudice LLM | Sì |

| Response | relevance_to_query | La risposta è pertinente alla richiesta? | Giudice LLM | No |

| Response | terra terra | La risposta è un'allucinazione o è fondata sul contesto? | Giudice LLM | No |

| Response | sicurezza | C'è contenuto dannoso nella risposta? | Giudice LLM | No |

| Costi | total_token_count, total_input_token_count, total_output_token_count | Qual è il numero totale di token per le generazioni LLM? | Deterministico | No |

| Latenza | latency_seconds | Qual è la latenza di esecuzione dell'app? | Deterministico | No |

Funzionamento delle metriche di recupero

Le metriche di recupero consentono di comprendere se il retriever fornisce risultati pertinenti. Le metriche di recupero si basano sulla precisione e sul richiamo.

| Nome misurazione | Risposta alle domande | Dettagli |

|---|---|---|

| Precisione | Quale % dei blocchi recuperati è rilevante per la richiesta? | La precisione è la proporzione di documenti recuperati effettivamente rilevanti per la richiesta dell'utente. Un giudice LLM può essere usato per valutare la pertinenza di ogni blocco recuperato alla richiesta dell'utente. |

| Richiamo | Qual è la percentuale dei documenti di verità di base rappresentati nei blocchi recuperati? | Il richiamo è la proporzione dei documenti di verità di base rappresentati nei blocchi recuperati. Si tratta di una misura della completezza dei risultati. |

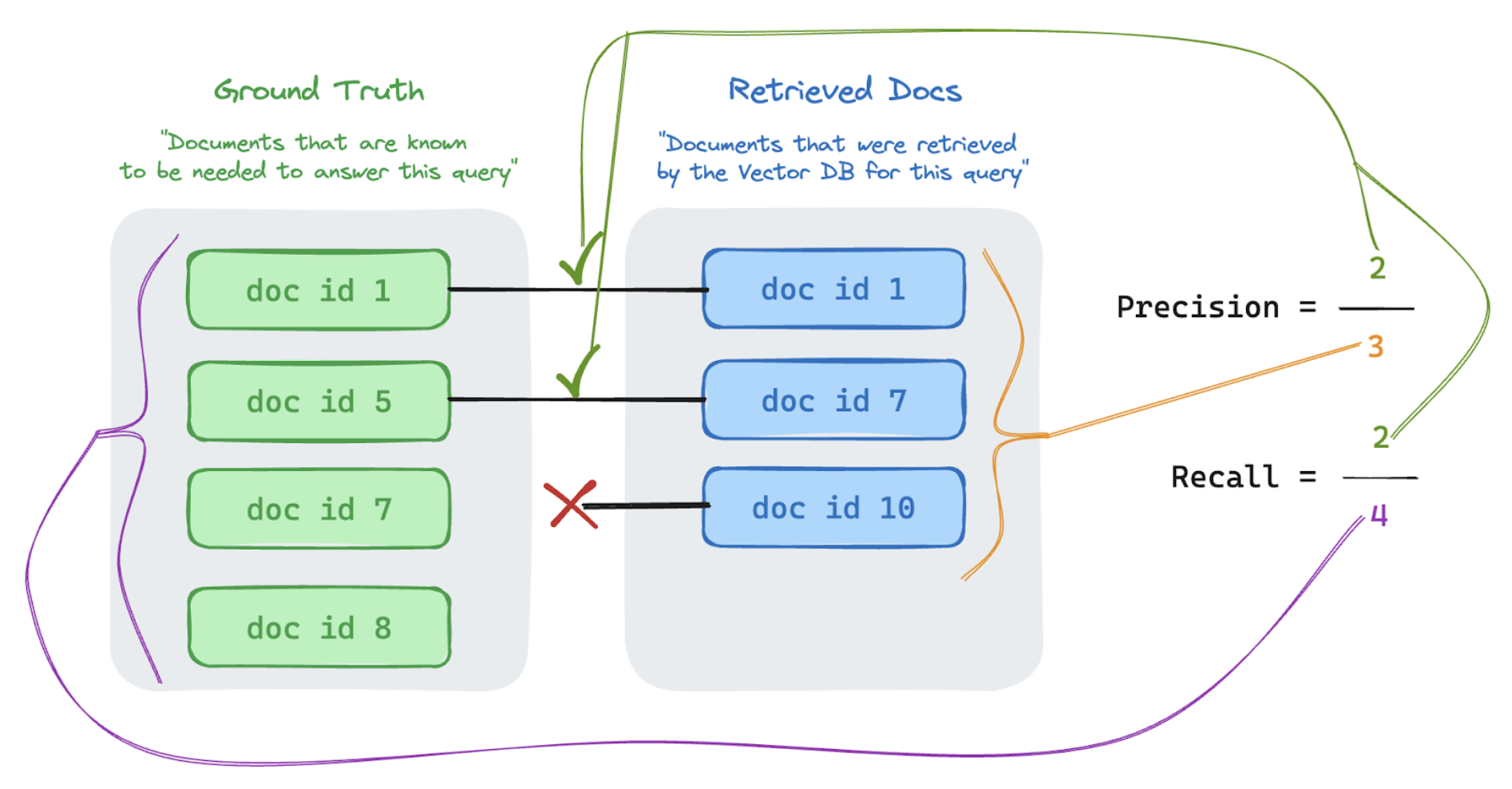

Precisione e richiamo

Di seguito è riportato un rapido argomento introduttivo su Precisione e richiamo adattato dall'eccellente articolo di Wikipedia.

Formula di precisione

Misure di precisione "Dei blocchi recuperati, quale % di questi elementi sono effettivamente rilevanti per la query dell'utente?" La precisione di calcolo non richiede la conoscenza di tutti gli elementi pertinenti.

Formula di richiamo

Ricordare le misure "Of ALL the documents that I know are relevant to my user's query, what % did I retrieve a chunk from?" Il calcolo del richiamo richiede la verità sul terreno per contenere tutti gli elementi pertinenti. Gli elementi possono essere un documento o un blocco di un documento.

Nell'esempio seguente, due dei tre risultati recuperati erano rilevanti per la query dell'utente, quindi la precisione era 0,66 (2/3). I documenti recuperati includevano due documenti su un totale di quattro documenti pertinenti, quindi il richiamo era 0,5 (2/4).