Passaggio 6. Apportare e valutare le correzioni di qualità nell'agente di intelligenza artificiale

Questo articolo illustra i passaggi per scorrere e valutare le correzioni di qualità nell'agente di intelligenza artificiale generativo in base all'analisi della causa radice.

Per altre informazioni sulla valutazione di un agente di intelligenza artificiale, vedere Che cos'è La valutazione dell'agente di intelligenza artificiale Mosaic?.

Requisiti

- In base all'analisi della causa radice, è stata identificata una potenziale correzione per il recupero o la generazione da implementare e valutare.

- L'applicazione POC (o un'altra catena di baseline) viene registrata in un'esecuzione MLflow con una valutazione di valutazione dell'agente archiviata nella stessa esecuzione.

Per il codice di esempio in questa sezione, vedere il repository GitHub.

Risultato previsto nella valutazione dell'agente

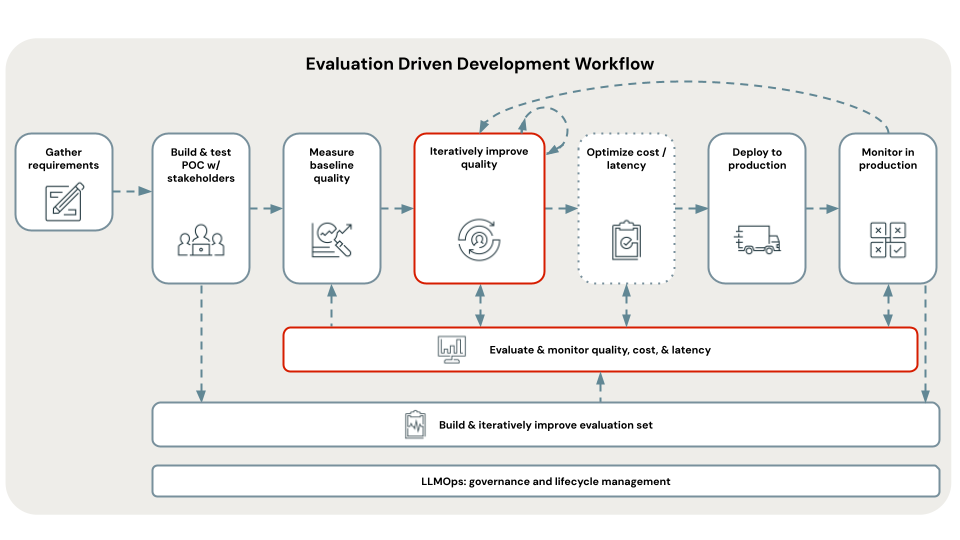

L'immagine precedente mostra l'output di valutazione dell'agente in MLflow.

Come correggere, valutare ed eseguire l'iterazione nell'agente di intelligenza artificiale

Per tutti i tipi, usare il notebook B_quality_iteration/02_evaluate_fixes per valutare la catena risultante rispetto alla configurazione di base, al modello di verifica e selezionare un "vincitore". Questo notebook consente di scegliere l'esperimento vincente e di distribuirlo nell'app di revisione o in un'API REST scalabile pronta per la produzione.

- In Azure Databricks aprire il notebook B_quality_iteration/02_evaluate_fixes .

- In base al tipo di correzione che si sta implementando:

- Per le correzioni della pipeline di dati:

- Seguire il passaggio 6 (pipeline). Implementare le correzioni della pipeline di dati per creare la nuova pipeline di dati e ottenere il nome dell'esecuzione MLflow risultante.

- Aggiungere il nome di esecuzione alla

DATA_PIPELINE_FIXES_RUN_NAMESvariabile.

- Per le correzioni di configurazione della catena:

- Seguire le istruzioni nella

Chain configurationsezione del notebook 02_evaluate_fixes per aggiungere correzioni di configurazione della catena allaCHAIN_CONFIG_FIXESvariabile.

- Seguire le istruzioni nella

- Per le correzioni del codice della catena:

- Creare un file di codice della catena modificato e salvarlo nella cartella B_quality_iteration/chain_code_fixes . In alternativa, selezionare una delle correzioni del codice della catena fornite da tale cartella.

- Seguire le istruzioni nella

Chain codesezione del notebook di 02_evaluate_fixes per aggiungere il file di codice della catena e qualsiasi altra configurazione della catena necessaria per laCHAIN_CODE_FIXESvariabile.

- Per le correzioni della pipeline di dati:

- Quando si esegue il notebook dalla

Run evaluationcella, si verifica quanto segue:- Valutare ogni correzione.

- Determinare la correzione con le metriche di qualità/costo/latenza migliori.

- Distribuire la soluzione migliore nell'app di revisione e in un'API REST pronta per la produzione per ottenere commenti e suggerimenti sugli stakeholder.

Passaggio successivo

Continuare con il passaggio 6 (pipeline). Implementare correzioni della pipeline di dati.

< Precedente: Passaggio 5.2. Qualità della generazione del debug