Architettura di Data lakehouse: framework ben progettato di Databricks

Questo set di articoli sull'architettura del data lakehouse fornisce principi e migliori pratiche per l'implementazione e il funzionamento di un lakehouse con Azure Databricks.

Framework ben progettato di Databricks per il lakehouse

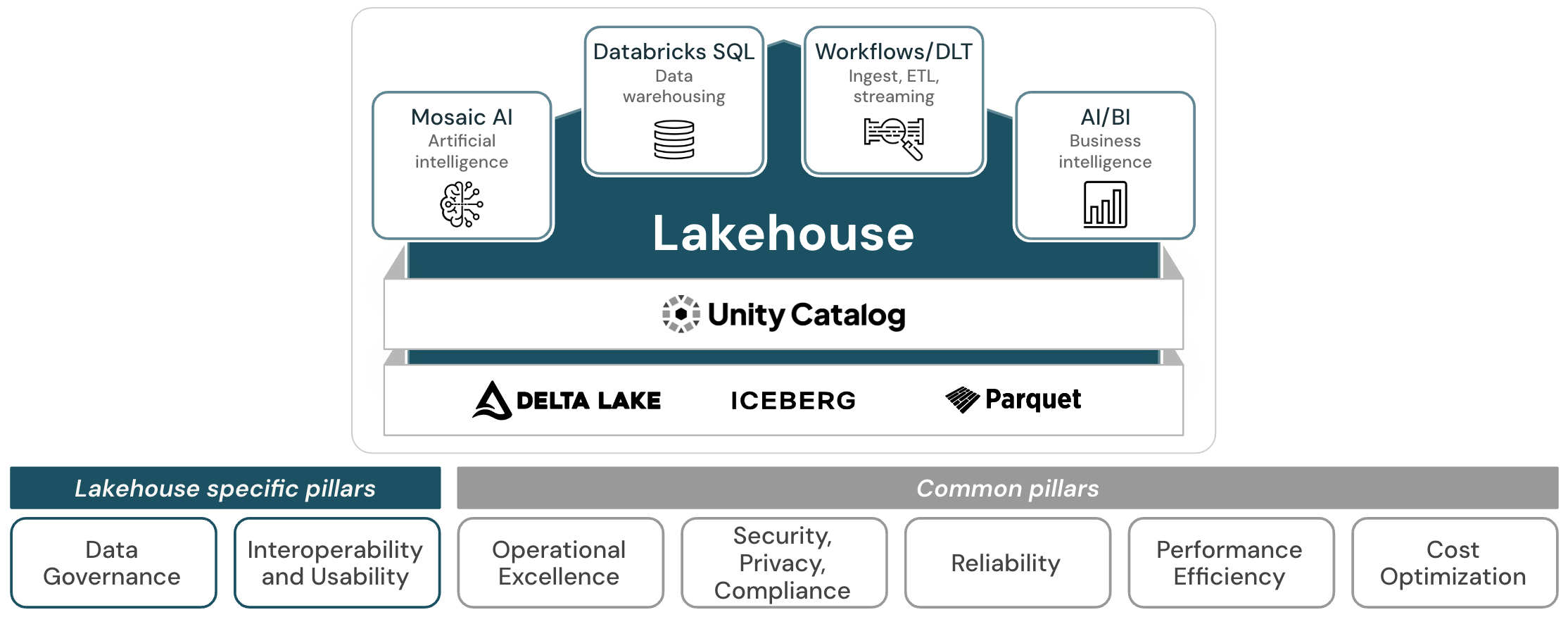

Il lakehouse ben progettato è costituito da 7 pilastri che descrivono aree diverse di preoccupazione per l'implementazione di un data lakehouse nel cloud:

Governance dei dati e dell'intelligenza artificiale

La supervisione per garantire che i dati e l'IA portino valore e supportino la strategia aziendale.

Interoperabilità e usabilità

La capacità del lakehouse di interagire con utenti e altri sistemi.

Eccellenza operativa

Tutti i processi operativi che mantengono il lakehouse in esecuzione nell'ambiente di produzione.

Sicurezza, privacy e conformità

Proteggere l'applicazione Azure Databricks, i carichi di lavoro dei clienti e i dati dei clienti dalle minacce.

Affidabilità

La capacità di un sistema di correggere gli errori e continuare a funzionare.

Efficienza prestazionale

La capacità di un sistema di adattarsi ai cambiamenti di carico.

Ottimizzazione dei costi

Gestione dei costi per massimizzare il valore offerto.

Il lakehouse ben progettato estende Microsoft Azure Well-Architected Framework alla piattaforma data intelligence di Databricks e shares i pilastri "Operational Excellence"Security" (come "Security, privacy e conformità"), "affidabilità", "Performance Efficiency" e "Cost Optimization".

Per questi cinque pilastri, i principi e le procedure consigliate del framework cloud si applicano ancora alla lakehouse. Il lakehouse ben progettato estende queste indicazioni con principi e pratiche consigliate che sono specifici per la gestione del lakehouse e importanti per costruire un sistema efficace ed efficiente.

I pilastri specifici dell'architettura lakehouse

I pilastri "governance dei dati e dell'IA" e "interoperabilità e usabilità" riguardano aspetti specifici della Lakehouse.

La governance dei dati e dell'intelligenza artificiale incapsula i criteri e le procedure implementate per gestire in modo sicuro i dati e gli asset di intelligenza artificiale all'interno di un'organizzazione. Uno degli aspetti fondamentali di un lakehouse è la governance centralizzata dei dati e dell'intelligenza artificiale: lakehouse unifica i casi d'uso di data warehousing e intelligenza artificiale in una singola piattaforma. Questo semplifica lo stack di dati moderno eliminando i silo di dati che tradizionalmente separano e complicano la progettazione dei dati, l'analisi, l'analisi, l'analisi, l'analisi, l'analisi e l'apprendimento automatico. Per semplificare queste attività di governance, lakehouse offre una soluzione di governance unificata per dati, analisi e intelligenza artificiale. Riducendo al minimo le copie dei dati e passando a un singolo livello di elaborazione dati where tutti i controlli di governance dei dati e dell'intelligenza artificiale possono essere eseguiti insieme, è possibile migliorare le probabilità di rimanere in conformità e rilevare una violazione dei dati.

Un altro importante tenet del lakehouse è fornire un'esperienza utente ottimale per tutti gli utenti che lavorano con esso e per poter interagire con un ampio ecosistema di sistemi esterni. Azure dispone già di un'ampia gamma di strumenti di dati che eseguono la maggior parte delle attività necessarie per un'azienda basata sui dati. Tuttavia, questi strumenti devono essere assemblati correttamente per fornire tutte le funzionalità, con ogni servizio che offre un'esperienza utente diversa. Questo approccio può comportare costi di implementazione elevati e in genere non offre la stessa esperienza utente di una piattaforma lakehouse nativa: gli utenti sono limitati da incoerenze tra strumenti e mancanza di funzionalità di collaborazione e spesso devono passare attraverso processi complessi per ottenere l'accesso al sistema e quindi ai dati.

Un lakehouse integrato dall'altro lato offre un'esperienza utente coerente in tutti i carichi di lavoro e quindi aumenta l'usabilità. In questo modo si riducono i costi di training e onboarding e si migliora la collaborazione tra le funzioni. Inoltre, le nuove funzionalità vengono aggiunte automaticamente nel tempo, per migliorare ulteriormente l'esperienza utente, senza la necessità di investire risorse e budget interni.

Un approccio multi-cloud può essere una strategia deliberata di un'azienda o il risultato di fusioni e acquisizioni o di business unit indipendenti che scelgono diversi cloud providers. In questo caso, l'uso di un multi-cloud lakehouse comporta un'esperienza utente unificata in tutti i cloud. In questo modo si riduce la proliferazione di sistemi in tutta l'azienda, riducendo a sua volta le competenze e i requisiti di formazione dei dipendenti coinvolti nelle attività guidate dai dati.

Infine, in un mondo in rete con processi aziendali inter-aziendali, i sistemi devono collaborare il più facilmente possibile. Il grado di interoperabilità è un criterio cruciale e i dati più recenti, come asset principale di qualsiasi azienda, devono fluire in modo sicuro tra i sistemi dei partner interni ed esterni.