Hub eventi di Azure: una piattaforma di streaming di dati in tempo reale con supporto nativo di Apache Kafka

Hub eventi di Azure è un servizio di-streaming dati nativo nel cloud che può trasmettere milioni di eventi al secondo, con bassa latenza, da qualsiasi origine a qualsiasi destinazione. Hub eventi di Azure è compatibile con Apache Kafka. Consente di eseguire carichi di lavoro Kafka esistenti senza modifiche al codice.

Le aziende possono usare Hub eventi per inserire e archiviare i dati di streaming. Usando i dati di streaming, le aziende possono ottenere informazioni dettagliate preziose, favorire l'analisi in tempo reale e rispondere agli eventi man mano che si verificano. Questi dati possono essere usati per migliorare l'efficienza complessiva e l'esperienza dei clienti.

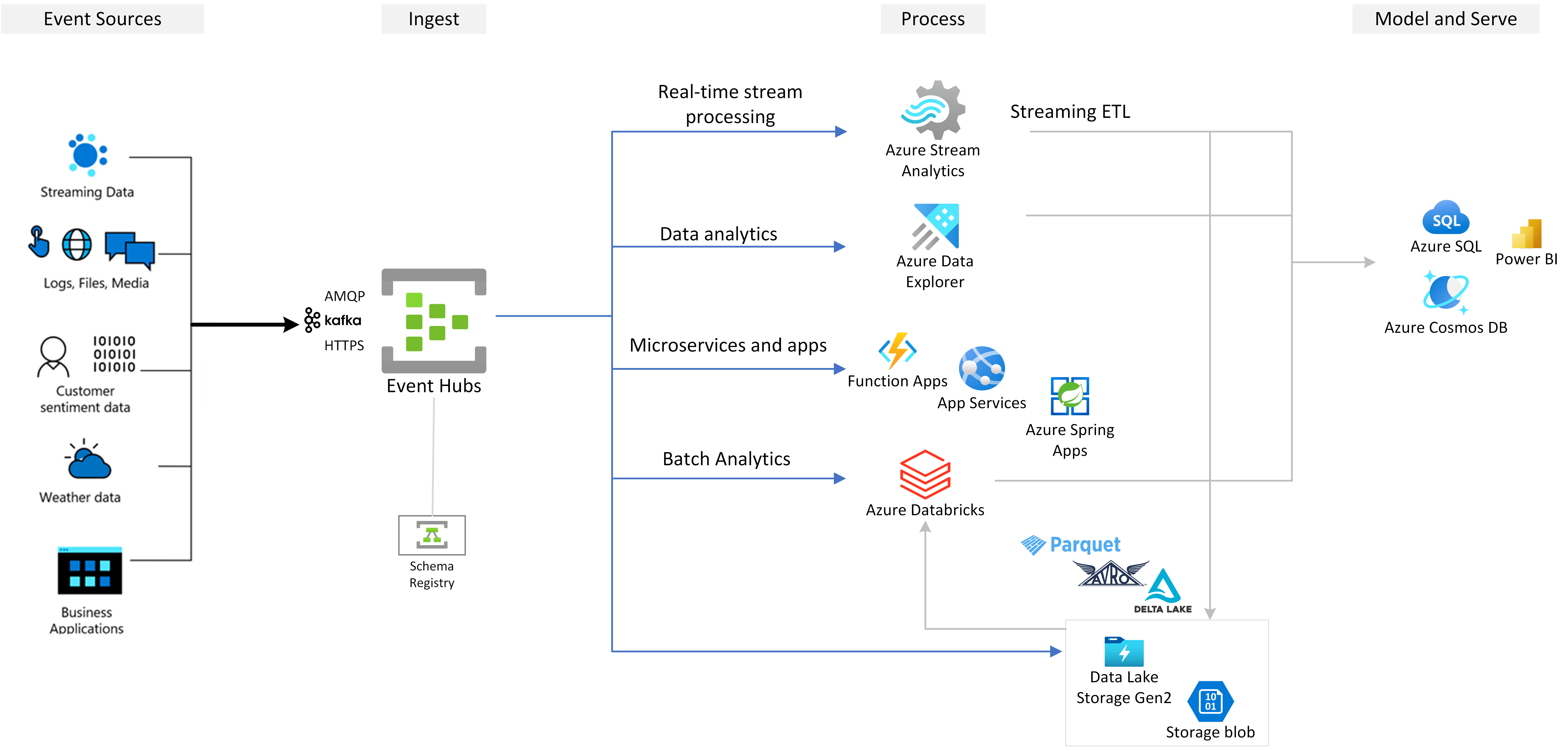

Hub eventi è il livello di inserimento di eventi preferito di qualsiasi soluzione di streaming di eventi creata in Azure. Si integra con i servizi di analisi e dati all'interno e all'esterno di Azure per creare una pipeline di streaming di dati completa per soddisfare i casi d'uso seguenti:

- Elaborare i dati dall'hub eventi usando Analisi di flusso di Azure per generare informazioni dettagliate in tempo reale.

- Analizzare ed esplorare i dati di streaming con Azure Esplora dati.

- Creare applicazioni, funzioni o microservizi nativi del cloud che vengono eseguiti sui dati di streaming da Hub eventi.

- Trasmettere eventi con convalida dello schema usando il Registro schemi di Azure predefinito per garantire la qualità e la compatibilità dei dati di streaming.

Funzionalità chiave

Nelle sezioni seguenti vengono illustrate le principali funzionalità di Hub eventi di Azure.

Apache Kafka in Hub eventi di Azure

Hub eventi è un motore di streaming di eventi multi-protocollo che supporta in modo nativo i protocolli Advanced Message Queuing Protocol (AMQP), Apache Kafka e HTTPS. Poiché supporta Apache Kafka, è possibile trasferire i carichi di lavoro Kafka in Hub eventi senza apportare modifiche al codice. Non è necessario impostare, configurare o gestire cluster Kafka personalizzati o usare un'offerta Kafka-as-a-service non nativa di Azure.

Hub eventi viene creato come motore broker nativo del cloud. Per questo motivo, è possibile eseguire carichi di lavoro Kafka con prestazioni migliori, una migliore efficienza dei costi e nessun sovraccarico operativo.

Per altre informazioni, vedere Hub eventi di Azure per Apache Kafka.

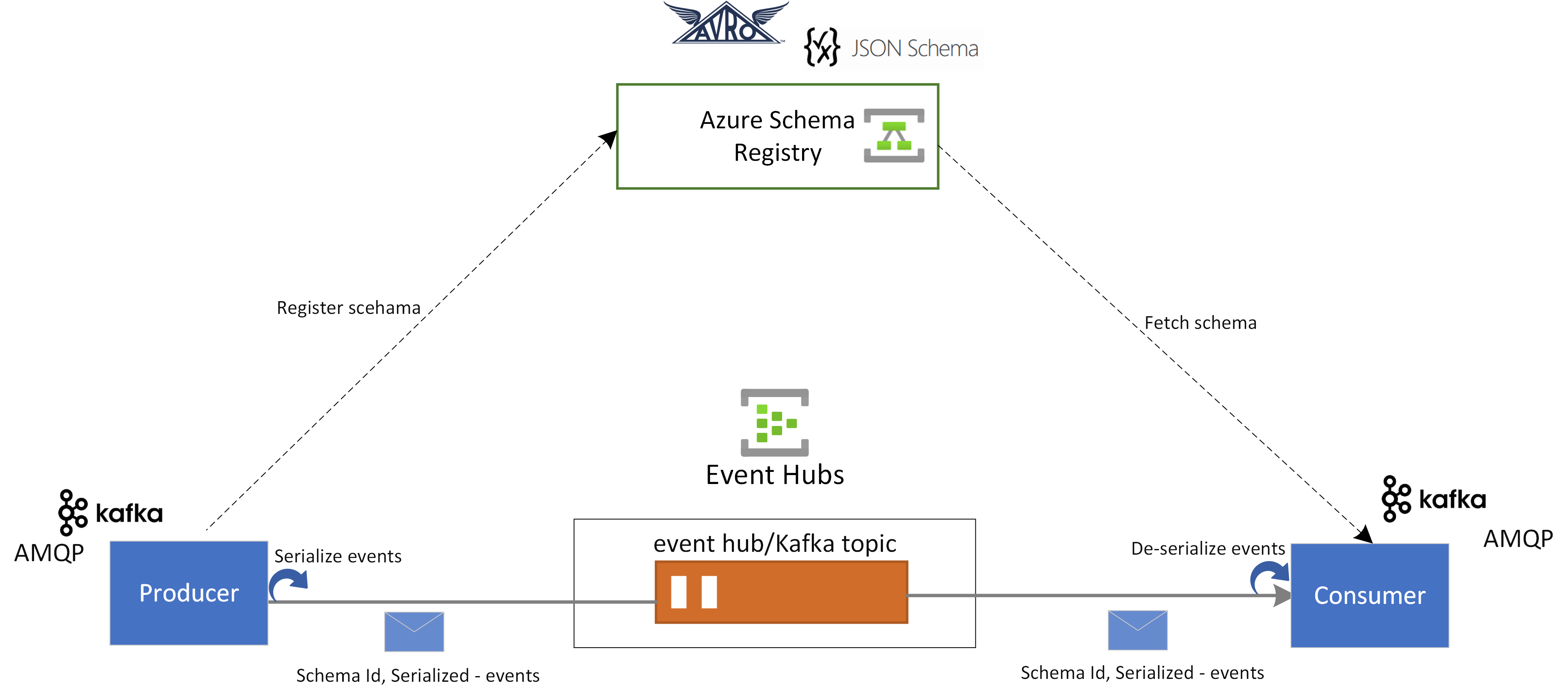

Registro schemi in Hub eventi

Registro schemi di Hub eventi offre un repository centralizzato per la gestione degli schemi delle applicazioni di streaming di eventi. Il Registro schemi è disponibile gratuitamente con ogni spazio dei nomi di Hub eventi. Si integra con le applicazioni Kafka o le applicazioni basate su SDK di Hub eventi.

Registro schemi garantisce la compatibilità e la coerenza dei dati tra producer di eventi e consumer. Consente l'evoluzione, la convalida e la governance dello schema e promuove uno scambio di dati efficiente e l'interoperabilità.

Il Registro schemi si integra con le applicazioni Kafka esistenti e supporta più formati di schema, inclusi gli schemi Avro e JSON.

Per altre informazioni, vedere Registro schemi di Azure in Hub eventi.

Elaborazione in tempo reale degli eventi di streaming con Analisi di flusso di Azure

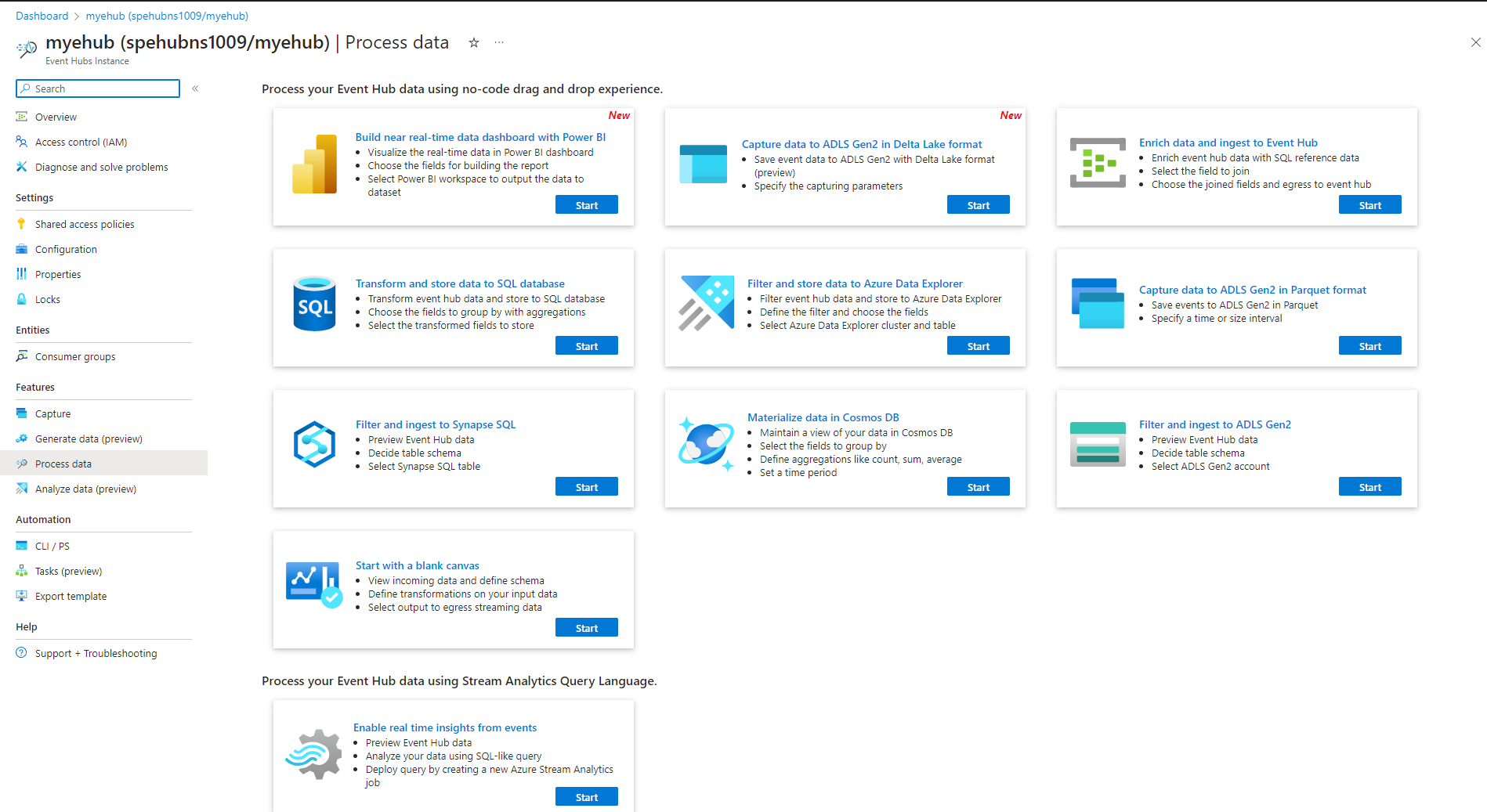

Hub eventi si integra con Analisi di flusso di Azure per consentire l'elaborazione dei flussi in tempo reale. Con l'editor senza codice predefinito, è possibile sviluppare un processo di Analisi di flusso di Azure usando la funzionalità di trascinamento della selezione, senza scrivere codice.

In alternativa, gli sviluppatori possono usare il linguaggio di query di Analisi di flusso di Azure basato su SQL per eseguire l'elaborazione dei flussi in tempo reale e sfruttare un'ampia gamma di funzioni per l'analisi dei dati in streaming.

Per altre informazioni, vedere gli articoli nella sezione Integrazione di Analisi di flusso di Azure del sommario.

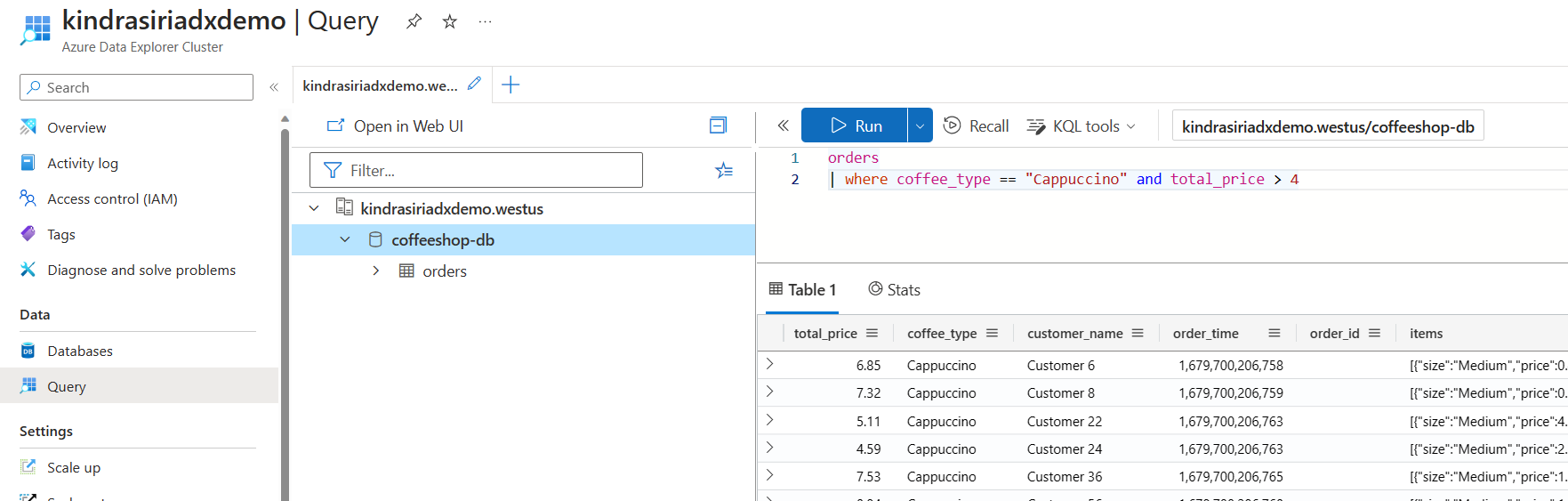

Esplorare i dati di streaming con Azure Esplora dati

Azure Esplora dati è una piattaforma completamente gestita per l'analisi dei Big Data che offre prestazioni elevate e consente l'analisi di grandi volumi di dati quasi in tempo reale. Integrando Hub eventi con Azure Esplora dati, è possibile eseguire analisi quasi in tempo reale ed esplorazione dei dati di streaming.

Per altre informazioni, vedere Inserire dati da un hub eventi in Azure Esplora dati.

Funzioni di Azure, SDK e ecosistema Kafka

Con Hub eventi è possibile inserire, bufferizzare, archiviare ed elaborare il flusso in tempo reale per ottenere informazioni utili. Hub eventi usa un modello consumer partizionato. Consente a più applicazioni di elaborare il flusso in modo simultaneo e di controllare la velocità di elaborazione. Hub eventi si integra anche con Funzioni di Azure per le architetture serverless.

È disponibile un ampio ecosistema per il protocollo AMQP 1.0, standard del settore. Gli SDK sono disponibili in linguaggi come .NET, Java, Python e JavaScript, in modo da avviare l'elaborazione dei flussi da Hub eventi. Tutte i linguaggi lato client supportati offrono un'integrazione di basso livello.

L'ecosistema consente anche di eseguire l'integrazione con Funzioni di Azure, Azure Spring Apps, Connettori Kafka e altre piattaforme e tecnologie di analisi dei dati, ad esempio Apache Spark e Apache Flink.

Supporta lo sviluppo locale con l'emulatore di Hub eventi

Hub eventi di Azure emulatore offre un'esperienza di sviluppo locale per Hub eventi. È possibile usare l'emulatore per sviluppare e testare il codice sul servizio in isolamento, senza interferenze nel cloud. Per altre informazioni, vedere Emulatore di Hub eventi

Streaming di eventi flessibile e conveniente

È possibile sperimentare lo streaming di eventi flessibile e conveniente tramite i livelli Standard, Premium o Dedicato per Hub eventi. Queste opzioni sono adatte alle esigenze di streaming dei dati che vanno da pochi MB/sec a diversi GB/sec. È possibile scegliere la corrispondenza appropriata per i requisiti.

Scalabile

Con Hub eventi, è possibile iniziare con i flussi di dati in megabyte e aumentare fino a gigabyte o terabyte. La funzionalità di aumento automatico è una delle opzioni disponibili per ridimensionare il numero di unità elaborate o unità di elaborazione per soddisfare le esigenze di utilizzo.

Supporta lo streaming di messaggi di grandi dimensioni

Nella maggior parte degli scenari di streaming, i dati sono caratterizzati da una velocità effettiva leggera, in genere inferiore a 1 MB e con una velocità effettiva elevata. Esistono anche istanze in cui i messaggi non possono essere divisi in segmenti più piccoli. Hub eventi può ospitare eventi fino a 20 MB con cluster dedicati scalabili self-service senza costi aggiuntivi . Questa funzionalità consente a Hub eventi di gestire un'ampia gamma di dimensioni dei messaggi per garantire operazioni aziendali ininterrotte. Per altre informazioni, vedere Inviare e ricevere messaggi di grandi dimensioni con Hub eventi di Azure.

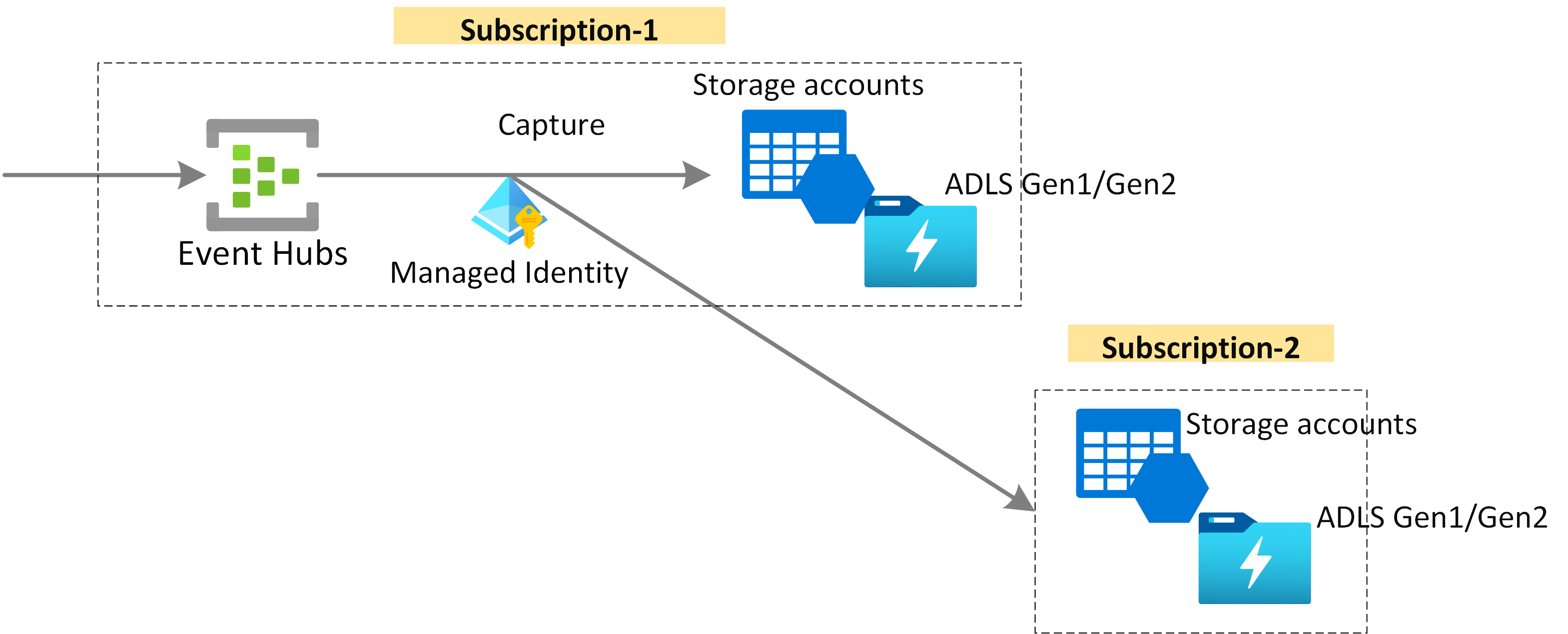

Acquisire dati di streaming per la conservazione a lungo termine e l'analisi batch

Acquisire i dati quasi in tempo reale in Archiviazione BLOB di Azure o Azure Data Lake Storage per la conservazione a lungo termine o l'elaborazione di micro batch. È possibile ottenere questo comportamento nello stesso flusso usato per derivare analisi in tempo reale. La configurazione dell'acquisizione di dati degli eventi è una procedura rapida.

Funzionamento

Hub eventi offre una piattaforma di streaming di eventi unificata con un buffer di conservazione del tempo, separando i producer di eventi dai consumer di eventi. Le applicazioni producer e consumer possono eseguire l'inserimento di dati su larga scala tramite più protocolli.

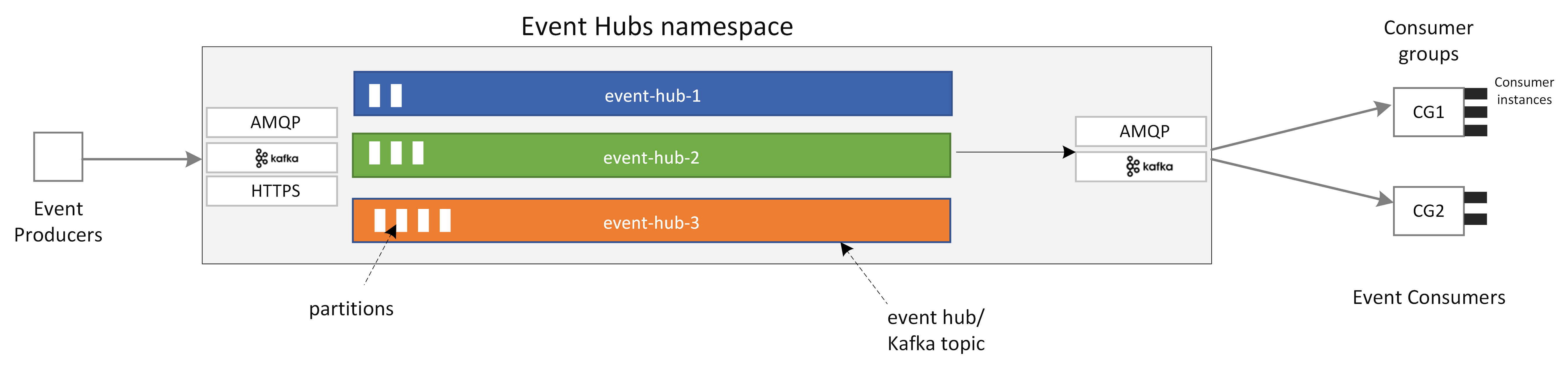

Il diagramma seguente illustra i componenti principali dell'architettura di Hub eventi.

I componenti funzionali principali di Hub eventi includono:

- Applicazioni producer: Queste applicazioni possono inserire dati in un hub eventi usando gli SDK di Hub eventi o qualsiasi client producer di Kafka.

- Spazio dei nomi: Contenitore di gestione per uno o più hub eventi o argomenti Kafka. Le attività di gestione, come l'allocazione della capacità di streaming, la configurazione della sicurezza di rete e l'abilitazione del ripristino di emergenza geografico vengono gestite a livello di spazio dei nomi.

- Argomento Hub eventi/Kafka: In Hub eventi è possibile organizzare gli eventi in un hub eventi o in un argomento Kafka. Si tratta di un log distribuito di solo accodamento, che può contenere una o più partizioni.

- Partizioni: Vengono usate per ridimensionare un hub eventi. Sono come le corsie di un'autostrada. Se si necessita di una maggiore velocità effettiva di streaming, è possibile aggiungere altre partizioni.

- Applicazioni consumer: Queste applicazioni possono usare i dati cercando nel registro eventi e mantenendo l'offset consumer. I consumer possono essere client consumer Kafka o client SDK di Hub eventi.

- Gruppo di consumer: Questo gruppo logico di istanze consumer legge i dati da un hub eventi o da un argomento Kafka. Consente a più consumer di leggere gli stessi dati di streaming in un hub eventi in modo indipendente e con i propri offset.

Contenuto correlato

Per iniziare a usare Hub eventi, vedere le guide introduttive seguenti.

Trasmettere i dati usando l'SDK di Hub eventi (AMQP)

È possibile usare uno degli esempi seguenti per trasmettere i dati a Hub eventi usando gli SDK.

Trasmettere dati con Apache Kafka

È possibile usare gli esempi seguenti per trasmettere dati dalle applicazioni Kafka a Hub eventi.

Convalida dello schema con registro schemi

È possibile usare il Registro schemi di Hub eventi per eseguire la convalida dello schema per le applicazioni di streaming di eventi.