Monitoraggio dei dettagli dell'applicazione Apache Spark

Con Microsoft Fabric è possibile usare Apache Spark per eseguire notebook, processi e altri tipi di applicazioni nell'area di lavoro. Questo articolo illustra come monitorare le applicazioni Apache Spark, consentendo di tenere sotto controllo lo stato di esecuzione recente, i problemi e lo stato dei processi.

Visualizzare le applicazioni Apache Spark

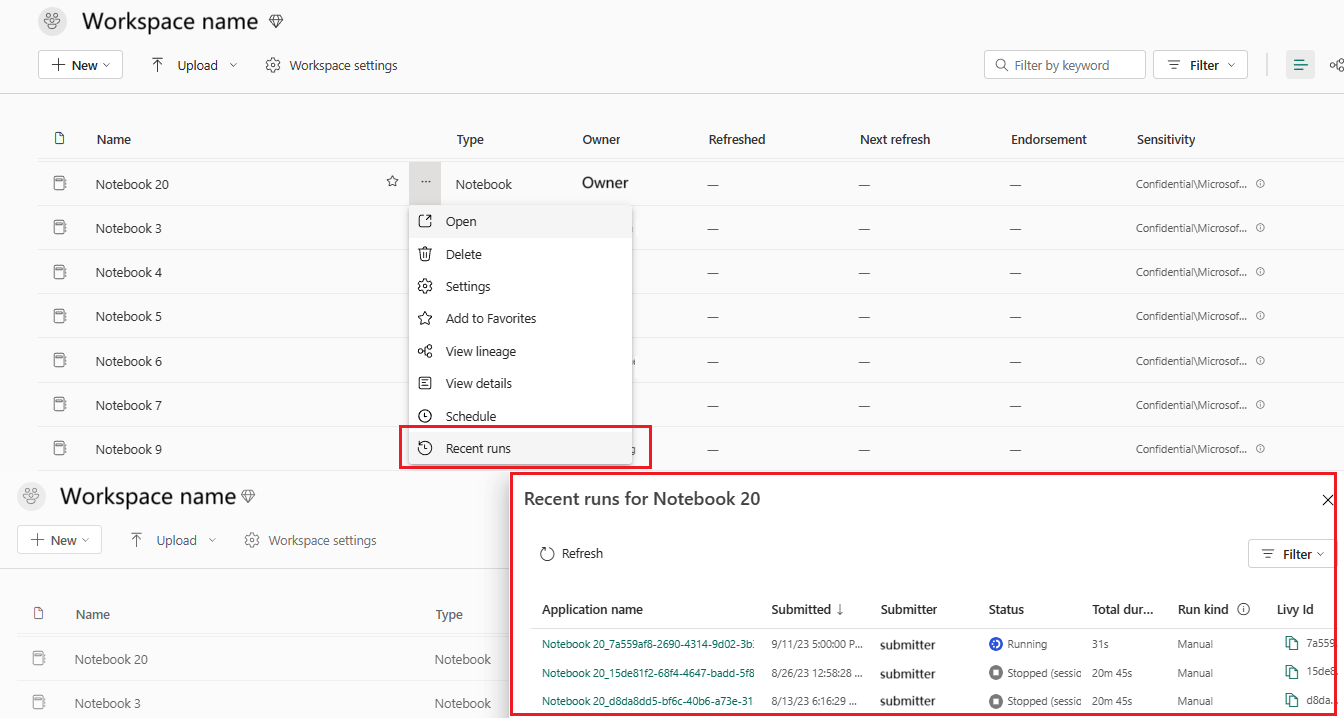

È possibile visualizzare tutte le applicazioni Apache Spark dalla definizione processo Spark; in alternativa, il menu di scelta rapida dell’elemento notebook mostra l’opzione di esecuzione recente ->Esecuzioni recenti.

È possibile selezionare il nome dell'applicazione da visualizzare nell'elenco delle applicazioni; nella pagina dei dettagli dell'applicazione è possibile visualizzare i dettagli dell'applicazione.

Monitorare o lo stato delle applicazioni Apache Spark

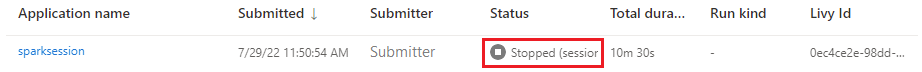

Aprire la pagina Esecuzioni recenti della definizione processo del notebook o di Spark, in cui è possibile visualizzare lo stato dell'applicazione Apache.

- Success

- In coda

- Arrestato

- Annullati

- Non riuscito

Processi

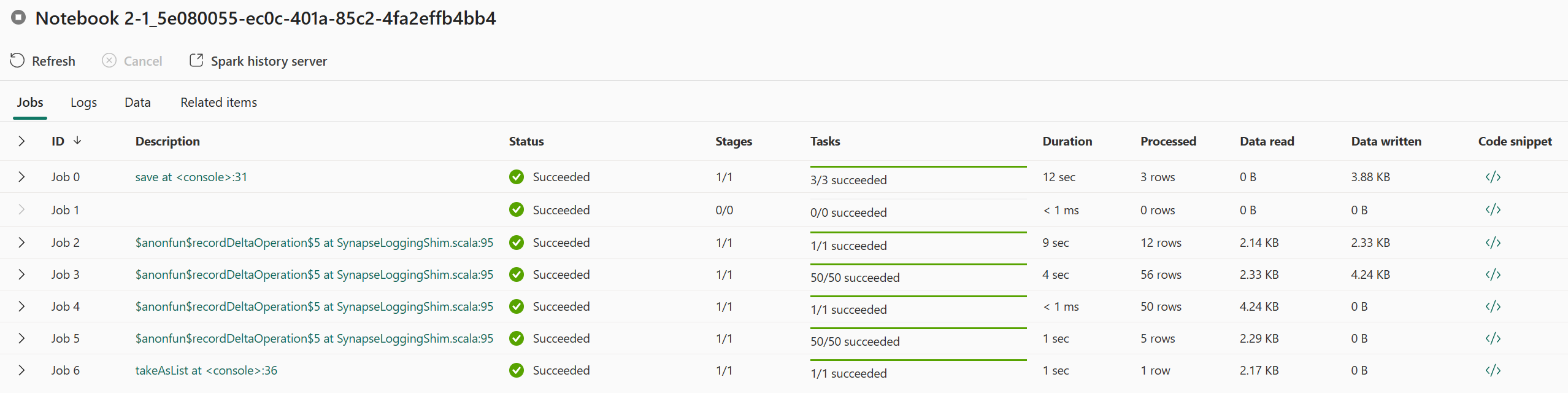

Aprire un processo dell'applicazione Apache Spark dalla definizione processo Spark; in alternativa, il menu contestuale dell’elemento notebook mostra l'opzione Esecuzione recente ->Esecuzioni recenti -> selezionare un processo nella pagina delle esecuzioni recenti.

Nella pagina dei dettagli di monitoraggio delle applicazioni Apache Spark, l'elenco delle esecuzioni dei processi viene visualizzato nella scheda Processi, in cui è possibile visualizzare i dettagli di ogni processo, tra cui ID processo, Descrizione, Stato, Fasi, Attività, Durata, Elaborato, Lettura dati, Dati scritti e Frammento di codice.

- Facendo clic su ID processo, è possibile espandere/comprimere il processo.

- Fare clic sulla descrizione del processo. È possibile passare alla pagina del processo o della fase nell'interfaccia utente di Spark.

- Fare clic sul frammento di codice del processo. È possibile controllare e copiare il codice correlato a questo processo.

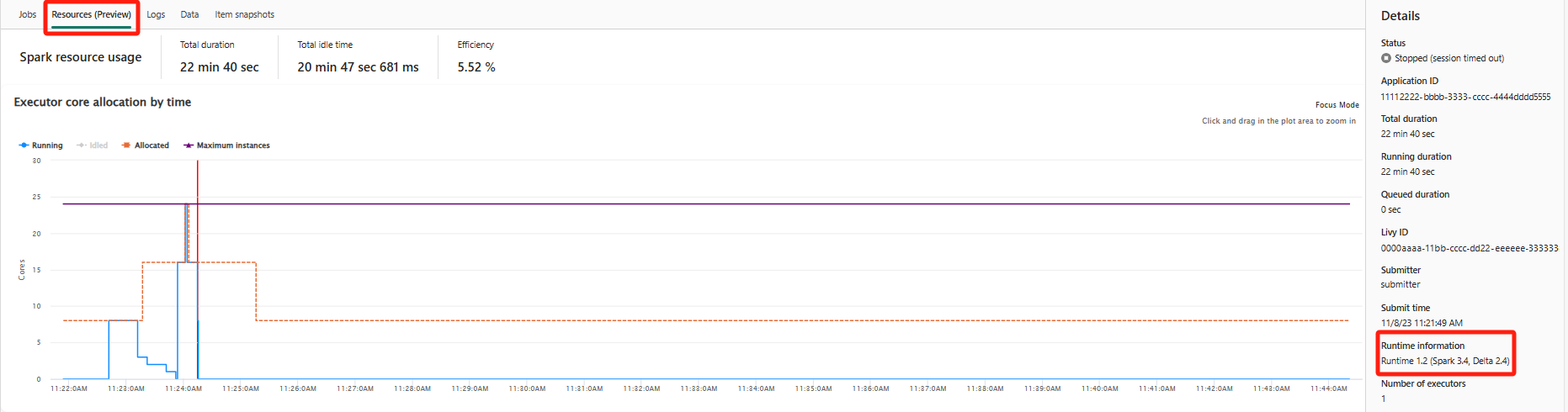

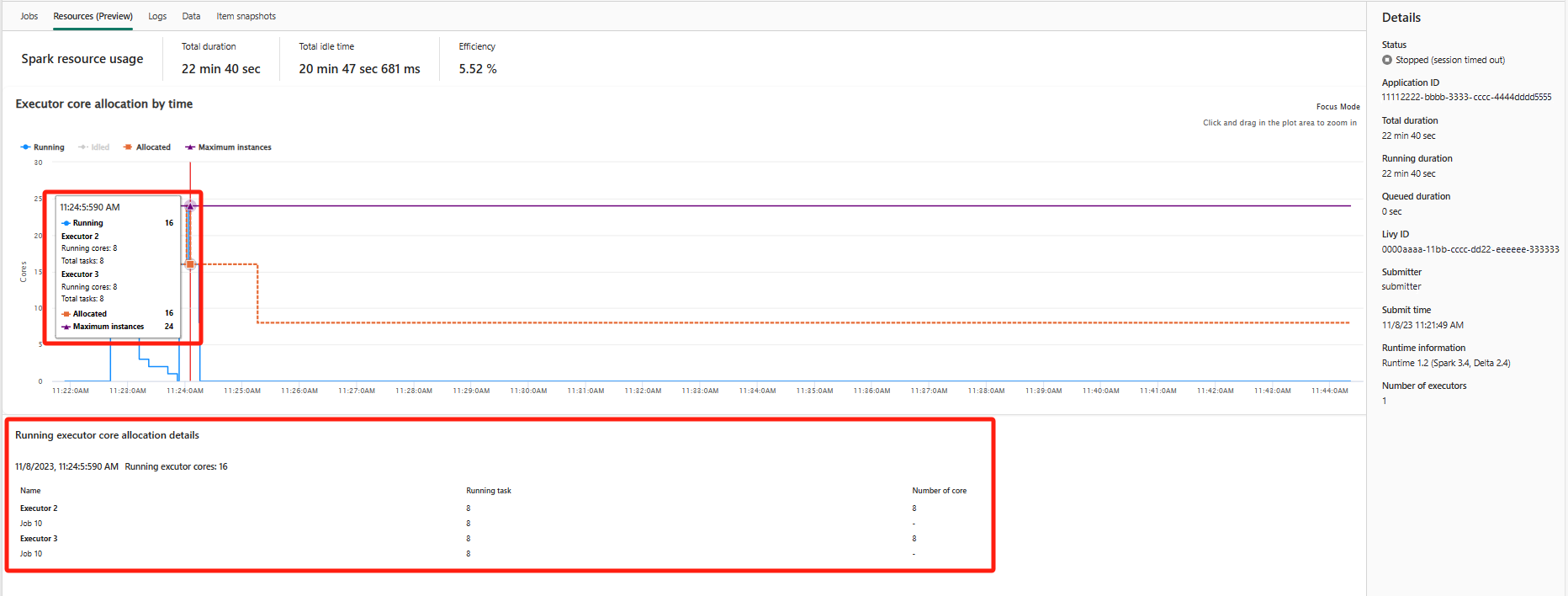

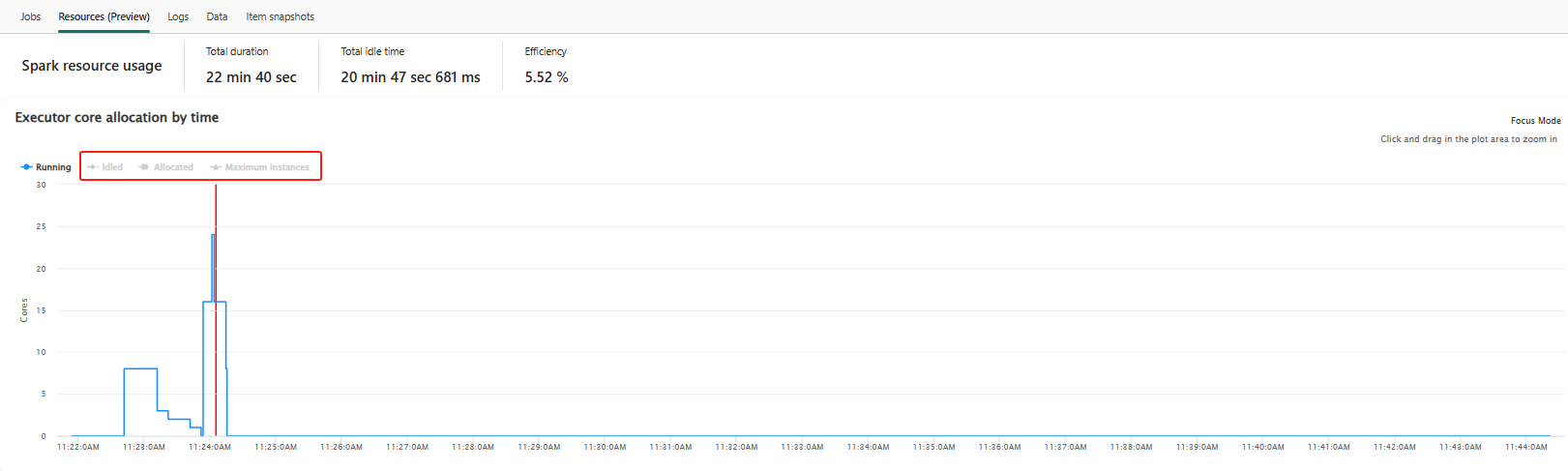

Risorse (anteprima)

Il grafico di utilizzo executor mostra visivamente l'allocazione di executor del processo Spark e l'uso delle risorse. Attualmente, solo le informazioni di runtime di Spark 3.4 e versioni successive visualizzeranno questa funzionalità. Selezionare Risorse (anteprima). Vengono tracciate quattro curve dei tipi sull'uso di executor, tra cui In esecuzione, Inattivo, Allocato, Numero massimo di istanze.

Allocato si riferisce alla situazione core allocata durante l'esecuzione dell'applicazione Spark.

Numero massimo di istanze si riferisce al numero massimo di core allocati all'applicazione Spark.

In esecuzione si riferisce al numero effettivo di core usati dall'applicazione Spark quando è in esecuzione. Fare clic in un punto nel tempo durante l'esecuzione dell'applicazione Spark. È possibile visualizzare i dettagli dell'allocazione core executor in esecuzione nella parte inferiore del grafico.

Inattivo è il numero di core inutilizzati durante l'esecuzione dell'applicazione Spark.

In alcuni casi, in alcuni punti nel tempo il numero di attività potrebbe superare la capacità dei core executor (ossia numeri > core executor totali / spark.task.cpus). Ciò è previsto, perché esiste una lacuna temporale tra un'attività contrassegnata come in esecuzione e il momento effettivo in cui è in esecuzione in un core executor. Alcune attività potrebbero quindi essere visualizzate come in esecuzione, ma non vengono eseguite in alcun core.

Selezionare l'icona del colore per selezionare o deselezionare il contenuto corrispondente in tutto il grafico.

Pannello di riepilogo

Nella pagina di monitoraggio dell'applicazione Apache Spark, fare clic sul pulsante Proprietà per aprire/comprimere il pannello di riepilogo. È possibile visualizzare i dettagli per questa applicazione in Dettagli.

- Stato per questa applicazione Spark.

- ID di questa applicazione Spark.

- Durata totale.

- Durata di esecuzione per questa applicazione Spark.

- Durata in coda per questa applicazione Spark.

- ID Livy

- Persona che invia la richiesta per questa applicazione Spark.

- Ora di invio per questa applicazione Spark.

- Numero di executor.

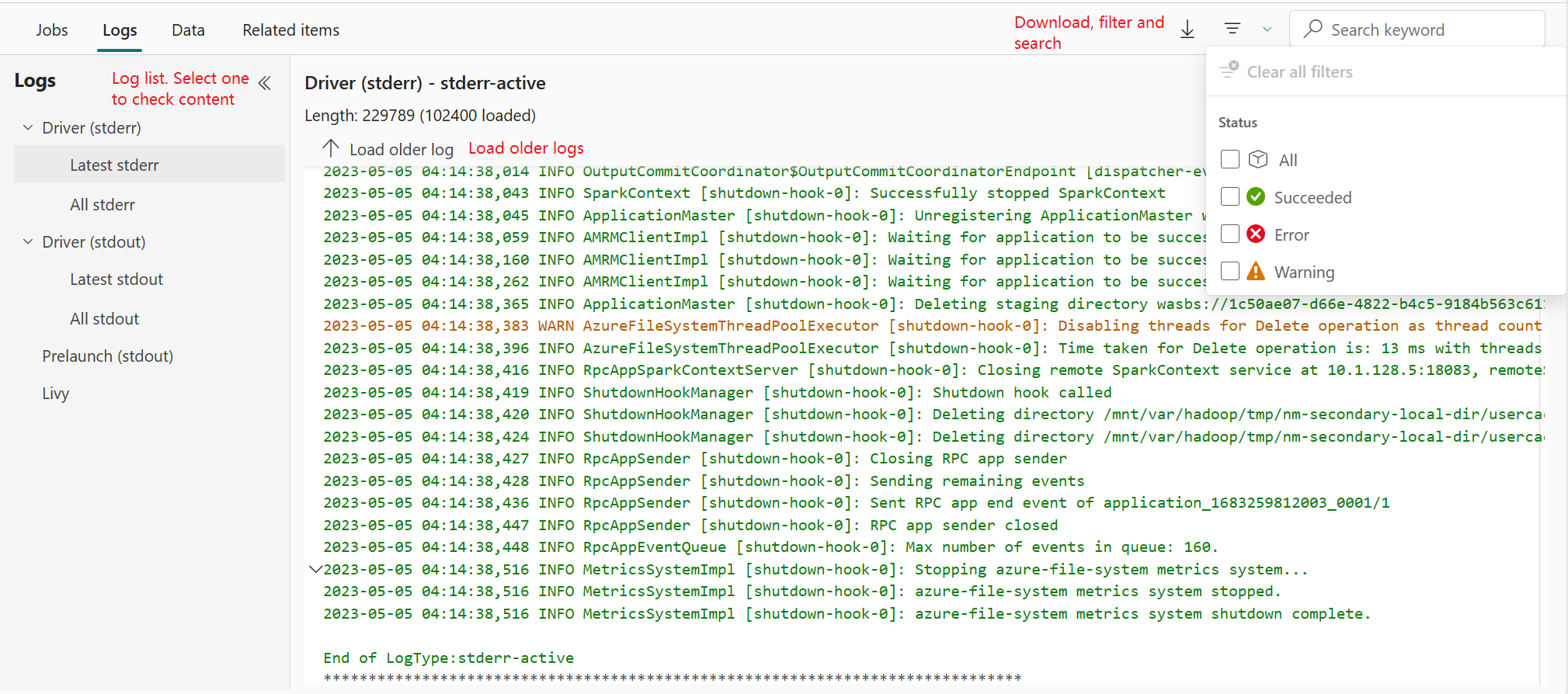

Registri

Per la scheda Log è possibile visualizzare il log completo del log Livy, Prelaunch, Driver con opzioni diverse selezionate nel pannello sinistro. È anche possibile recuperare direttamente le informazioni dei log necessarie eseguendo la ricerca di parole chiave e visualizzare i log filtrando lo stato dei log. Fare clic su Scarica log per scaricare le informazioni dei log in locale.

In alcuni casi non sono disponibili log, ad esempio lo stato del processo viene accodato e la creazione del cluster non è riuscita.

I log in tempo reale sono disponibili solo quando l'invio dell'app non riesce e vengono forniti anche i log dei driver.

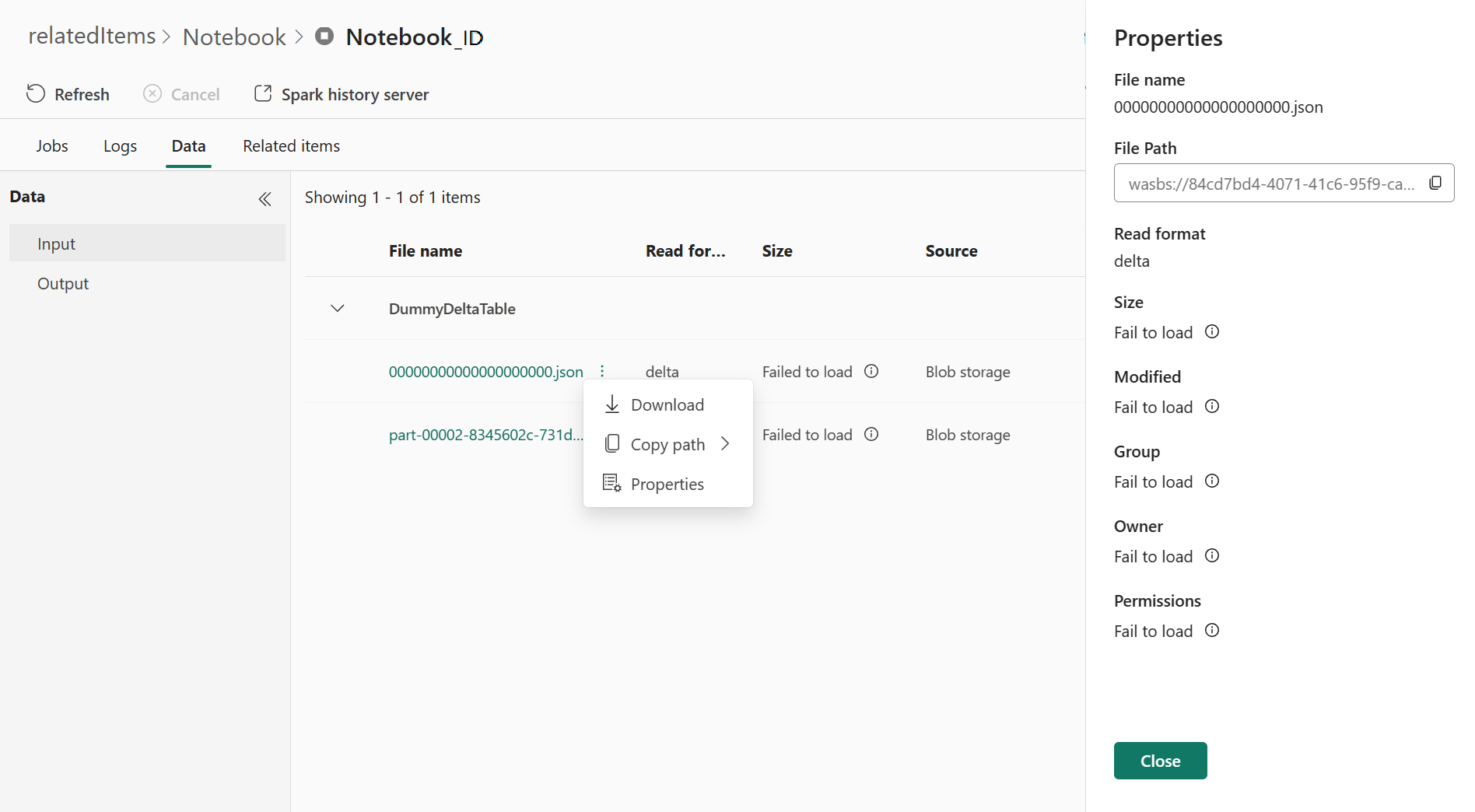

Dati

Per la scheda Dati, è possibile copiare l'elenco dei dati negli Appunti, scaricare l'elenco dei dati e dati singoli, e controllare le proprietà per ogni dato.

- Il pannello sinistro può essere espanso o compresso.

- Il nome, il formato di lettura, le dimensioni, l'origine e il percorso dei file di input e output verranno visualizzati in questo elenco.

- È possibile scaricare i file in input e output, copiare il percorso e visualizzare le proprietà.

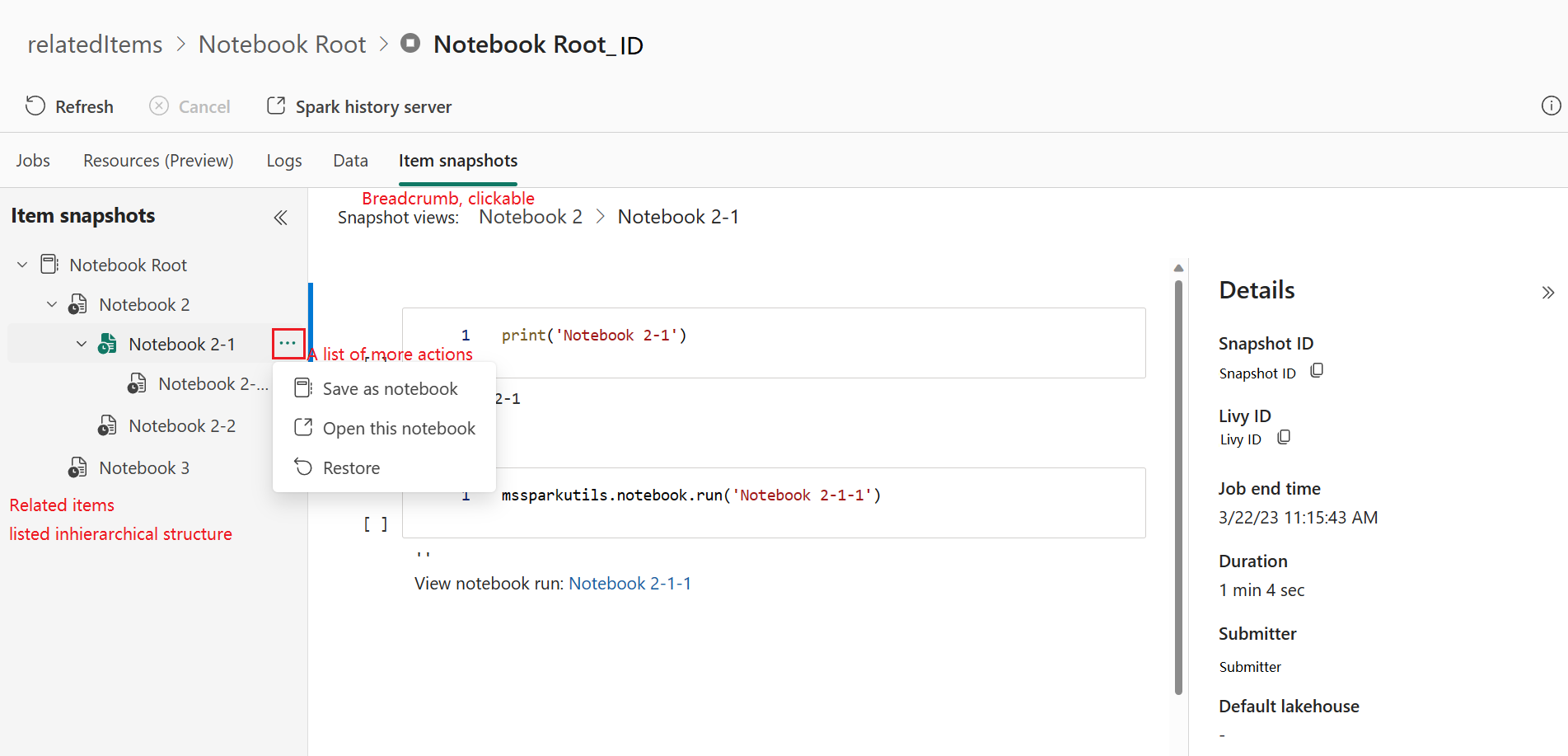

Snapshot degli elementi

La scheda Snapshot elemento consente di esplorare e visualizzare gli elementi associati all'applicazione Apache Spark, inclusi notebook, definizione del processo Spark e/o pipeline. La pagina snapshot dell'elemento visualizza lo snapshot del codice e dei valori dei parametri al momento dell'esecuzione per i notebook. Mostra anche lo snapshot di tutte le impostazioni e i parametri al momento dell'invio per le definizioni processo Spark. Se l'applicazione Apache Spark è associata a una pipeline, la pagina degli elementi correlati presenta anche la pipeline corrispondente e l'attività di Spark.

Nella schermata Snapshot elemento è possibile:

- Esplorare e spostarsi tra gli elementi correlati nell'albero gerarchico.

- Fare clic sull'icona con i puntini di sospensione "Elenco di altre azioni" per ogni elemento per eseguire azioni diverse.

- Fare clic sull'elemento snapshot per visualizzarne il contenuto.

- Visualizzare il percorso di navigazione per visualizzare il percorso dall'elemento selezionato alla radice.

Nota

La funzionalità Snapshot del notebook attualmente non supporta i notebook in stato di esecuzione o in una sessione Spark a concorrenza elevata.

Diagnostica

Il pannello di diagnostica fornisce agli utenti consigli e analisi degli errori in tempo reale generati da Spark Advisor tramite un'analisi del codice dell'utente. Con i modelli predefiniti, Apache Spark Advisor consente agli utenti di evitare errori comuni e di analizzare gli errori per identificare la causa radice.

Contenuto correlato

Il passaggio successivo dopo aver visualizzato i dettagli di un'applicazione Apache Spark consiste nel visualizzare lo stato del processo Spark sotto la cella Notebook. È possibile fare riferimento a: