Guida introduttiva: Creare la prima pipeline per copiare i dati

In questa guida introduttiva si crea una pipeline di dati per spostare un set di dati di esempio in Lakehouse. Questa esperienza mostra una rapida demo su come usare l'attività Copy della pipeline e come caricare i dati in Lakehouse.

Prerequisiti

Per iniziare, è necessario soddisfare i prerequisiti seguenti:

- Un account tenant Microsoft Fabric con una sottoscrizione attiva. Creare un account gratuito.

- Assicurarsi di disporre di un'area di lavoro abilitata per Microsoft Fabric: Creare un'area di lavoro.

Creazione di una pipeline di dati

Accedere a Power BI.

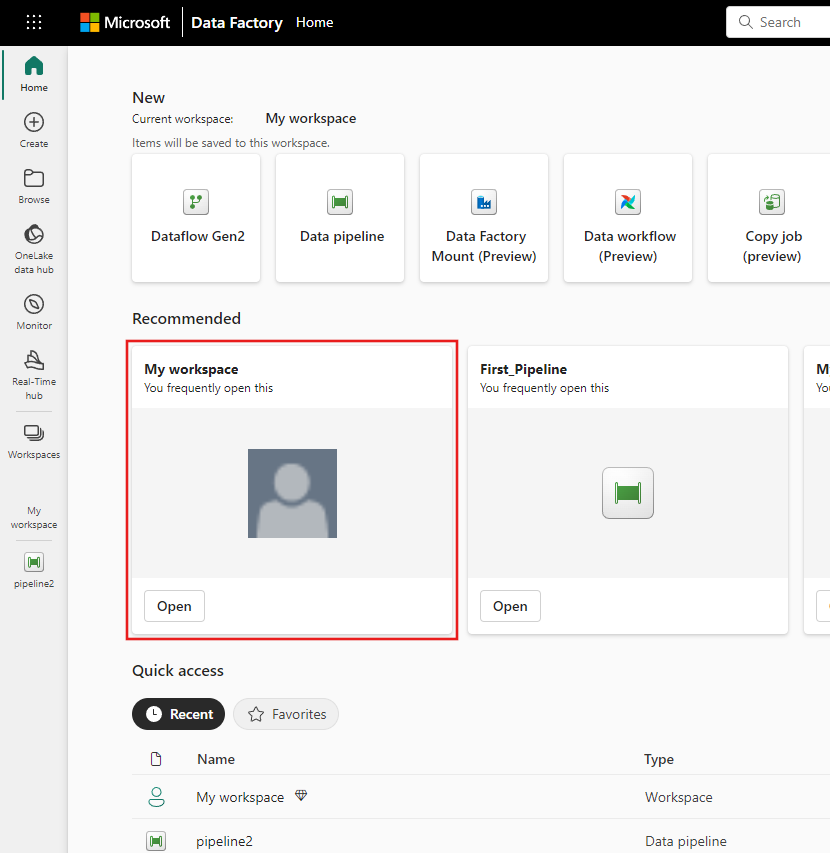

Selezionare l'icona di Power BI nella parte in basso a sinistra dello schermo, quindi selezionare Data Factory per aprire la home page di Data Factory.

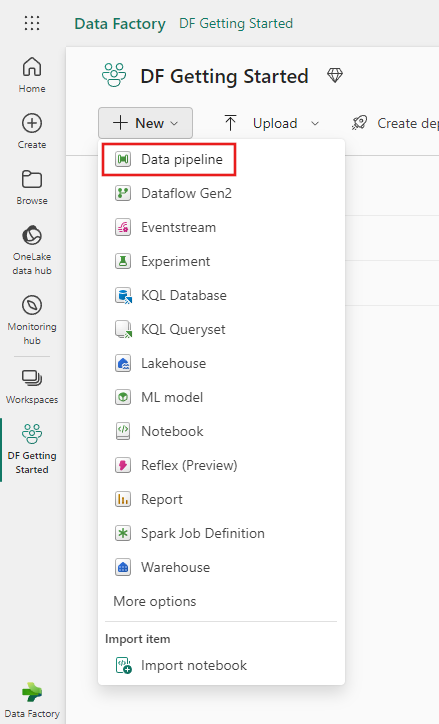

Accedere all'area di lavoro di Microsoft Fabric. Se hai già creato una nuova area di lavoro nella sezione precedente Prerequisiti, usare questa.

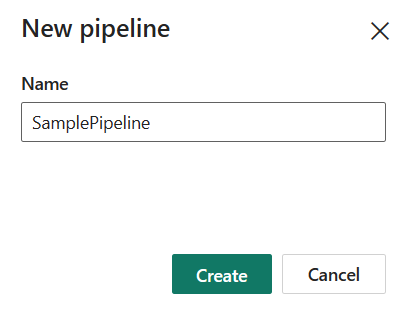

Selezionare Pipeline di dati e quindi immettere un nome di pipeline per creare una nuova pipeline.

Copiare i dati utilizzando la pipeline

In questa sessione si inizia a creare la prima pipeline personale seguendo i passaggi seguenti relativi alla copia da un set di dati di esempio fornito dalla pipeline in Lakehouse.

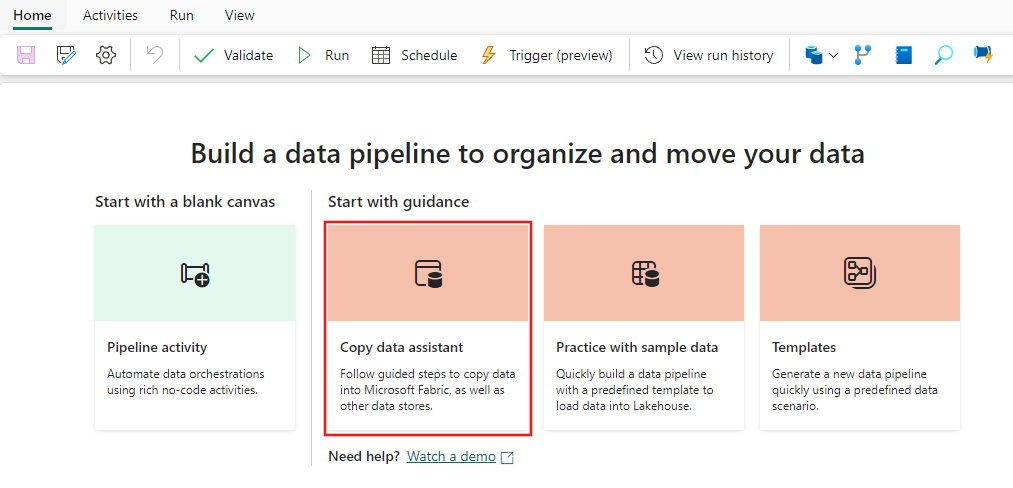

Passaggio 1: Iniziare con l'Assistente copia dati

Dopo avere selezionato Copia assistente dati nell'area di lavoro, lo strumento Assistente copia verrà aperto per iniziare.

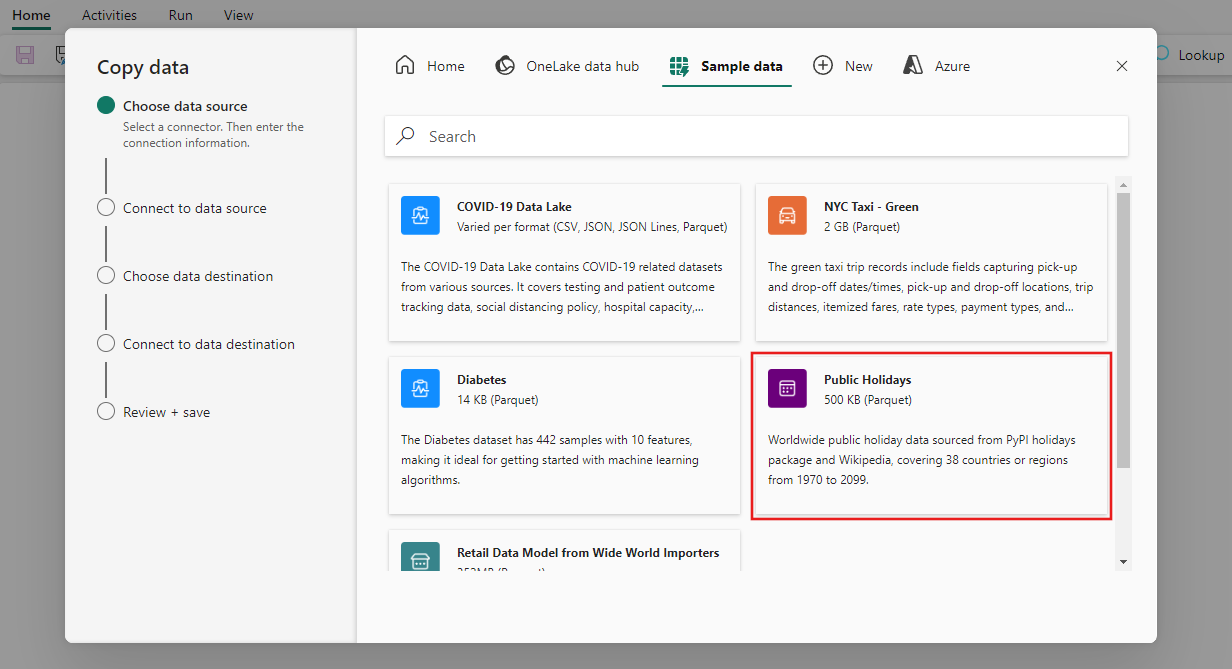

Passaggio 2: Configurare l'origine

Scegliere la scheda Dati di esempio nella parte superiore della pagina del browser dell'origine dati, quindi selezionare i dati di esempio Festività pubbliche e quindi Avanti.

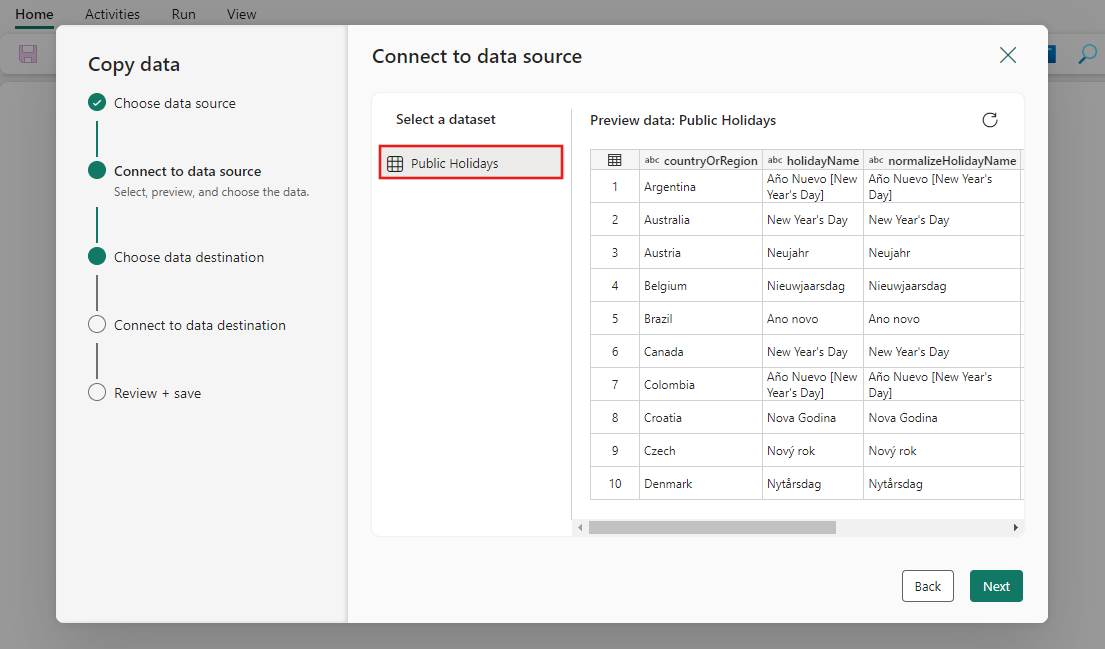

Nella pagina Connetti all'origine dati dell'assistente viene visualizzata l'anteprima per i dati di esempio festività pubbliche e quindi seleziona Avanti.

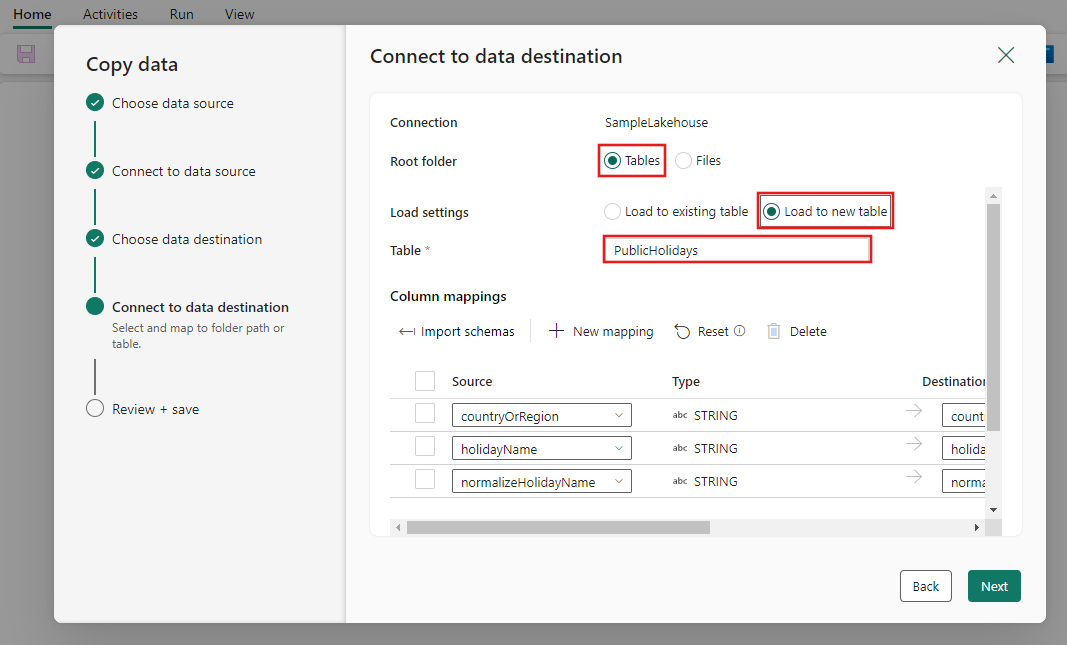

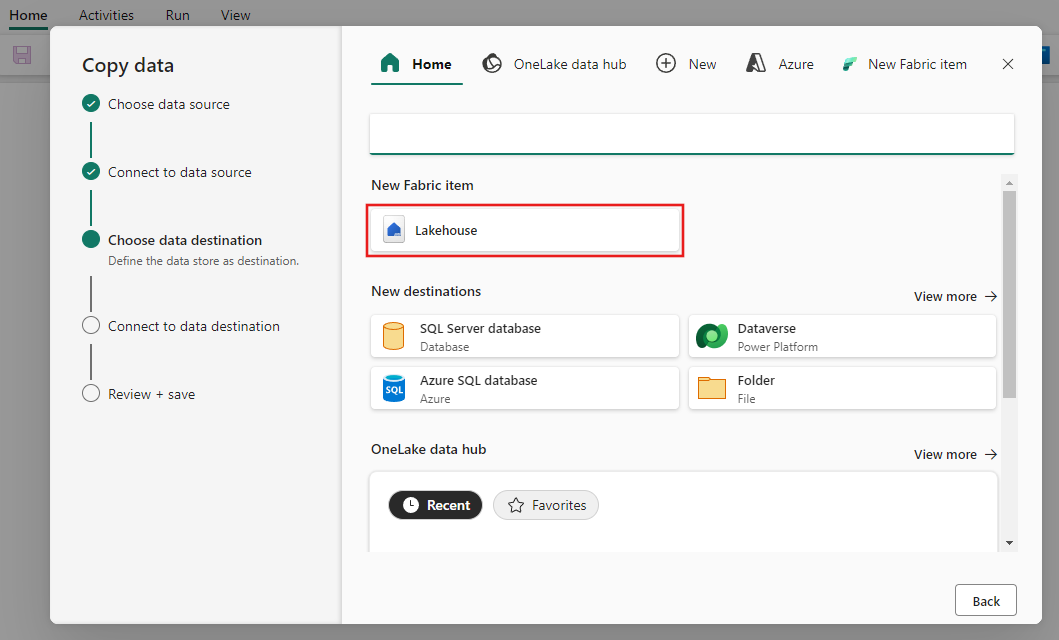

Passaggio 3: Configurare la destinazione

Selezionare Lakehouse e quindi Avanti.

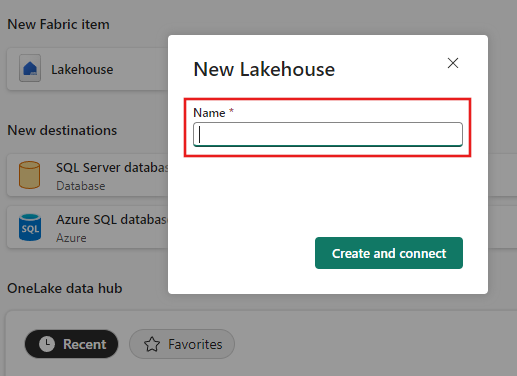

Immettere un nome Lakehouse, quindi selezionare Crea e connetti.

Configurare ed eseguire il mapping dei dati di origine alla tabella Lakehouse di destinazione. Selezionare Tabelle per la cartella Radice e Carica in una nuova tabella per Impostazioni di caricamento. Specificare un nome per la tabella e selezionare Avanti.

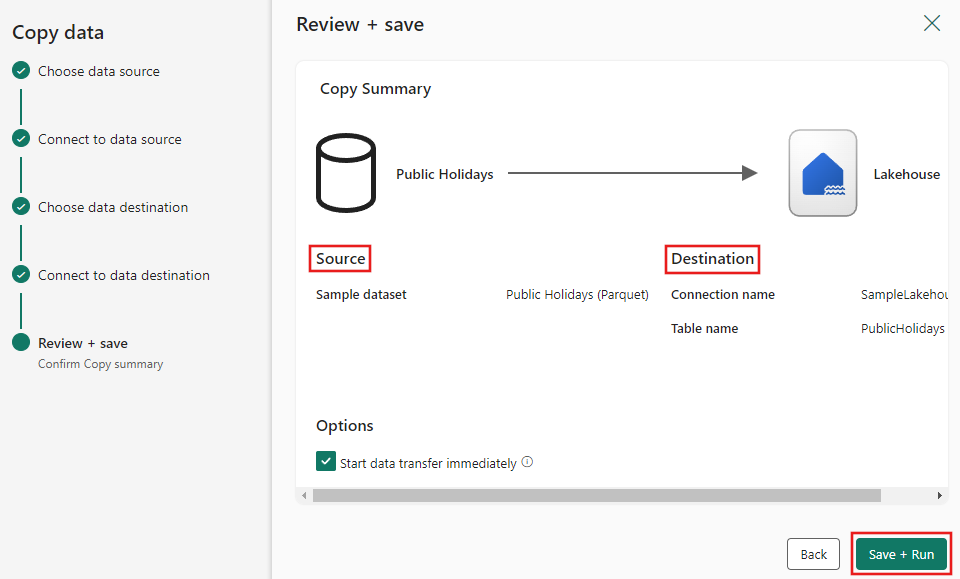

Passaggio 4: Esaminare e creare l'attività Copy

Esaminare le impostazioni dell'attività Copy nei passaggi precedenti e selezionare Salva ed Esegui per completare. In alternativa, è possibile rivedere i passaggi precedenti nello strumento per modificare le impostazioni, se necessario. Se si vuole solo salvare ma non eseguire la pipeline, è possibile deselezionare la casella di controllo Avvia trasferimento dati immediatamente.

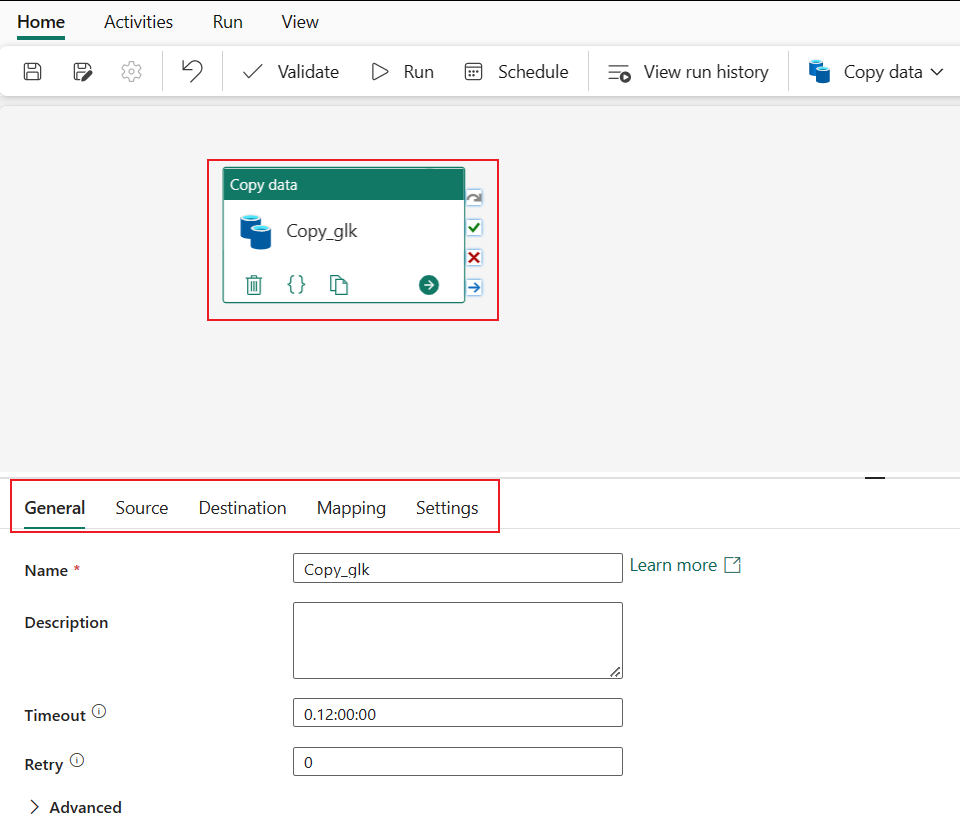

L’attività Copy viene aggiunta alla nuova area di lavoro della pipeline di dati. Tutte le impostazioni, incluse le impostazioni avanzate per l'attività, sono disponibili nelle schede sotto l'area di disegno della pipeline quando è selezionata l'attività Copia dati creata.

Eseguire e monitorare la pipeline di dati

Se non è stata scelta l'opzione Salva ed Esegui nella pagina Rivedi e salva dell'Assistente copia dati, passare alla scheda Home e selezionare Esegui. Viene visualizzata una finestra di dialogo di conferma. Selezionare quindi Salva ed esegui per avviare l'attività.

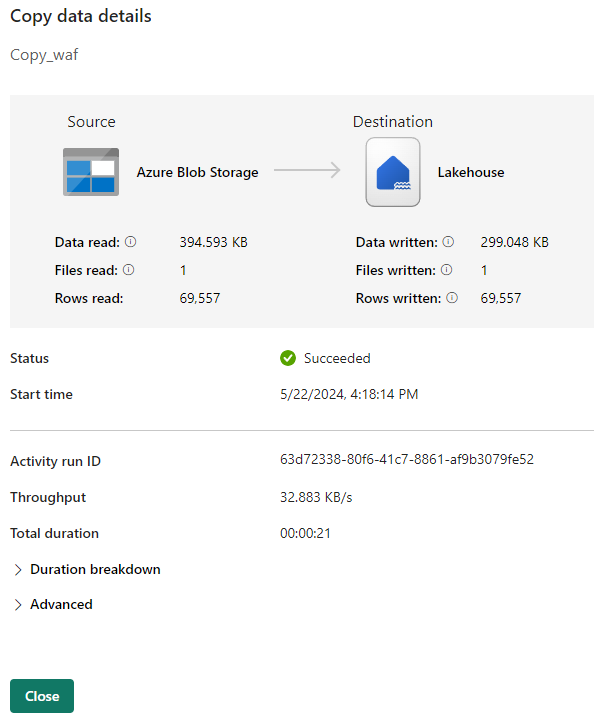

È possibile monitorare il processo in esecuzione e controllare i risultati nella scheda Output sotto l'area di lavoro della pipeline. Selezionare il collegamento per il nome dell'attività nell'output per visualizzare i dettagli dell'esecuzione.

I dettagli dell'esecuzione mostrano la quantità di dati letti e scritti e vari altri dettagli sull'esecuzione.

È anche possibile pianificare l'esecuzione della pipeline con una frequenza specifica in base alle esigenze. Di seguito è riportato un esempio che mostra una pianificazione per l'esecuzione della pipeline, impostata per essere eseguita ogni 15 minuti.

Contenuto correlato

La pipeline in questo esempio illustra come copiare i dati di esempio in Lakehouse. Contenuto del modulo:

- Creazione di una pipeline di dati.

- Copiare dati con l'Assistente copia.

- Eseguire e pianificare la pipeline di dati.

Passare quindi a altre informazioni sul monitoraggio delle esecuzioni della pipeline.