Come inserire dati in Fabric usando l'attività Copy di Azure Data Factory

Il connettore Microsoft Fabric Lakehouse in Azure Data Factory (ADF) e Azure Synapse Analytics consente operazioni sia di lettura sia di scrittura in Microsoft Fabric Lakehouse (per tabelle e file). Questo connettore consente di utilizzare le pipeline e i flussi di dati per mapping ADF e Synapse esistenti per interagire con Fabric Lakehouses. Questo articolo illustra come configurare Microsoft Fabric per consentire l'autenticazione dell'entità servizio e illustra il connettore Lakehouse per la lettura e la scrittura in Fabric Lakehouse.

Per altre informazioni su Lakehouse di Microsoft Fabric, si veda Che cos'è un lakehouse?

Connettore Lakehouse in Azure Data Factory

Un nuovo connettore di servizi collegati Lakehouse e due nuovi set di dati sono ora disponibili per i clienti che desiderano iniziare a leggere e scrivere in Microsoft Fabric Lakehouse. Per una guida completa sul connettore Lakehouse, si veda Copiare e trasformare i dati nei file Lakehouse di Microsoft Fabric (anteprima).

Autenticazione

Servizi collegati di Azure Data Factory

Il connettore Microsoft Fabric Lakehouse richiede una registrazione dell'entità servizio (SPN)/app per l'autenticazione. Per iniziare, è necessario creare un nuovo SPN o usarne uno esistente. Microsoft Fabric consente l'accesso SPN a gruppi di sicurezza specifici o all'intera organizzazione. Se l'opzione utilizzata dall'organizzazione è un gruppo di sicurezza specifico, l'SPN utilizzato nel connettore Lakehouse deve appartenere a un gruppo di sicurezza aggiunto all'elenco elementi consenti.

Nota

Le autorizzazioni API Power BI (delegate) non sono necessarie

Accesso a API Power BI

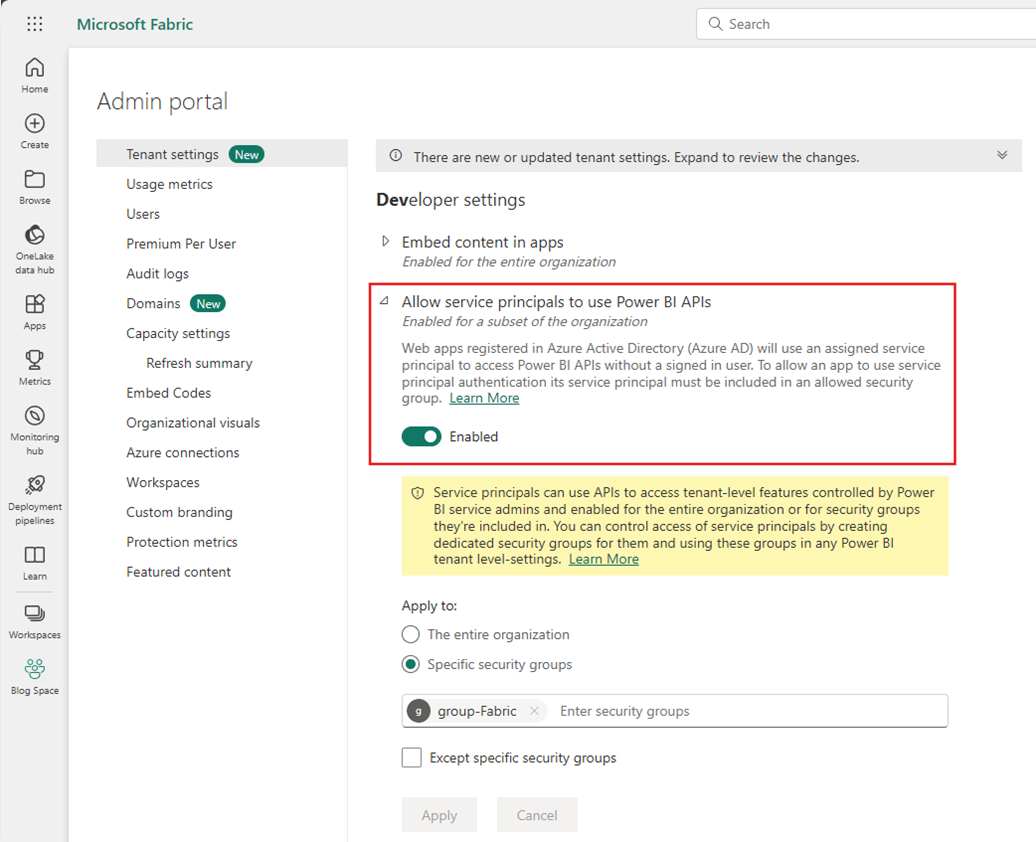

Nel portale di amministrazione di Power BI, l’amministratore tenant di Power BI deve abilitare Consenti alle entità servizio di usare le API Power BI. Il gruppo di sicurezza deve essere specificato nell'impostazione Consenti alle entità servizio di usare le API di Power BI oppure l’opzione può essere abilitata per l’intera organizzazione.

Per una guida completa, si veda Incorporare contenuto di Power BI in un'applicazione di analisi incorporata con un'entità servizio e un segreto dell'applicazione.

Nota

Quando si assegna il gruppo di sicurezza all'area di lavoro, potrebbe verificarsi un ritardo nell’assegnare all'entità servizio l'accesso all'area di lavoro, ritardo dovuto alla cache delle autorizzazioni in Azure. Se è necessario l'accesso immediato, usare PowerShell per forzare un aggiornamento delle autorizzazioni dell'utente. A tale scopo, aprire Windows PowerShell come amministratore ed eseguire i seguenti comandi:

Install-Module -Name MicrosoftPowerBIMgmt

Connect-PowerBIServiceAccount -Tenant '<TENANT ID>' -ServicePrincipal -Credential (Get-Credential)

Get-PowerBIWorkspace

Invoke-PowerBIRestMethod -URL 'https://api.powerbi.com/v1.0/myorg/RefreshUserPermissions' -Method Post -Body ''

Get-PowerBIWorkspace

Accesso all'area di lavoro

Dopo aver aggiunto il gruppo di sicurezza, occorre aggiungere anche il gruppo di sicurezza o l'entità servizio a ogni area di lavoro con la qualità di membro, collaboratore o amministratore. Per altri dettagli, si veda Concedere agli utenti l'accesso alle aree di lavoro .

Demo: Configurare l'autenticazione

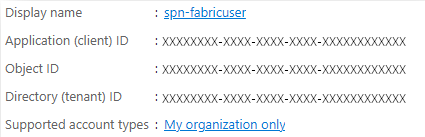

Entità servizio registrazione app

Creare un'entità servizio di registrazione app o usarne una esistente. Seguire la procedura per Registrare un'applicazione con Microsoft Entra ID e creare un'entità servizio.

Nota

Non è necessario assegnare un URI di reindirizzamento.

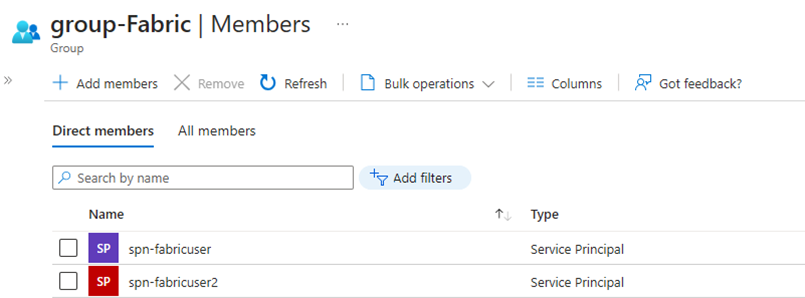

Gruppo di sicurezza

Creare un nuovo gruppo di sicurezza di Microsoft Entra o usarne uno esistente, poi aggiungervi il nome SPN. Seguire la procedura Creare un gruppo di base e aggiungere membri con Microsoft Entra ID per creare un gruppo di sicurezza di Microsoft Entra.

Portale di amministrazione di Power BI

Dal portale di amministrazione di Power BI passare a Impostazioni sviluppatore e selezionare Consenti alle entità servizio di usare API Power BI e poi abilitare l’opzione. Successivamente, aggiungere il gruppo di sicurezza del passaggio precedente. Per altre informazioni, sulle impostazioni del tenant del portale di amministrazione di Power BI, si veda Impostazioni del tenant.

Nota

Assicurarsi che l'impostazione Gli utenti possono accedere ai dati archiviati in OneLake con app esterne a Fabric sia abilitata. Fare riferimento a Consentire alle app in esecuzione al di fuori di Fabric di accedere ai dati tramite OneLake.

Area di lavoro

Aggiungere l'SPN o il gruppo di servizi all'area di lavoro con accesso come membro, collaboratore o amministratore.

Azure Data Factory: Servizi collegati

Da Azure Data Factory creare un nuovo servizio collegato Microsoft Fabric Lakehouse.

Nota

Per trovare l'area di lavoro e gli ID Lakehouse, passare a Fabric Lakehouse e identificarlo dall'URL. Ad esempio: https://.../groups/<ID area di lavoro>>/lakehouses/<ID Lakehouse>

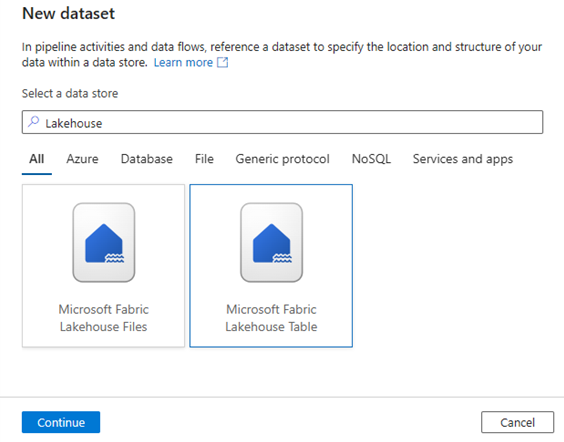

Azure Data Factory: Set di dati

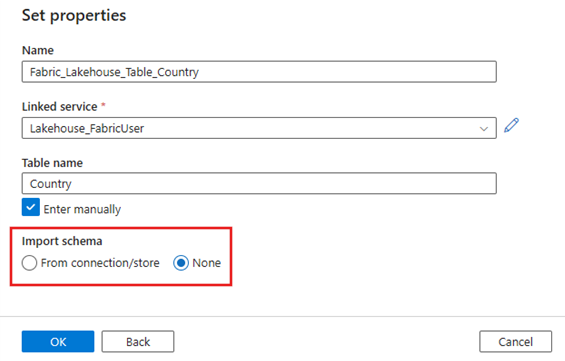

Creare un set di dati che faccia riferimento al servizio collegato Microsoft Fabric Lakehouse.

Nota

Selezionare Nessuno per l'opzione Importa schema se la tabella non esiste ancora e si sta specificando manualmente un nuovo nome di tabella.

Demo: Scrivere in una tabella di Fabric Lakehouse con una pipeline di Azure Data Factory

Origine

Creare una nuova pipeline e aggiungere un’attività Copy all'area di lavoro della pipeline. Nella scheda Origine dell’attività Copy selezionare un set di dati di origine da spostare in una tabella Lakehouse. In questo esempio si fa riferimento a un file .csv proveniente da un account Azure Data Lake Storage (ADLS) Gen2.

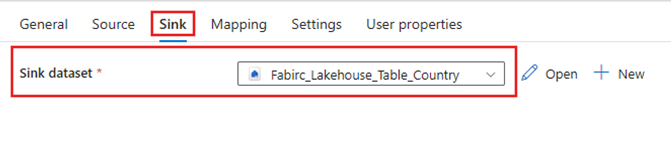

Sink

Passare alla scheda Sink dell’attività Copy e selezionare il set di dati di Fabric Lakehouse creato in precedenza.

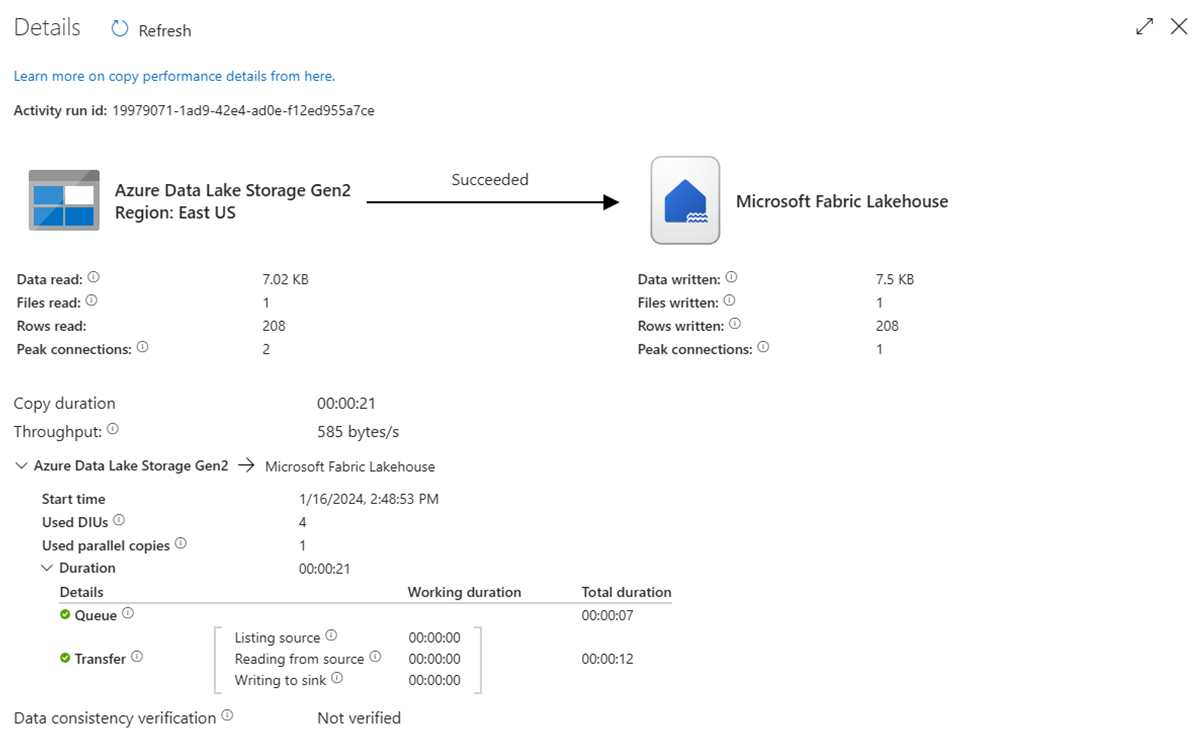

Eseguire la pipeline

Eseguire la pipeline per spostare i dati .csv nella tabella Fabric Lakehouse.

Demo: Leggere da una tabella di Fabric Lakehouse con una pipeline di Azure Data Factory

Nella sezione precedente è stato illustrato come usare Azure Data Factory per scrivere in una tabella Fabric Lakehouse. A questo punto, è possibile leggere da una tabella Fabric Lakehouse e scrivere in un file Parquet in Azure Data Lake Storage (ADLS) Gen2 con una pipeline simile.

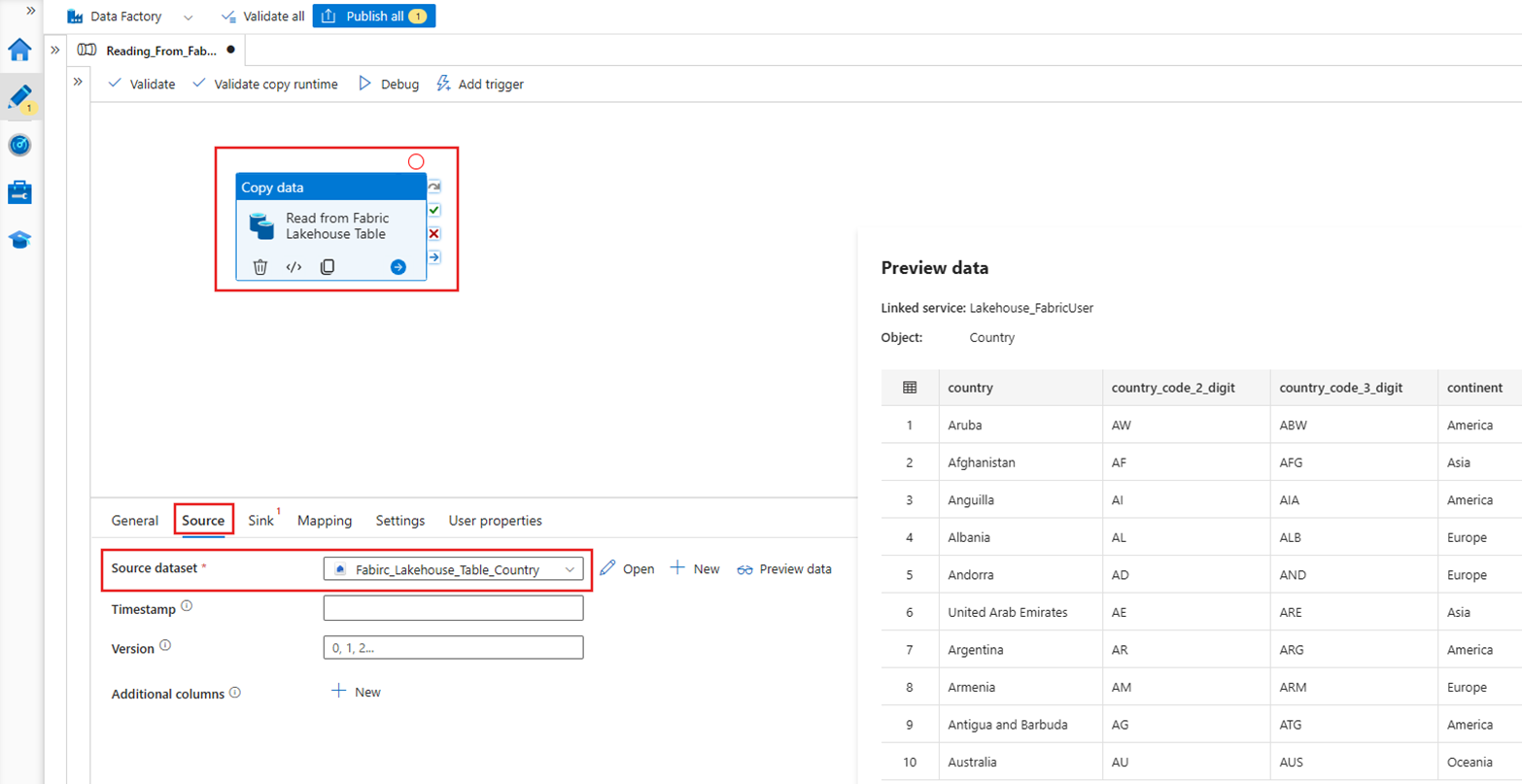

Origine

Creare una nuova pipeline e aggiungere un’attività Copy all'area di lavoro della pipeline. Nella scheda Origine dell'attività Copy, selezionare il set di dati Fabric Lakehouse precedentemente creato.

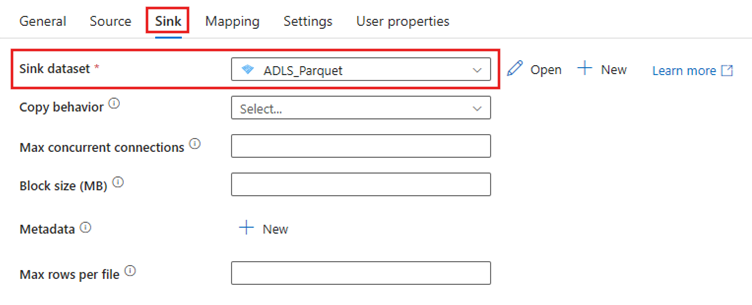

Sink

Passare alla scheda Sink dell'attività Copy e selezionare il set di dati di destinazione. In questo esempio la destinazione è Azure Data Lake Storage (Gen2), come file Parquet.

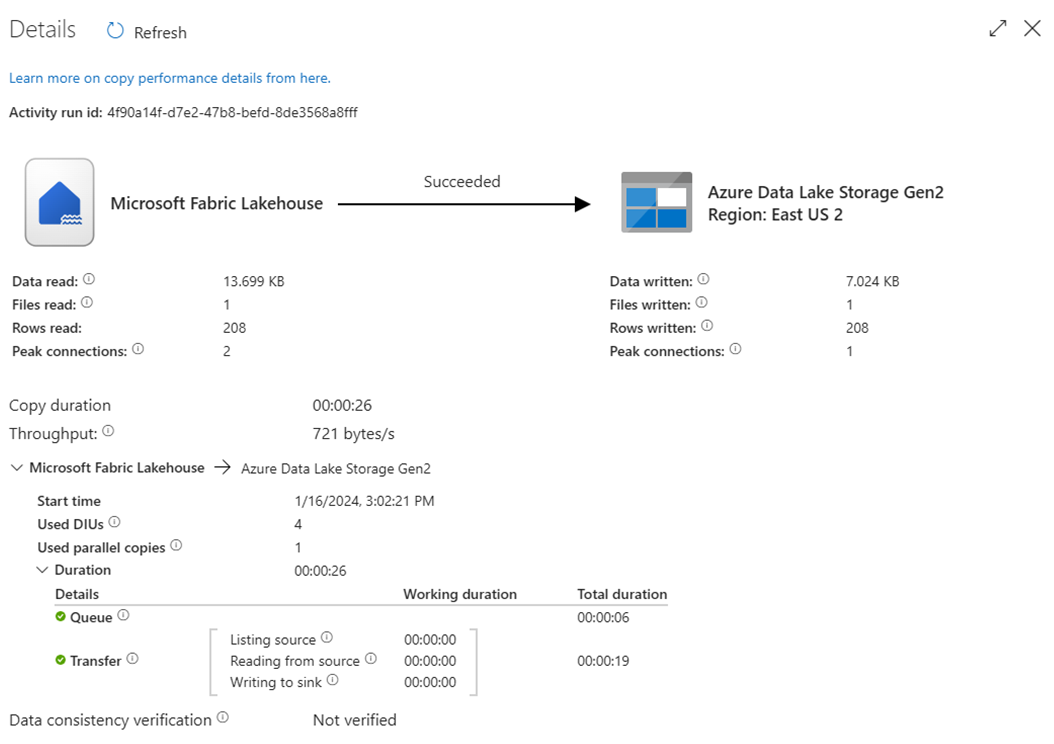

Eseguire la pipeline

Eseguire la pipeline per spostare i dati dalla tabella Fabric Lakehouse nel file Parquet in ADLS Gen2.

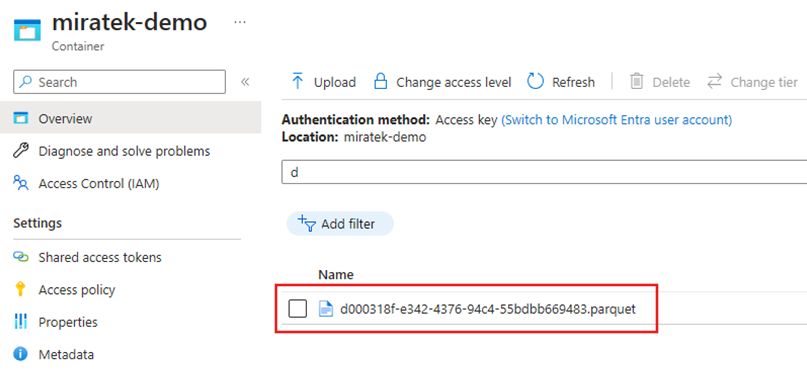

Ispezionare il file Parquet in ADLS Gen2

Adesso i dati della tabella Fabric Lakehouse sono disponibili in ADLS Gen2 come file Parquet.

Riepilogo

In questa sezione sono stati esaminati i requisiti per il connettore Lakehouse utilizzando l'autenticazione dell'entità servizio in Microsoft Fabric Lakehouse, poi è stato illustrato un esempio per la lettura e la scrittura in Lakehouse da una pipeline di Azure Data Factory. Il connettore e le funzionalità sono disponibili anche nel flusso di dati per il mapping di Azure Data Factory, in Azure Synapse Analytics e nel flusso di dati per il mapping di Azure Synapse Analytics.