Scenario di determinazione dei prezzi con Dataflow Gen2 per caricare 2 GB di dati Parquet in una tabella Lakehouse

In questo scenario, Dataflow Gen2 è stato usato per caricare 2 GB di dati Parquet archiviati in Azure Data Lake Storage (ADLS) Gen2 in una tabella Lakehouse in Microsoft Fabric. Sono stati usati i dati di esempio NYC Taxi-green per i dati Parquet.

I prezzi usati nel seguente esempio sono ipotetici e non intendono indicare l'esatto prezzo reale. Servono solo a dimostrare come è possibile stimare, pianificare e gestire i costi dei progetti Data Factory in Microsoft Fabric. Inoltre, poiché le capacità di Fabric hanno prezzi specifici per ogni regione, vengono usati i prezzi con pagamento in base al consumo per una capacità infrastruttura negli Stati Uniti occidentali 2 (una tipica area di Azure), a $0,18 per CU all'ora. Fare riferimento qui a Microsoft Fabric - Prezzi per esplorare altre opzioni di determinazione dei prezzi della capacità di Fabric.

Impostazione

Per eseguire lo scenario è necessario creare una pipeline con i seguenti elementi:

- Inizializzare il flusso di dati: ottenere dati di file Parquet da 2 GB dall'account di archiviazione di ADLS Gen2.

- Configurare Power Query:

- Spostarsi a Power Query.

- Verificare che l’opzione per la gestione temporanea della query sia abilitata.

- Procedere con la combinazione dei file Parquet.

- Trasformazione dei dati:

- Aumentare di livello le intestazioni per una maggior chiarezza.

- Rimuovere le colonne non necessarie.

- Regolare i tipi di dati della colonna in base alle esigenze.

- Definire la destinazione dei dati di output:

- Configurare Lakehouse come destinazione di output dei dati.

- In questo esempio è stato creato e utilizzato un Lakehouse all’interno di Fabric.

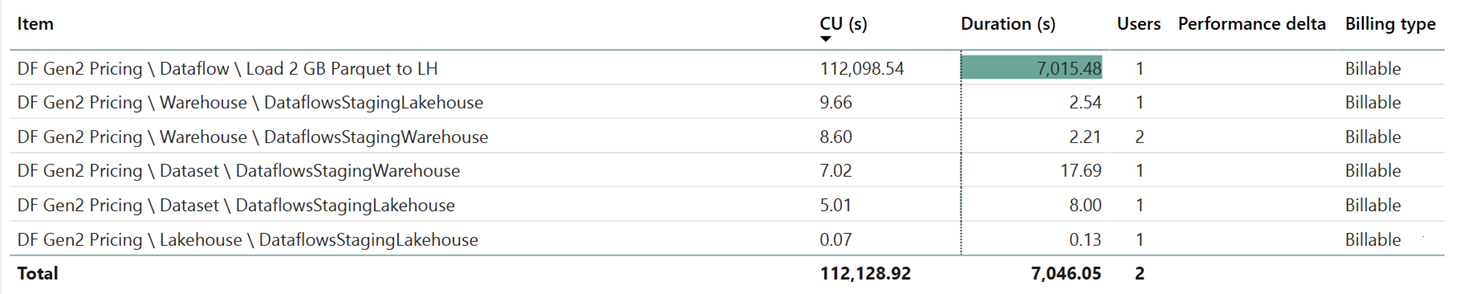

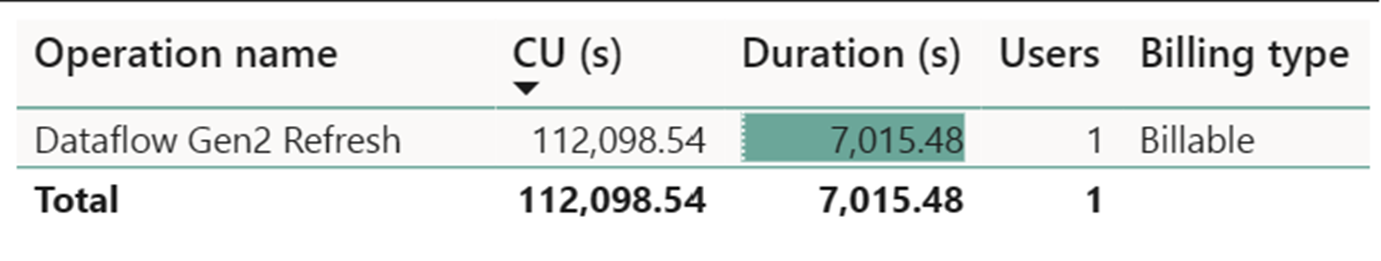

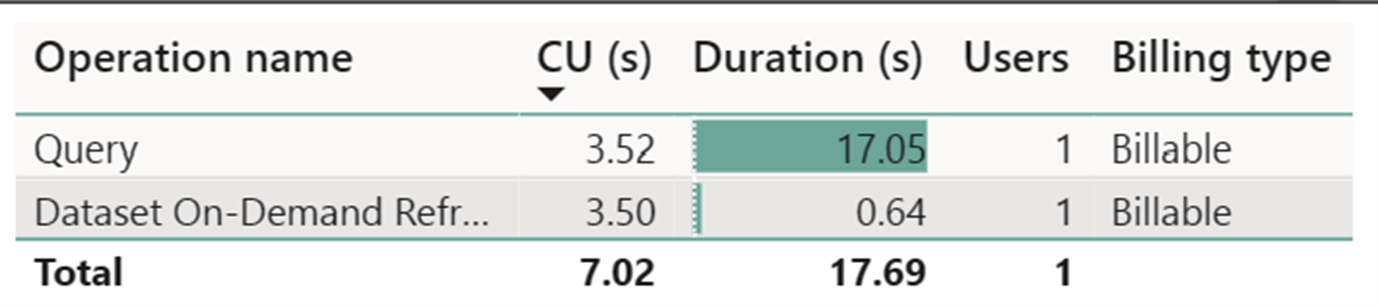

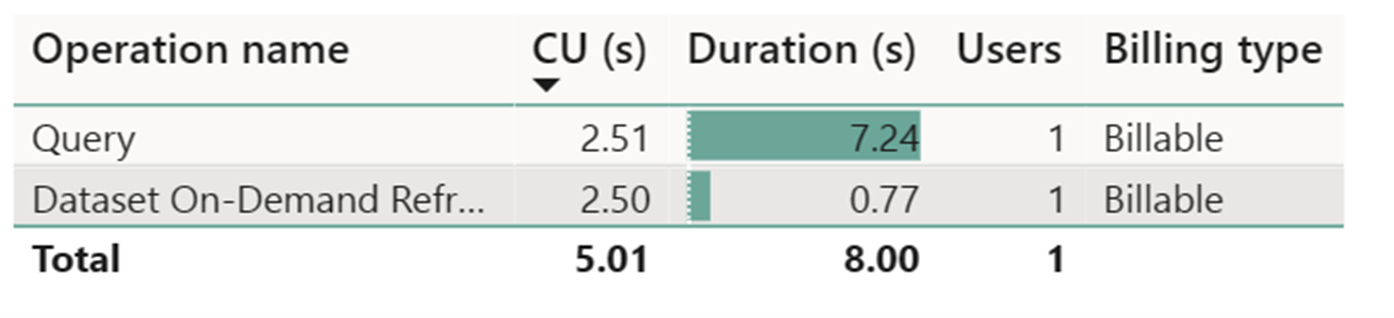

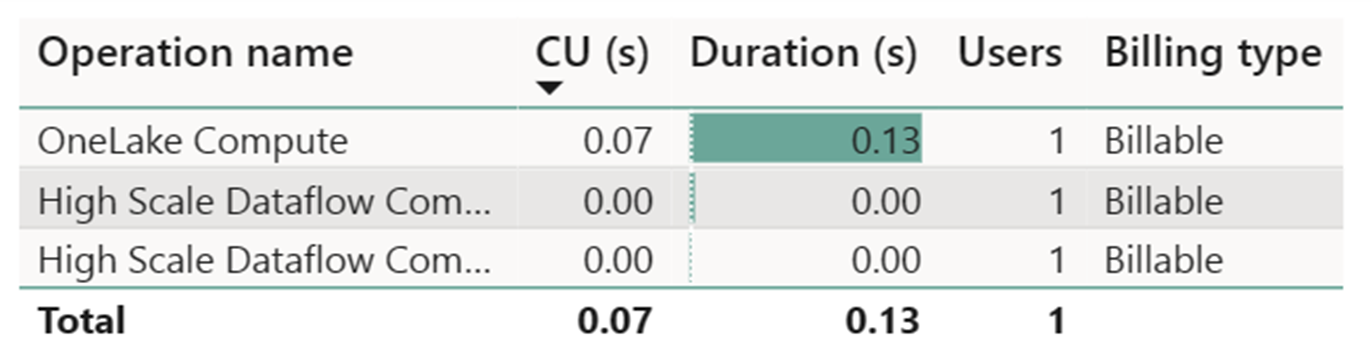

Stima dei costi con l'app Fabric Metrics

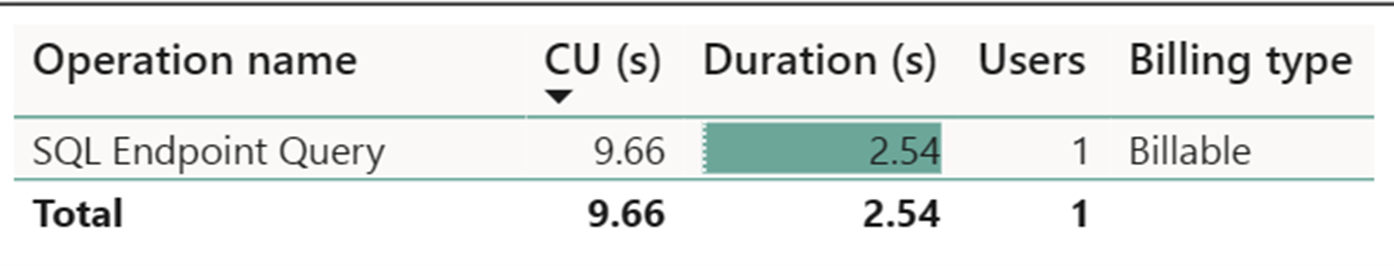

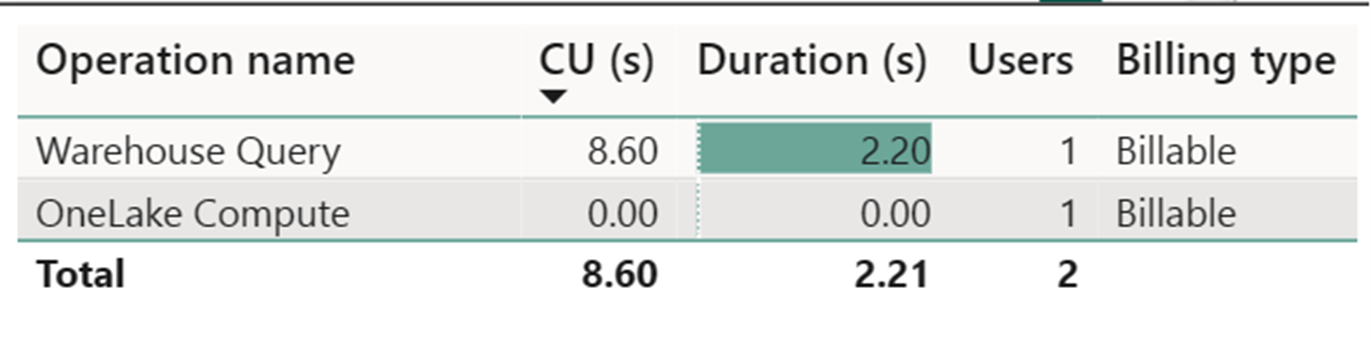

Il contatore di calcolo del flusso di dati a scalabilità elevata ha registrato un’attività trascurabile. Il contatore di calcolo standard per le operazioni di aggiornamento di Dataflow Gen2 usa 112.098,540 unità di calcolo (CU). È importante considerare che altre operazioni, tra cui Query warehouse, query dell'endpoint SQL e aggiornamento on demand del set di dati, costituiscono aspetti dettagliati dell'implementazione di Dataflow Gen2 attualmente trasparenti e necessarie per le rispettive operazioni. Tuttavia, queste operazioni verranno nascoste negli aggiornamenti futuri e devono essere ignorate quando si stimano i costi per Dataflow Gen2.

Nota

Anche se segnalata come metrica, la durata effettiva dell'esecuzione non è rilevante quando si calcolano le ore CU effettive con l'app Fabric Metrics la metrica dei secondi CU segnala già la durata.

| Metric | Livello di calcolo Standard | Calcolo su larga scala |

|---|---|---|

| Totale secondi CU | 112.098,54 SECONDI CU | 0 secondi |

| Ore CU effettive fatturate | 112.098,54 / (60*60) = 31,14 ORE CU | 0 / (60*60) = 0 ore cu |

Costo totale esecuzione a $0,18/ore-CU = (31,14 ore-CU) * ($0,18/ore-CU) ~= $5,60