Scenario dei prezzi per il caricamento di 1 TB di dati Parquet in un data warehouse mediante una pipeline di dati

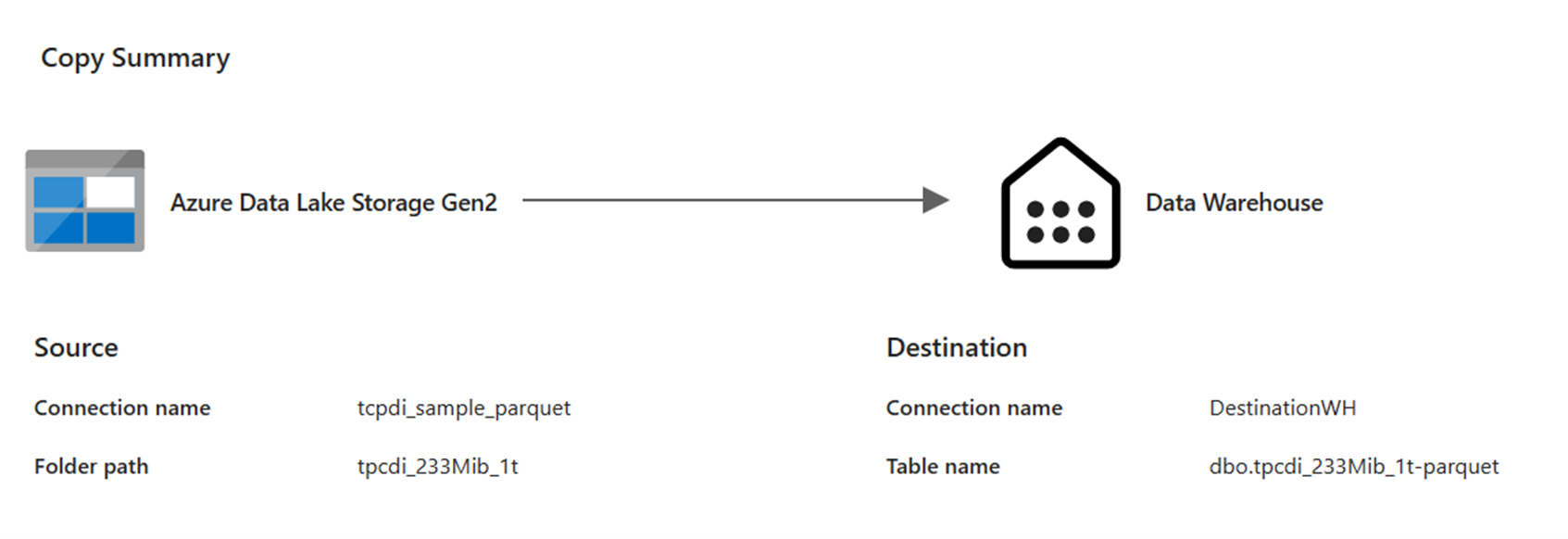

In questo scenario è stata usata un’attività Copy in una pipeline di dati per caricare 1 TB di dati di tabella Parquet archiviati in Azure Data Lake Storage (ADLS) Gen2 in un data warehouse di Microsoft Fabric.

I prezzi usati nel seguente esempio sono ipotetici e non intendono indicare l'esatto prezzo reale. Servono solo a dimostrare come è possibile stimare, pianificare e gestire i costi dei progetti Data Factory in Microsoft Fabric. Inoltre, poiché le capacità di Fabric hanno prezzi specifici per ogni regione, vengono usati i prezzi con pagamento in base al consumo per una capacità infrastruttura negli Stati Uniti occidentali 2 (una tipica area di Azure), a $0,18 per CU all'ora. Fare riferimento qui a Microsoft Fabric - Prezzi per esplorare altre opzioni di determinazione dei prezzi della capacità di Fabric.

Impostazione

Per eseguire questo scenario è necessario creare una pipeline con la seguente configurazione:

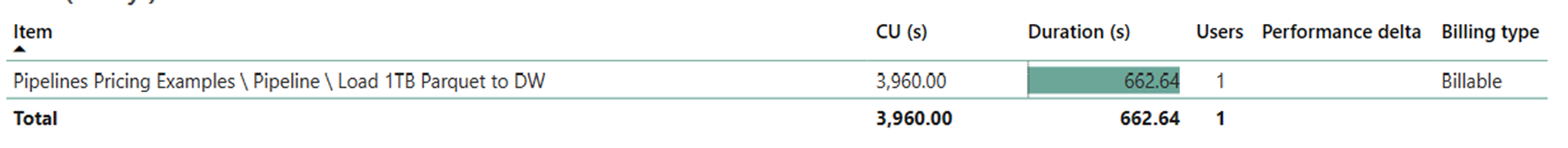

Stima dei costi con l'app Fabric Metrics

L’operazione di spostamento dei dati ha utilizzato 3.960 secondi CU con una durata di 662,64 secondi, mentre l’operazione di esecuzione dell'attività è null perché non sono state eseguite attività non di copia nell'esecuzione della pipeline.

Nota

Anche se segnalata come metrica, la durata effettiva dell'esecuzione non è rilevante quando si calcolano le ore CU effettive con l'app Fabric Metrics la metrica dei secondi CU segnala già la durata.

| Metric | Operazione di spostamento dati |

|---|---|

| Secondi CU | 3.960 secondi CU |

| Orario CU effettivo | (3.960) / (60*60) ore-CU = 1,1 ore-CU |

Costo totale esecuzione a $0,18/ore-CU = (1,1 CU-ore) * ($0,18/ore-CU) ~= $0,20