GitHub モデルから Azure AI モデル推論サービスにアップグレードする

生成 AI アプリケーションを開発する場合は、GitHub モデルを使用して AI モデルを検索して無料で実験できます。 プレイグラウンドと無料の API の使用には、1 分あたりの要求数、1 日あたりの要求数、要求あたりのトークン数、同時要求数のレート制限があります。 レート制限を受けた場合、さらに要求を行うには、該当したレート制限がリセットされるまで待つ必要があります。

アプリケーションを運用環境に移行する準備ができたら、Azure AI サービス リソースを Azure サブスクリプションにデプロイしてエクスペリエンスをアップグレードして、Azure AI モデル推論サービスの使用を開始できます。 コードで他に変更する必要はありません。

次の記事では、Azure AI サービス用の Azure AI モデルで GitHub モデルから作業を開始する方法について説明します。

前提条件

このチュートリアルを完了するには、以下が必要です。

GitHub モデルにアクセスできる GitHub アカウント。

Azure サブスクリプション。 お持ちでない場合は、モデルを運用環境にデプロイする準備ができたときに、Azure アカウントを作成するか、従量課金制アカウントに更新するように求められます。

Azure AI サービスへのアップグレード

プレイグラウンドと無料 API の使用のレート制限は、モデルでの実験や AI アプリケーションの開発に役立ちます。 アプリケーションを運用環境に移行する準備ができたら、有料の Azure アカウントのキーとエンドポイントを使用します。 コードで他に変更する必要はありません。

キーとエンドポイントを取得するには:

モデルのプレイグラウンドで、[API キーの取得] を選択します。

[運用キーの取得] を選択します。

Azure アカウントをお持ちでない場合は、[アカウントの作成] を選択し、手順に従ってアカウントを作成します。

Azure アカウントをお持ちの場合は、[もう一度サインインする] を選択します。

既存のアカウントが無料アカウントの場合は、まず従量課金制プランにアップグレードする必要があります。 アップグレードしたら、プレイグラウンドに戻り、もう一度 [API キーの取得] を選択し、アップグレードしたアカウントでサインインします。

Azure アカウントにサインインすると、Azure AI Foundry が表示されます。

ページの上部にある、[GitHub AI リソースに移動] を選択して、Azure AI Foundry / Github](https://ai.azure.com/github) に移動します。 Azure AI Foundry ポータルに初期モデルの詳細を読み込むには、1 分から 2 分かかる場合があります。

ページにはモデルの詳細が読み込まれます。 [デプロイの作成] ボタンを選択して、モデルをアカウントにデプロイします。

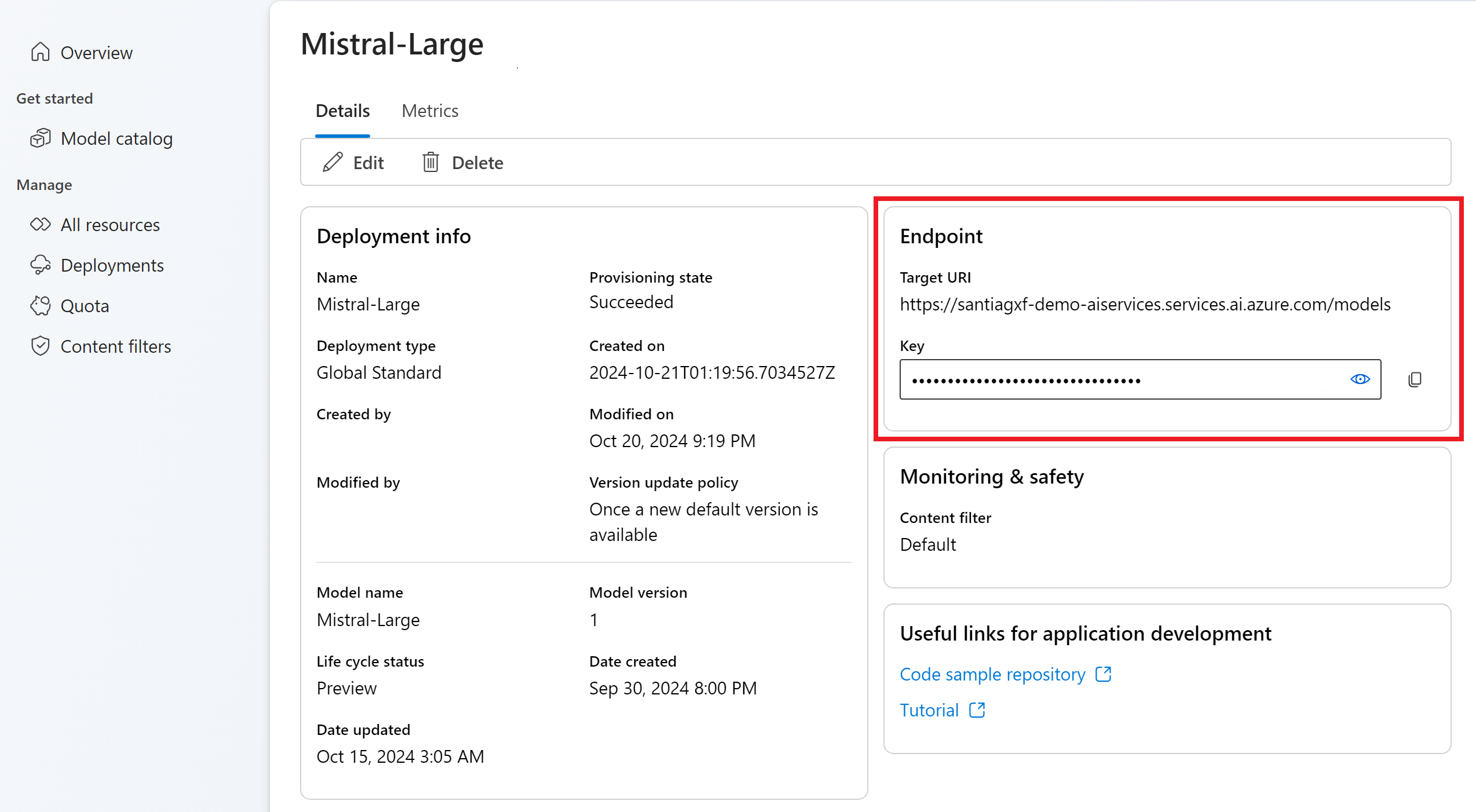

デプロイが完了すると、モデルの API キーとエンドポイントが [概要] に表示されます。 運用環境でモデルを使用するには、コード内でこれらの値を使用します。

この時点で、選択したモデルを使用する準備は整っています。

ヒント

パラメーター model="<deployment-name> を使用して、要求をこのデプロイにルーティングします。 デプロイは、特定の構成下で特定のモデルのエイリアスとして機能します。 Azure AI サービスがデプロイをルーティングする方法については、ルーティングの概念ページを参照してください。

新しいエンドポイントを使用するようにコードをアップグレードする

Azure AI サービス リソースが構成されたら、コードからそのリソースの使用を開始できます。 エンドポイント URL とそのキーが必要です。これは、[概要] セクションで確認できます。

サポートされている SDK のいずれかを使用して、エンドポイントから予測を取得できます。 次の SDK が正式にサポートされています。

- OpenAI SDK

- Azure OpenAI SDK

- Azure AI 推論 SDK

詳細と例については、サポートされている言語と SDK のセクションを参照してください。 次の例は、新しくデプロイされたモデルで Azure AI モデル推論 SDK を使用する方法を示しています。

pip のように、パッケージ マネージャーを使用してパッケージ azure-ai-inference をインストールします。

pip install azure-ai-inference>=1.0.0b5

警告

Azure AI サービス リソースには、Python のバージョン azure-ai-inference>=1.0.0b5 が必要です。

その後、パッケージを使用してモデルを使用できます。 次の例では、チャット入力候補を使用してクライアントを作成する方法を示します。

import os

from azure.ai.inference import ChatCompletionsClient

from azure.core.credentials import AzureKeyCredential

client = ChatCompletionsClient(

endpoint=os.environ["AZUREAI_ENDPOINT_URL"],

credential=AzureKeyCredential(os.environ["AZUREAI_ENDPOINT_KEY"]),

)

サンプルを確認し、API リファレンス ドキュメントを参照して、作業を開始してください。

最初のチャット補完を生成します。

from azure.ai.inference.models import SystemMessage, UserMessage

response = client.complete(

messages=[

SystemMessage(content="You are a helpful assistant."),

UserMessage(content="Explain Riemann's conjecture in 1 paragraph"),

],

model="mistral-large"

)

print(response.choices[0].message.content)

その他の機能を確認する

Azure AI モデル推論は、GitHub モデルでは使用できない次のような機能をサポートしています。

- モデル カタログを参照して、GitHub モデルでは使用できない他のモデルを確認します。

- コンテンツ フィルタリングを構成します。

- レート制限を構成します (特定のモデルの場合)。

- その他のデプロイ SKU (特定のモデル用) を確認します。

- プライベート ネットワークを構成します。

問題が発生しましたか?

その他のヘルプについては、FAQ セクションを参照してください。

次のステップ

- エンドポイントにさらにモデルを追加します。

- Azure AI Foundry ポータルでモデル カタログについて確認する。