Azure AI Studio のモデル ベンチマーク

重要

この記事で "(プレビュー)" と付記されている項目は、現在、パブリック プレビュー段階です。 このプレビューはサービス レベル アグリーメントなしで提供されており、運用環境ではお勧めしません。 特定の機能はサポート対象ではなく、機能が制限されることがあります。 詳しくは、Microsoft Azure プレビューの追加使用条件に関するページをご覧ください。

Azure AI Studio では、業界で使用可能なモデルとデータセット全体のベンチマークを比較して、ビジネス シナリオを満たすものを判断できます。 モデル カタログ内の詳細なベンチマーク結果に直接アクセスできます。 既に念頭に置いているモデルがある場合でも、モデルを探している場合でも、Azure AI のベンチマーク データを使用すると、情報に基づいた意思決定を迅速かつ効率的に行うことができます。

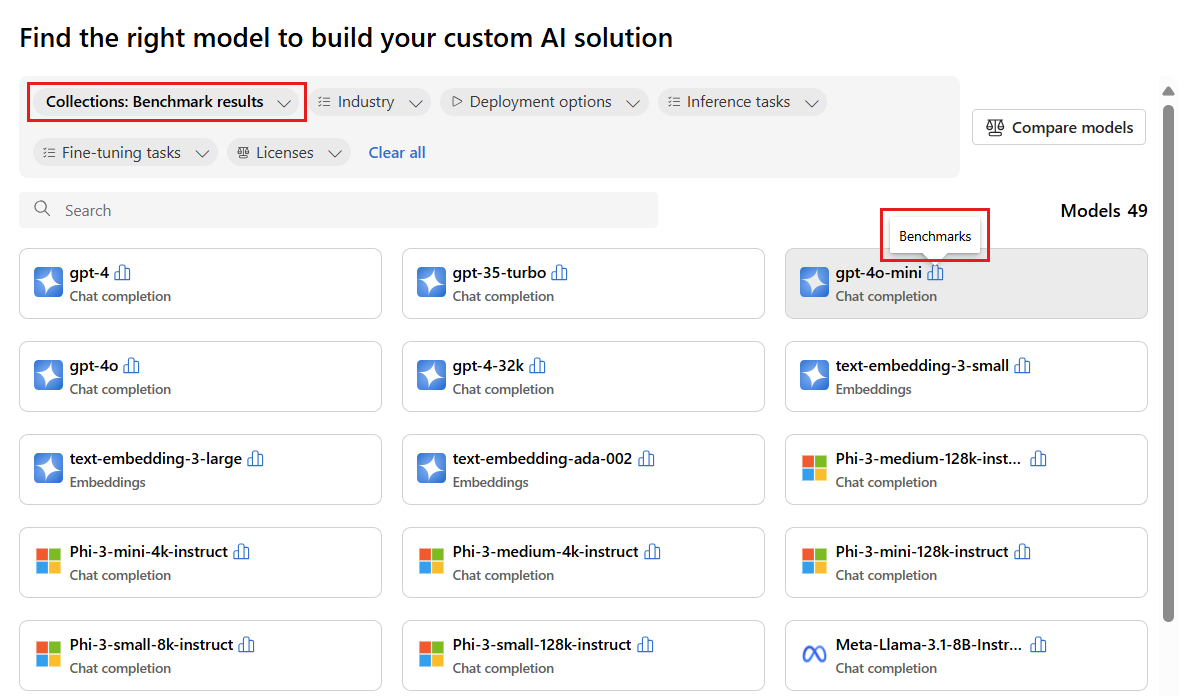

Azure AI は、普及しており、最も頻繁に使用されている一部のモデルのモデル ベンチマークをサポートしています。 サポートされているモデルには、ヒストグラムのような [ベンチマーク] アイコンが示されています。 モデル カタログでこれらのモデルを見つけるには、[コレクション] フィルターを使用し、[ベンチマーク結果] を選択します。 その後、検索機能を使用して特定のモデルを検索できます。

モデル ベンチマークは、ジョブを開始する前に、モデルとデータセットの持続可能性について、情報に基づいた意思決定を行うのに役立ちます。 ベンチマークは、ベンチマーク メトリックの包括的な比較に基づいて、タスクに対して最もパフォーマンスの高いモデルのキュレーション一覧です。 Azure AI Studio では、モデル カタログ コレクションに基づいて、モデルに対して次のベンチマークが提供されています。

- 大規模言語モデル (LLM) と小規模言語モデル (SLM) にわたるベンチマーク

- 埋め込みモデル間のベンチマーク

LLM と SLB のベンチマーク

モデル ベンチマークは、品質、パフォーマンス、コストのカテゴリで LLM と SLB を評価します。 ベンチマークは、新しいメトリックとデータセットが既存のモデルに追加され、新しいモデルがモデル カタログに追加されると定期的に更新されます。

Quality

Azure AI は、正確性とプロンプト支援メトリックという 2 つの主要なカテゴリにグループ化された、さまざまなメトリックで LLM と SLB の品質を評価します。

正確性メトリックについて:

| メトリック | 説明 |

|---|---|

| 精度 | 正確性スコアは、データセットとモデル レベルで使用できます。 データセット レベルでは、スコアはデータセット内のすべての例について計算された正確性メトリックの平均値です。 使用される正確性メトリックは、pass@1 メトリックを使用する HumanEval データセットを除くすべてのケースで、exact-match です。 完全一致は、モデルで生成されたテキストをデータセットに従って正しい回答と比較し、生成されたテキストが回答と完全に一致する場合は 1 を、それ以外の場合は 0 を報告します。 pass@1 メトリックは、コード生成タスクの一連の単体テストに合格したモデル ソリューションの割合を測定します。 モデル レベルでは、正確性スコアは各モデルのデータセット レベルの正確性の平均です。 |

プロンプト支援メトリックについて:

| メトリック | 説明 |

|---|---|

| 一貫性 | 一貫性では、言語モデルが流暢で、自然に読めて、人間の言葉に近い出力をどの程度上手く生成できるかが評価されます。 |

| 流暢性 | 流暢性では、生成 AI の予測した回答の言語熟練度が評価されます。 これは、生成されたテキストが文法規則、統語構造、語彙の適切な使用にどの程度準拠しているかを評価し、言語的に正しくかつ自然に聞こえる応答をもたらします。 |

| GPTSimilarity | GPTSimilarity は、グラウンド トゥルース文 (またはドキュメント) と AI モデルによって生成された予測文の類似性を定量化する測定値です。 このメトリックは、グランド トゥルースとモデルの予測の両方について、embeddings API を使用して最初に文レベルの埋め込みを計算することによって算出されます。 これらの埋め込みは、文の高次元ベクトル表現を表すもので、文のセマンティックな意味とコンテキストを捉えます。 |

| 現実性 | 現実度 (Groundedness) では、言語モデルの生成した回答が入力ソースからの情報とどの程度合致しているかが評価されます。 |

| 関連性 | 関連度では、言語モデルの生成した応答が、与えられた質問に対してどの程度適切で、直接的な関連性があるかが評価されます。 |

Azure AI では、品質インデックスも次のように表示されます。

| インデックス | 説明 |

|---|---|

| 品質インデックス | 品質インデックスは、GPTSimilarity を 0 から 1 の間でスケールダウンし、次に正確性メトリックで平均化することによって計算されます。 品質インデックスは値が大きいほど優れています。 |

品質インデックスは、15 個の標準データセットに対する適用可能な主要メトリック (正確性、再スケーリングされた GPTSimilarity) の平均スコアを表し、0 から 1 のスケールで提供されます。

品質インデックスは、メトリックの 2 つのカテゴリを組み合わせたものです。

- 正確性 (完全一致や

pass@kなど)。 範囲は 0 から 1 までです。 - プロンプト ベースのメトリック (GPTSimilarity、根拠性、一貫性、流暢性、関連性など)。 範囲は 1 から 5 までです。

品質インデックス値の安定性は、モデルの全体的な品質のインジケーターになります。

パフォーマンス

パフォーマンス メトリックは、各証跡が 1 時間間隔で毎日送信される 24 の証跡 (証跡ごとに 2 つの要求) に基づいて、14 日間の集計として計算されます。 モデル エンドポイントへの要求ごとに、次の既定パラメーターが使用されます。

| パラメーター | 値 | 適用対象 |

|---|---|---|

| リージョン | 米国東部/米国東部 2 | サーバーレス API と Azure OpenAI |

| 1 分あたりのトークン数 (TPM) レート制限 | 30k (Azure OpenAI に基づいた 180 RPM) N/A (サーバーレス API) |

Azure OpenAI モデルの場合、デプロイの種類 (標準、グローバル、グローバル標準など) に基づいて、レート制限の範囲をユーザーが選択できます。 サーバーレス API の場合、この設定は抽象化されます。 |

| 要求数 | 1 時間ごとの証跡で 2 つの要求 (1 日あたり 24 証跡) | サーバーレス API、Azure OpenAI |

| 証跡と実行の数 | 1 日あたり 24 証跡の 14 日間で 336 回の実行 | サーバーレス API、Azure OpenAI |

| プロンプトとコンテキストの長さ | 中程度の長さ | サーバーレス API、Azure OpenAI |

| 処理されたトークンの数 (中程度) | 入力と出力のトークン比 80:20、つまり 800 個の入力トークンから 200 個の出力トークン。 | サーバーレス API、Azure OpenAI |

| 同時要求の数 | 1 つ (要求は 1 つずつ順番に送信されます) | サーバーレス API、Azure OpenAI |

| データ | 合成 (静的テキストから準備された入力プロンプト) | サーバーレス API、Azure OpenAI |

| リージョン | 米国東部/米国東部 2 | サーバーレス API と Azure OpenAI |

| デプロイの種類 | Standard | Azure OpenAI にのみ適用されます |

| ストリーミング | True | サーバーレス API と Azure OpenAI に適用されます。 マネージド コンピューティングを使用してデプロイされたモデルの場合は、ストリーミング シナリオをレプリケートするために max_token = 1 を設定します。これにより、マネージド コンピューティングの最初のトークンまでの合計時間 (TTFT) などのメトリックを計算できます。 |

| Tokenizer | Tiktoken パッケージ (Azure OpenAI) Hugging Face モデル ID (サーバーレス API) |

Hugging Face モデル ID (Azure サーバーレス API) |

LLM と SLB のパフォーマンスは、次のメトリックで評価されます。

| メトリック | 説明 |

|---|---|

| 待ち時間の平均 | 要求の処理にかかった平均時間 (秒単位)。複数の要求に対して計算されます。 このメトリックを計算するためには、2 週間にわたって 1 時間ごとにエンドポイントに要求を送信し、平均を計算します。 |

| 待ち時間 P50 | 待ち時間 (要求から、成功のコードで応答全体を受け取るまでの時間) の 50 パーセンタイル値 (中央値)。 たとえば、エンドポイントに要求を送信したときに、要求の 50% が 'x' 秒以内に完了し、'x' が待ち時間の測定値になります。 |

| 待ち時間 P90 | 待ち時間 (要求から、成功のコードで応答全体を受け取るまでの時間) の 90 パーセンタイル値。 たとえば、エンドポイントに要求を送信したときに、要求の 90% が 'x' 秒以内に完了し、'x' が待ち時間の測定値になります。 |

| 待ち時間 P95 | 待ち時間 (要求から、成功のコードで応答全体を受け取るまでの時間) の 95 パーセンタイル値。 たとえば、エンドポイントに要求を送信したときに、要求の 95% が 'x' 秒以内に完了し、'x' が待ち時間の測定値になります。 |

| 待ち時間 P99 | 待ち時間 (要求から、成功のコードで応答全体を受け取るまでの時間) の 99 パーセンタイル値。 たとえば、エンドポイントに要求を送信したときに、要求の 99% が 'x' 秒以内に完了し、'x' が待ち時間の測定値になります。 |

| スループット GTPS | 1 秒あたりの生成トークン数 (GTPS) は、要求がエンドポイントに送信された時点から生成される 1 秒あたりの出力トークンの数です。 |

| スループット TTPS | 1 秒あたりの合計トークン数 (TTPS) は、入力プロンプトと生成された出力トークンの両方で、1 秒あたりに処理されたトークンの合計数です。 |

| 待ち時間 TTFT | 最初のトークンへの合計時間 (TTFT) は、ストリーミングが有効になっているときにエンドポイントから応答の最初のトークンが返されるまでにかかった時間です。 |

| トークンの時間間隔 | このメトリックは、トークンを受信する時間間隔です。 |

Azure AI には、待ち時間とスループットに関するパフォーマンス インデックスも次のように表示されます。

| インデックス | 説明 |

|---|---|

| 待ち時間インデックス | 最初のトークンまでの平均時間。 低い値が適切です。 |

| スループット インデックス | 1 秒あたりの平均生成トークン数。 大きいほど、良い値です。 |

待ち時間やスループットなどのパフォーマンス メトリックでは、最初のトークンまでの時間と 1 秒あたりの生成トークン数によって、モデルの一般的なパフォーマンスと動作をより全体的に把握できます。 パフォーマンス数値は定期的に更新されます。

コスト

コスト計算は、Azure AI プラットフォームでホストされている LLM または SLM モデル エンドポイントを使用する場合の見積もりです。 Azure AI では、サーバーレス API と Azure OpenAI モデルのコストの表示がサポートされています。 これらのコストは変更される可能性があるため、コスト計算は定期的に更新されます。

LLM と SLB のコストは、次のメトリックで評価されます。

| メトリック | 説明 |

|---|---|

| 入力トークンあたりのコスト | 100 万個の入力トークンのサーバーレス API デプロイのコスト |

| 出力トークンあたりのコスト | 100 万個の出力トークンのサーバーレス API デプロイのコスト |

| 推定コスト | 入力トークンあたりのコストと出力トークンあたりのコストの合計のコスト。比率は 3:1 です。 |

Azure AI では、コスト インデックスも次のように表示されます。

| インデックス | 説明 |

|---|---|

| コスト インデックス | 推定コスト。 低い値が適切です。 |

埋め込みモデルのベンチマーク

モデル ベンチマークは、埋め込みモデルを品質に基づいて評価します。

Quality

埋め込みモデルの品質は、次のメトリックで評価されます。

| メトリック | 説明 |

|---|---|

| 精度 | 精度は、処理された予測の総数に占める正しい予測の割合です。 |

| F1 スコア | F1 スコアは精度と再現率の加重平均です。最高値は 1 (完全な精度と再現率)、最低値は 0 です。 |

| 平均精度 (MAP) | MAP は、ランク付けシステムとレコメンダー システムの品質を評価します。 これは、提案された項目の関連度と、システムがより関連度の高い項目を上部に配置できているかという点の両方を測定します。 値の範囲は 0 から 1 までで、MAP が高いほど、システムは関連性の高い項目をリストの上位に配置できます。 |

| 正規化減損累積利得 (NDCG) | NDCG は、関連性に基づいて項目を並べ替える機械学習アルゴリズムの能力を評価します。 これは、ランキングを、関連するすべての項目がリストの一番上にある理想的な順序と比較します。k は、ランク付けの品質を評価する際のリストの長さです。 ベンチマークでは、ndcg_at_10 というメトリックが示すように k=10 です。これは、上位 10 個の項目を確認することを意味します。 |

| 精度 | 精度は、特定のクラスのインスタンスを正しく識別するモデルの能力を測定します。 精度は、機械学習モデルがターゲット クラスを予測するときにどれだけ正確であるかを示します。 |

| スピアマン相関 | コサイン類似度に基づくスピアマン相関は、最初に変数間のコサイン類似度を計算し、次にこれらのスコアをランク付けし、このランクを使用してスピアマン相関を計算することによって計算されます。 |

| V メジャー | V メジャーは、クラスタリングの品質を評価するために使用されるメトリックです。 V メジャーは、均質度と完全度の調和平均として計算され、2 つの値の間のバランスを確保することで意味のあるスコアが得られます。 可能なスコアは 0 から 1 であり、1 は完全に完了したラベル付けです。 |

スコアの計算

個別のスコア

ベンチマーク結果は、言語モデルの評価に一般的に使用される公開データセットに由来します。 ほとんどの場合、データは、データの作成者またはキュレーターによって管理されている GitHub リポジトリにホストされています。 Azure AI 評価パイプラインは、元のソースからデータをダウンロードし、各例の行からプロンプトを抽出し、モデルの応答を生成してから、関連する正確性メトリックを計算します。

プロンプトの構築は、データセットを紹介した論文や業界標準によって指定された、各データセットのベスト プラクティスに従います。 ほとんどの場合、各プロンプトには複数の "ショット"、つまりタスクのモデルを準備するための完全な質問と回答の例がいくつか含まれています。 評価パイプラインは、評価から除外されたデータの一部から質問と回答をサンプリングしてショットを作成します。