Microsoft Fabric の Apache Spark でのジョブの受付

適用対象:✅ Microsoft Fabric でのデータ エンジニアリングとデータ サイエンス

Fabric の Apache Spark では、オプティミスティック ジョブ受付手法を使用して、Spark ジョブの最小コア要件を決定します。 このプロセスは、ノートブック、レイクハウス、または Spark ジョブ定義からの対話型ジョブまたはバッチ ジョブに適用できます。 ワークスペース設定または接続環境で選択した Spark プールの最小ノード設定に依存します。 ワークスペースにリンクされている Fabric 容量で使用可能なコアが見つかった場合、ジョブは受け入れられ、実行が開始されます。 ジョブは最小ノード設定で開始され、ジョブ ステージごとに最大ノード制限内でスケールアップできます。 Fabric 容量を使用してジョブを実行することによって使用されるコアの合計が、割り当てられた最大バースト コア数を下回る場合、Fabric Spark のジョブ受付と調整レイヤによってジョブをスケールアップすることができます。

詳細については、「Microsoft Fabric Spark のコンカレンシー制限とキューイング」を参照してください。

オプティミスティック ジョブの受付のしくみとは

Fabric では、スターター プールには既定の最小ノードが 1 つ用意されていますが、カスタム プールではワークロードのニーズに基づいて最小ノードを設定できます。 自動スケールでは、構成された最小ノードと最大ノード内で、実行ステージ中の Spark ジョブのコンピューティング要件が調整されます。 オプティミスティック ジョブ 受付では、使用可能なコアに基づいてジョブの送信が評価され、最小コアで実行されます。 ジョブは、実行中に割り当てられた最大ノード数に基づいて拡張を試みます。 使用される Spark コアの合計が割り当てられた容量制限内にある場合、スケールアップ要求は承認されます。

Note

使用量が上限に達し、Fabric の合計容量内のすべてのコアが使用されている場合、スケールアップ要求はすべて拒否されます。 アクティブなジョブは、コアを解放するために完了するか取り消す必要があります。

これはジョブのコンカレンシーにどのように影響しますか?

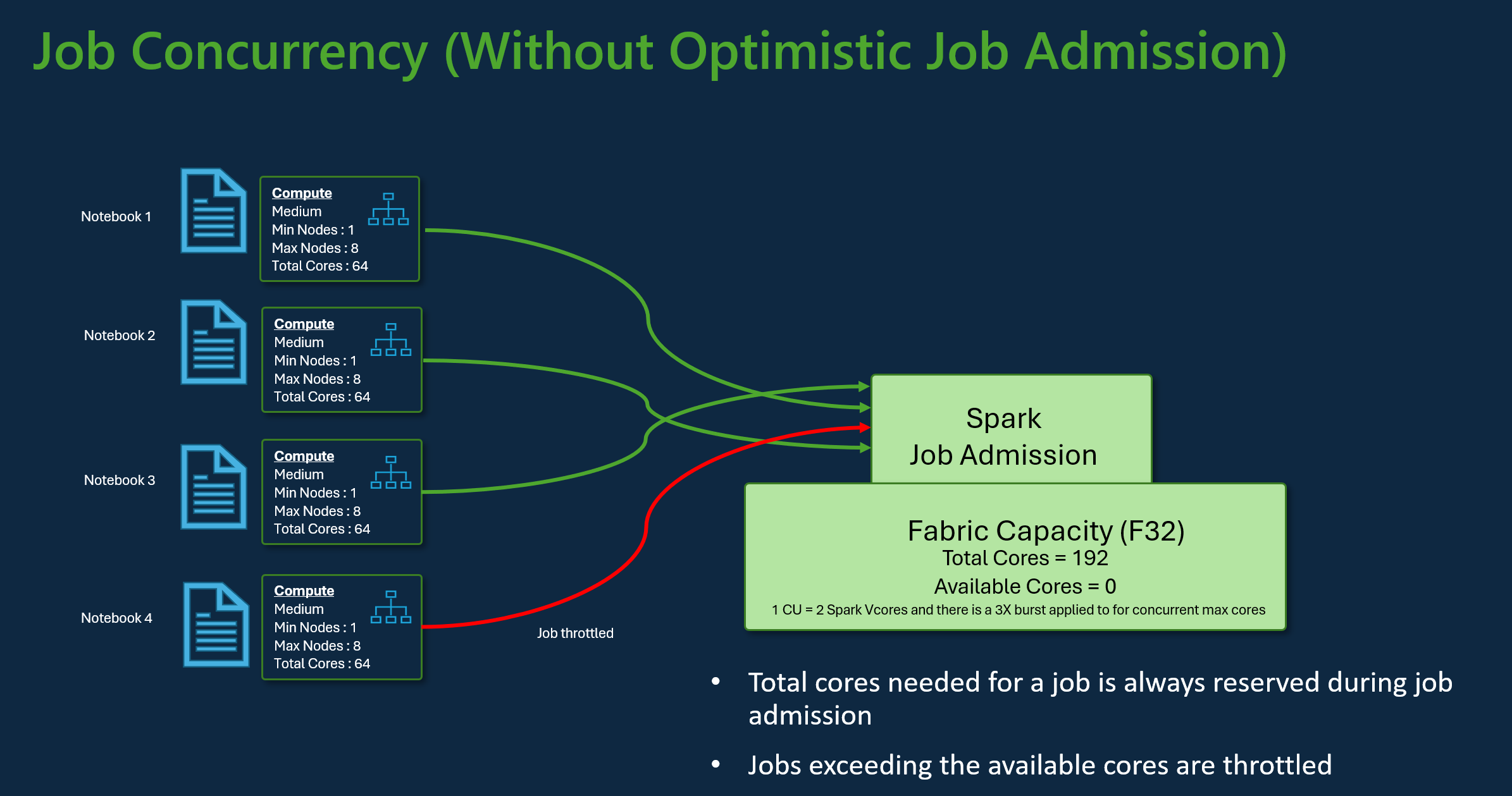

各ジョブの最小コア要件によって、ジョブを受け入れられるかどうかが決まります。 容量が完全に利用され、ジョブの最小コア ニーズを満たすために残っているコアがない場合、ジョブは拒否されます。 対話型ノートブック ジョブまたはレイクハウス操作は、使用可能なすべての容量が現在使用されているため、この要求を送信できません。現在実行中のジョブを取り消すか、使用可能な容量を増やすか、後で再試行してくださいというエラーメッセージでブロックされます。 バッチ ジョブは、コアが使用可能になるとキューに登録され、実行されます。

たとえば、Fabric F32 容量 SKU を使用するユーザーのシナリオを考えてみましょう。 すべてのジョブで、オプティミスティック ジョブ受付なしで既定のスターター プール セットアップが使用されていると仮定すると、容量は 3 つのジョブの最大コンカレンシーをサポートします。 ジョブあたりのコアの最大数は、最大ノード構成に従って割り当てられます。

上記と同じ容量のオプティミスティック ジョブ受付では、最大コンカレンシー シナリオ中に最小ノード構成を使用して 24 個のジョブを許可および実行できます。 各ジョブには 8 つの Spark 仮想コアが必要であり、1 つの最小ノード構成が中規模であるためです。

Spark オートスケールを使用してジョブをスケーリングする

Spark プールのオートスケールを有効にすると、ジョブは最小ノード構成で実行されます。 実行時に、スケーリングが発生する可能性があります。 これらの要求は、受付制御を通過します。 承認された要求は、使用可能なコアの合計数に基づいて最大制限にスケールアップされます。 拒否された要求はアクティブなジョブには影響しません。コアが使用可能になるまで、現在の構成で引き続き実行されます。

Note

最大ノード構成に従ってジョブの最大コア割り当てを確保するには、オートスケールを無効にして、Fabric 容量 SKU 内の最大ノードを設定します。 この場合、ジョブには最小コア要件がないため、空きコアが使用可能になると実行が開始され、構成された合計にスケールアップされます。 容量が完全に使用されている場合、ノートブックの対話型ジョブの速度が低下したり、キューに登録されたりすることがあります。 キューに登録されたジョブは、コアが使用可能になると自動的に再試行されます。

関連するコンテンツ

- Microsoft Fabric の Spark ワークスペース管理設定の作業を開始する。

- Fabric データ エンジニアリングとデータ サイエンスのための Spark コンピューティングについて説明します。

- Fabric Spark のコンカレンシーとキューの制限について、詳細をご覧ください。