빠른 시작: Azure OpenAI 서비스에서 GPT-35-Turbo 및 GPT-4 사용 시작

이 문서를 사용하여 Azure OpenAI 사용을 시작합니다.

필수 조건

- Azure 구독 – 체험 구독을 만듭니다.

gpt-4o또는gpt-4o-mini모델이 배포된 Azure OpenAI Service 리소스입니다. 초기 탐색을 위해 표준 또는 글로벌 표준 모델 배포 유형을 사용하는 것이 좋습니다. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

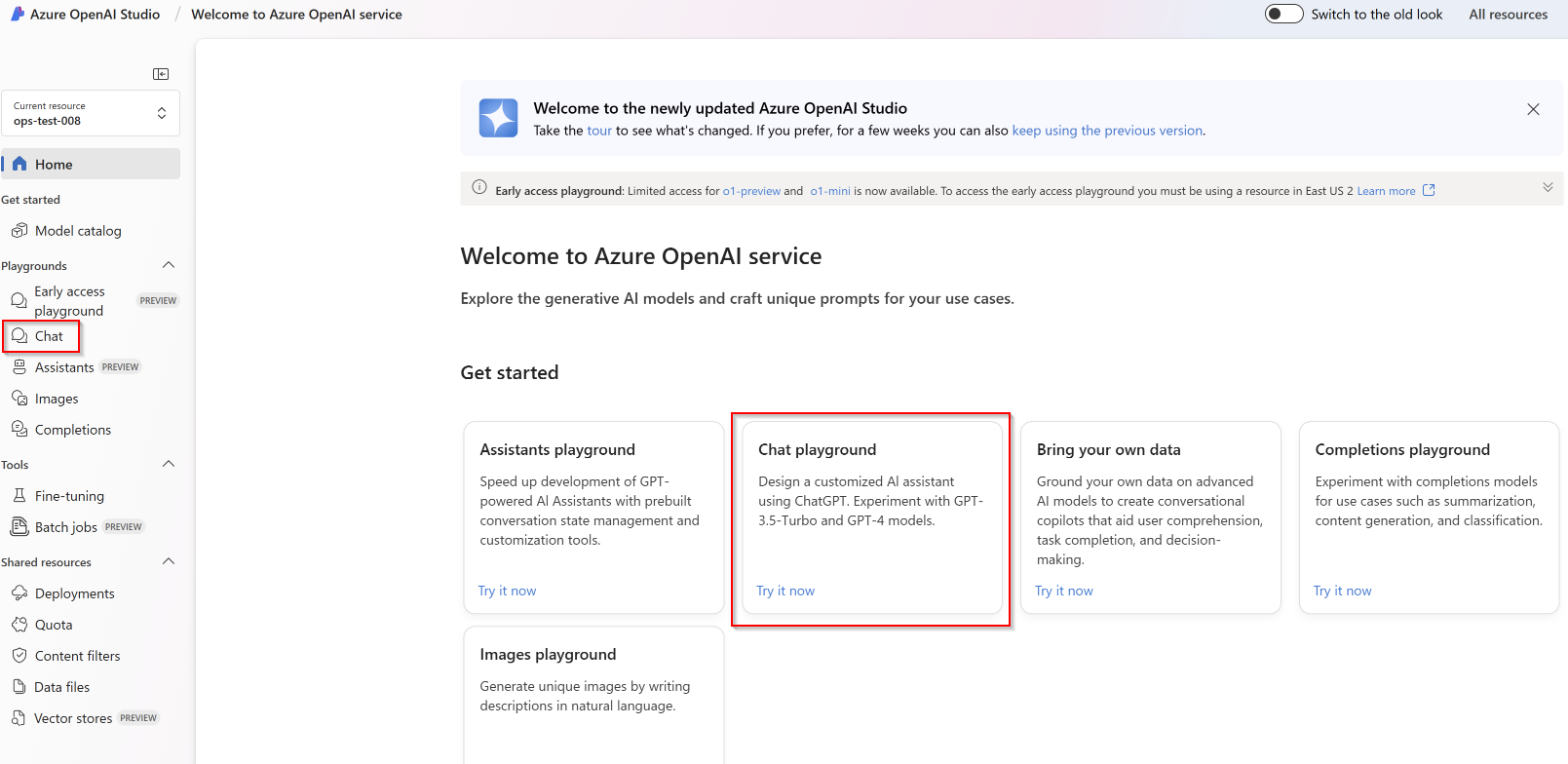

Azure OpenAI Studio로 이동

https://oai.azure.com/에서 Azure OpenAI Studio로 이동한 다음, Azure OpenAI 리소스에 액세스할 수 있는 자격 증명으로 로그인합니다. 로그인 워크플로 도중 또는 이후에 적절한 디렉터리, Azure 구독 및 Azure OpenAI 리소스를 선택합니다.

Azure OpenAI Studio 방문 페이지에서 채팅 플레이그라운드를 선택합니다.

플레이그라운드

Azure OpenAI Studio 채팅 플레이그라운드를 통해 코드 없는 접근 방식으로 Azure OpenAI 기능 탐색을 시작합니다. 이 페이지에서 쉽게 기능을 반복하고 실험해 볼 수 있습니다.

설정

*프롬프트 샘플 드롭다운을 사용하여 몇 가지 미리 로드된 시스템 메시지 예를 선택하여 시작할 수 있습니다.

시스템 메시지는 동작하는 방법과 응답을 생성할 때 참조해야 하는 컨텍스트에 대한 지침을 모델에 제공합니다. 도우미의 성격을 설명하고, 대답해야 하는 것과 대답해서는 안 되는 것을 말하고, 응답의 형식을 지정하는 방법을 말할 수 있습니다.

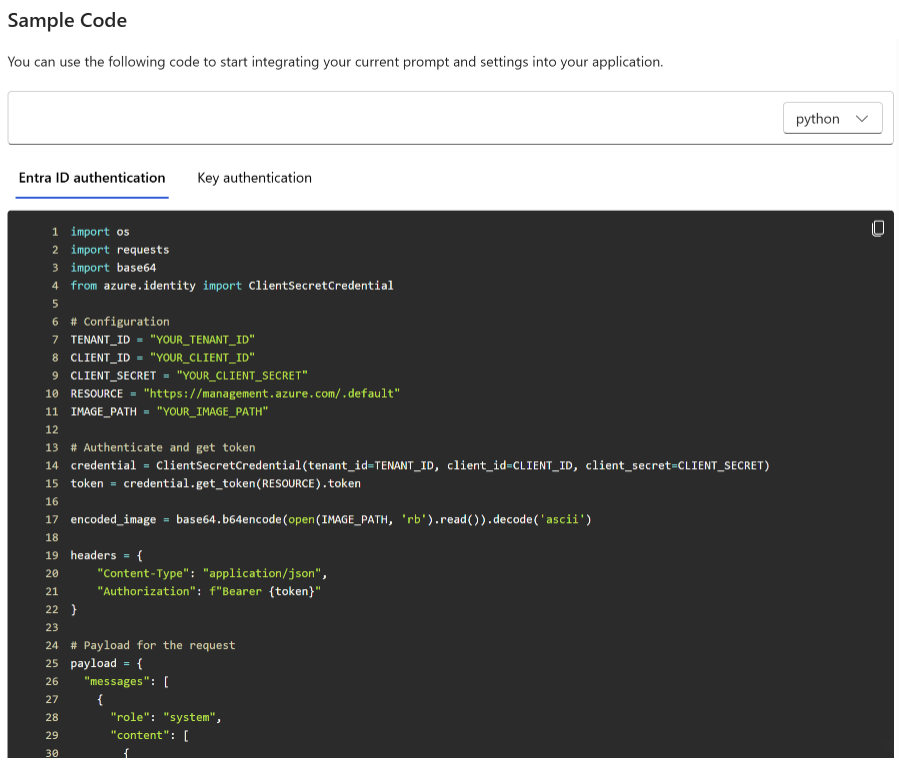

채팅 플레이그라운드를 사용하는 동안 언제든지 코드 보기를 선택하여 현재 채팅 세션 및 설정 선택 사항에 따라 미리 채워진 Python, curl 및 json 코드 샘플을 볼 수 있습니다. 그런 다음, 이 코드를 사용하고 애플리케이션을 작성하여 현재 플레이그라운드에서 수행하고 있는 것과 동일한 작업을 완료할 수 있습니다.

채팅 세션

Enter 단추를 선택하거나 오른쪽 화살표 아이콘을 선택하면 입력한 텍스트가 채팅 완료 API로 전송되고 결과는 텍스트 상자로 다시 반환됩니다.

채팅 지우기 단추를 선택하여 현재 대화 기록을 삭제합니다.

키 설정

| 이름 | 설명 |

|---|---|

| 배포 | 특정 모델과 연결된 배포 이름입니다. |

| 데이터 추가 | |

| 매개 변수 | 모델 응답을 변경하는 사용자 지정 매개 변수. 시작할 때는 대부분의 매개 변수에 대해 기본값을 사용하는 것이 좋습니다. |

| 온도 | 임의성을 제어합니다. 온도를 낮추면 모델이 더 반복적이고 결정된 응답을 생성합니다. 온도를 높이면 예기치 않거나 창의적인 응답이 발생합니다. 온도 또는 상위 P를 조정하되 둘 다 조정하지는 마세요. |

| 최대 응답(토큰) | 모델 응답당 토큰 수 한도를 설정합니다. 최신 모델의 API는 프롬프트(시스템 메시지, 예, 메시지 기록, 사용자 쿼리 포함)와 모델의 응답 간에 공유되는 최대 128,000개의 토큰을 지원합니다. 한 토큰은 일반적인 영어 텍스트의 경우 약 4자입니다. |

| Top p | 온도와 마찬가지로 임의성을 제어하지만 다른 방법을 사용합니다. 상위 P를 낮추면 모델의 토큰 선택이 유사 토큰으로 좁혀지게 됩니다. 상위 P를 늘리면 모델이 가능성이 높고 낮은 토큰 중에서 선택할 수 있습니다. 온도 또는 상위 P를 조정하되 둘 다 조정하지는 마세요. |

| 중지 시퀀스 | 중지 시퀀스는 모델이 원하는 지점에서 응답을 종료하도록 합니다. 모델 응답은 지정된 시퀀스 이전에 종료되므로 중지 시퀀스 텍스트가 포함되지 않습니다. GPT-35-Turbo의 경우 <|im_end|>를 사용하면 모델 응답이 후속 사용자 쿼리를 생성하지 않습니다. 최대 4개의 중지 시퀀스를 포함할 수 있습니다. |

코드 보기

모델과 채팅을 시도해 본 후 </> 코드 보기 단추를 선택합니다. 이렇게 하면 지금까지의 대화에 대한 코드를 다시 볼 수 있습니다.

프롬프트 구조 이해

코드 보기의 샘플을 살펴보면 대화가 system, user, assistant의 세 가지 역할로 구분되어 있는 것을 알 수 있습니다. 모델에게 메시지를 보낼 때마다 해당 지점까지의 전체 대화 기록이 다시 전송됩니다. 채팅 완료 API를 사용하면 모델은 과거에 보낸 내용을 실제로 기억하지 못하므로 모델이 적절하게 응답할 수 있도록 컨텍스트를 제공하는 대화 기록을 제공해야 합니다.

채팅 완료 사용 방법 가이드는 새 프롬프트 구조에 대한 심층적인 소개와 채팅 완료 모델을 효과적으로 사용하는 방법을 제공합니다.

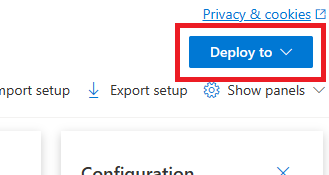

모델 배포

Azure OpenAI Studio의 환경에 만족하면 배포 대상 단추를 선택하여 스튜디오에서 직접 웹앱을 배포할 수 있습니다.

이를 통해 모델에서 자체 데이터를 사용하는 경우 독립형 웹 애플리케이션에 배포하거나 Copilot Studio(미리 보기)의 Copilot에 배포할 수 있는 옵션이 제공됩니다.

예를 들어 웹앱을 배포하도록 선택하는 경우:

웹앱을 처음 배포할 때 새 웹앱 만들기를 선택해야 합니다. 앱 URL의 일부가 될 앱의 이름을 선택합니다. 예: https://<appname>.azurewebsites.net.

게시된 앱에 대한 구독, 리소스 그룹, 위치 및 가격 책정 계획을 선택합니다. 기존 앱을 업데이트하려면 기존 웹앱에 게시를 선택하고 드롭다운 메뉴에서 이전 앱의 이름을 선택합니다.

웹앱을 배포하도록 선택하는 경우 웹앱을 사용하기 위한 중요한 고려 사항을 참조하세요.

리소스 정리

채팅 플레이그라운드 테스트가 완료된 후 Azure OpenAI 리소스를 정리하고 제거하려는 경우 리소스 또는 리소스 그룹을 삭제할 수 있습니다. 리소스 그룹을 삭제하면 해당 리소스 그룹에 연결된 다른 모든 리소스가 함께 삭제됩니다.

다음 단계

- GPT-35-Turbo 및 GPT-4 방법 가이드를 통해 새로운

gpt-35-turbo모델로 작업하는 방법에 대해 자세히 알아봅니다. - 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

소스 코드 | 패키지(NuGet) | 샘플| RAG(Retrieval Augmented Generation) 엔터프라이즈 채팅 템플릿 |

필수 조건

- Azure 구독 - 체험 구독 만들기

- .NET 7 SDK

gpt-35-turbo또는gpt-4모델이 배포된 Azure OpenAI Service 리소스입니다. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

설정

새 .NET Core 애플리케이션 만들기

콘솔 창(예: cmd, PowerShell 또는 Bash)에서 dotnet new 명령을 사용하여 azure-openai-quickstart라는 새 콘솔 앱을 만듭니다. 이 명령은 program.cs라는 단일 C# 원본 파일을 사용하여 간단한 "Hello World" 프로젝트를 만듭니다.

dotnet new console -n azure-openai-quickstart

새로 만든 앱 폴더로 디렉터리를 변경합니다. 다음을 통해 애플리케이션을 빌드할 수 있습니다.

dotnet build

빌드 출력에 경고나 오류가 포함되지 않아야 합니다.

...

Build succeeded.

0 Warning(s)

0 Error(s)

...

다음을 사용하여 OpenAI .NET 클라이언트 라이브러리를 설치합니다.

dotnet add package Azure.AI.OpenAI --prerelease

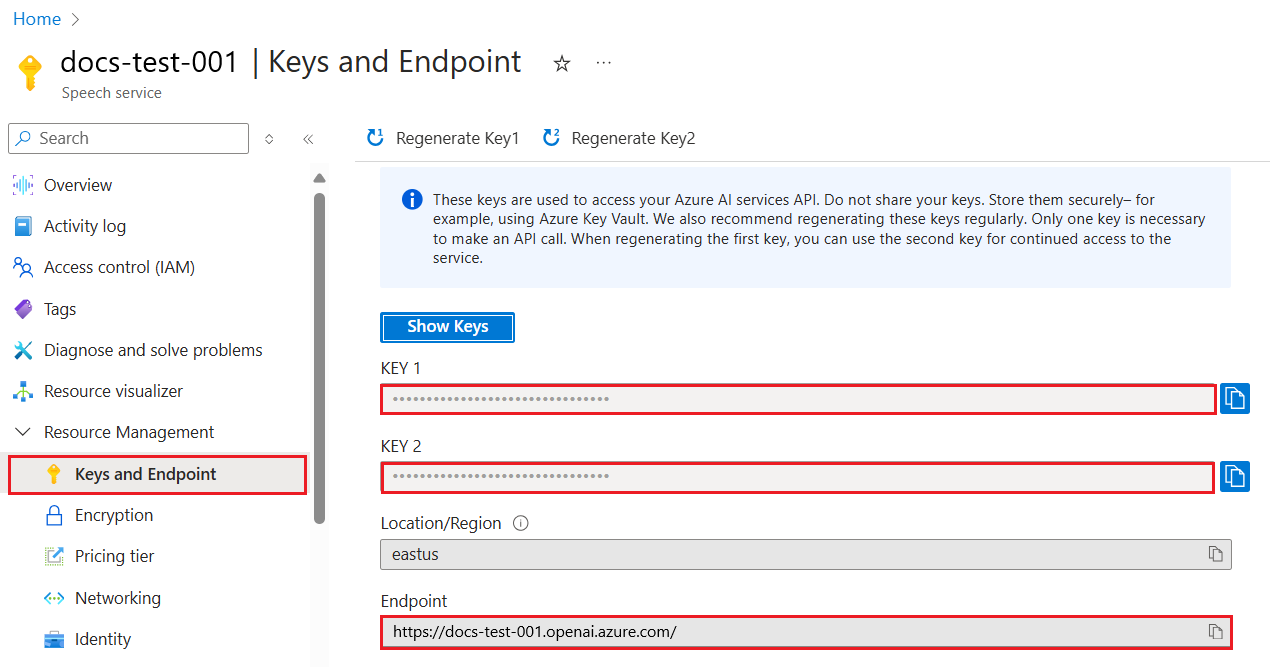

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

샘플 애플리케이션 만들기

프로젝트 디렉터리에서 program.cs 파일을 열고, 다음 코드로 바꿉니다.

응답 스트리밍 없음

using Azure;

using Azure.AI.OpenAI;

using static System.Environment;

string endpoint = GetEnvironmentVariable("AZURE_OPENAI_ENDPOINT");

string key = GetEnvironmentVariable("AZURE_OPENAI_API_KEY");

AzureOpenAIClient azureClient = new(

new Uri(endpoint),

new AzureKeyCredential(key));

// This must match the custom deployment name you chose for your model

ChatClient chatClient = azureClient.GetChatClient("gpt-35-turbo");

ChatCompletion completion = chatClient.CompleteChat(

[

new SystemChatMessage("You are a helpful assistant that talks like a pirate."),

new UserChatMessage("Does Azure OpenAI support customer managed keys?"),

new AssistantChatMessage("Yes, customer managed keys are supported by Azure OpenAI"),

new UserChatMessage("Do other Azure AI services support this too?")

]);

Console.WriteLine($"{completion.Role}: {completion.Content[0].Text}");

Important

프로덕션의 경우 Azure Key Vault와 같은 자격 증명을 안전하게 저장하고 액세스하는 방법을 사용합니다. 자격 증명 보안에 대한 자세한 내용은 Azure AI 서비스 보안 문서를 참조하세요.

dotnet run program.cs

출력

Assistant : Yes, many other Azure AI services also support customer managed keys, including Azure Cognitive Services, Azure Machine Learning, and Azure Databricks. By using customer managed keys, you can retain complete control over your encryption keys and provide an additional layer of security for your AI assets.

결과를 인쇄하기 전에 모델이 전체 응답을 생성할 때까지 기다립니다. 또는 응답을 비동기식으로 스트리밍하고 결과를 인쇄하려는 경우 program.cs의 콘텐츠를 다음 예의 코드로 바꿀 수 있습니다.

스트리밍과 비동기

using Azure;

using Azure.AI.OpenAI;

using OpenAI.Chat;

using static System.Environment;

string endpoint = GetEnvironmentVariable("AZURE_OPENAI_ENDPOINT");

string key = GetEnvironmentVariable("AZURE_OPENAI_API_KEY");

AzureOpenAIClient azureClient = new(

new Uri(endpoint),

new AzureKeyCredential(key));

// This must match the custom deployment name you chose for your model

ChatClient chatClient = azureClient.GetChatClient("gpt-35-turbo");

var chatUpdates = chatClient.CompleteChatStreamingAsync(

[

new SystemChatMessage("You are a helpful assistant that talks like a pirate."),

new UserChatMessage("Does Azure OpenAI support customer managed keys?"),

new AssistantChatMessage("Yes, customer managed keys are supported by Azure OpenAI"),

new UserChatMessage("Do other Azure AI services support this too?")

]);

await foreach(var chatUpdate in chatUpdates)

{

if (chatUpdate.Role.HasValue)

{

Console.Write($"{chatUpdate.Role} : ");

}

foreach(var contentPart in chatUpdate.ContentUpdate)

{

Console.Write(contentPart.Text);

}

}

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

- 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

필수 조건

- Azure 구독 - 체험 구독 만들기

- Go 1.21.0 이상이 로컬로 설치되었습니다.

gpt-35-turbo모델이 배포된 Azure OpenAI Service 리소스. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

설정

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

샘플 애플리케이션 만들기

chat_completions.go라는 새 파일을 만듭니다. 다음 코드를 chat_completions.go 파일에 복사합니다.

package main

import (

"context"

"fmt"

"log"

"os"

"github.com/Azure/azure-sdk-for-go/sdk/ai/azopenai"

"github.com/Azure/azure-sdk-for-go/sdk/azcore"

"github.com/Azure/azure-sdk-for-go/sdk/azcore/to"

)

func main() {

azureOpenAIKey := os.Getenv("AZURE_OPENAI_API_KEY")

modelDeploymentID := os.Getenv("YOUR_MODEL_DEPLOYMENT_NAME")

maxTokens:= int32(400)

// Ex: "https://<your-azure-openai-host>.openai.azure.com"

azureOpenAIEndpoint := os.Getenv("AZURE_OPENAI_ENDPOINT")

if azureOpenAIKey == "" || modelDeploymentID == "" || azureOpenAIEndpoint == "" {

fmt.Fprintf(os.Stderr, "Skipping example, environment variables missing\n")

return

}

keyCredential := azcore.NewKeyCredential(azureOpenAIKey)

// In Azure OpenAI you must deploy a model before you can use it in your client. For more information

// see here: https://learn.microsoft.com/azure/cognitive-services/openai/how-to/create-resource

client, err := azopenai.NewClientWithKeyCredential(azureOpenAIEndpoint, keyCredential, nil)

if err != nil {

// TODO: Update the following line with your application specific error handling logic

log.Printf("ERROR: %s", err)

return

}

// This is a conversation in progress.

// NOTE: all messages, regardless of role, count against token usage for this API.

messages := []azopenai.ChatRequestMessageClassification{

// You set the tone and rules of the conversation with a prompt as the system role.

&azopenai.ChatRequestSystemMessage{Content: to.Ptr("You are a helpful assistant.")},

// The user asks a question

&azopenai.ChatRequestUserMessage{Content: azopenai.NewChatRequestUserMessageContent("Does Azure OpenAI support customer managed keys?")},

// The reply would come back from the model. You'd add it to the conversation so we can maintain context.

&azopenai.ChatRequestAssistantMessage{Content: to.Ptr("Yes, customer managed keys are supported by Azure OpenAI")},

// The user answers the question based on the latest reply.

&azopenai.ChatRequestUserMessage{Content: azopenai.NewChatRequestUserMessageContent("What other Azure Services support customer managed keys?")},

// from here you'd keep iterating, sending responses back from ChatGPT

}

gotReply := false

resp, err := client.GetChatCompletions(context.TODO(), azopenai.ChatCompletionsOptions{

// This is a conversation in progress.

// NOTE: all messages count against token usage for this API.

Messages: messages,

DeploymentName: &modelDeploymentID,

MaxTokens: &maxTokens,

}, nil)

if err != nil {

// TODO: Update the following line with your application specific error handling logic

log.Printf("ERROR: %s", err)

return

}

for _, choice := range resp.Choices {

gotReply = true

if choice.ContentFilterResults != nil {

fmt.Fprintf(os.Stderr, "Content filter results\n")

if choice.ContentFilterResults.Error != nil {

fmt.Fprintf(os.Stderr, " Error:%v\n", choice.ContentFilterResults.Error)

}

fmt.Fprintf(os.Stderr, " Hate: sev: %v, filtered: %v\n", *choice.ContentFilterResults.Hate.Severity, *choice.ContentFilterResults.Hate.Filtered)

fmt.Fprintf(os.Stderr, " SelfHarm: sev: %v, filtered: %v\n", *choice.ContentFilterResults.SelfHarm.Severity, *choice.ContentFilterResults.SelfHarm.Filtered)

fmt.Fprintf(os.Stderr, " Sexual: sev: %v, filtered: %v\n", *choice.ContentFilterResults.Sexual.Severity, *choice.ContentFilterResults.Sexual.Filtered)

fmt.Fprintf(os.Stderr, " Violence: sev: %v, filtered: %v\n", *choice.ContentFilterResults.Violence.Severity, *choice.ContentFilterResults.Violence.Filtered)

}

if choice.Message != nil && choice.Message.Content != nil {

fmt.Fprintf(os.Stderr, "Content[%d]: %s\n", *choice.Index, *choice.Message.Content)

}

if choice.FinishReason != nil {

// this choice's conversation is complete.

fmt.Fprintf(os.Stderr, "Finish reason[%d]: %s\n", *choice.Index, *choice.FinishReason)

}

}

if gotReply {

fmt.Fprintf(os.Stderr, "Received chat completions reply\n")

}

}

Important

프로덕션의 경우 Azure Key Vault와 같은 자격 증명을 안전하게 저장하고 액세스하는 방법을 사용합니다. 자격 증명 보안에 대한 자세한 내용은 Azure AI 서비스 보안 문서를 참조하세요.

이제 명령 프롬프트를 열고 다음을 실행합니다.

go mod init chat_completions.go

다음 실행:

go mod tidy

go run chat_completions.go

출력

Content filter results

Hate: sev: safe, filtered: false

SelfHarm: sev: safe, filtered: false

Sexual: sev: safe, filtered: false

Violence: sev: safe, filtered: false

Content[0]: As of my last update in early 2023, in Azure, several AI services support the use of customer-managed keys (CMKs) through Azure Key Vault. This allows customers to have control over the encryption keys used to secure their data at rest. The services that support this feature typically fall under Azure's range of cognitive services and might include:

1. Azure Cognitive Search: It supports using customer-managed keys to encrypt the index data.

2. Azure Form Recognizer: For data at rest, you can use customer-managed keys for added security.

3. Azure Text Analytics: CMKs can be used for encrypting your data at rest.

4. Azure Blob Storage: While not exclusively an AI service, it's often used in conjunction with AI services to store data, and it supports customer-managed keys for encrypting blob data.

Note that the support for CMKs can vary by service and sometimes even by the specific feature within the service. Additionally, the landscape of cloud services is fast evolving, and new features, including security capabilities, are frequently added. Therefore, it's recommended to check the latest Azure documentation or contact Azure support for the most current information about CMK support for any specific Azure AI service.

Finish reason[0]: stop

Received chat completions reply

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

소스 코드 | Artifact(Maven) | 샘플 | RAG(Retrieval Augmented Generation) 엔터프라이즈 채팅 템플릿 | IntelliJ IDEA

필수 조건

- Azure 구독 - 체험 구독 만들기

- JDK(Java Development Kit)의 현재 버전

- Gradle 빌드 도구 또는 다른 종속성 관리자

gpt-35-turbo또는gpt-4모델이 배포된 Azure OpenAI Service 리소스입니다. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

설정

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

새 Java 애플리케이션 만들기

새 Gradle 프로젝트를 만듭니다.

콘솔 창(예: cmd, PowerShell 또는 Bash)에서 앱에 대한 새 디렉터리를 만들고 이 디렉터리로 이동합니다.

mkdir myapp && cd myapp

작업 디렉터리에서 gradle init 명령을 실행합니다. 이 명령은 build.gradle.kts를 포함하여 런타임에 애플리케이션을 만들고 구성하는 데 사용되는 Gradle용 필수 빌드 파일을 만듭니다.

gradle init --type basic

DSL을 선택하라는 메시지가 표시되면 Kotlin을 선택합니다.

Java SDK 설치

이 빠른 시작에서는 Gradle 종속성 관리자를 사용합니다. 다른 종속성 관리자에 대한 클라이언트 라이브러리 및 정보는 Maven 중앙 리포지토리에서 찾을 수 있습니다.

build.gradle.kts를 찾고, 원하는 IDE 또는 텍스트 편집기에서 엽니다. 그런 다음, 다음 빌드 구성을 복사합니다. 이 구성은 프로젝트를 진입점이 OpenAI빠른 시작 클래스인 Java 애플리케이션으로 정의합니다. Azure AI Vision 라이브러리를 가져옵니다.

plugins {

java

application

}

application {

mainClass.set("OpenAIQuickstart")

}

repositories {

mavenCentral()

}

dependencies {

implementation(group = "com.azure", name = "azure-ai-openai", version = "1.0.0-beta.10")

implementation("org.slf4j:slf4j-simple:1.7.9")

}

샘플 애플리케이션 만들기

Java 파일을 만듭니다.

작업 디렉터리에서 다음 명령을 실행하여 프로젝트 원본 폴더를 만듭니다.

mkdir -p src/main/java새 폴더로 이동하여 OpenAIQuickstart.java라는 파일을 만듭니다.

선호하는 편집기 또는 IDE에서 OpenAIQuickstart.java 파일을 열고 다음 코드를 붙여넣습니다.

package com.azure.ai.openai.usage; import com.azure.ai.openai.OpenAIClient; import com.azure.ai.openai.OpenAIClientBuilder; import com.azure.ai.openai.models.ChatChoice; import com.azure.ai.openai.models.ChatCompletions; import com.azure.ai.openai.models.ChatCompletionsOptions; import com.azure.ai.openai.models.ChatRequestAssistantMessage; import com.azure.ai.openai.models.ChatRequestMessage; import com.azure.ai.openai.models.ChatRequestSystemMessage; import com.azure.ai.openai.models.ChatRequestUserMessage; import com.azure.ai.openai.models.ChatResponseMessage; import com.azure.ai.openai.models.CompletionsUsage; import com.azure.core.credential.AzureKeyCredential; import com.azure.core.util.Configuration; import java.util.ArrayList; import java.util.List; public class OpenAIQuickstart { public static void main(String[] args) { String azureOpenaiKey = Configuration.getGlobalConfiguration().get("AZURE_OPENAI_API_KEY"); String endpoint = Configuration.getGlobalConfiguration().get("AZURE_OPENAI_ENDPOINT"); String deploymentOrModelId = "{azure-open-ai-deployment-model-id}"; OpenAIClient client = new OpenAIClientBuilder() .endpoint(endpoint) .credential(new AzureKeyCredential(azureOpenaiKey)) .buildClient(); List<ChatRequestMessage> chatMessages = new ArrayList<>(); chatMessages.add(new ChatRequestSystemMessage("You are a helpful assistant.")); chatMessages.add(new ChatRequestUserMessage("Does Azure OpenAI support customer managed keys?")); chatMessages.add(new ChatRequestAssistantMessage("Yes, customer managed keys are supported by Azure OpenAI?")); chatMessages.add(new ChatRequestUserMessage("Do other Azure AI services support this too?")); ChatCompletions chatCompletions = client.getChatCompletions(deploymentOrModelId, new ChatCompletionsOptions(chatMessages)); System.out.printf("Model ID=%s is created at %s.%n", chatCompletions.getId(), chatCompletions.getCreatedAt()); for (ChatChoice choice : chatCompletions.getChoices()) { ChatResponseMessage message = choice.getMessage(); System.out.printf("Index: %d, Chat Role: %s.%n", choice.getIndex(), message.getRole()); System.out.println("Message:"); System.out.println(message.getContent()); } System.out.println(); CompletionsUsage usage = chatCompletions.getUsage(); System.out.printf("Usage: number of prompt token is %d, " + "number of completion token is %d, and number of total tokens in request and response is %d.%n", usage.getPromptTokens(), usage.getCompletionTokens(), usage.getTotalTokens()); } }Important

프로덕션의 경우 Azure Key Vault와 같은 자격 증명을 안전하게 저장하고 액세스하는 방법을 사용합니다. 자격 증명 보안에 대한 자세한 내용은 Azure AI 서비스 보안 문서를 참조하세요.

프로젝트 루트 폴더로 돌아가서 다음을 사용하여 앱을 빌드합니다.

gradle build그런 다음,

gradle run명령을 사용하여 실행합니다.gradle run

출력

Model ID=chatcmpl-7JYnyE4zpd5gaIfTRH7hNpeVsvAw4 is created at 1684896378.

Index: 0, Chat Role: assistant.

Message:

Yes, most of the Azure AI services support customer managed keys. However, there may be some exceptions, so it is best to check the documentation of each specific service to confirm.

Usage: number of prompt token is 59, number of completion token is 36, and number of total tokens in request and response is 95.

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

- 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

소스 코드 | Artifacts(Maven) | 샘플

필수 조건

- Azure 구독 - 체험 구독 만들기

- JDK(Java Development Kit)의 현재 버전

- Spring Boot CLI 도구

gpt-35-turbo모델이 배포된 Azure OpenAI Service 리소스. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요. 이 예에서는 배포 이름이 모델 이름gpt-35-turbo와 일치한다고 가정합니다.

설정

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

참고 항목

Spring AI는 기본적으로 모델 이름을 gpt-35-turbo로 지정합니다. 다른 이름으로 모델을 배포한 경우에만 SPRING_AI_AZURE_OPENAI_MODEL 값을 제공하면 됩니다.

export SPRING_AI_AZURE_OPENAI_API_KEY="REPLACE_WITH_YOUR_KEY_VALUE_HERE"

export SPRING_AI_AZURE_OPENAI_ENDPOINT="REPLACE_WITH_YOUR_ENDPOINT_HERE"

export SPRING_AI_AZURE_OPENAI_MODEL="REPLACE_WITH_YOUR_MODEL_NAME_HERE"

새로운 Spring 애플리케이션 만들기

새로운 Spring 프로젝트를 만듭니다.

Bash 창에서 앱에 대한 새 디렉터리를 만들고 해당 디렉터리로 이동합니다.

mkdir ai-chat-demo && cd ai-chat-demo

작업 디렉터리에서 spring init 명령을 실행합니다. 이 명령은 기본 Java 클래스 원본 파일과 Maven 기반 프로젝트 관리에 사용되는 pom.xml 파일을 포함하여 Spring 프로젝트에 대한 표준 디렉터리 구조를 만듭니다.

spring init -a ai-chat-demo -n AIChat --force --build maven -x

생성된 파일 및 폴더는 다음 구조와 유사합니다.

ai-chat-demo/

|-- pom.xml

|-- mvn

|-- mvn.cmd

|-- HELP.md

|-- src/

|-- main/

| |-- resources/

| | |-- application.properties

| |-- java/

| |-- com/

| |-- example/

| |-- aichatdemo/

| |-- AiChatApplication.java

|-- test/

|-- java/

|-- com/

|-- example/

|-- aichatdemo/

|-- AiChatApplicationTests.java

Spring 애플리케이션 편집

pom.xml 파일을 편집합니다.

프로젝트 디렉터리의 루트에서 원하는 편집기나 IDE로 pom.xml 파일을 열고 다음 콘텐츠로 파일을 덮어씁니다.

<?xml version="1.0" encoding="UTF-8"?> <project xmlns="http://maven.apache.org/POM/4.0.0" xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance" xsi:schemaLocation="http://maven.apache.org/POM/4.0.0 https://maven.apache.org/xsd/maven-4.0.0.xsd"> <modelVersion>4.0.0</modelVersion> <parent> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-parent</artifactId> <version>3.2.0</version> <relativePath/> <!-- lookup parent from repository --> </parent> <groupId>com.example</groupId> <artifactId>ai-chat-demo</artifactId> <version>0.0.1-SNAPSHOT</version> <name>AIChat</name> <description>Demo project for Spring Boot</description> <properties> <java.version>17</java.version> </properties> <dependencies> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter</artifactId> </dependency> <dependency> <groupId>org.springframework.experimental.ai</groupId> <artifactId>spring-ai-azure-openai-spring-boot-starter</artifactId> <version>0.7.0-SNAPSHOT</version> </dependency> <dependency> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-starter-test</artifactId> <scope>test</scope> </dependency> </dependencies> <build> <plugins> <plugin> <groupId>org.springframework.boot</groupId> <artifactId>spring-boot-maven-plugin</artifactId> </plugin> </plugins> </build> <repositories> <repository> <id>spring-snapshots</id> <name>Spring Snapshots</name> <url>https://repo.spring.io/snapshot</url> <releases> <enabled>false</enabled> </releases> </repository> </repositories> </project>src/main/java/com/example/aichatdemo 폴더에서 원하는 편집기나 IDE로 Ai채팅Application.java를 열고 다음 코드를 붙여넣습니다.

package com.example.aichatdemo; import java.util.ArrayList; import java.util.List; import org.springframework.ai.client.AiClient; import org.springframework.ai.prompt.Prompt; import org.springframework.ai.prompt.messages.ChatMessage; import org.springframework.ai.prompt.messages.Message; import org.springframework.ai.prompt.messages.MessageType; import org.springframework.beans.factory.annotation.Autowired; import org.springframework.boot.CommandLineRunner; import org.springframework.boot.SpringApplication; import org.springframework.boot.autoconfigure.SpringBootApplication; @SpringBootApplication public class AiChatApplication implements CommandLineRunner { private static final String ROLE_INFO_KEY = "role"; @Autowired private AiClient aiClient; public static void main(String[] args) { SpringApplication.run(AiChatApplication.class, args); } @Override public void run(String... args) throws Exception { System.out.println(String.format("Sending chat prompts to AI service. One moment please...\r\n")); final List<Message> msgs = new ArrayList<>(); msgs.add(new ChatMessage(MessageType.SYSTEM, "You are a helpful assistant")); msgs.add(new ChatMessage(MessageType.USER, "Does Azure OpenAI support customer managed keys?")); msgs.add(new ChatMessage(MessageType.ASSISTANT, "Yes, customer managed keys are supported by Azure OpenAI?")); msgs.add(new ChatMessage(MessageType.USER, "Do other Azure AI services support this too?")); final var resps = aiClient.generate(new Prompt(msgs)); System.out.println(String.format("Prompt created %d generated response(s).", resps.getGenerations().size())); resps.getGenerations().stream() .forEach(gen -> { final var role = gen.getInfo().getOrDefault(ROLE_INFO_KEY, MessageType.ASSISTANT.getValue()); System.out.println(String.format("Generated respose from \"%s\": %s", role, gen.getText())); }); } }Important

프로덕션의 경우 Azure Key Vault와 같은 자격 증명을 안전하게 저장하고 액세스하는 방법을 사용합니다. 자격 증명 보안에 대한 자세한 내용은 Azure AI 서비스 보안 문서를 참조하세요.

프로젝트 루트 폴더로 다시 이동하고 다음 명령을 사용하여 앱을 실행합니다.

./mvnw spring-boot:run

출력

. ____ _ __ _ _

/\\ / ___'_ __ _ _(_)_ __ __ _ \ \ \ \

( ( )\___ | '_ | '_| | '_ \/ _` | \ \ \ \

\\/ ___)| |_)| | | | | || (_| | ) ) ) )

' |____| .__|_| |_|_| |_\__, | / / / /

=========|_|==============|___/=/_/_/_/

:: Spring Boot :: (v3.1.5)

2023-11-07T13:31:10.884-06:00 INFO 6248 --- [ main] c.example.aichatdemo.AiChatApplication : No active profile set, falling back to 1 default profile: "default"

2023-11-07T13:31:11.595-06:00 INFO 6248 --- [ main] c.example.aichatdemo.AiChatApplication : Started AiChatApplication in 0.994 seconds (process running for 1.28)

Sending chat prompts to AI service. One moment please...

Prompt created 1 generated response(s).

Generated respose from "assistant": Yes, other Azure AI services also support customer managed keys. Azure AI Services, Azure Machine Learning, and other AI services in Azure provide options for customers to manage and control their encryption keys. This allows customers to have greater control over their data and security.

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

참고 항목

이 문서는 이제 Azure OpenAI를 완전히 지원하는 최신 OpenAI npm 패키지를 사용하도록 업데이트되었습니다. 레거시 Azure OpenAI JavaScript SDK에 대한 코드 예시를 찾고 있는 경우 현재 이 리포지토리에서 계속 제공되고 있습니다.

필수 조건

- Azure 구독 - 체험 구독 만들기

- Node.js의 LTS 버전

- 로컬 개발 환경에서 암호 없는 인증에 사용되는 Azure CLI는 Azure CLI로 로그인하여 필요한 컨텍스트를 만듭니다.

gpt-35-turbo또는gpt-4시리즈 모델이 배포된 Azure OpenAI Service 리소스. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

설정

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

노드 애플리케이션 만들기

콘솔 창(예: cmd, PowerShell 또는 Bash)에서 앱에 대한 새 디렉터리를 만들고 이 디렉터리로 이동합니다.

클라이언트 라이브러리 설치

새 디렉터리의 컨텍스트 내에서 npm을 사용하여 JavaScript용 필수 패키지를 설치합니다.

npm install openai @azure/identity

종속성이 있는 앱의 package.json 파일이 업데이트됩니다.

샘플 애플리케이션 만들기

새 프로젝트를 원하는 명령 프롬프트를 열고 ChatCompletion.js라는 새 파일을 만듭니다. 다음 코드를 ChatCompletion.js 파일에 복사합니다.

const { AzureOpenAI } = require("openai");

const {

DefaultAzureCredential,

getBearerTokenProvider

} = require("@azure/identity");

// You will need to set these environment variables or edit the following values

const endpoint = process.env["AZURE_OPENAI_ENDPOINT"] || "<endpoint>";

const apiVersion = "2024-05-01-preview";

const deployment = "gpt-4o"; //This must match your deployment name.

// keyless authentication

const credential = new DefaultAzureCredential();

const scope = "https://cognitiveservices.azure.com/.default";

const azureADTokenProvider = getBearerTokenProvider(credential, scope);

async function main() {

const client = new AzureOpenAI({ endpoint, apiKey, azureADTokenProvider, deployment });

const result = await client.chat.completions.create({

messages: [

{ role: "system", content: "You are a helpful assistant." },

{ role: "user", content: "Does Azure OpenAI support customer managed keys?" },

{ role: "assistant", content: "Yes, customer managed keys are supported by Azure OpenAI?" },

{ role: "user", content: "Do other Azure AI services support this too?" },

],

model: "",

});

for (const choice of result.choices) {

console.log(choice.message);

}

}

main().catch((err) => {

console.error("The sample encountered an error:", err);

});

module.exports = { main };

다음 명령을 사용하여 스크립트를 실행합니다.

node.exe ChatCompletion.js

출력

== Chat Completions Sample ==

{

content: 'Yes, several other Azure AI services also support customer managed keys for enhanced security and control over encryption keys.',

role: 'assistant'

}

참고 항목

오류가 발생하는 경우: 오류 발생: OpenAIError: apiKey 및 azureADTokenProvider 인수는 상호 배타적입니다. 한 번에 하나만 전달할 수 있습니다. 시스템에서 API 키에 대한 기존 환경 변수를 제거해야 할 수도 있습니다. Microsoft Entra ID 코드 샘플이 API 키 환경 변수를 명시적으로 참조하지 않더라도 이 샘플을 실행하는 시스템에 API 키 환경 변수가 있으면 이 오류가 계속 생성됩니다.

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

- Azure OpenAI 개요

- 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

참고 항목

이 문서는 이제 Azure OpenAI를 완전히 지원하는 최신 OpenAI npm 패키지를 사용하도록 업데이트되었습니다. 레거시 Azure OpenAI JavaScript SDK에 대한 코드 예시를 찾고 있는 경우 현재 이 리포지토리에서 계속 제공되고 있습니다.

필수 조건

- Azure 구독 - 체험 구독 만들기

- Node.js의 LTS 버전

- TypeScript

- 로컬 개발 환경에서 암호 없는 인증에 사용되는 Azure CLI는 Azure CLI로 로그인하여 필요한 컨텍스트를 만듭니다.

gpt-35-turbo또는gpt-4시리즈 모델이 배포된 Azure OpenAI Service 리소스입니다. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

설정

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

노드 애플리케이션 만들기

콘솔 창(예: cmd, PowerShell 또는 Bash)에서 앱에 대한 새 디렉터리를 만들고 이 디렉터리로 이동합니다.

클라이언트 라이브러리 설치

새 디렉터리의 컨텍스트 내에서 npm을 사용하여 JavaScript용 필수 패키지를 설치합니다.

npm install openai @azure/identity

종속성이 있는 앱의 package.json 파일이 업데이트됩니다.

샘플 애플리케이션 만들기

새 프로젝트를 원하는 명령 프롬프트를 열고 ChatCompletion.ts 새 파일을 만듭니다. 다음 코드를 ChatCompletion.ts 파일에 복사합니다.

import { AzureOpenAI } from "openai";

import {

DefaultAzureCredential,

getBearerTokenProvider

} from "@azure/identity";

import type {

ChatCompletion,

ChatCompletionCreateParamsNonStreaming,

} from "openai/resources/index";

// You will need to set these environment variables or edit the following values

const endpoint = process.env["AZURE_OPENAI_ENDPOINT"] || "<endpoint>";

// Required Azure OpenAI deployment name and API version

const apiVersion = "2024-08-01-preview";

const deploymentName = "gpt-4o-mini"; //This must match your deployment name.

// keyless authentication

const credential = new DefaultAzureCredential();

const scope = "https://cognitiveservices.azure.com/.default";

const azureADTokenProvider = getBearerTokenProvider(credential, scope);

function getClient(): AzureOpenAI {

return new AzureOpenAI({

endpoint,

azureADTokenProvider,

apiVersion,

deployment: deploymentName,

});

}

function createMessages(): ChatCompletionCreateParamsNonStreaming {

return {

messages: [

{ role: "system", content: "You are a helpful assistant." },

{

role: "user",

content: "Does Azure OpenAI support customer managed keys?",

},

{

role: "assistant",

content: "Yes, customer managed keys are supported by Azure OpenAI?",

},

{ role: "user", content: "Do other Azure AI services support this too?" },

],

model: "",

};

}

async function printChoices(completion: ChatCompletion): Promise<void> {

for (const choice of completion.choices) {

console.log(choice.message);

}

}

export async function main() {

const client = getClient();

const messages = createMessages();

const result = await client.chat.completions.create(messages);

await printChoices(result);

}

main().catch((err) => {

console.error("The sample encountered an error:", err);

});

다음 명령으로 스크립트를 작성합니다.

tsc

다음 명령을 사용하여 스크립트를 실행합니다.

node.exe ChatCompletion.js

출력

== Chat Completions Sample ==

{

content: 'Yes, several other Azure AI services also support customer managed keys for enhanced security and control over encryption keys.',

role: 'assistant'

}

참고 항목

오류가 발생하는 경우: 오류 발생: OpenAIError: apiKey 및 azureADTokenProvider 인수는 상호 배타적입니다. 한 번에 하나만 전달할 수 있습니다. 시스템에서 API 키에 대한 기존 환경 변수를 제거해야 할 수도 있습니다. Microsoft Entra ID 코드 샘플이 API 키 환경 변수를 명시적으로 참조하지 않더라도 이 샘플을 실행하는 시스템에 API 키 환경 변수가 있으면 이 오류가 계속 생성됩니다.

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

- Azure OpenAI 개요

- 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

라이브러리 소스 코드 | 패키지(PyPi) | RAG(Retrieval Augmented Generation) 엔터프라이즈 채팅 템플릿 |

필수 조건

- Azure 구독 - 체험 구독 만들기

- Python 3.8 이상 버전

- 다음 Python 라이브러리: os

gpt-35-turbo또는gpt-4모델이 배포된 Azure OpenAI Service 리소스입니다. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

설정

다음을 사용하여 OpenAI Python 클라이언트 라이브러리를 설치합니다.

pip install openai

참고 항목

이 라이브러리는 OpenAI에서 유지 관리합니다. 라이브러리의 최신 업데이트를 추적하려면 릴리스 기록을 참조하세요.

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

새 Python 애플리케이션 만들기

quickstart.py라는 새 Python 파일을 만듭니다. 선호하는 편집기 또는 IDE에서 이 파일을 엽니다.

quickstart.py의 내용을 다음 코드로 바꿉니다.

GPT-35-Turbo 또는 GPT-4 모델을 배포할 때 선택한 배포 이름으로 model 변수를 설정해야 합니다. 기본 모델 이름과 동일한 배포 이름을 선택하지 않으면 모델 이름을 입력할 때 오류가 발생합니다.

import os

from openai import AzureOpenAI

client = AzureOpenAI(

azure_endpoint = os.getenv("AZURE_OPENAI_ENDPOINT"),

api_key=os.getenv("AZURE_OPENAI_API_KEY"),

api_version="2024-02-01"

)

response = client.chat.completions.create(

model="gpt-35-turbo", # model = "deployment_name".

messages=[

{"role": "system", "content": "You are a helpful assistant."},

{"role": "user", "content": "Does Azure OpenAI support customer managed keys?"},

{"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."},

{"role": "user", "content": "Do other Azure AI services support this too?"}

]

)

print(response.choices[0].message.content)

Important

프로덕션의 경우 Azure Key Vault와 같은 자격 증명을 안전하게 저장하고 액세스하는 방법을 사용합니다. 자격 증명 보안에 대한 자세한 내용은 Azure AI 서비스 보안 문서를 참조하세요.

quickstart 파일의

python명령을 사용하여 애플리케이션을 실행합니다.python quickstart.py

출력

{

"choices": [

{

"finish_reason": "stop",

"index": 0,

"message": {

"content": "Yes, most of the Azure AI services support customer managed keys. However, not all services support it. You can check the documentation of each service to confirm if customer managed keys are supported.",

"role": "assistant"

}

}

],

"created": 1679001781,

"id": "chatcmpl-6upLpNYYOx2AhoOYxl9UgJvF4aPpR",

"model": "gpt-3.5-turbo-0301",

"object": "chat.completion",

"usage": {

"completion_tokens": 39,

"prompt_tokens": 58,

"total_tokens": 97

}

}

Yes, most of the Azure AI services support customer managed keys. However, not all services support it. You can check the documentation of each service to confirm if customer managed keys are supported.

메시지 구조 이해

GPT-35-Turbo 및 GPT-4 모델은 대화형식의 입력 작업에 최적화되어 있습니다. messages 변수는 시스템, 사용자 및 도우미가 기술하는 대화에서 서로 다른 역할을 가진 사전 배열을 전달합니다. 시스템 메시지는 모델이 응답하는 방법에 대한 컨텍스트 또는 지침을 포함하여 모델을 대비시키는 데 사용할 수 있습니다.

GPT-35-Turbo 및 GPT-4 방법 가이드는 이러한 새로운 모델과 통신하기 위한 옵션에 대해 심층적으로 소개합니다.

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

- 방법 가이드를 통해 GPT-35-Turbo 및 GPT-4 모델로 작업하는 방법에 대해 자세히 알아봅니다.

- 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

필수 조건

- Azure 구독 – 체험 구독을 만듭니다.

gpt-35-turbo또는gpt-4모델이 배포된 Azure OpenAI Service 리소스입니다. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

설정

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 키 및 엔드포인트 섹션은 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

setx AZURE_OPENAI_API_KEY "REPLACE_WITH_YOUR_KEY_VALUE_HERE"

setx AZURE_OPENAI_ENDPOINT "REPLACE_WITH_YOUR_ENDPOINT_HERE"

REST API

BASH 셸에서 다음 명령을 실행합니다. gpt-35-turbo를 GPT-35-Turbo 또는 GPT-4 모델을 배포할 때 선택한 배포 이름으로 바꿔야 합니다. 기본 모델 이름과 동일한 배포 이름을 선택하지 않으면 모델 이름을 입력할 때 오류가 발생합니다.

curl $AZURE_OPENAI_ENDPOINT/openai/deployments/gpt-35-turbo/chat/completions?api-version=2024-02-01 \

-H "Content-Type: application/json" \

-H "api-key: $AZURE_OPENAI_API_KEY" \

-d '{"messages":[{"role": "system", "content": "You are a helpful assistant."},{"role": "user", "content": "Does Azure OpenAI support customer managed keys?"},{"role": "assistant", "content": "Yes, customer managed keys are supported by Azure OpenAI."},{"role": "user", "content": "Do other Azure AI services support this too?"}]}'

예제 엔드포인트를 사용하는 명령의 첫 번째 줄 형식은 curl https://docs-test-001.openai.azure.com/openai/deployments/{YOUR-DEPLOYMENT_NAME_HERE}/chat/completions?api-version=2024-02-01 \ 같이 표시됩니다. 오류가 발생하면 엔드포인트와 /openai/deployments를 구분할 때 /를 두 번 사용하지 않았는지 다시 한 번 확인합니다.

일반 Windows 명령 프롬프트에서 이 명령을 실행하려면 텍스트를 변경하여 \ 및 줄 바꿈을 제거해야 합니다.

Important

프로덕션의 경우 Azure Key Vault와 같은 자격 증명을 안전하게 저장하고 액세스하는 방법을 사용합니다. 자격 증명 보안에 대한 자세한 내용은 Azure AI 서비스 보안 문서를 참조하세요.

출력

{"id":"chatcmpl-6v7mkQj980V1yBec6ETrKPRqFjNw9",

"object":"chat.completion","created":1679072642,

"model":"gpt-35-turbo",

"usage":{"prompt_tokens":58,

"completion_tokens":68,

"total_tokens":126},

"choices":[{"message":{"role":"assistant",

"content":"Yes, other Azure AI services also support customer managed keys. Azure AI services offer multiple options for customers to manage keys, such as using Azure Key Vault, customer-managed keys in Azure Key Vault or customer-managed keys through Azure Storage service. This helps customers ensure that their data is secure and access to their services is controlled."},"finish_reason":"stop","index":0}]}

읽기 용이성을 위해 조정된 출력 서식입니다. 실제 출력은 줄 바꿈이 없는 단일 텍스트 블록입니다.

메시지 구조 이해

GPT-35-Turbo 및 GPT-4 모델은 대화형식의 입력 작업에 최적화되어 있습니다. messages 변수는 시스템, 사용자 및 도우미가 기술하는 대화에서 서로 다른 역할을 가진 사전 배열을 전달합니다. 시스템 메시지는 모델이 응답하는 방법에 대한 컨텍스트 또는 지침을 포함하여 모델을 대비시키는 데 사용할 수 있습니다.

GPT-35-Turbo 및 GPT-4 방법 가이드는 이러한 새로운 모델과 통신하기 위한 옵션에 대해 심층적으로 소개합니다.

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

- 방법 가이드를 통해 GPT-35-Turbo 및 GPT-4 모델로 작업하는 방법에 대해 자세히 알아봅니다.

- 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.

필수 조건

- Azure 구독 - 체험 구독 만들기

- 최신 버전인 PowerShell 7 또는 Windows PowerShell 5.1을 사용할 수 있습니다.

- 모델이 배포된 Azure OpenAI 서비스 리소스. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

gpt-35-turbo또는gpt-4모델이 배포된 Azure OpenAI Service 리소스입니다. 모델 배포에 대한 자세한 내용은 리소스 배포 가이드를 참조하세요.

키 및 엔드포인트 검색

Azure OpenAI에 대해 성공적으로 호출하려면 엔드포인트와 키가 필요합니다.

| 변수 이름 | 값 |

|---|---|

ENDPOINT |

서비스 엔드포인트는 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. 또는 Azure AI Foundry 포털의 배포 페이지를 통해 엔드포인트를 찾을 수 있습니다. 예제 엔드포인트는 https://docs-test-001.openai.azure.com/입니다. |

API-KEY |

이 값은 Azure Portal에서 리소스를 검사할 때 키 및 엔드포인트 섹션에서 찾을 수 있습니다. KEY1 또는 KEY2를 사용할 수 있습니다. |

Azure Portal에서 해당 리소스로 이동합니다. 엔드포인트 및 키는 리소스 관리 섹션에서 찾을 수 있습니다. 엔드포인트 및 액세스 키를 복사합니다. API 호출을 인증하는 데 모두 필요합니다. KEY1 또는 KEY2를 사용할 수 있습니다. 항상 두 개의 키를 사용하면 서비스 중단 없이 키를 안전하게 회전하고 다시 생성할 수 있습니다.

환경 변수

키 및 엔드포인트에 대한 영구 환경 변수를 만들고 할당합니다.

Important

API 키를 사용하는 경우 Azure Key Vault와 같은 다른 위치에 안전하게 저장합니다. API 키를 코드에 직접 포함하지 말고, 공개적으로 게시하지 마세요.

AI 서비스 보안에 대한 자세한 내용은 Azure AI 서비스에 대한 요청 인증을 참조하세요.

$Env:AZURE_OPENAI_API_KEY = 'YOUR_KEY_VALUE'

$Env:AZURE_OPENAI_ENDPOINT = 'YOUR_ENDPOINT'

새 PowerShell 스크립트 만들기

빠른 시작.ps1이라는 새 PowerShell 파일을 만듭니다. 선호하는 편집기 또는 IDE에서 이 파일을 엽니다.

quickstart.ps1의 내용을 다음 코드로 바꿉니다. GPT-35-Turbo 또는 GPT-4 모델을 배포할 때 선택한 배포 이름으로

engine변수를 설정해야 합니다. 기본 모델 이름과 동일한 배포 이름을 선택하지 않으면 모델 이름을 입력할 때 오류가 발생합니다.# Azure OpenAI metadata variables $openai = @{ api_key = $Env:AZURE_OPENAI_API_KEY api_base = $Env:AZURE_OPENAI_ENDPOINT # your endpoint should look like the following https://YOUR_RESOURCE_NAME.openai.azure.com/ api_version = '2024-02-01' # this may change in the future name = 'YOUR-DEPLOYMENT-NAME-HERE' #This will correspond to the custom name you chose for your deployment when you deployed a model. } # Completion text $messages = @() $messages += @{ role = 'system' content = 'You are a helpful assistant.' } $messages += @{ role = 'user' content = 'Does Azure OpenAI support customer managed keys?' } $messages += @{ role = 'assistant' content = 'Yes, customer managed keys are supported by Azure OpenAI.' } $messages += @{ role = 'user' content = 'Do other Azure AI services support this too?' } # Header for authentication $headers = [ordered]@{ 'api-key' = $openai.api_key } # Adjust these values to fine-tune completions $body = [ordered]@{ messages = $messages } | ConvertTo-Json # Send a request to generate an answer $url = "$($openai.api_base)/openai/deployments/$($openai.name)/chat/completions?api-version=$($openai.api_version)" $response = Invoke-RestMethod -Uri $url -Headers $headers -Body $body -Method Post -ContentType 'application/json' return $responseImportant

프로덕션의 경우 Azure Key Vault를 사용한 PowerShell 비밀 관리와 같은 자격 증명을 안전하게 저장하고 액세스하는 방법을 사용합니다. 자격 증명 보안에 대한 자세한 내용은 Azure AI 서비스 보안 문서를 참조하세요.

PowerShell을 사용하여 스크립트를 실행합니다.

./quickstart.ps1

출력

# the output of the script will be a .NET object containing the response

id : chatcmpl-7sdJJRC6fDNGnfHMdfHXvPkYFbaVc

object : chat.completion

created : 1693255177

model : gpt-35-turbo

choices : {@{index=0; finish_reason=stop; message=}}

usage : @{completion_tokens=67; prompt_tokens=55; total_tokens=122}

# convert the output to JSON

./quickstart.ps1 | ConvertTo-Json -Depth 3

# or to view the text returned, select the specific object property

$reponse = ./quickstart.ps1

$response.choices.message.content

메시지 구조 이해

GPT-35-Turbo 및 GPT-4 모델은 대화형식의 입력 작업에 최적화되어 있습니다. messages 변수는 시스템, 사용자 및 도우미가 기술하는 대화에서 서로 다른 역할을 가진 사전 배열을 전달합니다. 시스템 메시지는 모델이 응답하는 방법에 대한 컨텍스트 또는 지침을 포함하여 모델을 대비시키는 데 사용할 수 있습니다.

GPT-35-Turbo 및 GPT-4 방법 가이드는 이러한 새로운 모델과 통신하기 위한 옵션에 대해 심층적으로 소개합니다.

리소스 정리

Azure OpenAI 리소스를 정리하고 제거하려면 해당 리소스를 삭제할 수 있습니다. 리소스를 삭제하기 전에 먼저 배포된 모델을 삭제해야 합니다.

다음 단계

- 방법 가이드를 통해 GPT-35-Turbo 및 GPT-4 모델로 작업하는 방법에 대해 자세히 알아봅니다.

- 더 많은 예제를 보려면 Azure OpenAI 샘플 GitHub 리포지토리를 체크 아웃합니다.