Azure AI Foundry를 사용하여 모델 미세 조정

Important

이 문서에 표시된 항목(미리 보기)은 현재 퍼블릭 미리 보기에서 확인할 수 있습니다. 이 미리 보기는 서비스 수준 계약 없이 제공되며, 프로덕션 워크로드에는 권장되지 않습니다. 특정 기능이 지원되지 않거나 기능이 제한될 수 있습니다. 자세한 내용은 Microsoft Azure Preview에 대한 추가 사용 약관을 참조하세요.

미세 조정은 성능 향상, 새로운 기술 또는 향상된 정확도를 위해 특정 작업 또는 새 데이터 세트에 대한 추가 교육을 통해 미리 학습된 생성 AI 모델을 사용자 지정하는 것을 의미합니다. 결과는 제공된 예제에 따라 최적화된 새로운 사용자 지정 GenAI 모델입니다.

GenAI 모델을 다음과 같이 미세 조정하는 것이 좋습니다.

- 특정 엔터프라이즈 요구 사항에 맞게 크기 조정 및 조정

- 맞춤형 모델이 부정확하거나 관련이 없는 응답을 생성할 가능성이 적기 때문에 가양성 감소

- 도메인별 작업에 대한 모델의 정확도 향상

- 더 빠르고 정확한 결과를 통해 시간과 리소스 절약

- 모델이 특정 사용 사례에 맞게 미세 조정됨에 따라 더 관련성이 높고 컨텍스트 인식 결과를 얻습니다.

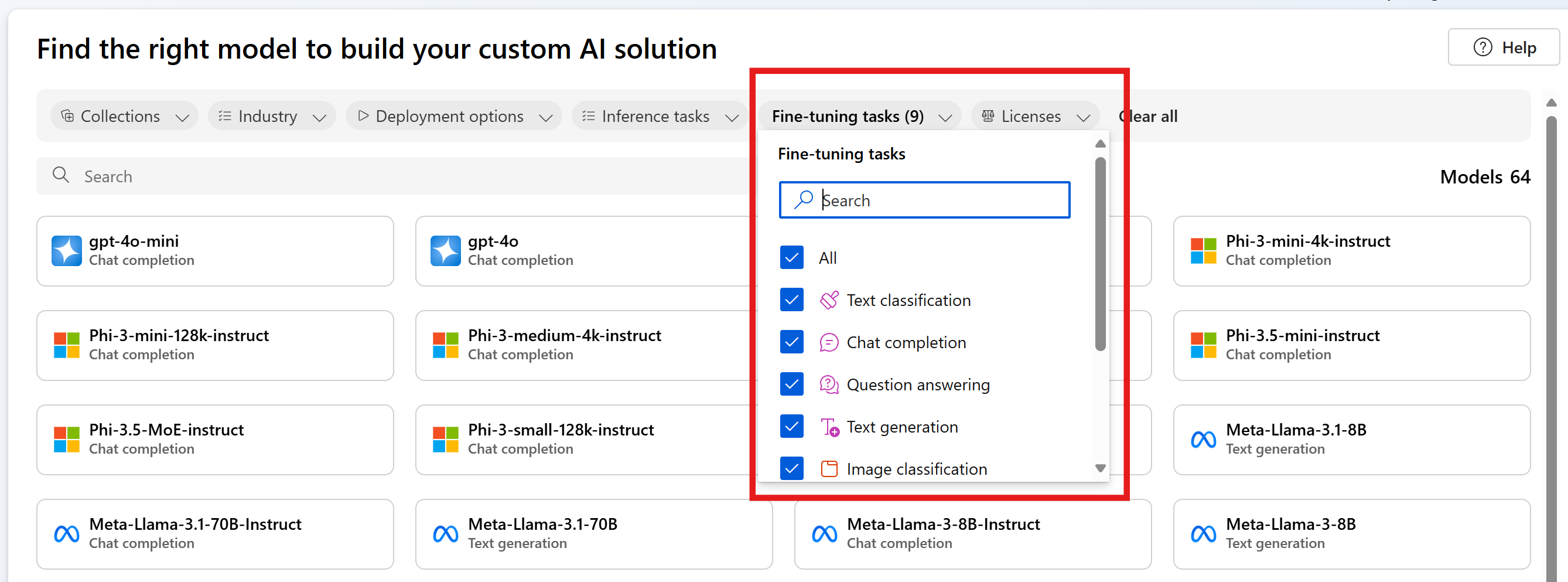

Azure AI Foundry 는 모델 공급자 간에 여러 모델을 제공하여 시장에서 가장 최신의 최신 모델에 액세스할 수 있도록 합니다. 미세 조정 작업 필터를 사용하고 모델 카드를 선택하여 각 모델에 대한 자세한 정보를 확인하여 모델 카탈로그를 통해 미세 조정에 지원되는 모델을 검색할 수 있습니다. 특정 모델에는 지역 제약 조건이 적용될 수 있습니다. 자세한 내용은 이 목록을 참조하세요.

이 문서에서는 미세 조정을 위한 사용 사례와 이를 통해 GenAI 여정에 도움이 되는 방법을 안내합니다.

미세 조정 시작

생성 AI 여정을 시작할 때는 기본 모델 및 해당 기능에 익숙해지도록 프롬프트 엔지니어링 및 RAG부터 시작하는 것이 좋습니다.

- 프롬프트 엔지니어링 은 톤 및 스타일 세부 정보, 예제 응답 및 자연어 처리 모델에 대한 의도 매핑을 사용하여 프롬프트를 디자인하는 기술입니다. 이 프로세스는 응답의 정확도와 관련성을 향상시켜 모델의 성능을 최적화합니다.

- RAG(검색 증강 생성)는 외부 원본에서 데이터를 검색하고 프롬프트에 통합하여 LLM 성능을 향상시킵니다. RAG를 사용하면 기업은 데이터 관련성을 유지하고 비용을 최적화하면서 사용자 지정 솔루션을 달성할 수 있습니다.

편안하게 솔루션을 빌드하기 시작하면 프롬프트 엔지니어링이 부족한 위치를 이해하는 것이 중요하며 미세 조정을 시도해야 하는지 파악하는 데 도움이 됩니다.

- 기본 모델이 에지 사례 또는 예외에서 실패하나요?

- 기본 모델이 올바른 형식으로 출력을 일관되게 제공하지 않나요?

- 컨텍스트 창에서 모델을 조정하기에 충분한 예제를 맞추기가 어렵습니까?

- 대기 시간이 높습니까?

기본 모델 및 프롬프트 엔지니어링을 사용하는 오류의 예는 미세 조정을 위해 수집할 데이터를 식별하고 미세 조정된 모델을 평가하고 비교할 수 있는 성능 기준을 설정하는 데 도움이 될 수 있습니다. 미세 조정 없는 성능에 대한 기준을 설정하는 작업은 미세 조정이 모델 성능을 향상시켰는지 여부를 파악하는 데 필수적입니다.

예를 들면 다음과 같습니다.

고객은 GPT-3.5 Turbo를 사용하여 자연어 질문을 특정 비표준 쿼리 언어의 쿼리로 전환하려고 합니다. 고객은 프롬프트에 지침("항상 GQL 반환")을 제공하고 RAG를 사용하여 데이터베이스 스키마를 검색했습니다. 그러나 구문이 항상 올바른 것은 아니었으며 에지 사례에 대해 종종 실패했습니다. 고객은 모델이 이전에 실패한 경우를 포함하여 수천 개의 자연어 질문 예제와 데이터베이스에 대한 동등한 쿼리를 수집합니다. 그런 다음 고객은 해당 데이터를 사용하여 모델을 미세 조정합니다. 새로 미세 조정된 모델과 엔지니어링된 프롬프트 및 검색을 결합하면 모델 출력의 정확도가 허용 가능한 사용 기준에 도달합니다.

사용 사례

기본 모델은 이미 방대한 양의 데이터에 대해 미리 학습되어 있으며 대부분의 경우 원하는 품질 응답을 얻기 위해 프롬프트에 지침과 예제를 추가합니다. 이 프로세스를 "몇 번의 학습"이라고 합니다. 미세 조정을 사용하면 특정 사용 사례에 맞게 조정할 수 있는 더 많은 예제를 사용하여 모델을 학습할 수 있으므로 몇 번의 학습이 향상됩니다. 이렇게 하면 프롬프트에서 토큰 수를 줄여 잠재적인 비용 절감 및 대기 시간이 짧은 요청으로 이어질 수 있습니다.

자연어를 쿼리 언어로 전환하는 것은 모델에서 동작하는 방법을 알려주지 않는 하나의 사용 사례일 뿐입니다. 몇 가지 추가 사용 사례는 다음과 같습니다.

- 검색된 데이터의 모델 처리 개선

- 특정 스타일, 톤 또는 형식으로 콘텐츠를 출력하도록 모델 조정

- 정보를 조회할 때 정확도 향상

- 프롬프트 길이 줄이기

- 새로운 기술 교육(즉, 코딩할 자연어)

비용이 주요 동기 부여자라고 판단할 경우 신중하게 진행합니다. 미세 조정은 프롬프트를 줄이거나 더 작은 모델을 사용할 수 있도록 하여 특정 사용 사례에 대한 비용을 줄일 수 있습니다. 그러나 학습에 대한 선불 비용이 더 높을 수 있으며 사용자 지정 모델을 호스팅하는 비용을 지불해야 합니다.

모델을 미세 조정하는 단계

다음은 모델을 미세 조정하는 일반적인 단계입니다.

- 사용 사례에 따라 작업을 지원하는 모델을 선택합니다.

- 학습 데이터 준비 및 업로드

- (선택 사항) 유효성 검사 데이터 준비 및 업로드

- (선택 사항) 작업 매개 변수 구성

- 모델을 학습시킵니다.

- 완료되면 메트릭을 검토하고 모델을 평가합니다. 결과가 벤치마크를 충족하지 않는 경우 2단계로 돌아갑니다.

- 미세 조정된 모델 사용

미세 조정은 제공할 수 있는 데이터의 품질에 크게 좌우됩니다. 성공하고 원하는 결과를 얻기 위해 수백 개의 학습 예제를 제공하는 것이 가장 좋습니다.

미세 조정을 위해 지원되는 모델

이제 사용 사례에 미세 조정을 사용하는 시기를 알게 되었으므로 Azure AI Foundry로 이동하여 미세 조정에 사용할 수 있는 모델을 찾을 수 있습니다. 모델 카탈로그의 일부 모델의 경우 서버리스 API 또는 관리형 컴퓨팅(미리 보기) 또는 둘 다를 사용하여 미세 조정을 사용할 수 있습니다.

세부 조정은 서버리스 API를 통해 배포되는 일부 모델에 대해 특정 Azure 지역에서 사용할 수 있습니다. 이러한 모델을 미세 조정하려면 사용자가 모델을 미세 조정하는 데 사용할 수 있는 지역에 허브/프로젝트가 있어야 합니다. 자세한 내용은 서버리스 API 엔드포인트 모델의 지역 가용성을 참조하세요.

관리 컴퓨팅(미리 보기)을 사용하여 미세 조정하는 방법에 대한 자세한 내용은 관리 컴퓨팅(미리 보기)을 사용하여 모델 미세 조정을 참조하세요.

미세 조정에 사용할 수 있는 Azure OpenAI 모델에 대한 자세한 내용은 이 가이드의 뒷부분에 있는 Azure OpenAI 서비스 모델 설명서 또는 Azure OpenAI 모델 테이블을 참조하세요.

미세 조정할 수 있는 Azure OpenAI 서비스 모델의 경우 미세 조정을 위해 지원되는 지역에는 미국 중북부, 스웨덴 중부 등이 포함됩니다.

Azure OpenAI 모델 미세 조정

참고 항목

gpt-35-turbo - 이 모델의 미세 조정은 하위 지역 집합으로 제한되며 기본 모델을 사용할 수 있는 모든 지역에서는 사용할 수 없습니다.

Azure AI Foundry 프로젝트에서 Azure OpenAI 모델을 사용하는 경우와 프로젝트 외부를 사용하는 경우 미세 조정에 지원되는 지역이 달라질 수 있습니다.

| Model ID | 미세 조정 지역 | 최대 요청(토큰) | 학습 데이터(최대) |

|---|---|---|---|

babbage-002 |

미국 중북부 스웨덴 중부 스위스 서부 |

16,384 | 2021년 9월 |

davinci-002 |

미국 중북부 스웨덴 중부 스위스 서부 |

16,384 | 2021년 9월 |

gpt-35-turbo(0613) |

미국 동부2 미국 중북부 스웨덴 중부 스위스 서부 |

4,096 | 2021년 9월 |

gpt-35-turbo(1106) |

미국 동부2 미국 중북부 스웨덴 중부 스위스 서부 |

입력: 16,385 출력: 4,096 |

2021년 9월 |

gpt-35-turbo (0125) |

미국 동부2 미국 중북부 스웨덴 중부 스위스 서부 |

16,385 | 2021년 9월 |

gpt-4 (0613) 1 |

미국 중북부 스웨덴 중부 |

8192 | 2021년 9월 |

gpt-4o-mini(2024-07-18) |

미국 중북부 스웨덴 중부 |

입력: 128,000 출력: 16,384 학습 예제 컨텍스트 길이: 64,536 |

2023년 10월 |

gpt-4o (2024-08-06) |

미국 동부2 미국 중북부 스웨덴 중부 |

입력: 128,000 출력: 16,384 학습 예제 컨텍스트 길이: 64,536 |

2023년 10월 |

1 GPT-4는 현재 공개 미리 보기로 제공됩니다.