2단계. 이해 관계자 피드백 수집을 위한 POC 배포

이 단계가 끝나면 이해 관계자가 POC에 대한 피드백을 테스트하고 제공할 수 있는 에이전트 평가 검토 앱을 배포하게 됩니다. 관련자의 사용 현황 및 피드백의 자세한 로그는 Lakehouse의 Delta Tables로 전달됩니다.

요구 사항

- 1단계. 코드 리포지토리 복제 및 컴퓨팅 만들기 단계 완료

- 필수 조건 데이터: 요구 사항 수집은 Unity Catalog볼륨내의 Lakehouse에서 사용할 수 있습니다.

이 섹션의 샘플 코드는 GitHub 리포지토리에서 확인하세요.

개념 증명 RAG 애플리케이션

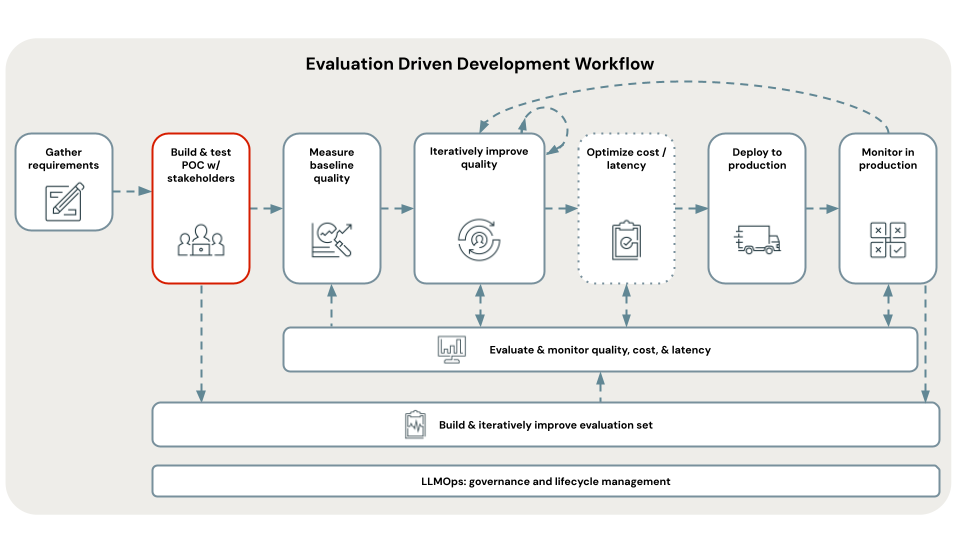

평가 기반 개발의 첫 번째 단계는 POC(개념 증명)를 빌드하는 것입니다. POC는 다음과 같은 이점을 제공합니다.

- RAG를 사용하여 사용 사례의 타당성에 대한 방향 보기를 제공합니다.

- 이해 관계자로부터 초기 피드백을 수집할 수 있으므로 평가 Set 첫 번째 버전을 만들 수 있습니다.

- 반복을 시작할 품질 기준 측정을 설정합니다.

Databricks는 가장 간단한 RAG 아키텍처를 사용하여 POC를 빌드하고 각 매개 변수에 대해 Databricks 권장 기본값을 사용하는 것이 좋습니다.

이 권장 사항은 RAG 애플리케이션 내에서 조정할 수 있는 수백 가지 가능한 parameters 조합이 있기 때문입니다. 이러한 튜닝을 몇 주 동안 쉽게 수행할 수 있지만 RAG를 체계적으로 평가하기 전에 설정에서 POC doom 루프라고 하는 항목을 반복하지만 개선이 있었는지 객관적으로 알 수 있는 방법은 없지만 이해 관계자가 참을성 있게 검토하기를 기다리는 동안 모든 작업을 수행합니다.

이 자습서의 POC 템플릿은 품질 반복을 염두에 두고 설계되었습니다. DATAbricks 연구 팀이 RAG 품질을 개선하기 위해 조정하는 것이 중요하다고 보여 준 내용에 따라 매개 변수화됩니다. 이러한 템플릿은 "마술처럼 RAG를 만드는 3개의 코드 줄"이 아니라 평가 기반 개발 워크플로의 다음 단계에서 품질을 위해 조정할 수 있는 잘 구성된 RAG 애플리케이션입니다.

이를 통해 POC를 신속하게 배포할 수 있지만 코드를 다시 작성할 필요 없이 신속하게 품질 반복으로 전환할 수 있습니다.

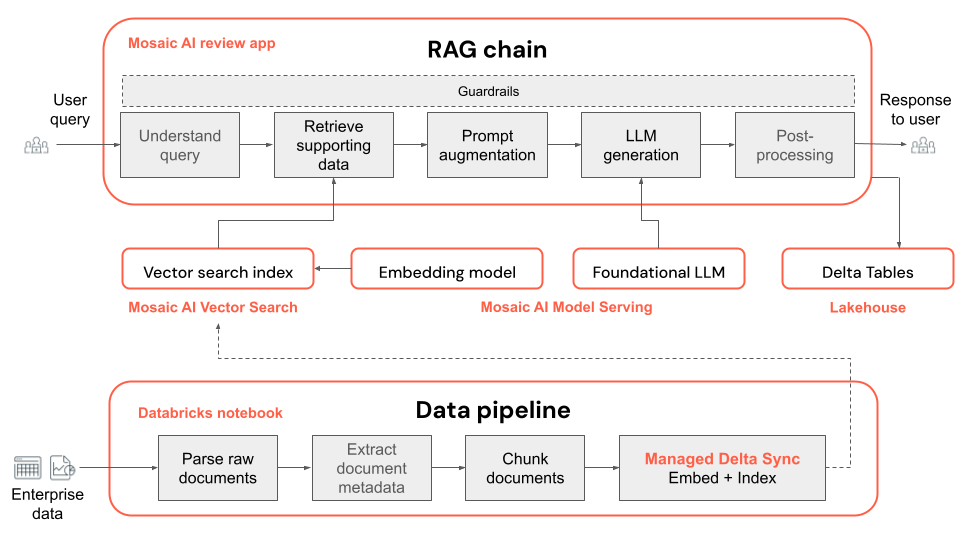

다음은 POC 애플리케이션의 기술 아키텍처입니다.

참고 항목

기본적으로 POC는 Mosaic AI 파운데이션 모델 서빙에서 사용할 수 있는 오픈 소스 모델을 사용합니다. 그러나 POC는 파운데이션 모델을 지원하는 Mosaic AI 모델 서빙을 사용하기 때문에 다른 모델을 사용하는 것은 쉽습니다. 모델 서빙에서 해당 모델을 구성한 다음 embedding_endpoint_name Notebook에서 llm_endpoint_name 및 00_config을(를) 교체하기만 하면 됩니다.

- Databricks Marketplace에서 사용할 수 있는 다른 오픈 소스 모델에 대해 프로비전된 처리량 파운데이션 모델 API를 따릅니다.

- Azure OpenAI, OpenAI, Cohere, Anthropic 및 Google Gemini와 같은 지원되는 타사 호스팅 모델에 대해 Create_OpenAI_External_Model Notebook 또는 Mosaic AI 모델 서빙의 외부 모델을 따릅니다.

피드백을 수집하기 위해 POC를 배포하는 단계

다음 단계에서는 POC 생성형 AI 애플리케이션을 실행하고 배포하는 방법을 보여줍니다. 배포한 후에는 관련자와 공유하여 피드백을 수집할 수 있는 URL을 검토 앱에 get.

데이터 형식에 따라 A_POC_app 내에서 POC 코드 폴더를 엽니다.

- PDF 파일의 경우 pdf_uc_volume을 사용합니다.

- Powerpoint 파일의 경우 pptx_uc_volume을 사용합니다.

- DOCX 파일의 경우 docx_uc_volume을 사용합니다.

- 텍스트, markdown, HTML 콘텐츠 및 메타데이터가 있는 JSON 파일은 json_uc_volume을 사용합니다.

데이터가 위의 요구 사항 중 하나를 충족하지 않는 경우 위의 POC 디렉터리의

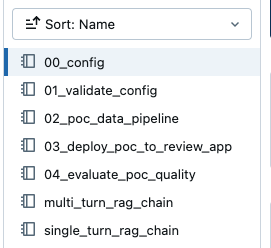

parser_udf내에서 구문 분석 함수(02_poc_data_pipeline)를 사용자 지정하여 파일 형식으로 작업할 수 있습니다.POC 폴더 내에 다음 Notebooks가 표시됩니다.

필요에 따라 기본 parameters를 검토하십시오.

위에서 선택한 POC 디렉터리 내에서

00_config노트북을 열어 데이터 파이프라인 및 RAG 체인에 대한 애플리케이션의 기본 parameters을 봅니다.Important

Databricks가 권장하는 기본 parameters은 완벽하도록 의도된 것이 아니며, 시작점으로서의 역할을 합니다. 이 워크플로의 다음 단계에서는 이러한 parameters에 대해 반복 작업을 안내합니다.

구성의 유효성을 검사합니다.

01_validate_config를 실행하여 구성이 유효하고 모든 리소스를 사용할 수 있는지 확인합니다.rag_chain_config.yaml파일이 애플리케이션을 배포하는 데 사용되는 디렉터리에 나타납니다.데이터 파이프라인을 실행합니다.

POC 데이터 파이프라인은 Apache Spark를 기반으로 하는 Databricks Notebook입니다.

02_poc_data_pipelineNotebook을 열고 모두 실행을 눌러 파이프라인을 실행합니다. 파이프라인은 다음을 수행합니다.- UC 볼륨에서 원시 문서 로드

- 각 문서를 구문 분석하여 결과를 Delta Table에 저장합니다.

- 각 문서를 청크로 나누고 결과를 Delta Table에 저장합니다.

- Mosaic AI 벡터 검색을 사용하여 문서 포함 및 벡터 인덱스 만들기

데이터 파이프라인에 대한 출력 tables 및 구성과 같은 메타데이터는 MLflow에 기록됩니다.

Notebook 아래쪽에 있는 Delta Tables 또는 벡터 인덱스 출력에 대한 링크를 찾아 출력을 검사할 수 있습니다.

Vector index: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>_poc_chunked_docs_gold_index Output tables: Bronze Delta Table w/ raw files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_raw_files_bronze Silver Delta Table w/ parsed files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_parsed_docs_silver Gold Delta Table w/ chunked files: https://<your-workspace-url>.databricks.com/explore/data/<uc-catalog>/<uc-schema>/<app-name>__poc_chunked_docs_gold검토 앱에 POC 체인을 배포합니다.

기본 POC 체인은 LangChain을 사용하여 빌드된 멀티 턴 RAG 체인입니다.

참고 항목

POC 체인은 MLflow 코드 기반 로깅을 사용합니다. 코드 기반 로깅에 대한 자세한 내용은 로그 및 등록 AI 에이전트를 참조하세요.

03_deploy_poc_to_review_appNotebook 열기Notebook의 각 셀을 실행합니다.

MLflow 추적은 POC 애플리케이션의 작동 방식을 보여 줍니다. 입력 질문을 사용 사례와 관련된 질문으로 조정하고 셀을 다시 실행하여 애플리케이션을 "바이브 확인"합니다.

사용 사례와 관련되도록 기본 지침을 수정합니다. 이는 검토 앱에 표시됩니다.

instructions_to_reviewer = f"""## Instructions for Testing the {RAG_APP_NAME}'s Initial Proof of Concept (PoC) Your inputs are invaluable for the development team. By providing detailed feedback and corrections, you help us fix issues and improve the overall quality of the application. We rely on your expertise to identify any gaps or areas needing enhancement. 1. **Variety of Questions**: - Please try a wide range of questions that you anticipate the end users of the application will ask. This helps us ensure the application can handle the expected queries effectively. 2. **Feedback on Answers**: - After asking each question, use the feedback widgets provided to review the answer given by the application. - If you think the answer is incorrect or could be improved, please use "Edit Answer" to correct it. Your corrections will enable our team to refine the application's accuracy. 3. **Review of Returned Documents**: - Carefully review each document that the system returns in response to your question. - Use the thumbs up/down feature to indicate whether the document was relevant to the question asked. A thumbs up signifies relevance, while a thumbs down indicates the document was not useful. Thank you for your time and effort in testing {RAG_APP_NAME}. Your contributions are essential to delivering a high-quality product to our end users.""" print(instructions_to_reviewer)배포 셀을 실행하여 검토 앱에 대한 링크를 get.

Review App URL: https://<your-workspace-url>.databricks.com/ml/review/<uc-catalog>.<uc-schema>.<uc-model-name>/<uc-model-version>

검토 앱에 액세스할 수 있는 개별 사용자의 권한을 Grant으로 설정합니다.

검토 앱사용할 수 있는 권한을

단계를 수행하여 Databricks가 아닌 사용자에 대한 액세스를 수 있습니다. 몇 가지 질문을 직접 하고 피드백을 제공하여 검토 앱을 테스트합니다.

참고 항목

검토 앱의 MLflow 추적 및 사용자의 피드백은, 구성한 catalogschema에서 델타 Tables에 나타납니다. 이러한 Delta Tables로그는 나타나는 데 최대 2시간이 걸릴 수 있습니다.

이해 관계자와 검토 앱 공유

이제 POC RAG 애플리케이션을 이해 관계자와 공유하여 피드백을 get 수 있습니다.

Important

Databricks는 POC를 3개 이상의 이해 관계자에게 배포하고 각각 10~20개의 질문을 having 제안합니다. 평가 set포함할 다양한 관점 set 가질 수 있도록 여러 이해 관계자가 POC를 테스트하도록 하는 것이 중요합니다.

다음 단계

3단계를 계속 진행합니다. 관련자 피드백를 바탕으로 평가 Set을 작성합니다.