Spark 작업 정의 Git 통합

이 문서에서는 Microsoft Fabric의 Spark SJD(작업 정의)에 대한 Git 통합이 작동하는 방식을 설명합니다. 리포지토리 연결을 설정하고, 원본 제어를 통해 Spark 작업 정의 변경 내용을 관리하고, 다양한 작업 영역에 배포하는 방법을 알아봅니다.

Azure DevOps에서 Spark 작업 정의에 Git 통합을 사용하도록 설정하면 전체 Git 기록을 통해 변경 내용을 추적할 수 있습니다. PySpark 또는 SparkR을 선택하면 기본 정의 파일 및 참조 파일이 커밋의 일부로 포함됩니다. 이러한 파일 내의 원본 코드 변경 내용도 추적됩니다.

Important

이 기능은 미리 보기로 제공됩니다.

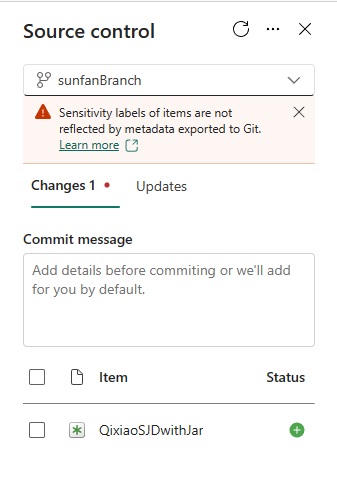

연결 설정

작업 영역 설정에서 리포지토리에 대한 연결을 쉽게 설정하여 변경 내용을 커밋하고 동기화할 수 있습니다. 연결을 설정하려면 Git 통합 시작 문서를 참조하세요. 연결되면 Spark 작업 정의와 같은 항목이 원본 제어 창에 표시됩니다.

Spark 작업 정의를 Git 리포지토리에 커밋하면 작업 정의 폴더 구조가 리포지토리에 나타납니다.

Git의 Spark 작업 정의 표현

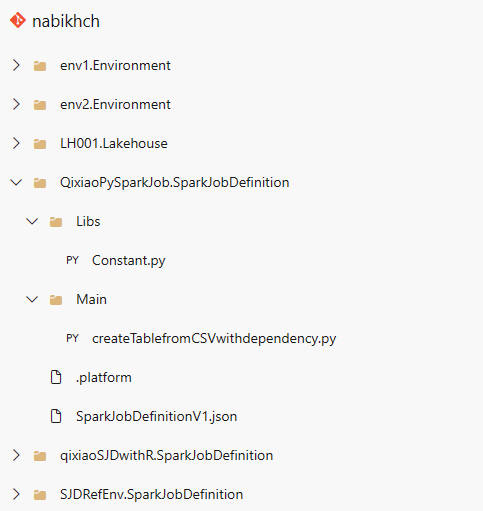

다음 이미지는 리포지토리에 있는 각 Spark 작업 정의 항목의 파일 구조 예제입니다.

Spark 작업 정의 항목을 리포지토리에 커밋하면 각 항목에 대해 git 폴더가 만들어지고 <항목 이름> + "SparkJobDefinition"이라는 스키마에 따라 이름이 지정됩니다. 작업 영역에서 항목을 추적하는 데 사용되므로 폴더의 이름을 바꾸지 마세요. 예를 들어 항목 이름이 "sjd1"인 경우 git 폴더 이름은 "sjd1SparkJobDefinition"입니다.

git 폴더 내에는 두 개의 하위 폴더가 있습니다. 기본 및 참조입니다. 기본 폴더에는 기본 정의 파일이 포함되고 참조 폴더에는 참조 파일이 포함됩니다.

기본 및 참조 파일 외에도 SparkJobDefinitionV1.json 파일도 있습니다. Spark 작업 정의 항목에 대한 메타데이터를 보유하므로 수정하지 마세요. .platform 파일에는 Git 설치>와 관련된 플랫폼 정보도 포함되어 있으므로 수정하면 안 됩니다.

참고 항목

- Java 또는 Scala를 언어로 선택하는 경우 기본 및 참조 파일은 .jar 파일로 업로드할 때 커밋되지 않습니다.

- 연결된 환경은 리포지토리에서 Fabric 작업 영역으로 동기화한 후 Spark 작업 정의에 유지됩니다. 현재 작업 영역 간 참조 환경은 지원되지 않습니다. 새 환경에 수동으로 연결하거나 작업 영역 기본 설정을 사용하여 작업 정의를 실행해야 합니다.

- Spark 작업 정의는 리포지토리에서 Fabric 작업 영역으로 동기화할 때 기본 Lakehouse ID를 유지합니다. 기본 Lakehouse를 사용하여 Notebook을 커밋하는 경우 새로 만든 Lakehouse 항목을 수동으로 참조해야 합니다. 자세한 내용은 Lakehouse Git 통합을 참조하세요.