이벤트 스트림에서 이벤트 소스를 추가 및 관리

이벤트 스트림을 만든 후에는 다양한 데이터 원본 및 대상에 연결할 수 있습니다.

참고 항목

향상된 기능은 지금 eventstream을 만들 때 기본적으로 사용하도록 설정됩니다. 표준 기능을 사용하여 만든 이벤트 스트림이 있는 경우 해당 이벤트 스트림은 계속 작동합니다. 평소처럼 편집하고 사용할 수 있습니다. 향상된 이벤트 스트림의 추가 기능과 이점을 활용할 수 있도록 표준 eventstream을 대체하는 새 Eventstream을 만드는 것이 좋습니다.

이벤트 스트림을 만든 후에는 다양한 데이터 원본 및 대상에 연결할 수 있습니다.

Eventstream을 사용하면 Microsoft 원본에서 데이터를 스트리밍할 수 있을 뿐만 아니라 새로운 메시징 커넥터를 통해 Google Cloud 및 Amazon Kinesis와 같은 타사 플랫폼의 수집도 지원할 수 있습니다. 이 확장 기능은 외부 데이터 스트림을 Fabric에 원활하게 통합하여 유연성을 높이고 여러 원본에서 실시간 인사이트를 얻을 수 있도록 합니다.

이 문서에서는 eventstream에 추가할 수 있는 이벤트 원본에 대해 알아봅니다.

필수 조건

- 패브릭 용량 라이선스 모드(또는 참가자 이상의 권한이 있는 평가판 라이선스 모드)의 작업 영역에 액세스합니다.

- 각 원본에 관한 필수 구성 요소는 다음 원본별 문서에 설명되어 있습니다.

지원되는 원본

향상된 기능이 있는 Fabric 이벤트 스트림은 다음 원본을 지원합니다. 각 문서에서는 특정 원본을 추가하기 위한 세부 정보 및 지침을 제공합니다.

| 원본 | 설명 |

|---|---|

| Azure Event Hubs | Azure 이벤트 허브를 가지고 계신 경우에 이벤트 스트림을 사용하셔서 이벤트 허브 데이터를 Microsoft Fabric에서 수집해 보실 수 있습니다. |

| Azure IoT Hub | Azure IoT Hub가 있는 경우 Eventstream을 사용하여 IoT 데이터를 Microsoft Fabric에 수집할 수 있습니다. |

| Azure SQL 데이터베이스 CDC(변경 데이터 캡처) | Azure SQL Database CDC 원본 커넥터를 사용하면 Azure SQL 데이터베이스에서 현재 데이터의 스냅샷을 캡처할 수 있습니다. 그런 다음, 커넥터는 이 데이터에 대한 향후 행 수준 변경 내용을 모니터링하고 기록합니다. |

| PostgreSQL 데이터베이스 CDC | PostgreSQL 데이터베이스 CDC(변경 데이터 캡처) 원본 커넥터를 사용하면 PostgreSQL 데이터베이스에서 현재 데이터의 스냅샷을 캡처할 수 있습니다. 그런 다음, 커넥터는 이 데이터에 대한 향후 행 수준 변경 내용을 모니터링하고 기록합니다. |

| MySQL Database CDC | Azure MySQL CDC(변경 데이터 캡처) 원본 커넥터를 사용하면 Azure Database for MySQL 데이터베이스에서 현재 데이터의 스냅샷을 캡처할 수 있습니다. 모니터링할 테이블을 지정할 수 있으며, Eventstream은 테이블에 대한 향후 행 수준 변경 내용을 기록합니다. |

| Azure Cosmos DB CDC | Microsoft Fabric Eventstream용 Azure Cosmos DB CDC(변경 데이터 캡처) 원본 커넥터를 사용하면 Azure Cosmos DB 데이터베이스에서 현재 데이터의 스냅샷을 캡처할 수 있습니다. 그런 다음, 커넥터는 이 데이터에 대한 향후 행 수준 변경 내용을 모니터링하고 기록합니다. |

| VM(가상 머신) 데이터베이스(DB) CDC의 SQL Server | 패브릭 이벤트 스트림에 대한 SQL Server on VM DB(CDC) 원본 커넥터를 사용하면 VM의 SQL Server 데이터베이스에 있는 현재 데이터의 스냅샷을 캡처할 수 있습니다. 그런 다음 커넥터는 데이터에 대한 향후 행 수준 변경 내용을 모니터링하고 기록합니다. |

| Azure SQL Managed Instance CDC | Microsoft Fabric 이벤트 스트림에 대한 Azure SQL Managed Instance CDC 원본 커넥터를 사용하면 SQL Managed Instance 데이터베이스에서 현재 데이터의 스냅샷을 캡처할 수 있습니다. 그런 다음, 커넥터는 이 데이터에 대한 향후 행 수준 변경 내용을 모니터링하고 기록합니다. |

| Google Cloud Pub/Sub | Google Pub/Sub는 Eventstream을 게시하고 구독할 수 있는 메시징 서비스입니다. Google Pub/Sub를 Eventstream에 원본으로 추가하여 실시간 이벤트를 캡처 및 변환하고 Fabric의 다양한 목적지로 라우팅할 수 있습니다. |

| Amazon Kinesis Data Streams | Amazon Kinesis Data Streams는 스트리밍 데이터에 최적화된 확장성과 내구성이 뛰어난 데이터 수집 및 처리 서비스입니다. Amazon Kinesis Data Streams를 Eventstream 내 원본으로 통합하면 실시간 데이터 스트림을 원활하게 처리한 후 Fabric 내 여러 목적지로 라우팅할 수 있습니다. |

| Confluent Cloud Kafka | Confluent Cloud Kafka는 Apache Kafka를 사용하여 강력한 데이터 스트리밍 및 처리 기능을 제공하는 스트리밍 플랫폼입니다. Confluent Cloud Kafka를 Eventstream 내의 원본으로 통합하면 실시간 데이터 스트림을 원활하게 처리한 후 Fabric 내의 여러 대상으로 라우팅할 수 있습니다. |

| Amazon MSK Kafka | Amazon MSK Kafka는 설정, 크기 조정 및 관리를 간소화하는 완전히 관리되는 Kafka 서비스입니다. Amazon MSK Kafka를 이벤트 스트림 내의 원본으로 통합하면 MSK Kafka에서 실시간 이벤트를 원활하게 가져와서 처리한 후 패브릭 내의 여러 대상으로 라우팅할 수 있습니다. |

| 샘플 데이터 | Eventstream을 설정하는 동안 데이터 수집을 테스트하기 위해 Bicycles, Yellow Taxi 또는 Stock Market events를 샘플 데이터 원본으로 선택할 수 있습니다. |

| 사용자 지정 엔드포인트(즉, 표준 기능의 사용자 지정 앱) | 사용자 지정 엔드포인트 기능을 사용하면 애플리케이션 또는 Kafka 클라이언트가 연결 문자열 사용하여 Eventstream에 연결할 수 있으므로 스트리밍 데이터를 Eventstream으로 원활하게 수집할 수 있습니다. |

| Azure Service Bus(미리 보기) | Eventstream을 사용하여 Azure Service Bus 큐 또는 토픽의 구독에서 Microsoft Fabric으로 데이터를 수집할 수 있습니다. |

| Apache Kafka(미리 보기) | Apache Kafka는 확장 가능한 실시간 데이터 시스템을 빌드하기 위한 오픈 소스 분산 플랫폼입니다. Apache Kafka를 이벤트 스트림 내의 원본으로 통합하면 Apache Kafka에서 실시간 이벤트를 원활하게 가져와서 패브릭 내의 여러 대상으로 라우팅하기 전에 처리할 수 있습니다. |

| Azure Blob Storage 이벤트(미리 보기) | Azure Blob Storage 이벤트는 클라이언트가 Blob을 만들거나 바꾸거나 삭제할 때 실행됩니다. 커넥터를 사용하면 Blob Storage 이벤트와 실시간 허브의 Fabric 이벤트를 연결할 수 있습니다. 이러한 이벤트를 연속 데이터 스트림으로 변환하고 Fabric의 다양한 대상으로 라우팅하기 전에 변환할 수 있습니다. |

| Fabric 작업 영역 항목 이벤트(미리 보기) | Fabric 작업 영역 항목 이벤트는 Fabric 작업 영역이 변경될 때 발생하는 불연속 Fabric 이벤트입니다. 이러한 변경 내용에는 Fabric 항목 만들기, 업데이트 또는 삭제가 포함되었습니다. Fabric Eventstream을 사용하면 추가 분석을 위해 이러한 Fabric 작업 영역 이벤트를 캡처하고, 변환하며, Fabric의 다양한 목적지로 라우팅할 수 있습니다. |

| Fabric OneLake 이벤트(미리 보기) | OneLake 이벤트를 사용하면 OneLake에서 파일 및 폴더의 변경 내용을 구독한 다음 이러한 변경 내용에 실시간으로 대응할 수 있습니다. 패브릭 이벤트 스트림을 사용하면 이러한 OneLake 이벤트를 캡처하고, 변환하고, 패브릭의 다양한 대상으로 라우팅하여 추가 분석을 수행할 수 있습니다. 패브릭 이벤트 스트림 내에서 OneLake 이벤트를 원활하게 통합하면 OneLake에서 활동을 모니터링하고 분석할 수 있는 유연성이 향상됩니다. |

| Fabric 작업 이벤트(미리 보기) | ob 이벤트를 사용하면 Fabric에서 작업을 실행할 때 생성된 변경 내용을 구독할 수 있습니다. 예를 들어 의미 체계 모델을 새로 고치거나, 예약된 파이프라인을 실행하거나, Notebook을 실행할 때 변경 내용에 대응할 수 있습니다. 이러한 각 활동은 해당 작업을 생성할 수 있으며, 그러면 해당 작업 이벤트 집합이 생성됩니다. Fabric 이벤트 스트림을 사용하면 이러한 작업 이벤트를 캡처하고, 변환하고, 패브릭의 다양한 대상으로 라우팅하여 추가 분석을 수행할 수 있습니다. 패브릭 이벤트 스트림 내에서 작업 이벤트를 원활하게 통합하면 작업에서 활동을 모니터링하고 분석할 수 있는 유연성이 향상됩니다. |

참고 항목

하나의 이벤트 스트림에 대한 최대 원본 및 대상 수는 11개입니다.

관련 콘텐츠

필수 조건

시작하기 전에 다음 전제 조건을 완료해야 합니다.

- 패브릭 용량 라이선스 모드(또는 참가자 이상의 권한이 있는 평가판 라이선스 모드)의 작업 영역에 액세스합니다.

- Azure 이벤트 허브 혹은 Azure IoT 허브를 이벤트 스트림 소스으로 추가하기 위해서는 해당 정책 키에 액세스하실 수 있는 적절한 권한을 가지고 계셔야 합니다. 방화벽 뒤에 있거나 가상 네트워크에서 보호해 주지 않으며 공개적으로 액세스를 해주셔야 합니다.

지원되는 원본

패브릭 이벤트 스트림은 다음 원본을 지원합니다. 테이블의 링크를 사용하셔서 특정 소스 추가를 위한 자세한 정보를 제공해 드리는 문서로 이동해 보세요.

| 원본 | 설명 |

|---|---|

| Azure Event Hubs | Azure 이벤트 허브를 가지고 계신 경우에 이벤트 스트림을 사용하셔서 이벤트 허브 데이터를 Microsoft Fabric에서 수집해 보실 수 있습니다. |

| Azure IoT Hub | Azure IoT Hub가 있는 경우 Eventstream을 사용하여 IoT 데이터를 Microsoft Fabric에 수집할 수 있습니다. |

| 샘플 데이터 | Eventstream을 설정하는 동안 데이터 수집을 테스트하기 위해 Bicycles, Yellow Taxi 또는 Stock Market events를 샘플 데이터 원본으로 선택할 수 있습니다. |

| 사용자 지정 앱 | 사용자 지정 앱 기능을 사용하시게 되면 앱 혹은 Kafka 클라이언트가 연결 문자열 사용하셔서 이벤트 스트림에 연결하실 수 있기 때문에 스트리밍 데이터를 이벤트 스트림에서 원활하게 수집하실 수 있는 것입니다. |

참고 항목

하나의 이벤트 스트림에 대한 최대 원본 및 대상 수는 11개입니다.

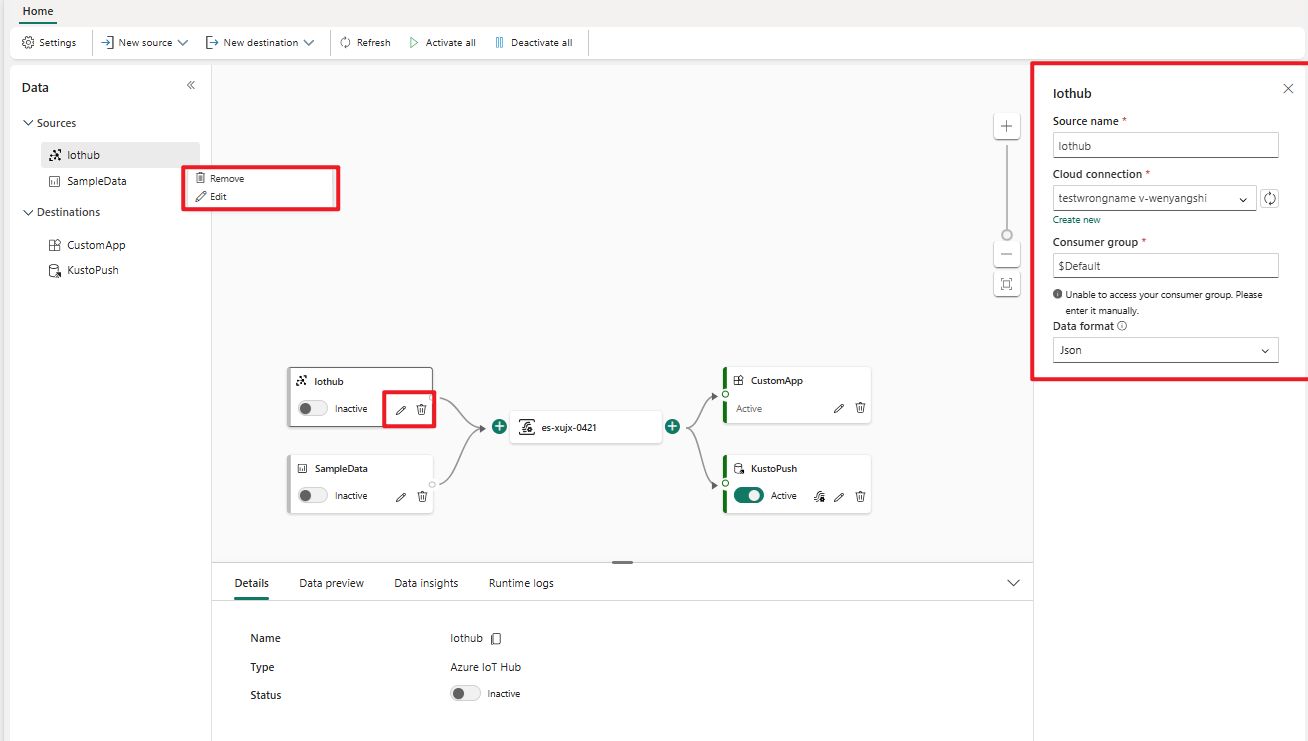

원본 관리

편집/제거: 탐색 창 혹은 캔버스를 통해서 편집하시나 제거하실 이벤트 스트림 소스를 선택하실 수 있습니다. 편집을 선택하시게 되면 기본 편집기 오른쪽에서 편집 창이 열리게 되는 것입니다.

사용자 지정 앱을 위한 키를 다시 생성하기: 앱에 대한 새로운 연결 키를 다시 생성하고 싶으신 경우에 캔버스에서 사용자 지정 앱 소스 중에서 하나를 선택해 주시고 다시 생성 을 선택하셔서 새 로운 연결 키를 가져와 주세요.