Opcje pobierania danych do usługi Fabric Lakehouse

Środowisko pobierania danych obejmuje wszystkie scenariusze użytkownika dotyczące uwzględnienia danych w usłudze Lakehouse, takich jak:

- Nawiązywanie połączenia z istniejącym programem SQL Server i kopiowanie danych do tabeli delty w usłudze Lakehouse.

- Przekazywanie plików z komputera.

- Kopiowanie i scalanie wielu tabel z innych magazynów lakehouse do nowej tabeli delty.

- Nawiązywanie połączenia ze źródłem przesyłania strumieniowego z danymi lądu w lakehouse.

- Odwoływanie się do danych bez kopiowania ich z innych wewnętrznych źródeł typu lakehouse lub źródeł zewnętrznych.

Różne sposoby ładowania danych do magazynu lakehouse

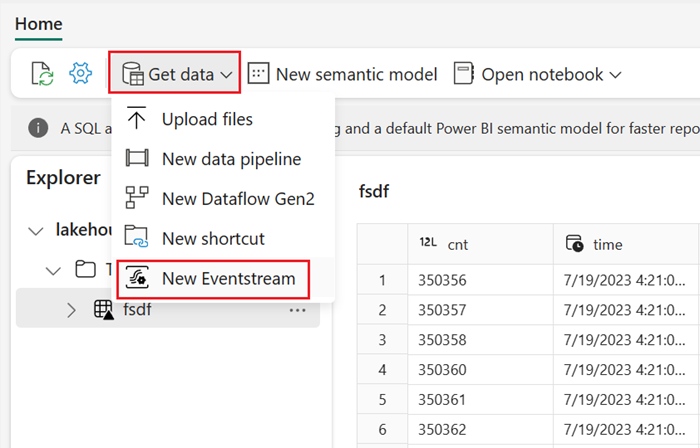

W usłudze Microsoft Fabric istnieje kilka sposobów pobierania danych do magazynu lakehouse:

- Przekazywanie pliku z komputera lokalnego

- Uruchamianie narzędzia do kopiowania w potokach

- Konfigurowanie przepływu danych

- Biblioteki platformy Apache Spark w kodzie notesu

- Przesyłanie strumieniowe zdarzeń w czasie rzeczywistym za pomocą strumienia zdarzeń

- Pobieranie danych z usługi Eventhouse

Przekazywanie pliku lokalnego

Możesz również przekazać dane przechowywane na komputerze lokalnym. Można to zrobić bezpośrednio w eksploratorze Lakehouse.

Narzędzie do kopiowania w potokach

Narzędzie do kopiowania to wysoce skalowalne rozwiązanie Integracja danych, które umożliwia łączenie się z różnymi źródłami danych i ładowanie danych w oryginalnym formacie lub konwertowanie ich na tabelę delty. Narzędzie do kopiowania jest częścią działań potoków, które można modyfikować na wiele sposobów, takich jak planowanie lub wyzwalanie na podstawie zdarzenia. Aby uzyskać więcej informacji, zobacz Jak kopiować dane przy użyciu działania kopiowania.

Przepływy danych

W przypadku użytkowników, którzy znają przepływy danych usługi Power BI, to samo narzędzie jest dostępne do ładowania danych do usługi LakeHouse. Możesz szybko uzyskać do niego dostęp z poziomu opcji "Pobierz dane" eksploratora usługi Lakehouse i załadować dane z ponad 200 łączników. Aby uzyskać więcej informacji, zobacz Szybki start: tworzenie pierwszego przepływu danych w celu pobierania i przekształcania danych.

Kod notesu

Dostępne biblioteki platformy Spark umożliwiają bezpośrednie łączenie ze źródłem danych, ładowanie danych do ramki danych, a następnie zapisywanie ich w usłudze Lakehouse. Ta metoda jest najbardziej otwartym sposobem ładowania danych w usłudze Lakehouse, którą kod użytkownika w pełni zarządza.

Uwaga

Zewnętrzne tabele delty utworzone przy użyciu kodu platformy Spark nie będą widoczne dla punktu końcowego analizy SQL. Użyj skrótów w obszarze Tabela, aby zewnętrzne tabele delty widoczne dla punktu końcowego analizy SQL.

Przesyłanie strumieniowe zdarzeń w czasie rzeczywistym za pomocą strumienia zdarzeń

Za pomocą strumienia zdarzeń można pobierać, przetwarzać i kierować duże ilości zdarzeń w czasie rzeczywistym z wielu różnych źródeł.

Aby dowiedzieć się, jak dodać usługę Lakehouse jako miejsce docelowe dla usługi Eventstream, zobacz Pobieranie danych z usługi Eventstream w usłudze Lakehouse.

Aby uzyskać optymalną wydajność przesyłania strumieniowego, można przesyłać strumieniowo dane z strumienia zdarzeń do usługi Eventhouse, a następnie włączyć dostępność usługi OneLake.

Pobieranie danych z usługi Eventhouse

Po włączeniu dostępności usługi OneLake dla danych w usłudze Eventhouse w usłudze Eventhouse zostanie utworzona tabela delty w usłudze OneLake. Dostęp do tej tabeli delty można uzyskać za pomocą skrótu. Aby uzyskać więcej informacji, zobacz OneLake shortcuts (Skróty onelake). Aby uzyskać więcej informacji, zobacz Eventhouse OneLake Availability (Dostępność usługi OneLake w usłudze Eventhouse).

Zagadnienia dotyczące wybierania podejścia do ładowania danych

| Przypadek użycia | Zalecenie |

|---|---|

| Przekazywanie małych plików z komputera lokalnego | Użyj lokalnego przekazywania plików |

| Małe dane lub konkretny łącznik | Korzystanie z przepływów danych |

| Duże źródło danych | Korzystanie z narzędzia do kopiowania w potokach |

| Złożone przekształcenia danych | Korzystanie z kodu notesu |

| Dane przesyłane strumieniowo | Przesyłanie strumieniowe zdarzeń do usługi Eventhouse za pomocą strumienia danych; włączanie dostępności usługi OneLake i tworzenie skrótu z usługi Lakehouse |

| Dane szeregów czasowych | Pobieranie danych z usługi Eventhouse |

Powiązana zawartość

- Eksplorowanie danych w usłudze Lakehouse za pomocą notesu

- Szybki start: tworzenie pierwszego potoku w celu skopiowania danych

- Jak kopiować dane przy użyciu działania kopiowania

- Przenoszenie danych z usługi Azure SQL DB do usługi Lakehouse za pośrednictwem asystenta kopiowania

- Dodawanie miejsca docelowego lakehouse do strumienia zdarzeń

- Dostępność usługi Eventhouse OneLake