Implantar um modelo de fala personalizada

Neste artigo, você aprenderá a implantar um ponto de extremidade para um modelo de fala personalizada. Com exceção da transcrição em lote, você deve implantar um ponto de extremidade personalizado para usar um modelo de fala personalizada.

Dica

Um ponto de extremidade de implantação hospedado não é necessário para usar a fala personalizada com a API de transcrição em lote. Você poderá conservar recursos se o modelo de fala personalizado só for usado para transcrição em lote. Para obter mais informações, confira Preços do serviço de Fala.

Você pode implantar um ponto de extremidade para um modelo base ou personalizado e, em seguida, atualizar o ponto de extremidade depois para usar um modelo melhor treinado.

Observação

Os pontos de extremidade usados pelos recursos de Fala F0 são excluídos após sete dias.

Adicionar um ponto de extremidade de implantação

Para criar um ponto de extremidade personalizado, siga estas etapas:

Entre no Speech Studio.

Selecione Fala personalizada> Nome do seu projeto >Implantar modelos.

Se este for seu primeiro ponto de extremidade, você observará que não há nenhum ponto de extremidade listado na tabela. Depois de criar um ponto de extremidade, use essa página para acompanhar cada ponto de extremidade implantado.

Selecione Implantar modelo para iniciar o novo assistente de ponto de extremidade.

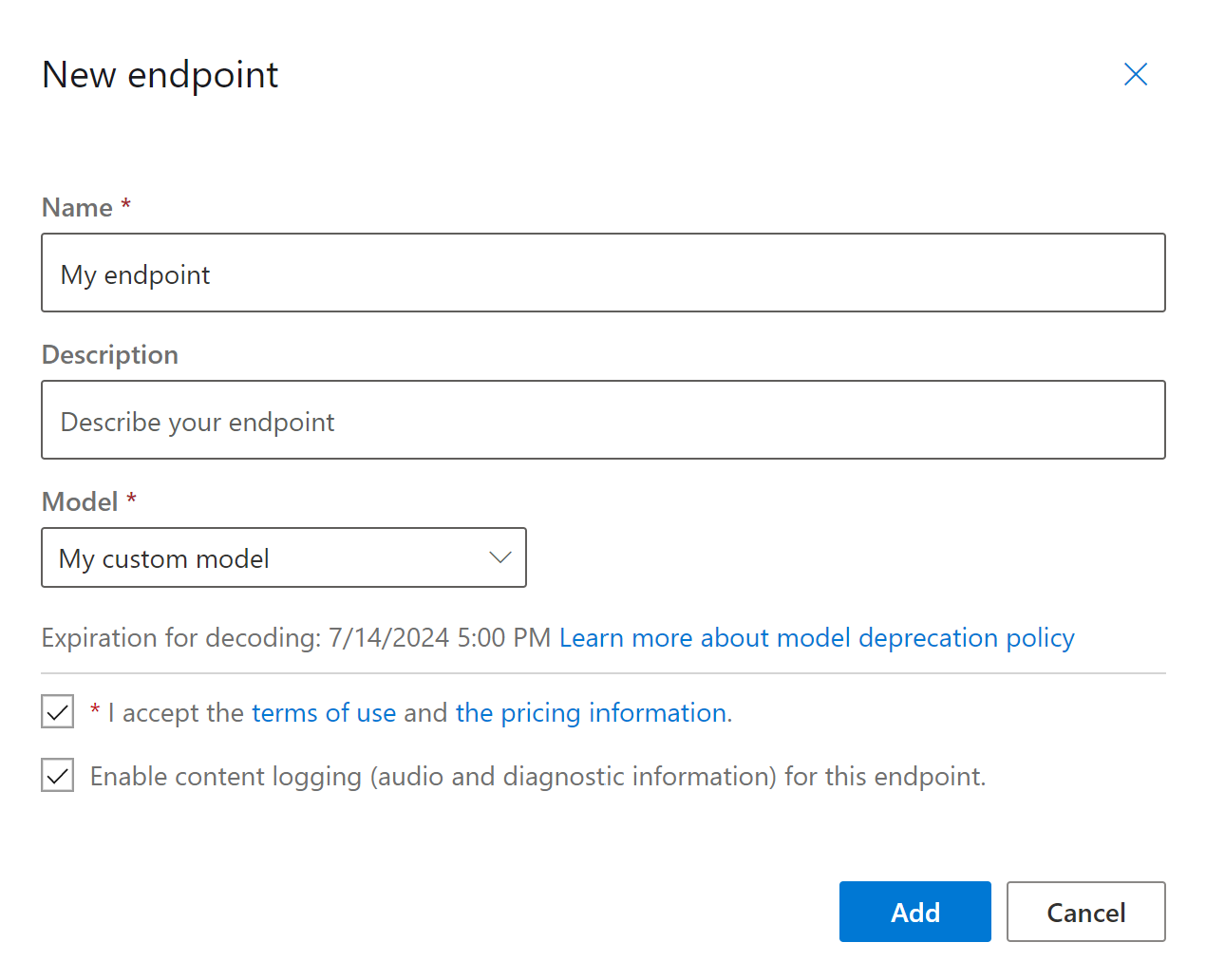

Na página Novo ponto de extremidade, insira um nome e uma descrição para o ponto de extremidade personalizado.

Selecione o modelo personalizado que você deseja associar ao ponto de extremidade.

Opcionalmente, você pode marcar a caixa para habilitar o log de áudio e diagnóstico do tráfego do ponto de extremidade.

Selecione Adicionar para salvar e implantar o ponto de extremidade.

Na página principal Implantar modelos, os detalhes sobre o novo ponto de extremidade são exibidos em uma tabela, como nome, descrição, status e data de validade. Pode levar até 30 minutos para criar uma instância de um novo ponto de extremidade usando seus modelos personalizados. Quando o status da implantação for alterado para Êxito, o ponto de extremidade estará pronto para uso.

Importante

Anote a data de validade do modelo. Esta é a última data em que você pode usar seu modelo personalizado para reconhecimento de fala. Para saber mais, confira Ciclo de vida do modelo e do ponto de extremidade.

Selecione no link para exibir informações específicas do seu ponto de extremidade, como a chave do ponto de extremidade, a URL do ponto de extremidade e o código de exemplo.

Para criar um ponto de extremidade e implantar um modelo, use o comando spx csr endpoint create. Construa os parâmetros de solicitação de acordo com as seguintes instruções:

- Defina o parâmetro

projectcomo a ID de um projeto existente. Isso é recomendado para que você também possa exibir e gerenciar o ponto de extremidade no Speech Studio. Você pode executar o comandospx csr project listpara obter projetos disponíveis. - Defina o parâmetro

modelnecessário para a ID do modelo que você deseja implantar no ponto de extremidade. - Defina o parâmetro

languagenecessário. A localidade do ponto de extremidade deve corresponder à localidade do modelo. O localidade não poderá ser alterada posteriormente. O parâmetrolanguageda CLI de Fala corresponde à propriedadelocalena solicitação e resposta JSON. - Defina o parâmetro

namenecessário. É o nome que é exibido no Speech Studio. O parâmetronameda CLI de Fala corresponde à propriedadedisplayNamena solicitação e resposta JSON. - Opcionalmente, você pode definir o parâmetro

logging. Defina isso paraenableda fim de habilitar o log de áudio e diagnóstico do tráfego do ponto de extremidade. O padrão éfalse.

Confira um exemplo de comando da CLI de Fala para criar um ponto de extremidade e implantar um modelo:

spx csr endpoint create --api-version v3.2 --project YourProjectId --model YourModelId --name "My Endpoint" --description "My Endpoint Description" --language "en-US"

Você deve receber um corpo de resposta no seguinte formato:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:29:36Z",

"status": "NotStarted",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

A propriedade self de nível superior no corpo da resposta é o URI do ponto de extremidade. Use esse URI para obter detalhes sobre o projeto, o modelo e os logs do ponto de extremidade. Você também usa esse URI para atualizar o ponto de extremidade.

Para obter a ajuda da CLI de Fala com pontos de extremidade, execute o seguinte comando:

spx help csr endpoint

Para criar um ponto de extremidade e implantar um modelo, use a operação Endpoints_Create da API REST de Conversão de fala em texto. Crie o corpo da solicitação de acordo com as seguintes instruções:

- Defina a propriedade

projectcomo o URI de um projeto existente. Isso é recomendado para que você também possa exibir e gerenciar o ponto de extremidade no Speech Studio. É possível fazer uma solicitação Projects_List para obter os projetos disponíveis. - Defina a propriedade

modelnecessária para o URI do modelo que você deseja implantar no ponto de extremidade. - Defina a propriedade

localenecessária. A localidade do ponto de extremidade deve corresponder à localidade do modelo. O localidade não poderá ser alterada posteriormente. - Defina a propriedade

displayNameobrigatória. É o nome que é exibido no Speech Studio. - Opcionalmente, você pode definir a propriedade

loggingEnabledemproperties. Defina isso paratruea fim de habilitar o log de áudio e diagnóstico do tráfego do ponto de extremidade. O padrão éfalse.

Faça uma solicitação HTTP POST usando o URI, conforme mostrado no exemplo Endpoints_Create a seguir. Substitua YourSubscriptionKey pela chave de recurso de Fala, YourServiceRegion pela região do recurso de Fala e defina as propriedades do corpo da solicitação, conforme descrito anteriormente.

curl -v -X POST -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"displayName": "My Endpoint",

"description": "My Endpoint Description",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/base/ae8d1643-53e4-4554-be4c-221dcfb471c5"

},

"locale": "en-US",

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints"

Você deve receber um corpo de resposta no seguinte formato:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:29:36Z",

"status": "NotStarted",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

A propriedade self de nível superior no corpo da resposta é o URI do ponto de extremidade. Use esse URI para obter detalhes sobre o projeto, o modelo e os logs do ponto de extremidade. Você também usa esse URI para atualizar ou excluir o ponto de extremidade.

Alterar o modelo e reimplantar o ponto de extremidade

Um ponto de extremidade pode ser atualizado para usar outro modelo que foi criado pelo mesmo recurso de Fala. Como mencionado anteriormente, você deve atualizar o modelo do ponto de extremidade antes que o modelo expire.

Para usar um novo modelo e reimplantar o ponto de extremidade personalizado:

- Entre no Speech Studio.

- Selecione Fala personalizada> Nome do seu projeto >Implantar modelos.

- Selecione o link para um ponto de extremidade por nome e selecione Alterar modelo.

- Selecione o novo modelo que você quer que o ponto de extremidade use.

- Selecione Concluído para salvar e reimplantar o ponto de extremidade.

Para reimplantar o ponto de extremidade personalizado com um modelo novo, use o comando spx csr model update. Construa os parâmetros de solicitação de acordo com as seguintes instruções:

- Defina o parâmetro

endpointnecessário para a ID do ponto de extremidade que você deseja implantar. - Defina o parâmetro

modelnecessário para a ID do modelo que você deseja implantar no ponto de extremidade.

Confira um exemplo de comando da CLI de Fala que reimplanta o ponto de extremidade personalizado com um modelo novo:

spx csr endpoint update --api-version v3.2 --endpoint YourEndpointId --model YourModelId

Você deve receber um corpo de resposta no seguinte formato:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Para obter a ajuda da CLI de Fala com pontos de extremidade, execute o seguinte comando:

spx help csr endpoint

Para reimplantar o ponto de extremidade personalizado com um novo modelo, use a operação Endpoints_Update da API REST de Conversão de fala em texto. Construa o corpo da solicitação de acordo com as seguintes instruções:

- Defina a propriedade

modelpara o URI do modelo que você deseja implantar no ponto de extremidade.

Faça uma solicitação HTTP PATCH usando o URI, conforme mostrado no exemplo a seguir. Substitua YourSubscriptionKey pela chave de recurso de Fala, substitua YourServiceRegion pela região do recurso de Fala, substitua YourEndpointId pela ID do ponto de extremidade e defina as propriedades do corpo da solicitação, conforme descrito anteriormente.

curl -v -X PATCH -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey" -H "Content-Type: application/json" -d '{

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

}' "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId"

Você deve receber um corpo de resposta no seguinte formato:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

A implantação leva vários minutos para ser concluída. Enquanto isso, o ponto de extremidade usa o modelo anterior sem interrupção do serviço.

Exibir dados de registro em log

Os dados de log estão disponíveis para exportação se você configurá-los durante a criação do ponto de extremidade.

Para baixar os logs de ponto de extremidade:

- Entre no Speech Studio.

- Selecione Discurso personalizado> O nome do seu projeto >Implantar modelos.

- Selecione o link pelo nome do ponto de extremidade.

- Em Log de conteúdo, selecione Baixar log.

Para obter logs de um ponto de extremidade, use o comando spx csr endpoint list. Construa os parâmetros de solicitação de acordo com as seguintes instruções:

- Defina o parâmetro

endpointnecessário para a ID do ponto de extremidade da qual você deseja obter logs.

Aqui está um exemplo de comando da CLI de Fala que obtém logs para um ponto de extremidade:

spx csr endpoint list --api-version v3.2 --endpoint YourEndpointId

Os locais de cada arquivo de log com mais detalhes são retornados no corpo da resposta.

Para obter logs para um ponto de extremidade, comece usando a operação Endpoints_Get da API REST de Conversão de fala em texto.

Faça uma solicitação HTTP GET usando o URI, conforme mostrado no exemplo a seguir. Substitua YourEndpointId por sua ID do ponto de extremidade, substitua YourSubscriptionKey pela sua chave de recurso de Fala e substitua YourServiceRegion pela sua região de recurso de Fala.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Você deve receber um corpo de resposta no seguinte formato:

{

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"model": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/models/9e240dc1-3d2d-4ac9-98ec-1be05ba0e9dd"

},

"links": {

"logs": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/a07164e8-22d1-4eb7-aa31-bf6bb1097f37/files/logs",

"restInteractive": "https://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restConversation": "https://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"restDictation": "https://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketInteractive": "wss://eastus.stt.speech.microsoft.com/speech/recognition/interactive/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketConversation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/conversation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37",

"webSocketDictation": "wss://eastus.stt.speech.microsoft.com/speech/recognition/dictation/cognitiveservices/v1?cid=a07164e8-22d1-4eb7-aa31-bf6bb1097f37"

},

"project": {

"self": "https://eastus.api.cognitive.microsoft.com/speechtotext/v3.2/projects/0198f569-cc11-4099-a0e8-9d55bc3d0c52"

},

"properties": {

"loggingEnabled": true

},

"lastActionDateTime": "2024-07-15T16:30:12Z",

"status": "Succeeded",

"createdDateTime": "2024-07-15T16:29:36Z",

"locale": "en-US",

"displayName": "My Endpoint",

"description": "My Endpoint Description"

}

Faça uma solicitação HTTP GET usando o URI "logs" do corpo da resposta anterior. Substitua YourEndpointId por sua ID do ponto de extremidade, substitua YourSubscriptionKey pela sua chave de recurso de Fala e substitua YourServiceRegion pela sua região de recurso de Fala.

curl -v -X GET "https://YourServiceRegion.api.cognitive.microsoft.com/speechtotext/v3.2/endpoints/YourEndpointId/files/logs" -H "Ocp-Apim-Subscription-Key: YourSubscriptionKey"

Os locais de cada arquivo de log com mais detalhes são retornados no corpo da resposta.

Os dados de registro em log ficam disponíveis no armazenamento de propriedade da Microsoft por 30 dias e, em seguida, são removidos. Se sua própria conta de armazenamento estiver vinculada à assinatura dos serviços de IA do Azure, os dados de registro em log não serão excluídos automaticamente.