Carregar dados no Azure Data Lake Storage Gen2 com o Azure Data Factory

APLICA-SE A: Azure Data Factory

Azure Data Factory  Azure Synapse Analytics

Azure Synapse Analytics

Dica

Experimente o Data Factory no Microsoft Fabric, uma solução de análise tudo-em-um para empresas. O Microsoft Fabric abrange desde movimentação de dados até ciência de dados, análise em tempo real, business intelligence e relatórios. Saiba como iniciar uma avaliação gratuita!

O Azure Data Lake Storage Gen2 é um conjunto de recursos dedicados à análise de Big Data, criado no armazenamento de Blobs do Azure. Ele permite que você faça interface com seus dados usando os paradigmas de sistema de arquivos e armazenamento de objetos.

O Azure Data Factory (ADF) é um serviço de integração de dados baseado em nuvem completamente gerenciado. É possível usar o serviço para preencher o Data Lake com dados de um conjunto avançado de armazenamentos de dados locais e baseados em nuvem e economizar tempo ao compilar as soluções de análise. Para obter uma lista detalhada de conectores com suporte, consulte a tabela de Suporte para repositórios de dados.

O Azure Data Factory oferece uma solução de movimentação de dados gerenciados de expansão. Devido à arquitetura de expansão do ADF, é possível ingerir dados com alta taxa de transferência. Para obter detalhes, consulte Desempenho da atividade de cópia.

Este artigo descreve como usar a ferramenta Copiar Dados do Data Factory para carregar dados do serviço Amazon Web Services S3 no Azure Data Lake Store Gen2. Você pode seguir as etapas semelhantes para copiar dados de outros tipos de armazenamentos de dados.

Dica

Para copiar dados do Azure Data Lake Storage Gen1 para o Gen2, consulte este passo a passo específico.

Pré-requisitos

- Assinatura do Azure: Se você não tiver uma assinatura do Azure, crie uma conta gratuita antes de começar.

- Conta de Armazenamento do Microsoft Azure com Data Lake Store Gen2 habilitada: se você não tiver uma conta de Armazenamento, crie uma.

- Conta de AWS com um bucket S3 que contém dados: este artigo mostra como copiar dados do Amazon S3. Você pode usar outros repositórios de dados seguindo as etapas semelhantes.

Criar uma data factory

Se você ainda não criou o data factory, siga as etapas no Início Rápido: crie um data factory usando o portal do Azure e o Estúdio do Azure Data Factory para criar um. Depois de criá-lo, navegue até o data factory no portal do Azure.

Selecione Abrir no bloco Abrir Estúdio do Azure Data Factory para iniciar o aplicativo Data Integration em uma guia separada.

Carregar dados no Azure Data Lake Store Gen2

Na página inicial do ADF (Azure Data Factory), selecione o bloco Ingerir para a inicialização da ferramenta Copiar Dados.

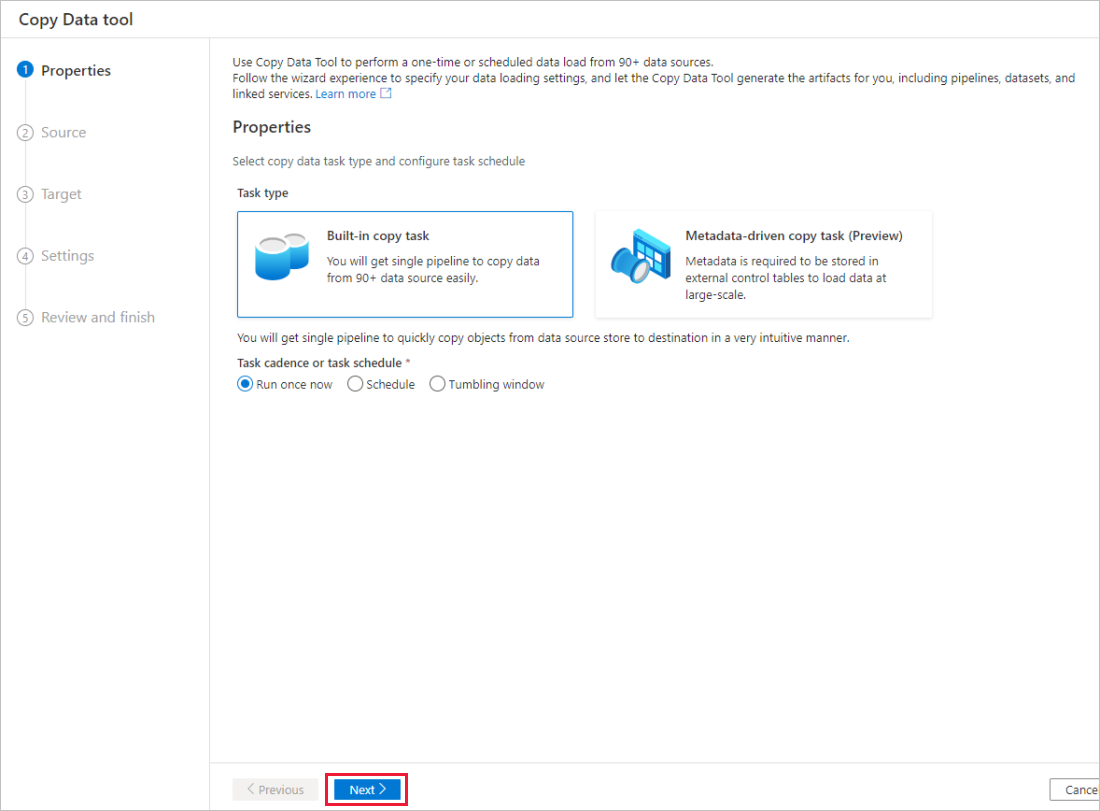

Na página Propriedades, escolha Tarefa de cópia interna em Tipo de tarefa e selecione Executar uma vez agora em Cadência ou agendamento da tarefa e selecione Avançar.

Na página Armazenamento de dados de origem, conclua as etapas a seguir:

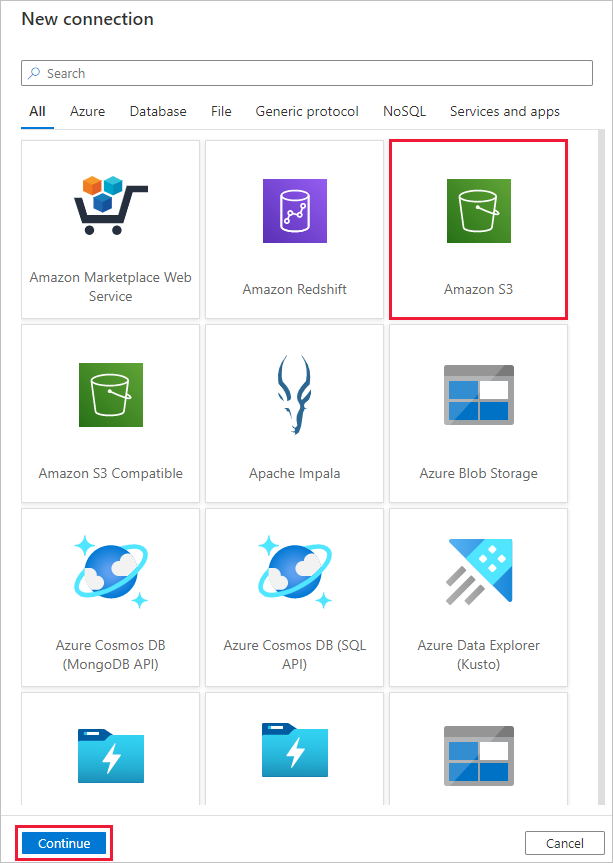

Selecione +Nova conexão. Selecione Amazon S3 na galeria de conectores e, em seguida, Continuar.

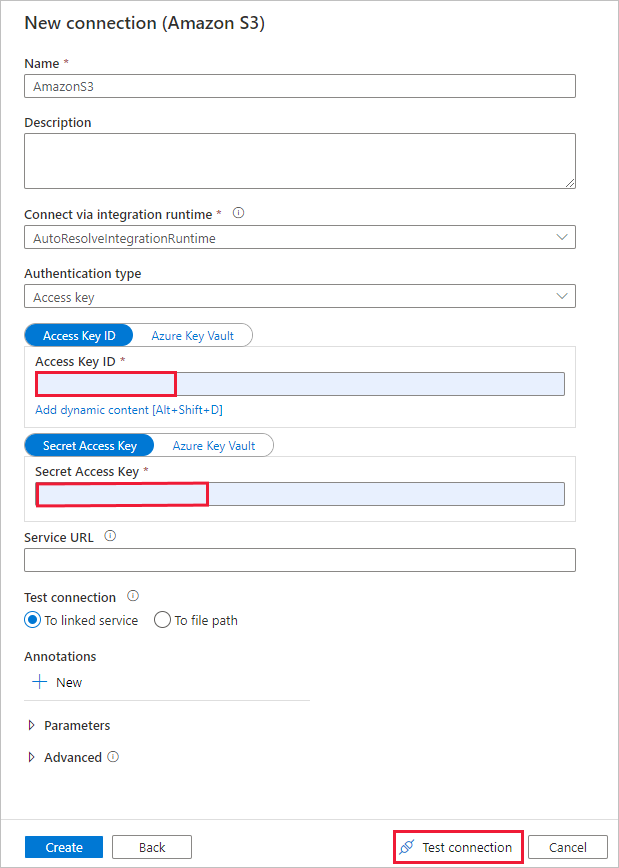

Na página Nova conexão (Amazon S3) , execute estas etapas:

- Especifique o valor da ID da chave de acesso.

- Especifique o valor da chave de acesso secreta.

- Clique em Testar conectividade para validar as configurações e selecione Criar.

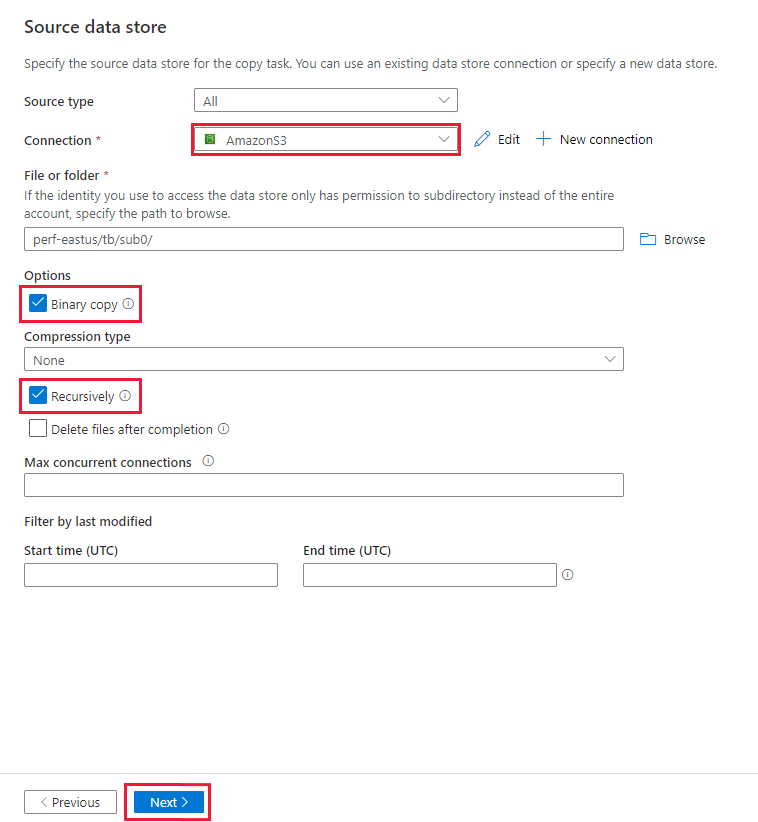

Na página Armazenamento de dados de origem, garanta que a conexão recém-criada do Amazon S3 seja selecionada no bloco Conexão.

Na seção Pasta ou arquivo, navegue até a pasta e o arquivo que receberá a cópia. Selecione o arquivo/pasta e OK.

Especifique o comportamento da cópia marcando as opções Recursivamente e Cópia binária. Selecione Avançar.

Na página Armazenamento de dados de destino, conclua as etapas a seguir.

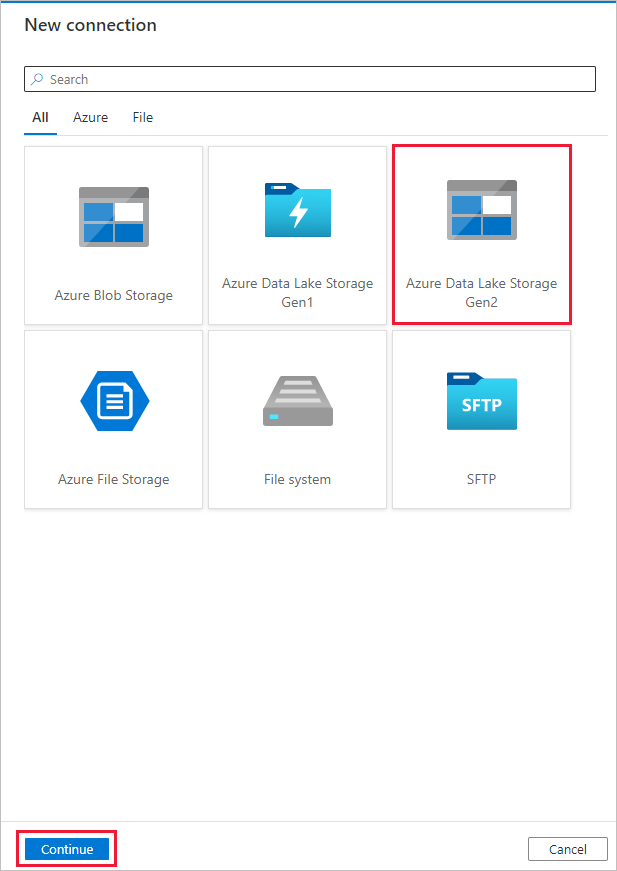

Selecione + Nova conexão, e selecione Azure Data Lake Storage Gen2 e Continuar.

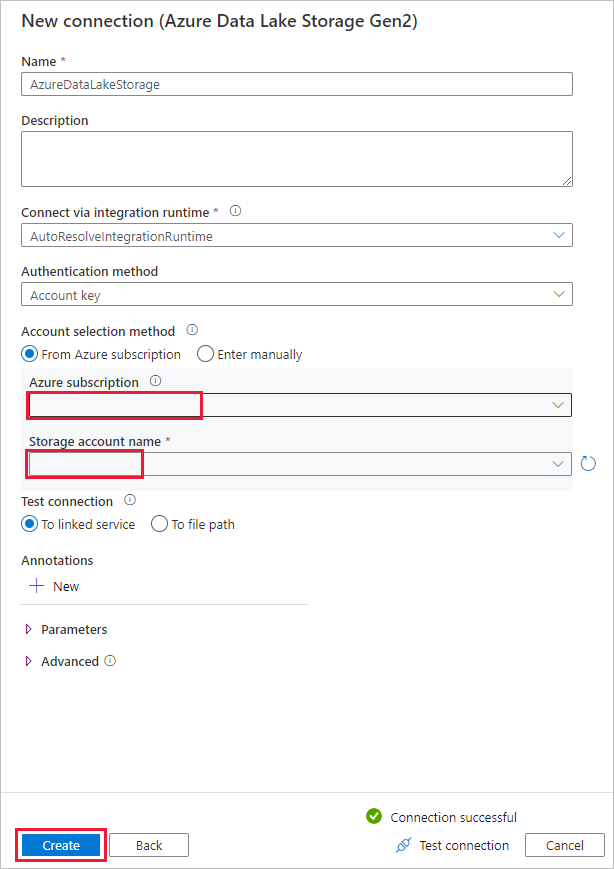

Na página Nova conexão (Azure Data Lake Storage Gen2) , selecione sua conta capaz Data Lake Storage Gen2 da lista suspensa "Nome da conta de armazenamento" e selecione Criar para criar a conexão.

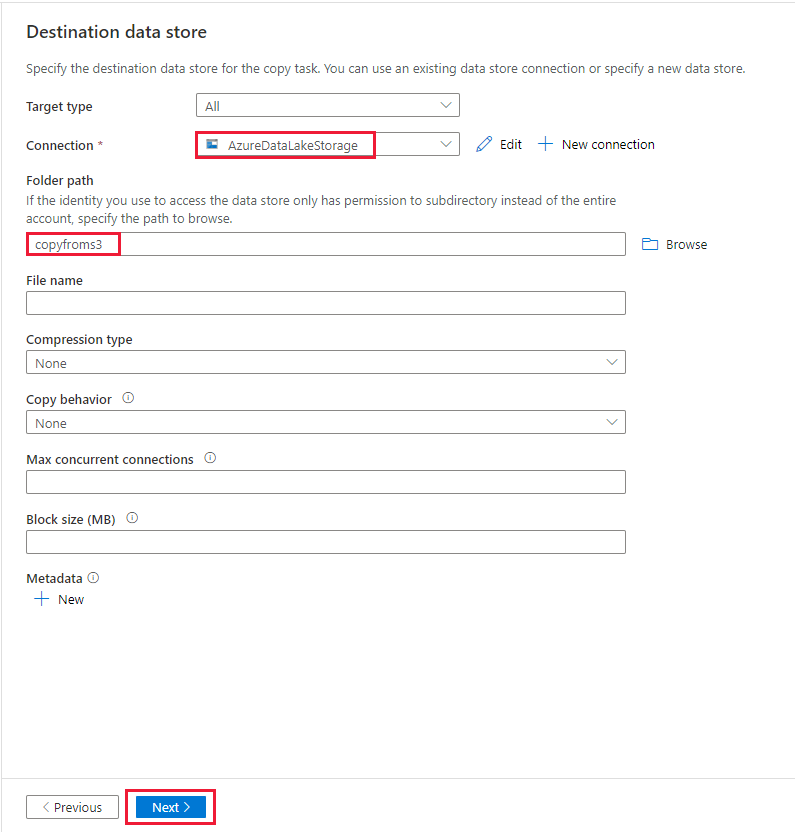

Na página Armazenamento de dados de origem, selecione a conexão criada recentemente no bloco Conexão. Em Caminho da pasta, insira copyfroms3 como o nome da pasta de saída e selecione Avançar. O ADF criará o sistema de arquivos ADLS Gen2 e as subpastas correspondentes durante a cópia, caso ela não exista.

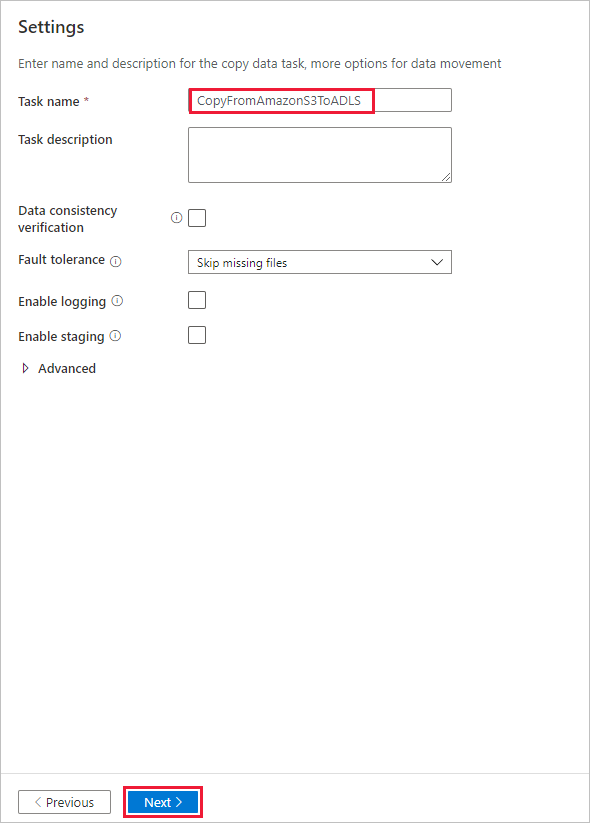

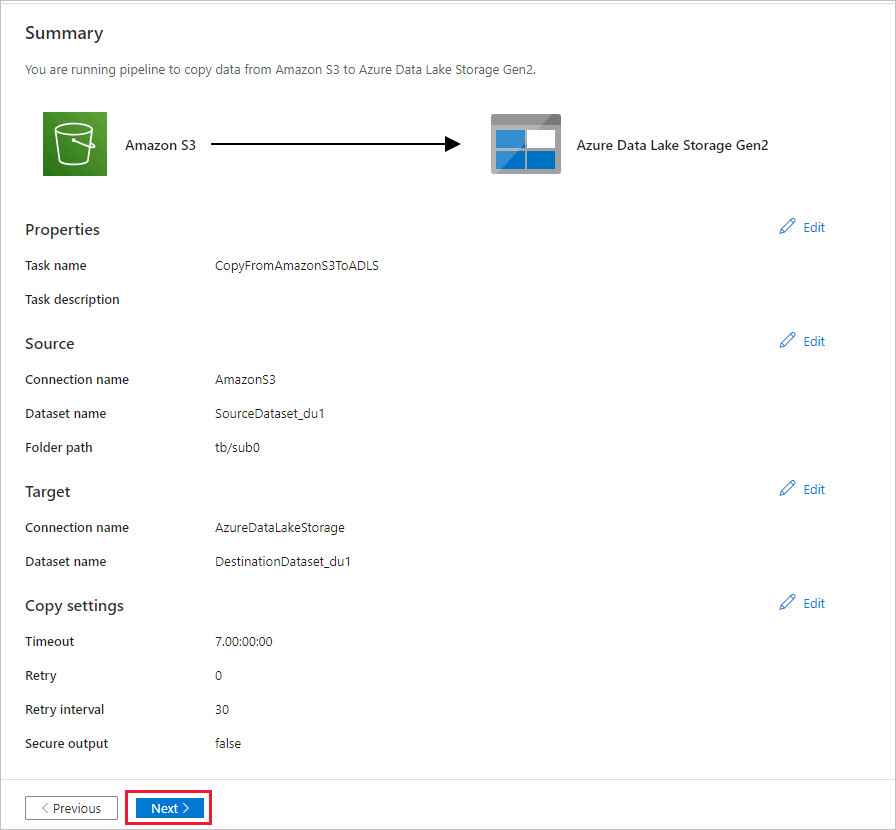

Na página Configurações, especifique CopyFromAmazonS3ToADLS para o campo Nome da tarefa e selecione Avançar para usar as configurações padrão.

Na página Resumo, examine as configurações e selecione Avançar.

Na página Implantação, selecione Monitorar para monitorar o pipeline (tarefa).

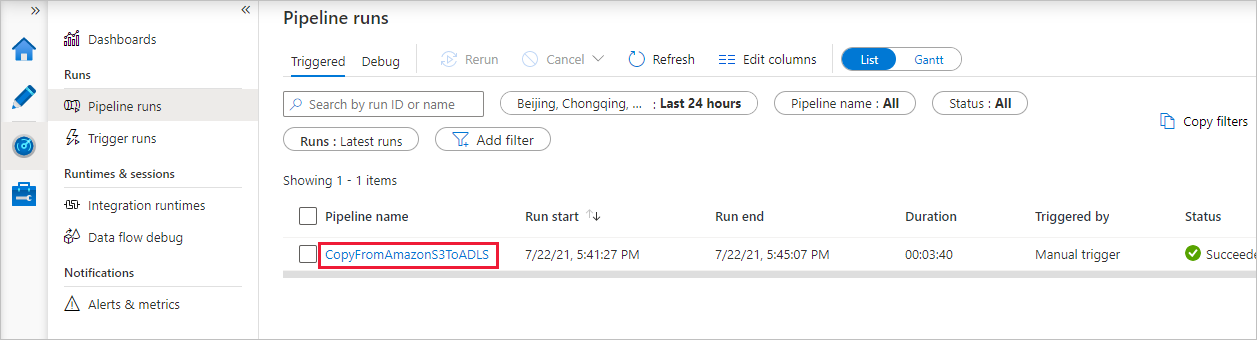

Quando a execução do pipeline terminar com êxito, você verá uma execução de pipeline disparada por um gatilho manual. Você pode usar os links na coluna Nome do Pipeline para ver detalhes da atividade e executar o pipeline novamente.

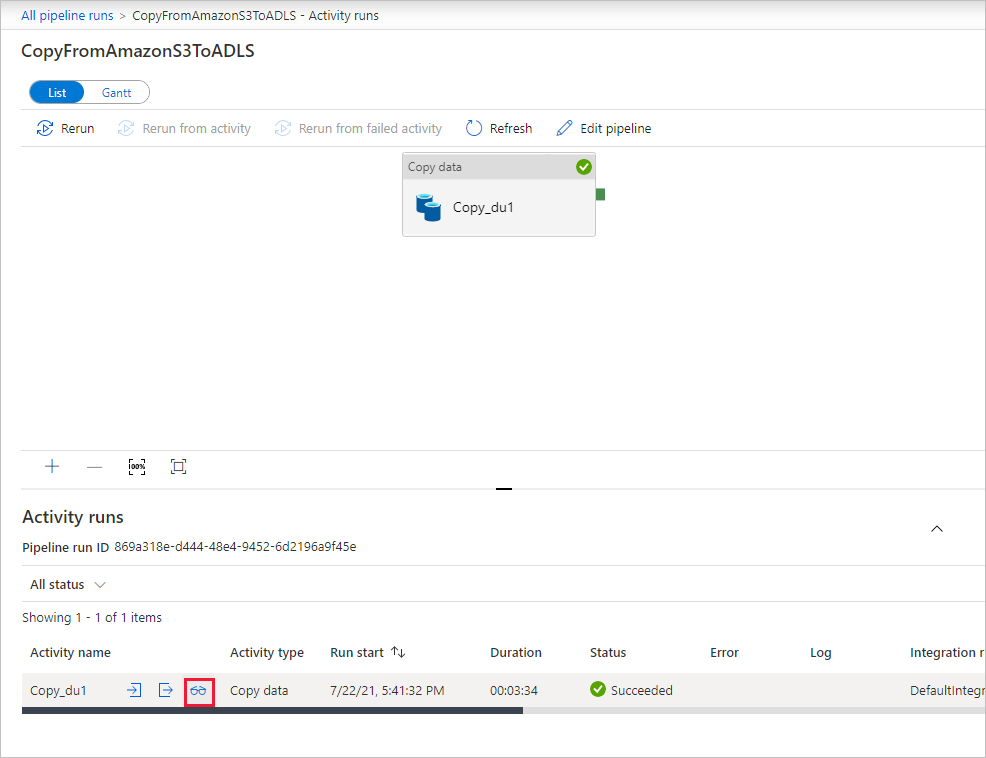

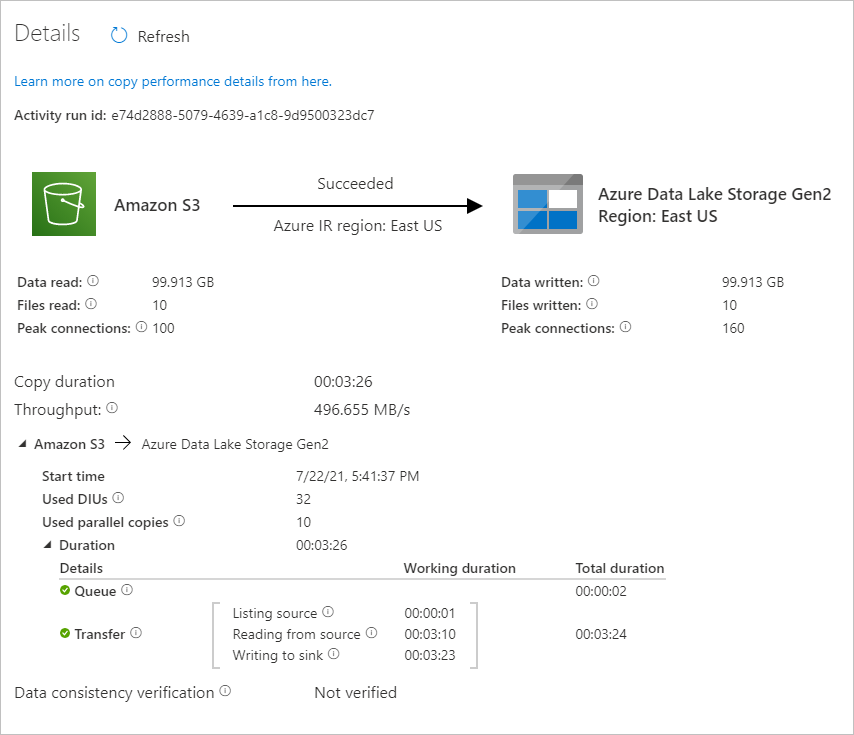

Para ver as execuções de atividade associadas à execução do pipeline, selecione o link CopyFromAmazonS3ToADLS na coluna Nome de pipeline. Para obter detalhes sobre a operação de cópia, selecione o link Detalhes (ícone de óculos) na coluna Nome de atividade. Você pode monitorar detalhes como o volume de dados copiados da fonte para o coletor, taxa de transferência de dados, etapas de execução com duração correspondente e configuração usada.

Para atualizar a exibição, selecione Atualizar. Selecione Todas as execuções de pipeline na parte superior para voltar à exibição "Execuções de Pipeline".

Verifique se os dados são copiados para a conta do Data Lake Store Gen2.