Desenvolver e depurar pipelines de Tabelas Dinâmicas Delta em notebooks

Importante

A experiência do Notebook para o desenvolvimento do Delta Live Tables está em Visualização Pública.

Este artigo descreve os recursos nos notebooks do Azure Databricks que auxiliam no desenvolvimento e na depuração do código do Delta Live Tables.

Visão geral de recursos

Ao trabalhar em um notebook Python ou SQL que é o código-fonte de um pipeline existente do Delta Live Tables, você pode conectar o notebook diretamente ao pipeline. Quando o notebook estiver conectado ao pipeline, os seguintes recursos estarão disponíveis:

- Inicie e valide o pipeline do notebook.

- Veja o grafo do fluxo de dados do pipeline e o log de eventos da atualização mais recente no notebook.

- Veja o diagnóstico do pipeline diretamente no editor do notebook.

- Veja o status do cluster do pipeline no notebook.

- Como acessar a interface do usuário do Delta Live Tables do notebook.

Pré-requisitos

- Você deve ter um pipeline do Delta Live Tables existente com um notebook Python ou SQL como código-fonte.

- Você deve ser o proprietário do pipeline ou ter o privilégio

CAN_MANAGE.

Limitações

- Os recursos abordados neste artigo só estão disponíveis nos notebooks do Azure Databricks. Não há suporte para arquivos de workspace.

- O terminal da Web não está disponível quando anexado a um pipeline. Como resultado, ele não é visível como uma guia no painel inferior.

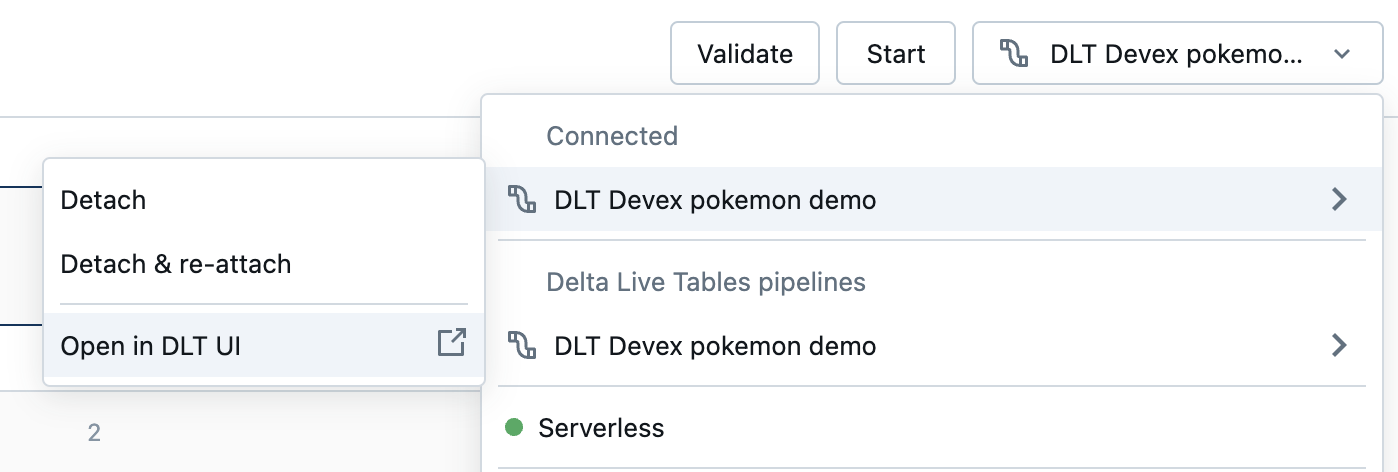

Conectar um notebook a um pipeline do Delta Live Tables

No notebook, clique no menu suspenso usado para selecionar a computação. O menu suspenso mostra todos os pipelines do Delta Live Tables com este notebook como código-fonte. Para conectar o notebook a um pipeline, selecione-o na lista.

Ver o status do cluster do pipeline

Para entender facilmente o estado do cluster do pipeline, seu status é mostrado no menu suspenso de computação com uma cor verde para indicar que o cluster está em execução.

Validar o código do pipeline

Você pode validar o pipeline para verificar se há erros de sintaxe no código-fonte sem processar dados.

Para validar um pipeline, siga um destes procedimentos:

- No canto superior direito do notebook, clique em Validar.

- Pressione

Shift+Enterem qualquer célula do notebook. - No menu suspenso de uma célula, clique em Validar Pipeline.

Observação

Se você tentar validar o pipeline enquanto uma atualização existente já estiver em execução, uma caixa de diálogo será exibida perguntando se você quer encerrar a atualização existente. Se você clicar em Sim, a atualização existente será interrompida e uma atualização de validação será iniciada automaticamente.

Iniciar o pipeline

Uma atualização de pipeline faz o seguinte: inicia um cluster, descobre e valida todas as tabelas e exibições definidas e cria ou atualiza tabelas e exibições com os dados mais recentes disponíveis.

Para iniciar uma atualização do pipeline, clique no botão Iniciar no canto superior direito do notebook.

Exibir o status de uma atualização

O painel superior do notebook mostra se uma atualização do pipeline está:

- Iniciando

- Validando

- Parando

Ver erros e diagnóstico

Depois que um pipeline é iniciado ou validado, todos os erros são mostrados embutidos com um sublinhado vermelho. Passe o mouse sobre um erro para ver mais informações.

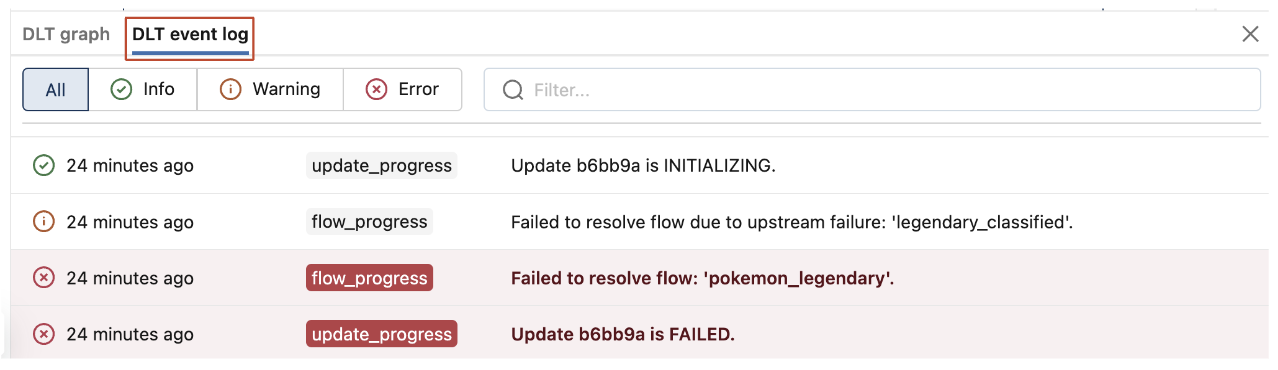

Ver eventos de pipeline

Quando anexado a um pipeline, haverá uma guia de log de eventos do Delta Live Tables na parte inferior do notebook.

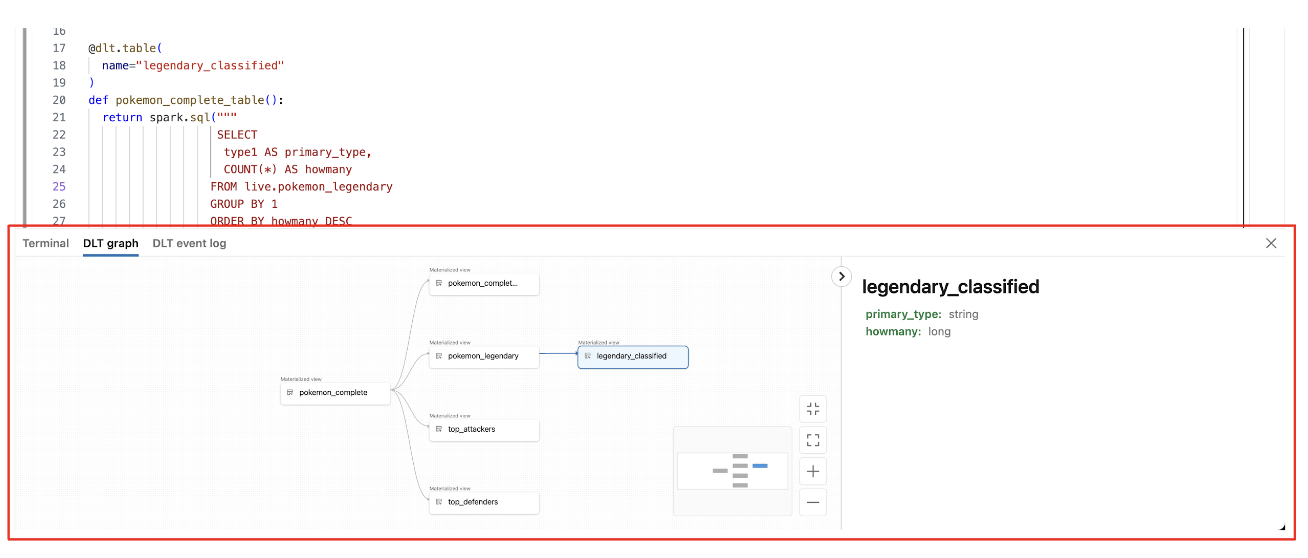

Ver o grafo do fluxo de dados do pipeline

Para exibir um grafo de fluxo de dados do pipeline, use a guia de grafo do Delta Live Tables na parte inferior do notebook. Selecionar um nó no grafo exibe seu esquema no painel direito.

Como acessar a interface do usuário do Delta Live Tables no notebook

Para ir facilmente para a interface do usuário do Delta Live Tables, use o menu no canto superior direito do notebook.

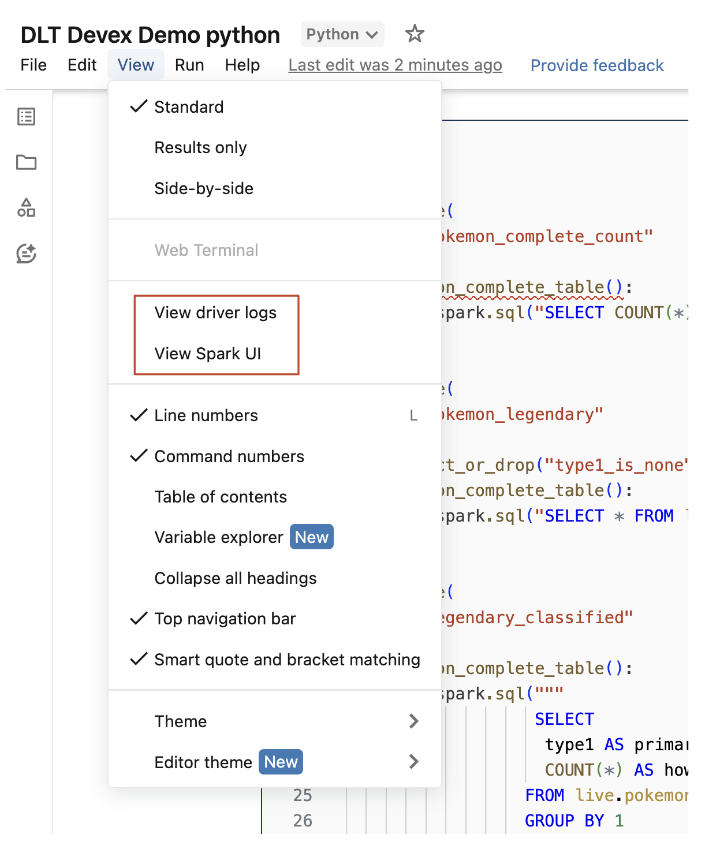

Acessar logs de driver e a interface do usuário do Spark no notebook

Os logs de driver e a interface do usuário do Spark associados ao pipeline que está sendo desenvolvido podem ser facilmente acessados no menu Exibir do notebook.