Criar uma execução de treinamento usando a API de ajuste fino do modelo de base

Importante

Esse recurso está em Visualização Pública nas seguintes regiões: centralus, eastus, eastus2, northcentralus e westus.

Este artigo descreve como criar e configurar uma execução de treinamento usando a API de ajuste fino do modelo de base (agora parte do treinamento do modelo de IA do Mosaic) e descreve todos os parâmetros usados na chamada à API. Você também pode criar uma execução usando a interface do usuário. Para obter instruções, consulte Criar uma execução de treinamento usando a interface do usuário de ajuste fino do modelo básico.

Requisitos

Confira os Requisitos

Criar uma execução de treinamento

Para criar execuções de treinamento programaticamente, use a função create(). Essa função treina um modelo no conjunto de dados fornecido e converte o ponto de verificação final do Composer em um ponto de verificação formatado com Hugging Face para inferência.

As entradas necessárias são o modelo que você deseja treinar, o local do conjunto de dados de treinamento e onde registrar seu modelo. Há também parâmetros opcionais que permitem que você execute a avaliação e altere os hiperparâmetros de sua execução.

Após a conclusão da execução, a execução concluída e o ponto de verificação final são salvos, o modelo é clonado e esse clone é registrado no Catálogo do Unity como uma versão de modelo para inferência.

O modelo da execução concluída, não a versão do modelo clonado no Catálogo do Unity, e seus pontos de verificação do Composer e Hugging Face são salvos no MLflow. Os pontos de verificação do Composer podem ser usados para tarefas de ajuste fino contínuas.

Consulte Configurar uma execução de treinamento para obter detalhes sobre argumentos para a função create().

from databricks.model_training import foundation_model as fm

run = fm.create(

model='meta-llama/Llama-2-7b-chat-hf',

train_data_path='dbfs:/Volumes/main/mydirectory/ift/train.jsonl', # UC Volume with JSONL formatted data

# Public HF dataset is also supported

# train_data_path='mosaicml/dolly_hhrlhf/train'

register_to='main.mydirectory', # UC catalog and schema to register the model to

)

Configurar uma execução de treinamento

A tabela a seguir resume os parâmetros da foundation_model.create() função.

| Parâmetro | Obrigatório | Type | Description |

|---|---|---|---|

model |

x | str | O nome do modelo a ser usado. Confira Modelos com suporte. |

train_data_path |

x | str | O local dos seus dados de treinamento. Esse pode ser um local no Catálogo do Unity (<catalog>.<schema>.<table> ou dbfs:/Volumes/<catalog>/<schema>/<volume>/<dataset>.jsonl) ou em um conjunto de dados do HuggingFace.Para INSTRUCTION_FINETUNE, os dados devem ser formatados com cada linha que contém um campo prompt e response.Para CONTINUED_PRETRAIN, esta é uma pasta de arquivos .txt. Consulte Preparar dados para o modelo de base: Ajuste fino para formatos de dados aceitos e Tamanho de dados recomendado para treinamento de modelo para recomendações de tamanho de dados. |

register_to |

x | str | O catálogo e o esquema do Catálogo do Unity (<catalog>.<schema> ou <catalog>.<schema>.<custom-name>) em que o modelo é registrado após o treinamento para implantação fácil. Se custom-name não for fornecido, esse padrão será o nome da execução. |

data_prep_cluster_id |

str | A ID do cluster a ser usada para processamento de dados do Spark. Isso é necessário para tarefas de treinamento supervisionadas em que os dados de treinamento estão em uma tabela Delta. Para obter informações sobre como localizar a ID do cluster, confira Obter a ID do cluster. | |

experiment_path |

str | O caminho para o experimento do MLflow em que a saída da execução de treinamento (métricas e pontos de verificação) é salva. O padrão é o nome de execução no workspace pessoal do usuário’(ou seja, /Users/<username>/<run_name>). |

|

task_type |

str | O tipo de tarefa a ser executado. Pode ser INSTRUCTION_FINETUNE (padrão) CHAT_COMPLETION ou CONTINUED_PRETRAIN. |

|

eval_data_path |

str | O local remoto dos dados de avaliação (se houver). Deve seguir o mesmo formato que train_data_path. |

|

eval_prompts |

List[str] | Uma lista de cadeias de caracteres de prompt para gerar respostas durante a avaliação. O padrão é None (não gera prompts). Os resultados são registrados no experimento sempre que o modelo está em ponto de verificação. As gerações ocorrem em cada ponto de verificação de modelo com os seguintes parâmetros de geração: max_new_tokens: 100, temperature: 1, top_k: 50, top_p: 0.95, do_sample: true. |

|

custom_weights_path |

str | O local remoto de um ponto de verificação de modelo personalizado para treinamento. O padrão é None, o que significa que a execução começa dos pesos pré-treinados originais do modelo escolhido. Se forem fornecidos pesos personalizados, esses pesos serão usados em vez dos pesos pré-treinados originais do modelo. Esses pesos devem ser um ponto de verificação do Composer e devem corresponder à model arquitetura do especificado. Consulte Criar em pesos de modelo personalizados |

|

training_duration |

str | A duração total da sua execução. O padrão é uma época ou 1ep. Pode ser especificada em épocas (10ep) ou tokens (1000000tok). |

|

learning_rate |

str | A taxa de aprendizagem para treinamento de modelo. Para todos os modelos que não sejam Llama 3.1 405B Instruct, a taxa de aprendizado padrão é de 5e-7. Para o Llama 3.1 405B Instruct, a taxa de aprendizado padrão é de 1.0e-5. O otimizador é DecoupledLionW com betas de 0,99 e 0,95 e sem redução de peso. O agendador de taxa de aprendizagem é LinearWithWarmupSchedule com um aquecimento de 2% da duração total do treinamento e um multiplicador de taxa de aprendizagem final de 0. |

|

context_length |

str | O comprimento máximo da sequência de uma amostra de dados. Isso é usado para truncar todos os dados que são muito longos e para empacotar sequências mais curtas em conjunto para eficiência. O padrão é 8.192 tokens ou o tamanho máximo do contexto para o modelo fornecido, o que for menor. Você pode usar esse parâmetro para configurar o tamanho do contexto, mas não há suporte para configurar o tamanho máximo do contexto de cada modelo. Consulte Modelos com suporte para obter o tamanho máximo de contexto com suporte de cada modelo. |

|

validate_inputs |

Booliano | Se deseja validar o acesso aos caminhos de entrada antes de enviar o trabalho de treinamento. O padrão é True. |

Compilar em pesos de modelo personalizados

O ajuste fino do modelo de fundação suporta a adição de pesos personalizados usando o parâmetro custom_weights_path opcional para treinar e personalizar um modelo.

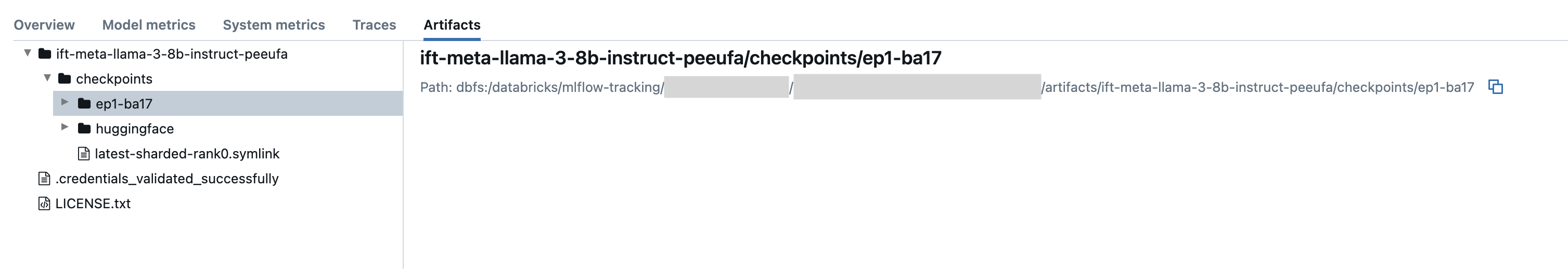

Para começar, defina custom_weights_path como o caminho do ponto de verificação do Composer de uma execução de treinamento anterior. Os caminhos de ponto de verificação podem ser encontrados na guia Artefatos de uma execução anterior do MLflow. O nome da pasta do ponto de verificação corresponde ao lote e à época de um instantâneo específico, como ep29-ba30/.

- Para fornecer o ponto de verificação mais recente de uma execução anterior, defina

custom_weights_pathcomo o ponto de verificação do Composer. Por exemplo,custom_weights_path=dbfs:/databricks/mlflow-tracking/<experiment_id>/<run_id>/artifacts/<run_name>/checkpoints/latest-sharded-rank0.symlink. - Para fornecer um ponto de verificação anterior, defina

custom_weights_pathcomo um caminho para uma pasta que contenha.distcparquivos correspondentes ao ponto de verificação desejado, comocustom_weights_path=dbfs:/databricks/mlflow-tracking/<experiment_id>/<run_id>/artifacts/<run_name>/checkpoints/ep#-ba#.

Em seguida, atualize o model parâmetro para corresponder ao modelo base do ponto de verificação que você passou para .custom_weights_path

No exemplo ift-meta-llama-3-1-70b-instruct-ohugkq a seguir, há uma execução anterior que ajusta meta-llama/Meta-Llama-3.1-70B. Para ajustar o ponto de verificação mais recente de ift-meta-llama-3-1-70b-instruct-ohugkq, defina as variáveis e custom_weights_path da model seguinte maneira:

from databricks.model_training import foundation_model as fm

run = fm.create(

model = 'meta-llama/Meta-Llama-3.1-70B'

custom_weights_path = 'dbfs:/databricks/mlflow-tracking/2948323364469837/d4cd1fcac71b4fb4ae42878cb81d8def/artifacts/ift-meta-llama-3-1-70b-instruct-ohugkq/checkpoints/latest-sharded-rank0.symlink'

... ## other parameters for your fine-tuning run

)

Consulte Configurar uma execução de treinamento para configurar outros parâmetros em sua execução de ajuste fino.

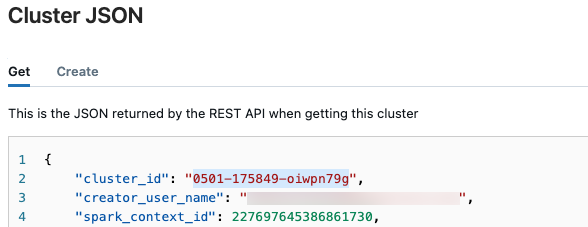

Obter a ID do cluster

Para recuperar a ID do cluster:

Na barra de navegação à esquerda do workspace Databricks, clique em Computação.

Na tabela, clique no nome do seu cluster.

Clique em

no canto superior direito e selecione Exibir JSON no menu suspenso.

no canto superior direito e selecione Exibir JSON no menu suspenso.O arquivo JSON do Cluster é exibido. Copie o ID do cluster, que é a primeira linha do arquivo.

Obter status de uma execução

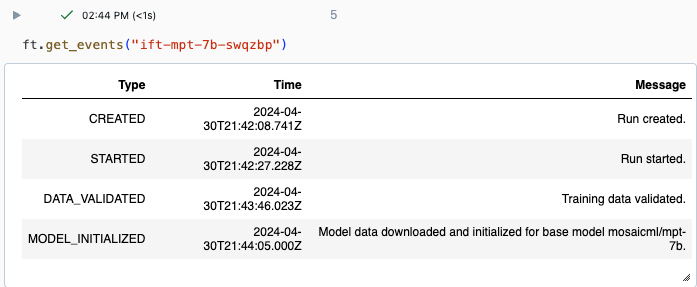

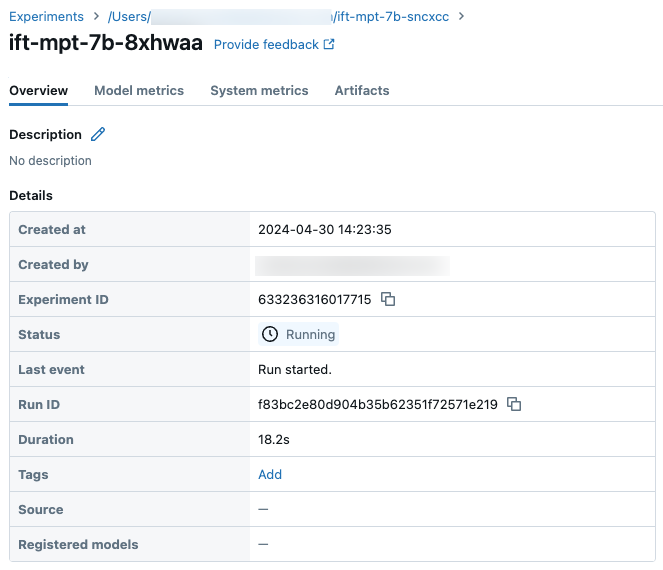

Você pode acompanhar o progresso de uma execução usando a página Experimento na interface do usuário do Databricks ou usando o comando de API get_events(). Para obter detalhes, consulte Exibir, gerenciar e analisar execuções de ajuste fino do Modelo de Fundação.

Exemplo de saída de get_events():

Detalhes da execução de exemplo na página Experimento:

Próximas etapas

Após a conclusão da execução do treinamento, você pode examinar as métricas no MLflow e implantar o modelo para inferência. Consulte as etapas 5 a 7 do Tutorial: Criar e implantar uma execução de ajuste fino do modelo de base.

Confira o notebook de demonstração Instrução de ajuste fino: Reconhecimento de Entidade Nomeada para obter um exemplo de ajuste fino de instrução que percorre a preparação de dados, a configuração e a implantação da execução de treinamento de ajuste fino.

Exemplo de notebook

O notebook a seguir mostra um exemplo de como gerar dados sintéticos usando o modelo Meta Llama 3.1 405B Instruct e usar esses dados para ajustar um modelo:

Gerar dados sintéticos usando o notebook Llama 3.1 405B Instruct

Recursos adicionais

- Ajuste fino do modelo de fundação

- Tutorial: Criar e implantar um modelo de base Execução de ajuste fino

- Criar uma execução de treinamento usando a interface do usuário de ajuste fino do modelo básico

- Visualizar, gerenciar e analisar execuções de ajuste fino do Modelo de Fundação

- Preparar dados para o ajuste fino do modelo de fundação