Catálogo de Modelos e Coleções

O catálogo de modelos no estúdio do Azure Machine Learning é o hub para descobrir e usar uma ampla gama de modelos que permitem criar aplicativos de IA generativa. O catálogo de modelos apresenta centenas de modelos de provedores de modelo, como Serviço OpenAI do Azure, Mistral, Meta, Cohere, Nvidia, Hugging Face, incluindo modelos treinados pela Microsoft. Modelos de provedores diferentes da Microsoft são produtos que não são da Microsoft, conforme definido nos Termos do Produto da Microsoft e sujeitos aos termos fornecidos com o modelo.

Coleções de modelos

Os modelos são organizados por Coleções no catálogo de modelos. Há três tipos de coleções no catálogo de modelos:

- Modelos selecionados pela IA do Azure: os modelos abertos de terceiros mais populares e de propriedade, empacotados e otimizados para funcionar perfeitamente na plataforma IA do Azure. O uso desses modelos está sujeito aos termos de licença do provedor de modelo fornecidos com o modelo. Quando implantado no Azure Machine Learning, a disponibilidade do modelo está sujeita ao SLA do Azure aplicável e a Microsoft fornece suporte para problemas de implantação. Modelos de parceiros como Meta, NVIDIA, Mistral AI são exemplos de modelos disponíveis na coleção "Coletado pela IA do Azure" no catálogo. Esses modelos podem ser identificados por uma marca de seleção verde nos blocos de modelo no catálogo ou você pode filtrar pela coleção "Coletado pela IA do Azure".

- Modelos Azure OpenAI, disponíveis exclusivamente no Azure: modelos emblemáticos do Azure OpenAI através da coleção “Azure OpenAI” através de uma integração com o Serviço OpenAI do Azure. Esses modelos possuem suporte da Microsoft e seu uso está sujeito aos termos do produto e ao SLA do Serviço OpenAI do Azure.

- Modelos abertos do hub Hugging Face: Centenas de modelos do hub HuggingFace são acessíveis através da coleção “Hugging Face” para inferência em tempo real com ponto de extremidade online. Hugging Face cria e mantém modelos listados na coleção HuggingFace. Use o fórum do HuggingFace ou o suporte do HuggingFace para obter ajuda. Saiba mais sobre como implantar modelos do Hugging Face.

Sugerir adições ao catálogo de modelos: você pode enviar uma solicitação para adicionar um modelo ao catálogo de modelos usando este formulário.

Visão geral dos recursos do catálogo de modelos

Para obter informações sobre modelos Azure OpenAI, consulte Serviço OpenAI do Azure.

Alguns modelos com Coletados pela IA do Azure e Modelos abertos do hub do Hugging Face podem ser implantados com uma opção de computação gerenciada, e alguns deles estão disponíveis para serem implantados usando APIs sem servidor com pagamento conforme o uso. Esses modelos podem ser descobertos, comparados, avaliados, ajustados (quando suportados) e implantados em escala e integrados em seus aplicativos de IA generativa com segurança de nível empresarial e governança de dados.

- Descobrir: revise cartões de modelo, experimente inferência de exemplos e procure exemplos de código para avaliar, ajustar ou implantar o modelo.

- Comparar: compare benchmarks entre modelos e conjuntos de dados disponíveis no setor para avaliar qual deles atende ao seu cenário de negócios.

- Avaliar: avalie se o modelo é adequado para sua carga de trabalho específica fornecendo seus próprios dados de teste. As métricas de avaliação facilitam a visualização do desempenho do modelo selecionado em seu cenário.

- Ajuste fino: personalize modelos ajustáveis usando seus próprios dados de treinamento e escolha o melhor modelo comparando métricas em todos os seus trabalhos de ajuste fino. As otimizações integradas aceleram o ajuste fino e reduzem a memória e a computação necessárias para o ajuste fino.

- Implantar: implante modelos pré-treinados ou modelos ajustados perfeitamente para inferência. Modelos que podem ser implantados na computação gerenciada também podem ser baixados.

Implantação de modelo: computação gerenciada e API sem servidor (pagamento conforme o uso)

O Catálogo de Modelos oferece duas maneiras distintas de implantar modelos do catálogo para o seu uso: computação gerenciada e APIs sem servidor. As opções de implantação disponíveis para cada modelo variam. Saiba mais sobre os recursos das opções de implantação e as opções disponíveis para modelos específicos nas tabelas abaixo. Saiba mais sobre processamento de dados com as opções de implantação.

| Recursos | Computação gerenciada | API sem servidor (pagamento conforme o uso) |

|---|---|---|

| Experiência de implantação e faturamento | Os pesos do modelo são implantados em Máquinas Virtuais dedicadas com pontos de extremidade online gerenciados. O ponto de extremidade online gerenciado, que pode ter uma ou mais implantações, disponibiliza uma API REST para inferência. Você será cobrado pelas horas principais da máquina virtual usadas pelas implantações. | O acesso aos modelos é feito por meio de uma implantação que provisiona uma API para acessar o modelo. A API fornece acesso ao modelo hospedado em um pool central de GPU, gerenciado pela Microsoft, para inferência. Esse modo de acesso é conhecido como "Modelos como Serviço". Você é cobrado pelas entradas e saídas das APIs, normalmente em tokens; as informações sobre preços são fornecidas antes da implantação. |

| Autenticação da API | Chaves e autenticação Microsoft Entra ID. Saiba mais. | Somente chaves. |

| Segurança de conteúdo | Utilize APIs do serviço Azure Content Safety. | Os filtros IA do Azure Content Safety estão disponíveis integrados com APIs de inferência. Os filtros do IA do Azure Content Safety podem ser cobrados separadamente. |

| Isolamento da rede | Rede virtual gerenciada com pontos de extremidade online. Saiba mais. |

Opções de implantação

| Modelar | Computação gerenciada | API sem servidor (pagamento conforme o uso) |

|---|---|---|

| Modelos da família Llama | Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat Llama-3-8B-Instruct Llama-3-70B-Instruct Llama-3-8B Llama-3-70B |

Llama-3-70B-Instruct Llama-3-8B-Instruct Llama-2-7b Llama-2-7b-chat Llama-2-13b Llama-2-13b-chat Llama-2-70b Llama-2-70b-chat |

| Modelos da família Mistral | mistralai-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x22B-Instruct-v0-1 mistral-community-Mixtral-8x22B-v0-1 mistralai-Mixtral-8x7B-v01 mistralai-Mistral-7B-Instruct-v0-2 mistralai-Mistral-7B-v01 mistralai-Mixtral-8x7B-Instruct-v01 mistralai-Mistral-7B-Instruct-v01 |

Mistral-large (2402) Mistral-large (2407) Mistral-small Ministral-3B Mistral-Nemo |

| Modelos familiares coerentes | Não disponível | Cohere-command-r-plus-08-2024 Cohere-command-r-08-2024 Cohere-command-r-plus Cohere-command-r Cohere-embed-v3-english Cohere-embed-v3-multilingual Cohere-rerank-v3-english Cohere-rerank-v3-multilingual |

| JAIS | Não disponível | jais-30b-chat |

| Modelos da família Phi-3 | Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3-vision-128k-Instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

Phi-3-mini-4k-Instruct Phi-3-mini-128k-Instruct Phi-3-small-8k-Instruct Phi-3-small-128k-Instruct Phi-3-medium-4k-instruct Phi-3-medium-128k-instruct Phi-3.5-mini-Instruct Phi-3.5-vision-Instruct Phi-3.5-MoE-Instruct |

| Nixtla | Não disponível | TimeGEN-1 |

| Outros modelos | Disponível | Não disponível |

Computação gerenciada

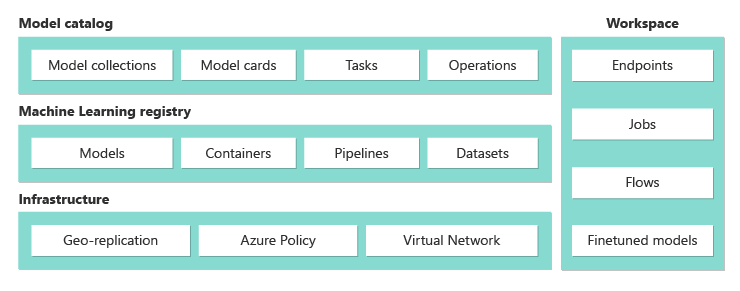

A capacidade de implantar modelos com computação gerenciada baseia-se em recursos de plataforma do Azure Machine Learning para habilitar a integração perfeita, em todo o ciclo de vida GenAIOps (às vezes chamado de LLMOps), da ampla coleção de modelos no catálogo de modelos.

Como os modelos são disponibilizados para computação gerenciada?

Os modelos são disponibilizados por meio de registros do Machine Learning do Azure que permitem a primeira abordagem de ML para hospedar e distribuir ativos de Machine Learning, como pesos de modelo, tempos de execução de contêiner para executar os modelos, pipelines para avaliar e ajustar os modelos e conjuntos de dados para parâmetros de comparação e amostras. Esses registros de ML baseiam-se em uma infraestrutura altamente escalável e pronta para empresas que:

Fornece artefatos de modelo de acesso de baixa latência para todas as regiões do Azure com replicação geográfica integrada.

Suportam requisitos de segurança empresarial como limitação do acesso a modelos com Azure Policy e implantação segura com redes virtuais gerenciadas.

Avaliar e ajustar modelos implantados com computação gerenciada

Você pode avaliar e fazer ajuste fino da coleção "Coletada pela IA do Azure" no Azure Machine Learning usando pipelines do Azure Machine Learning. Você pode optar por trazer seu próprio código de avaliação e ajuste fino e apenas acessar os pesos do modelo ou usar componentes do Azure Machine Learning que oferecem recursos internos de avaliação e ajuste fino. Para saber mais, siga esse link.

Implantar modelos para inferência com computação gerenciada

Os modelos disponíveis para implantação com computação gerenciada podem ser implantados em pontos de extremidade online do Azure Machine Learning para inferência em tempo real ou podem ser usados para inferência em lote do Azure Machine Learning para processar seus dados em lote. A implantação na computação gerenciada exige que você tenha a cota de Máquina Virtual em sua Assinatura do Azure para as SKUs específicas necessárias para executar o modelo de maneira ideal. Alguns modelos permitem implantar em cota compartilhada temporariamente para testar o modelo. Saiba mais sobre como implantar modelos:

- Implantar modelos Meta Llama

- Implantar modelos abertos criados pela IA do Azure

- Implantar modelos Hugging Face

Criar aplicativos de IA generativa com computação gerenciada

O prompt flow oferece recursos para prototipagem, experimentação, iteração e implantação de seus aplicativos de IA. Você pode usar modelos implantados com computação gerenciada no prompt flow com a ferramenta Open Model LLM. Você também pode usar a API REST exposta pelas computações gerenciadas em ferramentas LLM populares como LangChain com a extensão do Azure Machine Learning.

Segurança de conteúdo para modelos implantados com computação gerenciada

O serviço Segurança de Conteúdo de IA do Azure (AACS) está disponível para uso com modelos implantados para computação gerenciada na tela para várias categorias de conteúdo prejudicial, como conteúdo sexual, violência, ódio e automutilação e ameaças avançadas, como detecção de risco de jailbreak e detecção de texto material protegido. Você pode consultar este notebook para integração de referência com a AACS para Llama 2 ou usar a ferramenta de Segurança de Conteúdo (Texto) no Prompt Flow para passar as respostas do modelo para a AACS para triagem. Você será cobrado separadamente de acordo com os preços da AACS para tal uso.

Trabalhar com modelos que não estão no catálogo de modelos

Para modelos não disponíveis no catálogo de modelos, o Azure Machine Learning fornece uma plataforma aberta e extensível para trabalhar com modelos de sua escolha. Você pode trazer um modelo com qualquer estrutura ou runtime usando as funcionalidades de plataforma aberta e extensível do Azure Machine Learning, como ambientes do Azure Machine Learning para contêineres que podem empacotar estruturas e runtimes e pipelines do Azure Machine Learning para que o código avalie ou realize ajuste fino dos modelos. Consulte este notebook para obter exemplos de referência para importar modelos e trabalhar com tempos de execução e pipelines integrados.

APIs sem servidor com pagamento conforme o uso

Determinados modelos no catálogo de modelos podem ser implantados como APIs sem servidor com pagamento conforme o uso; este método de implantação é chamado de Modelos como Serviço (MaaS). Os modelos disponíveis por meio do MaaS são hospedados na infraestrutura gerenciada pela Microsoft, o que permite o acesso baseado em API ao modelo do provedor de modelos. O acesso baseado em API pode reduzir drasticamente o custo de acesso a um modelo e simplificar significativamente a experiência de provisionamento. A maioria dos modelos MaaS vem com preços baseados em tokens.

Como os modelos de terceiros são disponibilizados no MaaS?

Os modelos disponíveis para implantação como APIs sem servidor com pagamento conforme o uso são oferecidos pelo provedor de modelo, mas hospedados na infraestrutura do Azure gerenciada pela Microsoft e acessados por meio da API. Os fornecedores de modelos definem os termos de licença e definem o preço de utilização dos seus modelos, enquanto o Serviço do Azure Machine Learning gere a infraestrutura de alojamento, disponibiliza as APIs de inferência e atua como processador de dados para pedidos enviados e saída de conteúdo por modelos implantados através de MaaS. Saiba mais sobre processamento de dados para MaaS no artigo privacidade de dados.

Pague pelo uso do modelo em MaaS

A experiência de descoberta, assinatura e consumo para modelos implantados via MaaS está no portal de IA do Azure Foundry e no Estúdio do Azure Machine Learning. Os usuários aceitam os termos de licença para uso dos modelos, e as informações sobre preços de consumo são fornecidas durante a implantação. Os modelos de fornecedores terceirizados são cobrados através do Azure Marketplace, de acordo com os Termos de Uso do Mercado Comercial; os modelos da Microsoft são cobrados usando medidores do Azure como serviços de Consumo primário. Conforme descrito nos Termos do Produto, os Serviços de Consumo Primário são adquiridos usando medidores do Azure, mas não estão sujeitos aos termos de serviço do Azure; o uso desses modelos está sujeito aos termos de licença fornecidos.

Implante modelos para inferência por meio de MaaS

A implantação de um modelo por meio de MaaS permite que os usuários tenham acesso a APIs de inferência prontas para uso, sem a necessidade de configurar infraestrutura ou provisionar GPUs, economizando tempo e recursos de engenharia. Essas APIs podem ser integradas a diversas ferramentas LLM e o uso é cobrado conforme descrito na seção anterior.

Ajuste modelos por meio de MaaS com pagamento conforme o uso

Para modelos que estão disponíveis por meio de MaaS e oferecem suporte ao ajuste fino, os usuários podem aproveitar as vantagens do ajuste fino hospedado com cobrança de pagamento conforme o uso para personalizar os modelos usando os dados que eles fornecem. Para obter mais informações, consulte Ajustar um modelo Llama 2 no portal do Azure AI Foundry.

RAG com modelos implantados por meio de MaaS

O Azure AI Foundry permite que os usuários usem índices vetoriais e geração aumentada de recuperação. Modelos que podem ser implantados como APIs sem servidor podem ser usados para gerar inserções e inferências com base em dados personalizados para gerar respostas específicas para o seu caso de uso. Para obter mais informações, veja Geração aumentada de recuperação e índices.

Disponibilidade regional de ofertas e modelos

A cobrança Pagamento conforme o uso só está disponível para os usuários cuja assinatura do Azure pertence a uma conta de cobrança em um país onde o provedor de modelo disponibilizou a oferta. Se a oferta estiver disponível na região relevante, o usuário precisará ter um Hub/Projeto na região do Azure em que o modelo está disponível para implantação ou ajuste fino, conforme aplicável. Confira Disponibilidade de regiões para modelos em pontos de extremidade de API sem servidor para obter informações detalhadas.

Segurança de conteúdo para modelos implantados via MaaS

Importante

Esse recurso está atualmente em visualização pública. Essa versão prévia é fornecida sem um contrato de nível de serviço e não é recomendada para cargas de trabalho de produção. Alguns recursos podem não ter suporte ou podem ter restrição de recursos.

Para obter mais informações, consulte Termos de Uso Complementares de Versões Prévias do Microsoft Azure.

Para modelos de linguagem implantados por meio de APIs sem servidor, o Azure AI implementa uma configuração padrão de filtros de moderação de texto da Segurança de Conteúdo de IA do Azure que detecta conteúdos prejudiciais, como conteúdo de ódio, de automutilação, sexual e violento. Para saber mais sobre a filtragem de conteúdo (versão prévia), veja Categorias de danos na Segurança de Conteúdo de IA do Azure.

Dica

A filtragem de conteúdo (versão prévia) não está disponível para determinados tipos de modelo que são implantados por meio de APIs sem servidor. Esses tipos de modelo incluem modelos de inserção e modelos de série temporal.

A filtragem de conteúdo (versão prévia) ocorre de forma síncrona à medida que o serviço processa solicitações para gerar conteúdo. Você pode ser cobrado separadamente de acordo com preços de Segurança de Conteúdo de IA do Azure para tal uso. Você pode desabilitar a filtragem de conteúdo (versão prévia) para pontos de extremidade individuais sem servidor:

- No momento em que você implanta um modelo de linguagem pela primeira vez

- Posteriormente, selecionando a alternância de filtragem de conteúdo na página de detalhes da implantação

Suponha que você decida usar uma API diferente da API de Inferência do Modelo de IA do Azure para trabalhar com um modelo implantado por meio de uma API sem servidor. Nessa situação, a filtragem de conteúdo (versão prévia) não estará habilitada, a menos que você a implemente separadamente usando a Segurança de Conteúdo de IA do Azure.

Para começar a usar a Segurança de Conteúdo de IA do Azure, confira Início Rápido: Analisar conteúdo de texto. Se não usar a filtragem de conteúdo (versão prévia) ao trabalhar com modelos que são implantados por meio de APIs sem servidor, você correrá um risco mais alto de expor os usuários a conteúdos prejudiciais.

Isolamento de rede para modelos implantados por meio de APIs sem servidor

Os pontos de extremidade para modelos implantados como APIs sem servidor seguem a configuração do sinalizador de acesso à rede pública (PNA) do espaço de trabalho no qual a implantação existe. Para proteger seu ponto de extremidade MaaS, desabilite o sinalizador de PNA no seu espaço de trabalho. Você pode proteger a comunicação enviada por um cliente para o seu ponto de extremidade usando um ponto de extremidade privado para o espaço de trabalho.

Para definir o sinalizador de PNA para o espaço de trabalho:

- Acesse o portal do Azure.

- Procure Azure Machine Learning e selecione seu espaço de trabalho na lista de espaços de trabalho.

- Na página Visão Geral, use o painel de navegação do lado esquerdo para acessar Configurações>Rede.

- Na guia Acesso público, você pode definir as configurações para o sinalizador de acesso à rede pública.

- Salve suas alterações. Suas alterações podem levar até cinco minutos para serem propagadas.

Limitações

- Se você tiver um espaço de trabalho com um ponto de extremidade privado criado antes de 11 de julho de 2024, os novos pontos de extremidade MaaS adicionados a esse espaço de trabalho não seguirão a respectiva configuração de rede. Em vez disso, você precisa criar um novo ponto de extremidade privado para o espaço de trabalho e criar novas implantações de API sem servidor no espaço de trabalho para que as novas implantações possam seguir a configuração de rede do espaço de trabalho.

- Se você tiver um espaço de trabalho com implantações MaaS criadas antes de 11 de julho de 2024 e habilitar um ponto de extremidade privado nesse espaço de trabalho, as implantações MaaS existentes não seguirão a configuração de rede do espaço de trabalho. Para que as implantações de API sem servidor no espaço de trabalho sigam a configuração do espaço de trabalho, você precisará criar as implantações novamente.

- Atualmente, o suporte a Em Seus Dados não está disponível para implantações MaaS em espaços de trabalhos privados, já que o sinalizador de PNA dos espaços de trabalhos privados são desabilitados.

- Qualquer alteração de configuração de rede (por exemplo, habilitar ou desabilitar o sinalizador de PNA) pode levar até cinco minutos para ser propagada.

Saiba mais

- Saiba como usar modelos de base no Azure Machine Learning para ajuste fino, avaliação e implantação usando a interface do usuário do Estúdio do Azure Machine Learning ou métodos baseados em código.

- Explore o Catálogo de Modelos no Estúdio do Azure Machine Learning. Você precisa de um workspace do Azure Machine Learning para explorar o catálogo.

- Avalie, ajuste e implante modelos coletados pelo Azure Machine Learning.