Migrar configurações do Spark do Azure Synapse para o Fabric

O Apache Spark fornece inúmeras configurações que podem ser personalizadas para aprimorar a experiência em vários cenários. No Spark do Azure Synapse e na Engenharia de Dados do Fabric, você tem a flexibilidade de incorporar essas configurações ou propriedades para adaptar sua experiência. No Fabric, você pode adicionar configurações do Spark a um ambiente e usar propriedades embutidas do Spark diretamente nos trabalhos do Spark. Para mover configurações do Spark do Azure Synapse para o Fabric, use um ambiente.

Para considerações sobre a configuração do Spark, consulte as diferenças entre o Fabric e o Spark do Azure Synapse e o .

Pré-requisitos

- Se você ainda não tiver um, crie um workspace do Fabric no seu locatário.

- Se você ainda não tiver um, crie um ambiente em seu espaço de trabalho.

Opção 1: adicionar configurações do Spark ao ambiente personalizado

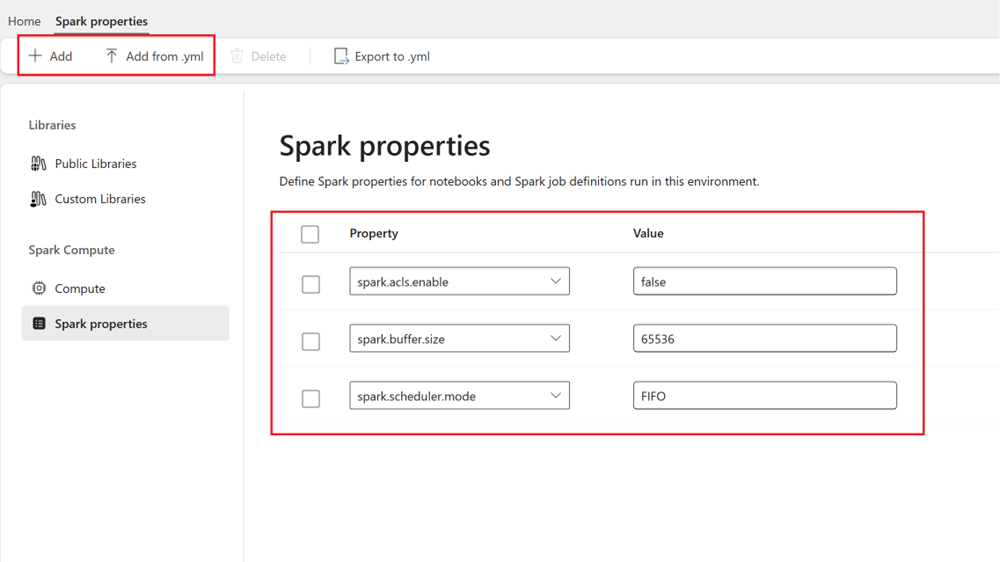

Em um ambiente, você pode definir as propriedades do Spark e essas configurações são aplicadas ao pool de ambientes selecionado.

- Abra o Synapse Studio: entre no Azure. Navegue até o workspace do Azure Synapse e abra o Synapse Studio.

- Localizar configurações do Spark:

- Acesse a área Gerenciar e selecione em pools do Apache Spark.

- Localize o pool do Apache Spark, selecione configuração do Apache Spark e localize o nome de configuração do Spark para o pool.

- Obter configurações do Spark: você pode obter essas propriedades selecionando Exibir configurações ou exportando a configuração (formato .txt/.conf/.json) em Configurações + bibliotecas>Configurações do Apache Spark.

- Depois que você tiver as configurações do Spark, adicione as propriedades personalizadas do Spark ao Ambiente no Fabric:

- No Ambiente, vá para Computação do Spark>Propriedades do Spark.

- Adicione as configurações do Spark. Você pode adicionar cada uma manualmente ou importar do .yml.

- Clique nas alterações Salvar e Publicar.

Saiba mais sobre como adicionar configurações do Spark a um Ambiente.