Tutorial do Lakehouse: Ingerir dados no Lakehouse

Neste tutorial, você ingere mais tabelas de fatos e dimensionais da Wide World Importers (WWI) no lakehouse.

Pré-requisitos

- Caso você não tenha um lakehouse, crie um.

Ingestão de dados

Nesta seção, utilize a atividade Copiar dados do pipeline do Data Factory para ingerir dados de amostra de uma conta de armazenamento do Azure para a seção Arquivos do lakehouse criado anteriormente.

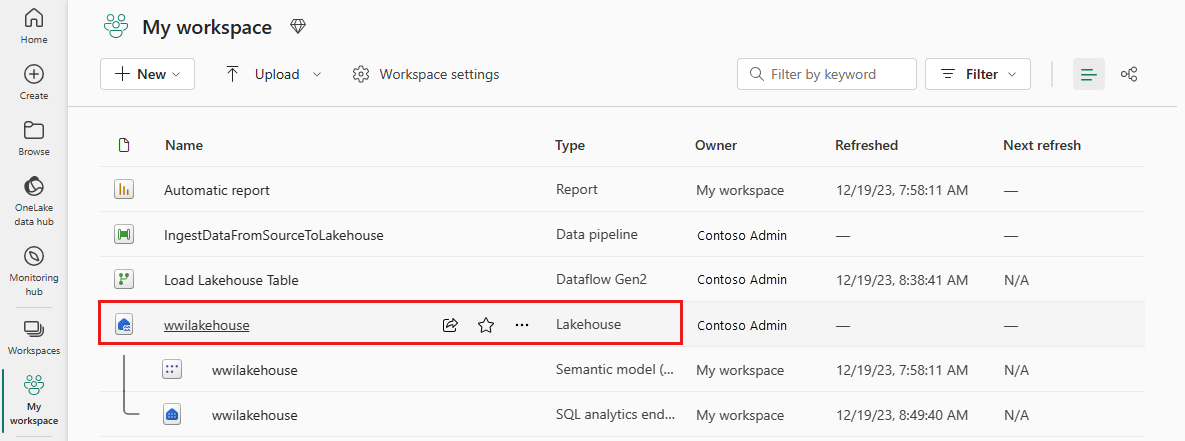

Selecione Espaços de Trabalho no painel de navegação esquerdo e, em seguida, selecione o novo espaço de trabalho no menu Espaços de Trabalho. A exibição de itens do seu espaço de trabalho é exibida.

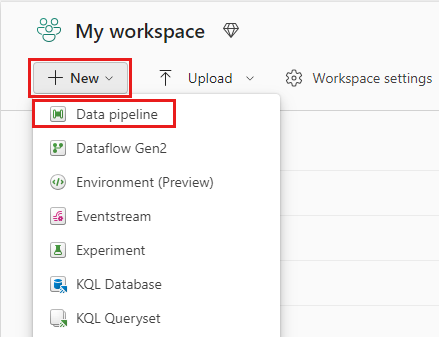

No item de menu +Novo da faixa espaço de trabalho, selecione Pipeline de dados.

Na caixa de diálogo Novo pipeline, especifique o nome como IngestDataFromSourceToLakehouse e selecione Criar. Um novo pipeline do data factory é criado e aberto.

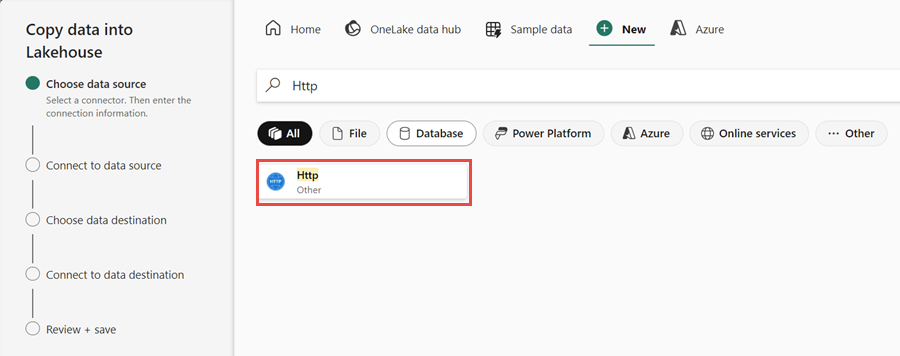

Em seguida, configure uma conexão HTTP para importar os dados de amostra do World Wide Importers para o Lakehouse. Na lista de Novas fontes, selecione Ver mais, pesquise Http e selecione-o.

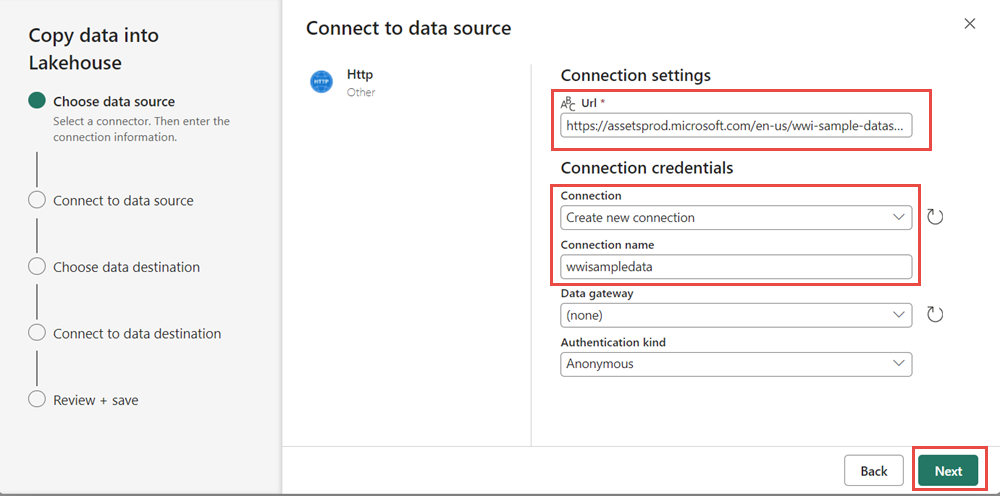

Na janela Conectar à fonte de dados insira os detalhes da tabela abaixo e selecione Avançar.

Propriedade Valor URL https://assetsprod.microsoft.com/en-us/wwi-sample-dataset.zipConexão Crie uma nova conexão Nome da conexão wwisampledata Gateway de dados Nenhum Tipo de autenticação Anônima

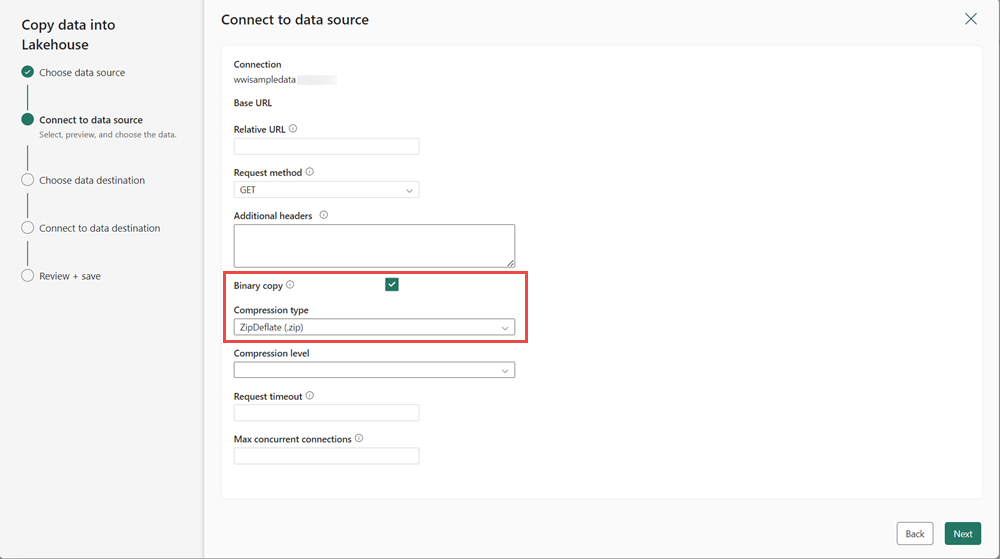

Na próxima etapa, habilite a cópia binária e escolha ZipDeflate (.zip) como o tipo de compactação pois a origem é um arquivo .zip. Mantenha os outros campos com seus valores padrão e clique em Avançar.

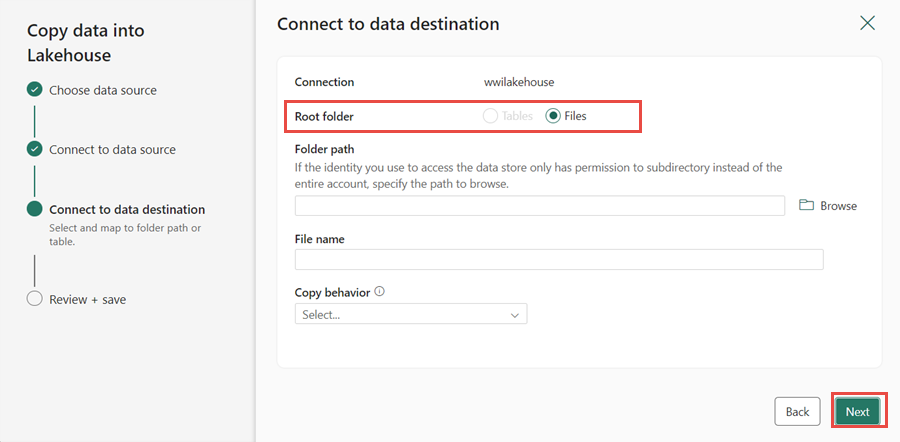

Na janela Conectar-se ao destino de dados, especifique a pasta raiz como Arquivos e clique em Avançar. Isso gravará os dados na seção Arquivos do lakehouse.

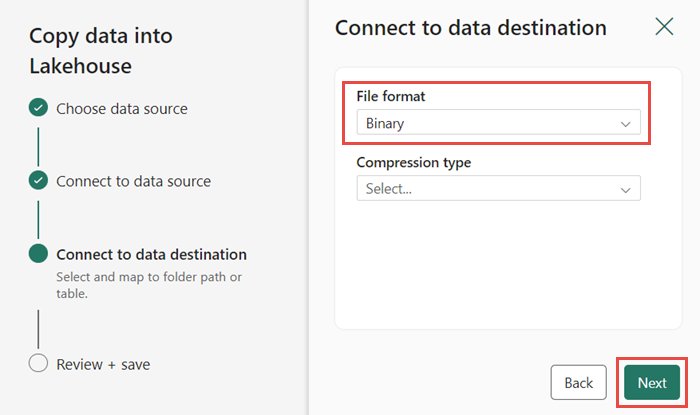

Escolha o Formato de arquivo como Binário para o destino. Clique em Avançar e depois em Salvar+Executar. Você pode agendar pipelines para atualizar dados periodicamente. Neste tutorial, executamos o pipeline apenas uma vez. O processo de cópia de dados leva aproximadamente 10 a 15 minutos para ser concluído.

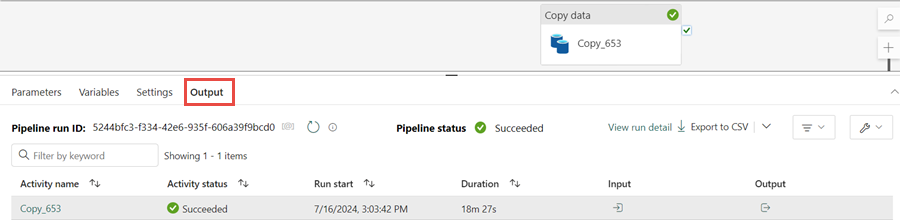

Você pode monitorar a execução e a atividade do pipeline na guia Saída. Você também pode visualizar informações detalhadas de transferência de dados selecionando o ícone de óculos ao lado do nome do pipeline, que aparece quando você passa o mouse sobre o nome.

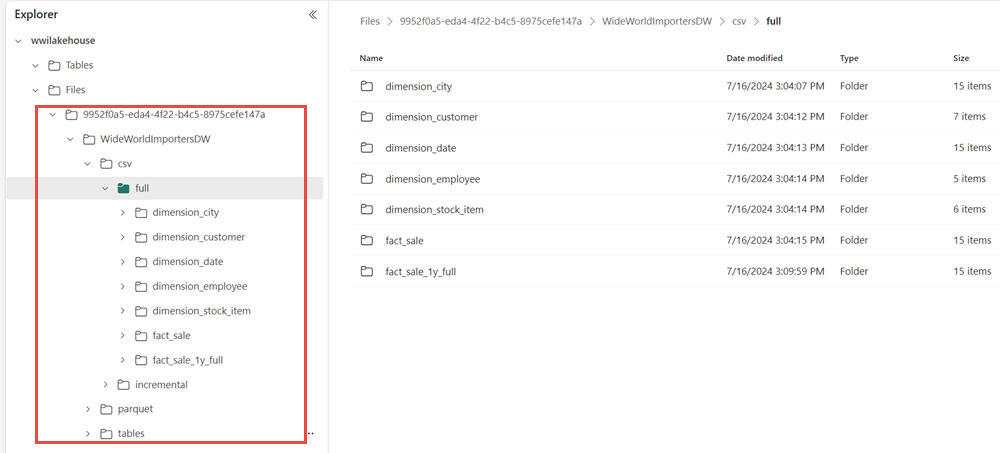

Após a execução bem-sucedida do pipeline, vá para o lakehouse (wwilakehouse) e abra o explorador para ver os dados importados.

Verifique se a pasta WideWorldImportersDW está presente na exibição Explorer e contém dados de todas as tabelas.

Os dados são criados na seção Arquivos do explorador do lakehouse. Uma nova pasta com GUID contém todos os dados necessários. Renomeie o GUID para wwi-raw-data

Para carregar dados incrementais em um lakehouse, consulte Carregar dados de forma incremental de um data warehouse para um lakehouse.