Executar experimentos com o MLflow

Os experimentos do MLflow permitem que os cientistas de dados acompanhem as execuções de treinamento em uma coleção chamada de experimento. As execuções de experimento são úteis para comparar mudanças ao longo do tempo ou comparar o desempenho relativo dos modelos com diferentes valores de hiperparâmetros.

Como executar um experimento

A criação de um experimento no Azure Databricks ocorre automaticamente quando você inicia uma execução. Aqui está um exemplo de como iniciar uma execução no MLflow, registrar em log dois parâmetros e registrar em log uma métrica:

with mlflow.start_run():

mlflow.log_param("input1", input1)

mlflow.log_param("input2", input2)

# Perform operations here like model training.

mlflow.log_metric("rmse", rmse)

Nesse caso, o nome do experimento é o nome do notebook. É possível exportar uma variável chamada MLFLOW_EXPERIMENT_NAME para alterar o nome do experimento, caso você escolha.

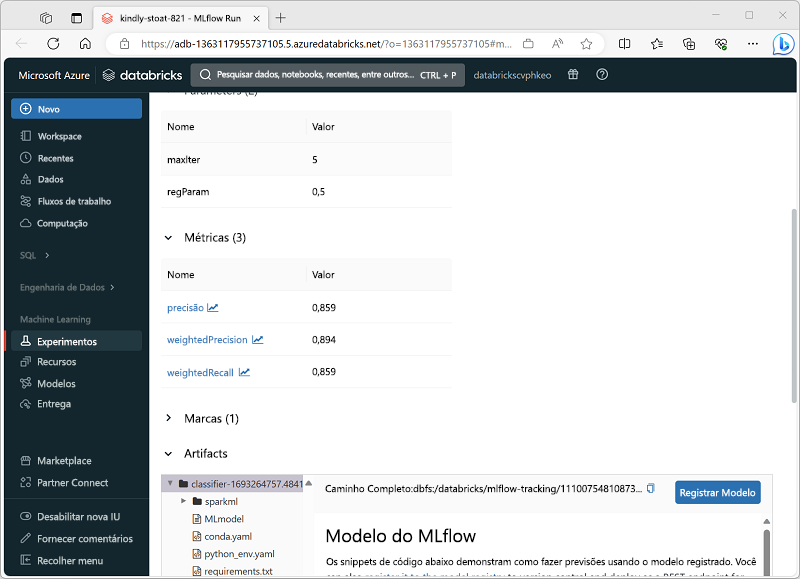

Revisão de uma execução de experimento

No portal do Azure Databricks, a página Experimentos permite exibir detalhes de cada execução de experimento; incluindo valores registrados para parâmetros, métricas e outros artefatos.