Como funciona a Segurança de Conteúdo de IA do Azure?

A Segurança de Conteúdo de IA do Azure funciona com texto e imagens, bem como com conteúdo gerado por IA.

Os recursos de visão de segurança de conteúdo são alimentados pelo modelo da Fundação Florence da Microsoft, que foi treinado com bilhões de pares de imagem/texto. A análise de texto usa técnicas de processamento de linguagem natural, proporcionando uma melhor compreensão da nuance e do contexto. A Segurança de Conteúdo de IA do Azure é multilíngue e pode detectar conteúdo prejudicial de maneira extensa e abreviada. Ele está disponível atualmente em inglês, alemão, espanhol, francês, português, italiano e chinês.

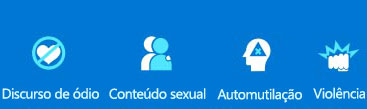

A Segurança de Conteúdo de IA do Azure classifica o conteúdo em quatro categorias:

Um nível de severidade para cada categoria é usado para determinar se o conteúdo deve ser bloqueado, enviado a um moderador ou aprovado automaticamente.

Os recursos na Segurança de Conteúdo de IA do Azure incluem:

Proteger o conteúdo do texto

Texto moderado examina texto em quatro categorias: violência, discurso de ódio, conteúdo sexual e automutilação. Um nível de severidade de 0 a 6 é retornado para cada categoria. Esse nível ajuda a priorizar o que precisa de atenção imediata das pessoas e com que urgência. Você também pode criar uma lista de bloqueios para verificar os termos específicos à sua situação.

Os escudos de prompt são uma API unificada para identificar e bloquear ataques de jailbreak de entradas para LLMs. Ele inclui entrada de usuário e documentos. Esses ataques são solicitações para LLMs que tentam ignorar os recursos de segurança internos do modelo. Os prompts do usuário são testados para garantir que a entrada no LLM seja segura. Os documentos são testados para garantir que eles não contenham instruções não seguras inseridas no texto.

A detecção de material protegido verifica o texto gerado por IA para texto protegido, como receitas, letras de músicas com direitos autorais ou outro material original.

A detecção de fundamentação protege contra respostas imprecisas no texto gerado por IA por LLMs. Os LLMs públicos usam dados disponíveis no momento em que foram treinados. No entanto, os dados podem ser introduzidos após o treinamento original do modelo ou criados em dados privados. Uma resposta fundamentada é aquela em que a saída do modelo é baseada nas informações de origem. Uma resposta não fundamentada é aquela em que a saída do modelo varia de acordo com as informações de origem. A detecção de fundamentação inclui uma opção de raciocínio na resposta da API. Isso adiciona um campo de raciocínio que explica qualquer detecção de falta de fundamentação. No entanto, o raciocínio aumenta o tempo de processamento e os custos.

Proteger o conteúdo da imagem

Imagens moderadas verificam conteúdo inadequado em quatro categorias: violência, automutilação, sexual e ódio. Um nível de severidade é retornado: seguro, baixo ou alto. Em seguida, você define um nível limite de baixo, médio ou alto. A combinação da severidade e do nível de limite determina se a imagem é permitida ou bloqueada para cada categoria.

O conteúdo multimodal moderado verifica imagens e texto, incluindo texto extraído de uma imagem usando o OCR (reconhecimento óptico de caracteres). O conteúdo é analisado em quatro categorias: violência, discurso de ódio, conteúdo sexual e automutilação.

Soluções de segurança personalizadas

Categorias personalizadas permitem que você crie suas categorias, fornecendo exemplos positivos e negativos e treinando o modelo. Em seguida, o conteúdo pode ser verificado de acordo com suas definições de categoria.

A mensagem do sistema de segurança ajuda você a escrever prompts eficazes para orientar o comportamento de um sistema de IA.

Limitações

A Segurança de Conteúdo de IA do Azure usa algoritmos de IA e, portanto, nem sempre pode detectar linguagem inadequada. E, em algumas ocasiões, ela pode bloquear a linguagem aceitável porque ela depende de algoritmos e aprendizado de máquina para detectar linguagem problemática.

A Segurança de Conteúdo de IA do Azure deve ser testada e avaliada em dados reais antes de ser implantada. E uma vez implantada, você deve continuar monitorando o sistema para ver com que precisão ela está sendo executada.

Avaliando a precisão

Ao avaliar a precisão da Segurança de Conteúdo da IA do Azure para sua situação, compare o desempenho dela com quatro critérios:

- Verdadeiro positivo – identificação correta de conteúdo prejudicial.

- Falso positivo – identificação incorreta de conteúdo prejudicial.

- Verdadeiro negativo – identificação correta de conteúdo inofensivo.

- Falso negativo – o conteúdo prejudicial não é identificado.

A Segurança de Conteúdo de IA do Azure funciona melhor para dar suporte a moderadores humanos que podem resolver casos de identificação incorreta. Quando as pessoas adicionam conteúdo a um site, elas não esperam que as postagens sejam removidas sem motivo. Comunicar-se com os usuários sobre por que o conteúdo é removido ou sinalizado como inadequado ajuda todos a entender o que é permitido e o que não é.