Noções básicas sobre os notebooks e pipelines do Azure Databricks

No Azure Databricks, você pode usar notebooks para executar um código escrito em Python, Scala, SQL e outras linguagens para ingerir e processar dados. Os notebooks fornecem uma interface interativa na qual é possível executar células de código individuais e usar o Markdown para incluir notas e anotações.

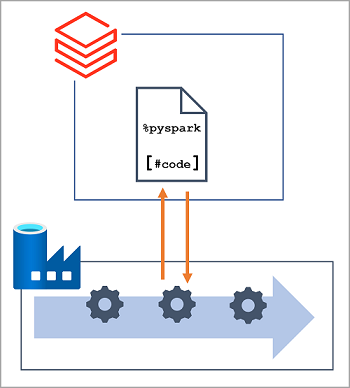

Em muitas soluções de engenharia de dados, o código escrito e testado interativamente pode ser incorporado posteriormente a uma carga de trabalho automatizada de processamento de dados. No Azure, essas cargas de trabalho são frequentemente implementadas como pipelines no Azure Data Factory, nos quais uma ou mais atividades são usadas para orquestrar uma série de tarefas que podem ser executadas sob demanda, em intervalos agendados ou em resposta a um evento (como o carregamento de novos dados em uma pasta em um data lake). O Azure Data Factory dá suporte a uma atividade do Notebook que pode ser usada para automatizar a execução autônoma de um notebook em um workspace do Azure Databricks.

Observação

A mesma atividade do Notebook está disponível em pipelines internos no Azure Synapse Analytics.