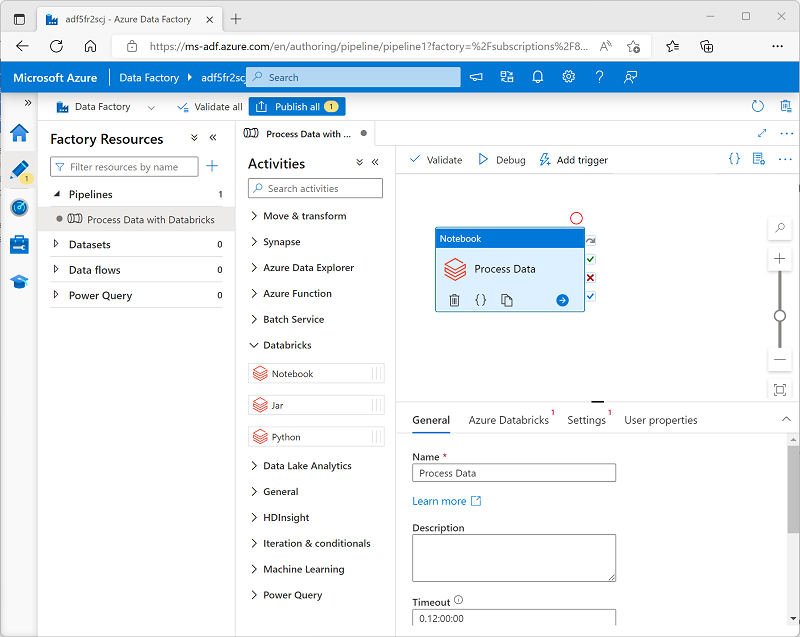

Usar uma atividade do Notebook em um pipeline

Depois de criar um serviço vinculado no Azure Data Factory para o workspace do Azure Databricks, será possível usá-lo para definir a conexão para uma atividade do Notebook em um pipeline.

Para usar uma atividade do Notebook, crie um pipeline e, na categoria Databricks, adicione uma atividade do Notebook à superfície do designer de pipeline.

Use as seguintes propriedades da atividade do Notebook para a configuração:

| Categoria | Configuração | Descrições |

|---|---|---|

| Geral | Nome | Um nome exclusivo para a atividade. |

| Descrição | Uma descrição significativa. | |

| Tempo limite | Duração de execução da atividade antes do seu cancelamento automático. | |

| Novas tentativas | Número de tentativas do Azure Data Factory antes de indicar falha. | |

| Intervalo de repetição | Tempo de espera antes de uma nova tentativa. | |

| Entrada e saída seguras | Determina se os valores de entrada e saída são registrados. | |

| Azure Databricks | Serviço vinculado do Azure Databricks | O serviço vinculado para o workspace do Azure Databricks que contém o notebook. |

| Configurações | Caminho do notebook | O caminho para o arquivo do notebook no workspace. |

| Parâmetros base | Usado para transmitir parâmetros ao notebook. | |

| Acrescentar bibliotecas | Bibliotecas de código necessárias que não são instaladas por padrão. | |

| Propriedades do usuário | Propriedades personalizadas definidas pelo usuário. |

Execução de um pipeline

Quando o pipeline que contém a atividade do Notebook é publicado, é possível executá-lo definindo um gatilho. Em seguida, as execuções de pipeline podem ser monitoradas na seção Monitorar do Azure Data Factory Studio.