O que é regressão?

A regressão é uma técnica de análise de dados simples, comum e altamente útil, geralmente chamada de "ajustar uma linha". Em sua forma mais simples, a regressão se ajusta a uma linha reta entre uma variável (recurso) e outra (rótulo). Em formas mais complicadas, a regressão pode estabelecer relações não lineares entre um único rótulo e vários recursos.

Regressão linear simples

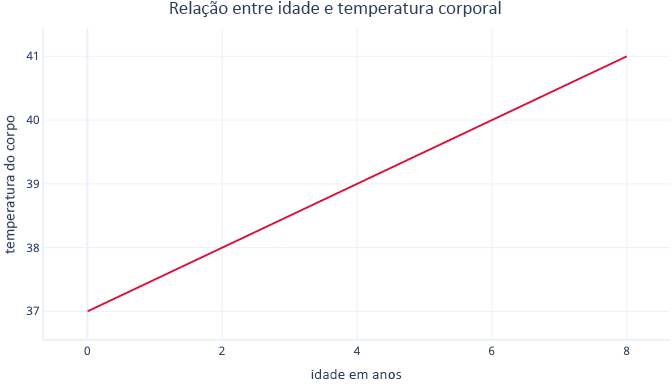

A regressão linear simples modela uma relação linear entre um único recurso e um rótulo, geralmente contínuo, permitindo que o recurso preveja o rótulo. Visualmente, ela pode ser algo do tipo:

A regressão linear simples tem dois parâmetros: interceptação (c), que indica o valor do rótulo quando o recurso é definido como zero; e inclinação (m), que indica o quanto o rótulo aumentará para cada aumento de um ponto no recurso.

Usando um raciocínio matemático, isso é simplesmente:

y=mx+c

Em que y é o rótulo e x o recurso.

Por exemplo, em nosso cenário, se tentarmos prever os pacientes que terão febre com base na idade deles, teremos o seguinte modelo:

temperatura=m*idade+c

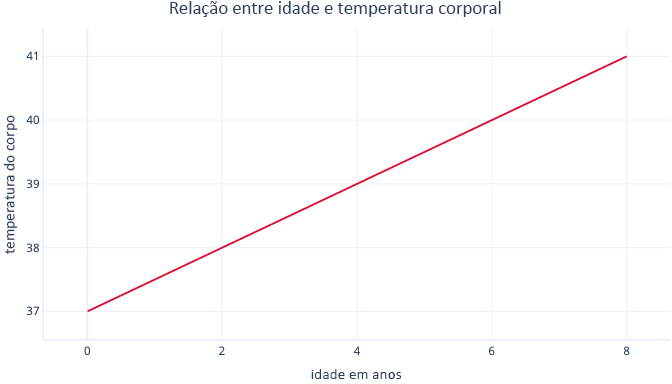

Precisamos encontrar os valores de m e c durante o procedimento de ajuste. Se encontrarmos m = 0,5 e c = 37, podemos visualizar desta forma:

Isso significa que cada ano de idade está associado ao aumento da temperatura do corpo de 0,5°C, com um ponto inicial de 37°C.

Ajuste de regressão linear

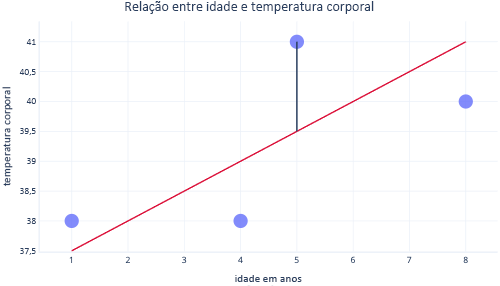

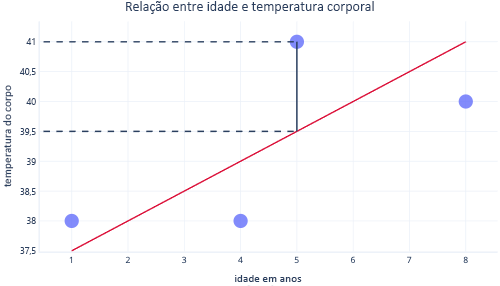

Normalmente, usamos bibliotecas existentes para ajustar modelos de regressão. A regressão normalmente visa a encontrar a linha que produz a menor quantidade de erro, em que o erro aqui representa a diferença entre o valor real do ponto de dados e o valor previsto. Por exemplo, na imagem a seguir, a linha preta indica o erro entre a previsão, a linha vermelha e um valor real: o ponto.

Observando esses dois pontos em um eixo y, podemos ver que a previsão era de 39,5, mas o valor real foi de 41.

Portanto, o modelo estava errado em 1,5 para esse ponto de dados.

Normalmente, ajustamos um modelo minimizando a soma residual dos quadrados. Isso significa que a função de custo é calculada desta forma:

- Calcular a diferença entre os valores reais e previstos (como mostrado anteriormente) para cada ponto de dados.

- Eleve os valores ao quadrado.

- Some (ou faça a média) desses valores elevados ao quadrado.

A presença dessa etapa de elevar ao quadrado significa que nem todos os pontos contribuem de maneira uniforme para a linha: as exceções—que são pontos que não se enquadram no padrão esperado—têm um erro desproporcionalmente maior, o que pode influenciar a posição da linha.

Pontos fortes da regressão

As técnicas de regressão têm muitos pontos fortes que os modelos mais complexos não têm.

Previsível e fácil de interpretar

As regressões são fáceis de interpretar porque descrevem equações matemáticas simples, que geralmente podemos transformar em gráfico. Modelos mais complexos geralmente são chamados de soluções de caixa preta, porque é difícil entender como eles fazem previsões ou como eles se comportarão com determinadas entradas.

Fácil de extrapolar

As regressões facilitam a extrapolação para fazer previsões para valores fora do intervalo do nosso conjuntos de dados. Por exemplo, é simples estimar, em nosso exemplo anterior, que um cão de nove anos terá uma temperatura de 40,5°C. A extrapolação deve sempre ser feita com cuidado: esse mesmo modelo acabaria prevendo que um indivíduo de 90 anos teria quase a temperatura necessária para ferver água.

O ajuste ideal costuma estar garantido

A maioria dos modelos de aprendizado de máquina usa descendente de gradiente para ajustar modelos, o que implica em ajustar o algoritmo do descendente de gradiente e não oferece nenhuma garantia de que uma solução ideal será encontrada. Por outro lado, a regressão linear que usa a soma de quadrados como uma função de custo não precisa de um procedimento iterativo de descendente de gradiente. Em vez disso, a matemática pode ser usada de forma inteligente para se calcular o local ideal para posicionar a linha. A matemática está fora do escopo deste módulo, mas é útil saber que na regressão linear não é necessário atenção especial ao processo de ajuste, e a solução ideal está garantida (contanto que o tamanho da amostra não seja grande demais).