GPT-4o API em tempo real para fala e áudio (Pré-visualização)

Nota

Esta funcionalidade está atualmente em pré-visualização pública. Essa visualização é fornecida sem um contrato de nível de serviço e não a recomendamos para cargas de trabalho de produção. Algumas funcionalidades poderão não ser suportadas ou poderão ter capacidades limitadas. Para obter mais informações, veja Termos Suplementares de Utilização para Pré-visualizações do Microsoft Azure.

A API em tempo real do Azure OpenAI GPT-4o para fala e áudio faz parte da família de modelos GPT-4o que oferece suporte a interações conversacionais de baixa latência, "speech in, speech out". A API de áudio realtime GPT-4o foi projetada para lidar com interações conversacionais em tempo real e de baixa latência, tornando-se uma ótima opção para casos de uso envolvendo interações ao vivo entre um usuário e um modelo, como agentes de suporte ao cliente, assistentes de voz e tradutores em tempo real.

A maioria dos usuários da API em tempo real precisa entregar e receber áudio de um usuário final em tempo real, incluindo aplicativos que usam WebRTC ou um sistema de telefonia. A API em tempo real não foi projetada para se conectar diretamente aos dispositivos do usuário final e depende de integrações de cliente para encerrar fluxos de áudio do usuário final.

Modelos suportados

Atualmente apenas gpt-4o-realtime-preview versão: 2024-10-01-preview suporta áudio em tempo real.

O gpt-4o-realtime-preview modelo está disponível para implantações globais nas regiões Leste dos EUA 2 e Suécia Central.

Importante

O sistema armazena seus prompts e conclusões conforme descrito na seção "Uso e acesso de dados para monitoramento de abuso" dos Termos de Produto específicos do serviço para o Serviço OpenAI do Azure, exceto que a Exceção Limitada não se aplica. O monitoramento de abuso será ativado para uso da API, gpt-4o-realtime-preview mesmo para clientes que, de outra forma, são aprovados para monitoramento de abuso modificado.

Suporte de API

O suporte para a API em tempo real foi adicionado pela primeira vez na versão 2024-10-01-previewda API.

Nota

Para obter mais informações sobre a API e a arquitetura, consulte o repositório de áudio em tempo real do Azure OpenAI GPT-4o no GitHub.

Pré-requisitos

- Uma assinatura do Azure - Crie uma gratuitamente.

- Um recurso OpenAI do Azure criado em uma região com suporte. Para obter mais informações, consulte Criar um recurso e implantar um modelo com o Azure OpenAI.

Implante um modelo para áudio em tempo real

Antes de poder usar o áudio em tempo real GPT-4o, você precisa de uma implantação do gpt-4o-realtime-preview modelo em uma região suportada, conforme descrito na seção de modelos suportados.

- Aceda à home page do Azure AI Foundry e certifique-se de que tem sessão iniciada com a subscrição do Azure que tem o seu recurso do Serviço OpenAI do Azure (com ou sem implementações de modelo).

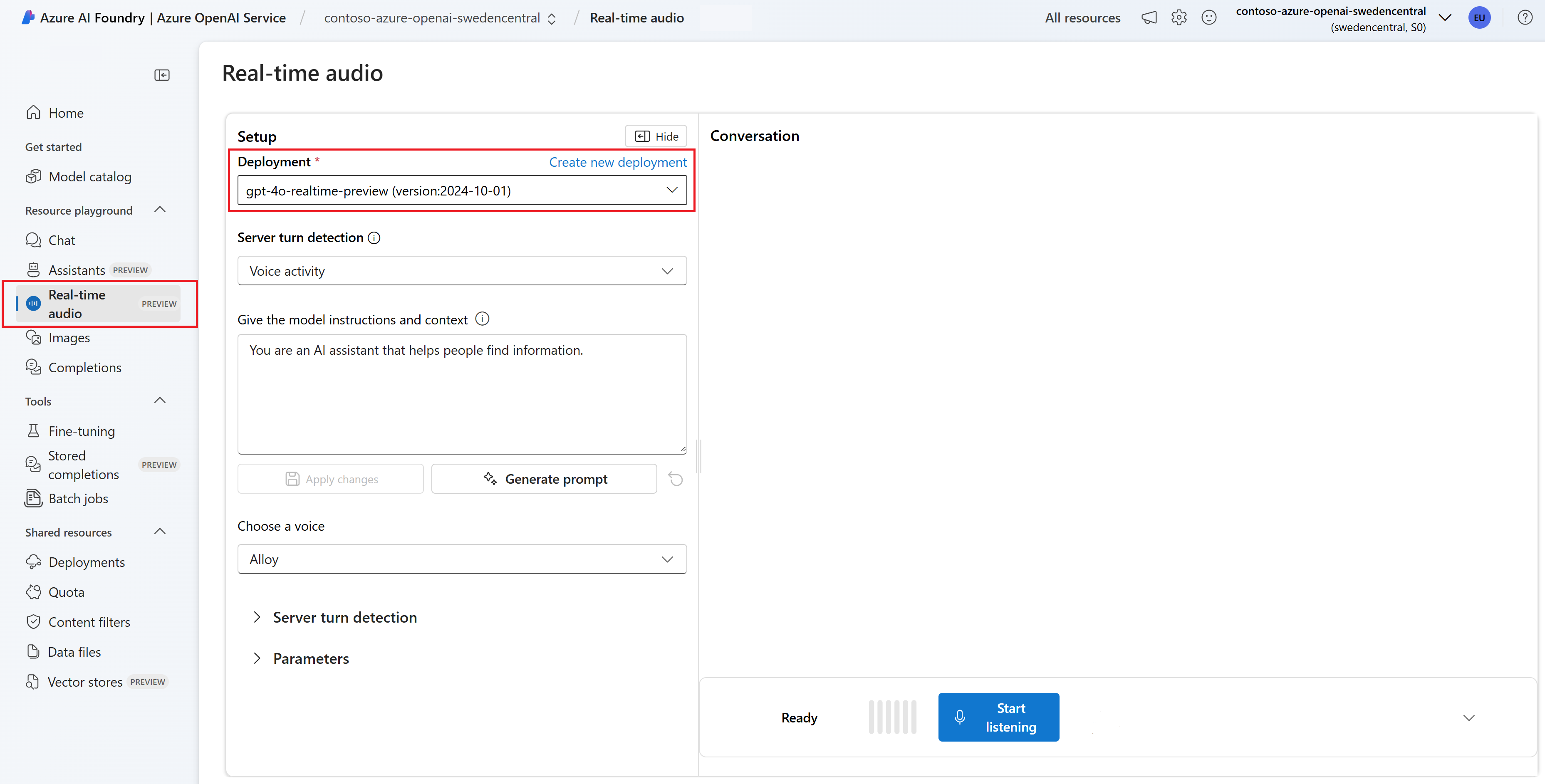

- Selecione o playground de áudio em tempo real em Playground de recursos no painel esquerdo.

- Selecione + Criar uma implantação para abrir a janela de implantação.

- Procure e selecione o

gpt-4o-realtime-previewmodelo e, em seguida, selecione Confirmar. - No assistente de implantação, certifique-se de selecionar a versão do

2024-10-01modelo. - Siga o assistente para implantar o modelo.

Agora que você tem uma implantação do modelo, pode interagir com ele em tempo real no portal do Azure AI Foundry Recreio de áudio em tempo real ou API em gpt-4o-realtime-preview tempo real.

Use o áudio GPT-4o em tempo real

Gorjeta

No momento, a maneira mais rápida de começar o desenvolvimento com a API GPT-4o Realtime é baixar o código de exemplo do repositório de áudio em tempo real do Azure OpenAI GPT-4o no GitHub.

Para conversar com seu modelo implantado gpt-4o-realtime-preview no playground de áudio em tempo real do Azure AI Foundry, siga estas etapas:

a página do Serviço OpenAI do Azure no portal do Azure AI Foundry. Certifique-se de que tem sessão iniciada com a subscrição do Azure que tem o seu recurso do Serviço OpenAI do Azure e o modelo implementado

gpt-4o-realtime-preview.Selecione o playground de áudio em tempo real em Playground de recursos no painel esquerdo.

Selecione seu modelo implantado

gpt-4o-realtime-previewna lista suspensa Implantação .Selecione Ativar microfone para permitir que o navegador acesse seu microfone. Se já tiver concedido permissão, pode ignorar este passo.

Opcionalmente, você pode editar o conteúdo na caixa de texto Dar instruções e contexto ao modelo. Dê instruções ao modelo sobre como ele deve se comportar e qualquer contexto que ele deve referenciar ao gerar uma resposta. Pode descrever a personalidade do assistente, dizer-lhe o que deve ou não responder e indicar-lhe como formatar as respostas.

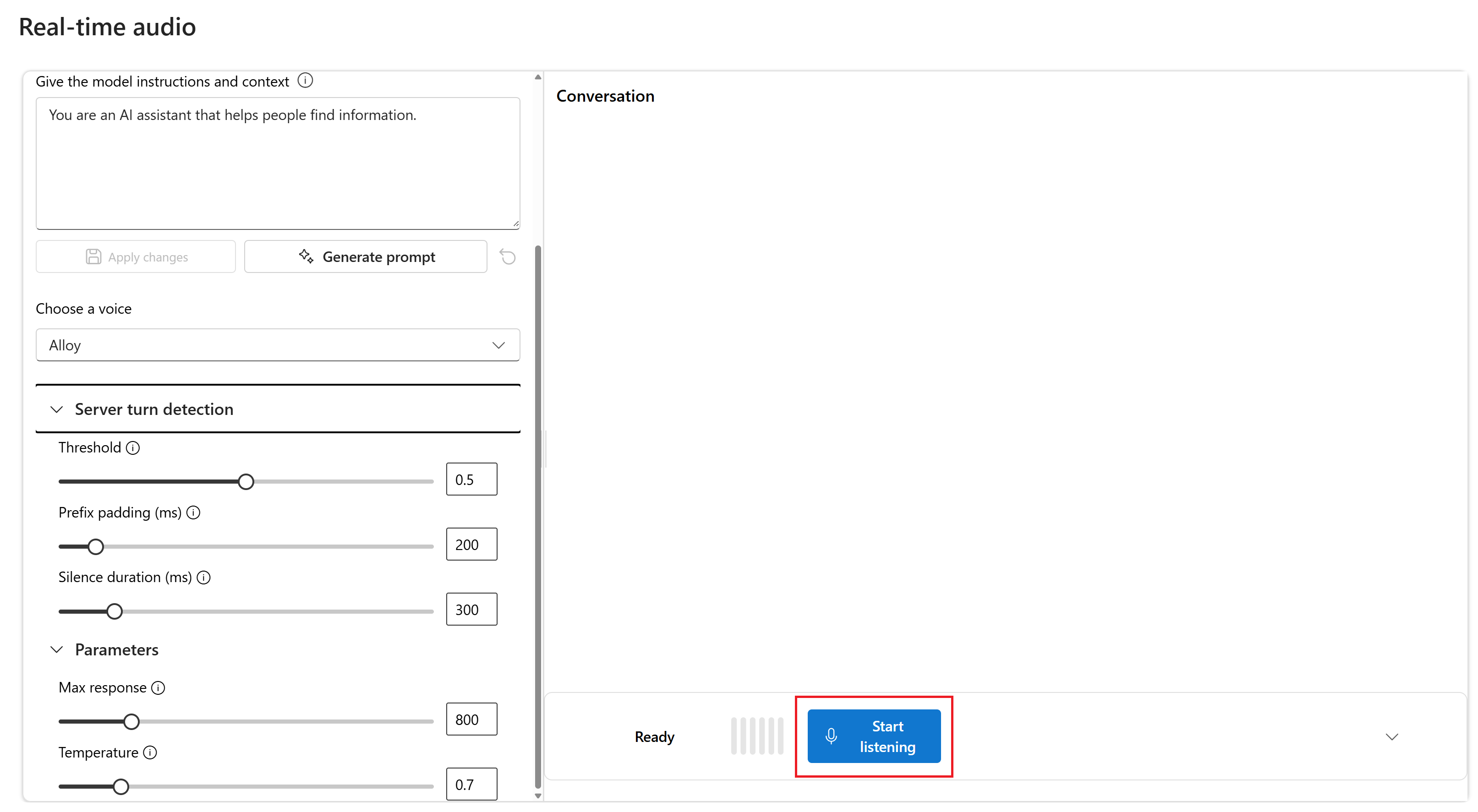

Opcionalmente, altere configurações como limite, preenchimento de prefixo e duração do silêncio.

Selecione Começar a ouvir para iniciar a sessão. Você pode falar no microfone para iniciar um bate-papo.

Você pode interromper o bate-papo a qualquer momento falando. Você pode encerrar o bate-papo selecionando o botão Parar de ouvir .

O exemplo da Web JavaScript demonstra como usar a API GPT-4o Realtime para interagir com o modelo em tempo real. O código de exemplo inclui uma interface web simples que captura o áudio do microfone do usuário e o envia para o modelo para processamento. O modelo responde com texto e áudio, que o código de exemplo renderiza na interface web.

Você pode executar o código de exemplo localmente em sua máquina seguindo estas etapas. Consulte o repositório no GitHub para obter as instruções mais atualizadas.

Se você não tiver Node.js instalado, baixe e instale a versão LTS do Node.js.

Clone o repositório em sua máquina local:

git clone https://github.com/Azure-Samples/aoai-realtime-audio-sdk.gitVá para a

javascript/samples/webpasta no seu editor de código preferido.cd ./javascript/samplesExecute

download-pkg.ps1oudownload-pkg.shfaça o download dos pacotes necessários.Vá para a

webpasta a./javascript/samplespartir da pasta.cd ./webExecute

npm installpara instalar dependências de pacote.Execute

npm run devpara iniciar o servidor Web, navegando em todos os prompts de permissões de firewall conforme necessário.Vá para qualquer um dos URIs fornecidos a partir da saída do console (como

http://localhost:5173/) em um navegador.Insira as seguintes informações na interface web:

- Ponto de extremidade: O ponto de extremidade do recurso de um recurso do Azure OpenAI. Não é necessário acrescentar o

/realtimecaminho. Um exemplo de estrutura pode serhttps://my-azure-openai-resource-from-portal.openai.azure.com. - Chave de API: uma chave de API correspondente para o recurso OpenAI do Azure.

- Implantação: o

gpt-4o-realtime-previewnome do modelo que você implantou na seção anterior. - Mensagem do sistema: Opcionalmente, você pode fornecer uma mensagem do sistema como "Você sempre fala como um pirata amigável".

- Temperatura: Opcionalmente, você pode fornecer uma temperatura personalizada.

- Voz: Opcionalmente, você pode selecionar uma voz.

- Ponto de extremidade: O ponto de extremidade do recurso de um recurso do Azure OpenAI. Não é necessário acrescentar o

Selecione o botão Gravar para iniciar a sessão. Aceite permissões para usar o microfone, se solicitado.

Você deve ver uma

<< Session Started >>mensagem na saída principal. Então você pode falar no microfone para iniciar um bate-papo.Você pode interromper o bate-papo a qualquer momento falando. Você pode encerrar o bate-papo selecionando o botão Parar .

Conteúdos relacionados

- Saiba mais sobre como usar a API em tempo real

- Veja a referência da API em tempo real

- Saiba mais sobre as cotas e limites do Azure OpenAI